Время на прочтение

9 мин

Количество просмотров 514K

Автор статьи, перевод которой мы сегодня публикуем, говорит, что она предназначена для тех разработчиков, которые хотят изучить Docker Compose и идут к тому, чтобы создать своё первое клиент-серверное приложение с использованием Docker. Предполагается, что читатель этого материала знаком с основами Docker. Если это не так — можете взглянуть на эту серию материалов, на эту публикацию, где основы Docker рассмотрены вместе с основами Kubernetes, и на эту статью для начинающих.

Что такое Docker Compose?

Docker Compose — это инструментальное средство, входящее в состав Docker. Оно предназначено для решения задач, связанных с развёртыванием проектов.

Изучая основы Docker, вы могли столкнуться с созданием простейших приложений, работающих автономно, не зависящих, например, от внешних источников данных или от неких сервисов. На практике же подобные приложения — редкость. Реальные проекты обычно включают в себя целый набор совместно работающих приложений.

Как узнать, нужно ли вам, при развёртывании некоего проекта, воспользоваться Docker Compose? На самом деле — очень просто. Если для обеспечения функционирования этого проекта используется несколько сервисов, то Docker Compose может вам пригодиться. Например, в ситуации, когда создают веб-сайт, которому, для выполнения аутентификации пользователей, нужно подключиться к базе данных. Подобный проект может состоять из двух сервисов — того, что обеспечивает работу сайта, и того, который отвечает за поддержку базы данных.

Технология Docker Compose, если описывать её упрощённо, позволяет, с помощью одной команды, запускать множество сервисов.

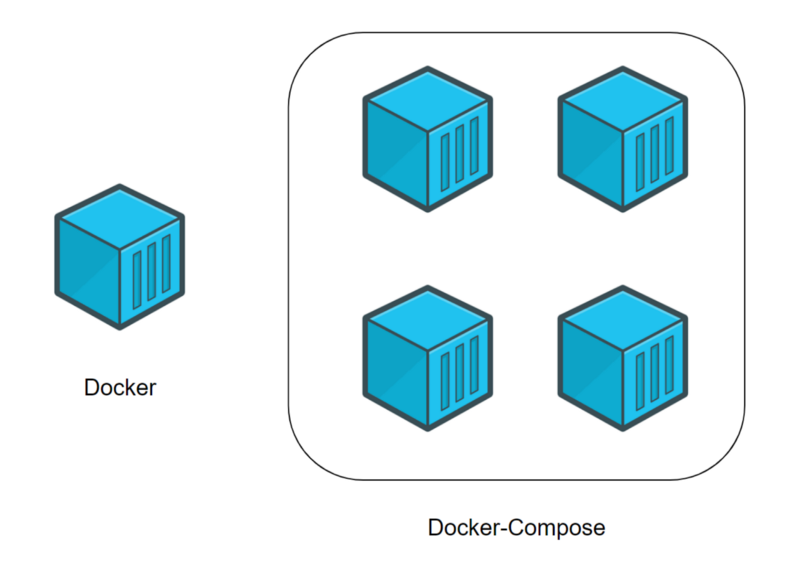

Разница между Docker и Docker Compose

Docker применяется для управления отдельными контейнерами (сервисами), из которых состоит приложение.

Docker Compose используется для одновременного управления несколькими контейнерами, входящими в состав приложения. Этот инструмент предлагает те же возможности, что и Docker, но позволяет работать с более сложными приложениями.

Docker (отдельный контейнер) и Docker Compose (несколько контейнеров)

Типичный сценарий использования Docker Compose

Docker Compose — это, в умелых руках, весьма мощный инструмент, позволяющий очень быстро развёртывать приложения, отличающиеся сложной архитектурой. Сейчас мы рассмотрим пример практического использования Docker Compose, разбор которого позволит вам оценить те преимущества, которые даст вам использование Docker Compose.

Представьте себе, что вы являетесь разработчиком некоего веб-проекта. В этот проект входит два веб-сайта. Первый позволяет людям, занимающимся бизнесом, создавать, всего в несколько щелчков мышью, интернет-магазины. Второй нацелен на поддержку клиентов. Эти два сайта взаимодействуют с одной и той же базой данных.

Ваш проект становится всё популярнее, и оказывается, что мощности сервера, на котором он работает, уже недостаточно. В результате вы решаете перевести весь проект на другую машину.

К сожалению, нечто вроде Docker Compose вы не использовали. Поэтому вам придётся переносить и перенастраивать сервисы по одному, надеясь на то, что вы, в процессе этой работы, ничего не забудете.

Если же вы используете Docker Compose, то перенос вашего проекта на новый сервер — это вопрос, который решается выполнением нескольких команд. Для того чтобы завершить перенос проекта на новое место, вам нужно лишь выполнить кое-какие настройки и загрузить на новый сервер резервную копию базы данных.

Разработка клиент-серверного приложения с использованием Docker Compose

Теперь, когда вы знаете о том, для чего мы собираемся использовать Docker Compose, пришло время создать ваше первое клиент-серверное приложение с использованием этого инструмента. А именно, речь идёт о разработке небольшого веб-сайта (сервера) на Python, который умеет выдавать файл с фрагментом текста. Этот файл у сервера запрашивает программа (клиент), тоже написанная на Python. После получения файла с сервера программа выводит текст, хранящийся в нём, на экран.

Обратите внимание на то, что мы рассчитываем на то, что вы владеете основами Docker, и на то, что у вас уже установлена платформа Docker.

Приступим к работе над проектом.

▍1. Создание проекта

Для того чтобы построить ваше первое клиент-серверное приложение, предлагаю начать с создания папки проекта. Она должна содержать следующие файлы и папки:

- Файл

docker-compose.yml. Это файл Docker Compose, который будет содержать инструкции, необходимые для запуска и настройки сервисов. - Папка

server. Она будет содержать файлы, необходимые для обеспечения работы сервера. - Папка

client. Здесь будут находиться файлы клиентского приложения.

В результате содержимое главной папки вашего проекта должно выглядеть так:

.

├── client/

├── docker-compose.yml

└── server/

2 directories, 1 file▍2. Создание сервера

Тут мы, в процессе создания сервера, затронем некоторые базовые вещи, касающиеся Docker.

2a. Создание файлов

Перейдите в папку server и создайте в ней следующие файлы:

- Файл

server.py. В нём будет находиться код сервера. - Файл

index.html. В этом файле будет находиться фрагмент текста, который должно вывести клиентское приложение. - Файл

Dockerfile. Это — файл Docker, который будет содержать инструкции, необходимые для создания окружения сервера.

Вот как должно выглядеть содержимое вашей папки server/:

.

├── Dockerfile

├── index.html

└── server.py

0 directories, 3 files2b. Редактирование Python-файла.

Добавим в файл server.py следующий код:

#!/usr/bin/env python3

# Импорт системных библиотек python.

# Эти библиотеки будут использоваться для создания веб-сервера.

# Вам не нужно устанавливать что-то особенное, эти библиотеки устанавливаются вместе с Python.

import http.server

import socketserver

# Эта переменная нужна для обработки запросов клиента к серверу.

handler = http.server.SimpleHTTPRequestHandler

# Тут мы указываем, что сервер мы хотим запустить на порте 1234.

# Постарайтесь запомнить эти сведения, так как они нам очень пригодятся в дальнейшем, при работе с docker-compose.

with socketserver.TCPServer(("", 1234), handler) as httpd:

# Благодаря этой команде сервер будет выполняться постоянно, ожидая запросов от клиента.

httpd.serve_forever()

Этот код позволяет создать простой веб-сервер. Он будет отдавать клиентам файл index.html, содержимое которого позже будет выводиться на веб-странице.

2c. Редактирование HTML-файла

В файл index.html добавим следующий текст:

Docker-Compose is magic!Этот текст будет передаваться клиенту.

2d. Редактирование файла Dockerfile

Сейчас мы создадим простой файл Dockerfile, который будет отвечать за организацию среды выполнения для Python-сервера. В качестве основы создаваемого образа воспользуемся официальным образом, предназначенным для выполнения программ, написанных на Python. Вот содержимое Dockerfile:

# На всякий случай напоминаю, что Dockerfile всегда должен начинаться с импорта базового образа.

# Для этого используется ключевое слово 'FROM'.

# Здесь нам нужно импортировать образ python (с DockerHub).

# В результате мы, в качестве имени образа, указываем 'python', а в качестве версии - 'latest'.

FROM python:latest

# Для того чтобы запустить в контейнере код, написанный на Python, нам нужно импортировать файлы 'server.py' и 'index.html'.

# Для того чтобы это сделать, мы используем ключевое слово 'ADD'.

# Первый параметр, 'server.py', представляет собой имя файла, хранящегося на компьютере.

# Второй параметр, '/server/', это путь, по которому нужно разместить указанный файл в образе.

# Здесь мы помещаем файл в папку образа '/server/'.

ADD server.py /server/

ADD index.html /server/

# Здесь мы воспользуемся командой 'WORKDIR', возможно, новой для вас.

# Она позволяет изменить рабочую директорию образа.

# В качестве такой директории, в которой будут выполняться все команды, мы устанавливаем '/server/'.

WORKDIR /server/Теперь займёмся работой над клиентом.

▍3. Создание клиента

Создавая клиентскую часть нашего проекта, мы попутно вспомним некоторые основы Docker.

3a. Создание файлов

Перейдите в папку вашего проекта client и создайте в ней следующие файлы:

- Файл

client.py. Тут будет находиться код клиента. - Файл

Dockerfile. Этот файл играет ту же роль, что и аналогичный файл в папке сервера. А именно, он содержит инструкцию, описывающую создание среды для выполнения клиентского кода.

В результате ваша папка client/ на данном этапе работы должна выглядеть так:

.

├── client.py

└── Dockerfile

0 directories, 2 files3b. Редактирование Python-файла

Добавим в файл client.py следующий код:

#!/usr/bin/env python3

# Импортируем системную библиотеку Python.

# Она используется для загрузки файла 'index.html' с сервера.

# Ничего особенного устанавливать не нужно, эта библиотека устанавливается вместе с Python.

import urllib.request

# Эта переменная содержит запрос к 'http://localhost:1234/'.

# Возможно, сейчас вы задаётесь вопросом о том, что такое 'http://localhost:1234'.

# localhost указывает на то, что программа работает с локальным сервером.

# 1234 - это номер порта, который вам предлагалось запомнить при настройке серверного кода.

fp = urllib.request.urlopen("http://localhost:1234/")

# 'encodedContent' соответствует закодированному ответу сервера ('index.html').

# 'decodedContent' соответствует раскодированному ответу сервера (тут будет то, что мы хотим вывести на экран).

encodedContent = fp.read()

decodedContent = encodedContent.decode("utf8")

# Выводим содержимое файла, полученного с сервера ('index.html').

print(decodedContent)

# Закрываем соединение с сервером.

fp.close()Благодаря этому коду клиентское приложение может загрузить данные с сервера и вывести их на экран.

3c. Редактирование файла Dockerfile

Как и в случае с сервером, мы создаём для клиента простой Dockerfile, ответственный за формирование среды, в которой будет работать клиентское Python-приложение. Вот код клиентского Dockerfile:

# То же самое, что и в серверном Dockerfile.

FROM python:latest

# Импортируем 'client.py' в папку '/client/'.

ADD client.py /client/

# Устанавливаем в качестве рабочей директории '/client/'.

WORKDIR /client/▍4. Docker Compose

Как вы могли заметить, мы создали два разных проекта: сервер и клиент. У каждого из них имеется собственный файл Dockerfile. До сих пор всё происходящее не выходит за рамки основ работы с Docker. Теперь же мы приступаем к работе с Docker Compose. Для этого обратимся к файлу docker-compose.yml, расположенному в корневой папке проекта.

Обратите внимание на то, что тут мы не стремимся рассмотреть абсолютно все команды, которые можно использовать в docker-compose.yml. Наша главная цель — разобрать практический пример, дающий вам базовые знания по Docker Compose.

Вот код, который нужно поместить в файл docker-compose.yml:

# Файл docker-compose должен начинаться с тега версии.

# Мы используем "3" так как это - самая свежая версия на момент написания этого кода.

version: "3"

# Следует учитывать, что docker-composes работает с сервисами.

# 1 сервис = 1 контейнер.

# Сервисом может быть клиент, сервер, сервер баз данных...

# Раздел, в котором будут описаны сервисы, начинается с 'services'.

services:

# Как уже было сказано, мы собираемся создать клиентское и серверное приложения.

# Это означает, что нам нужно два сервиса.

# Первый сервис (контейнер): сервер.

# Назвать его можно так, как нужно разработчику.

# Понятное название сервиса помогает определить его роль.

# Здесь мы, для именования соответствующего сервиса, используем ключевое слово 'server'.

server:

# Ключевое слово "build" позволяет задать

# путь к файлу Dockerfile, который нужно использовать для создания образа,

# который позволит запустить сервис.

# Здесь 'server/' соответствует пути к папке сервера,

# которая содержит соответствующий Dockerfile.

build: server/

# Команда, которую нужно запустить после создания образа.

# Следующая команда означает запуск "python ./server.py".

command: python ./server.py

# Вспомните о том, что в качестве порта в 'server/server.py' указан порт 1234.

# Если мы хотим обратиться к серверу с нашего компьютера (находясь за пределами контейнера),

# мы должны организовать перенаправление этого порта на порт компьютера.

# Сделать это нам поможет ключевое слово 'ports'.

# При его использовании применяется следующая конструкция: [порт компьютера]:[порт контейнера]

# В нашем случае нужно использовать порт компьютера 1234 и организовать его связь с портом

# 1234 контейнера (так как именно на этот порт сервер

# ожидает поступления запросов).

ports:

- 1234:1234

# Второй сервис (контейнер): клиент.

# Этот сервис назван 'client'.

client:

# Здесь 'client/ соответствует пути к папке, которая содержит

# файл Dockerfile для клиентской части системы.

build: client/

# Команда, которую нужно запустить после создания образа.

# Следующая команда означает запуск "python ./client.py".

command: python ./client.py

# Ключевое слово 'network_mode' используется для описания типа сети.

# Тут мы указываем то, что контейнер может обращаться к 'localhost' компьютера.

network_mode: host

# Ключевое слово 'depends_on' позволяет указывать, должен ли сервис,

# прежде чем запуститься, ждать, когда будут готовы к работе другие сервисы.

# Нам нужно, чтобы сервис 'client' дождался бы готовности к работе сервиса 'server'.

depends_on:

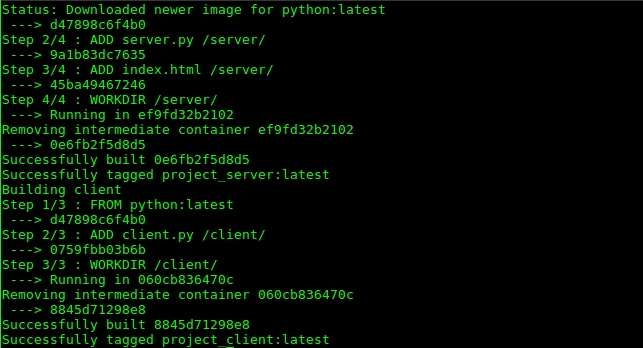

- server▍5. Сборка проекта

После того, как в docker-compose.yml внесены все необходимые инструкции, проект нужно собрать. Этот шаг нашей работы напоминает использование команды docker build, но соответствующая команда имеет отношение к нескольким сервисам:

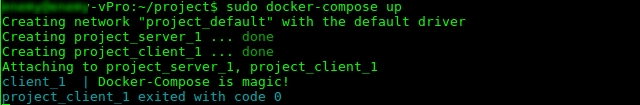

$ docker-compose build▍6. Запуск проекта

Теперь, когда проект собран, пришло время его запустить. Этот шаг нашей работы соответствует шагу, на котором, при работе с отдельными контейнерами, выполняется команда docker run:

$ docker-compose up

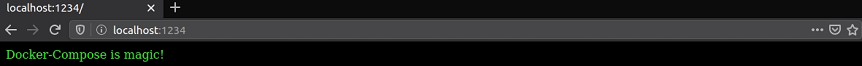

После выполнения этой команды в терминале должен появиться текст, загруженный клиентом с сервера: Docker-Compose is magic!.

Как уже было сказано, сервер использует порт компьютера 1234 для обслуживания запросов клиента. Поэтому, если перейти в браузере по адресу http://localhost:1234/, в нём будет отображена страница с текстом Docker-Compose is magic!.

Полезные команды

Рассмотрим некоторые команды, которые могут вам пригодиться при работе с Docker Compose.

Эта команда позволяет останавливать и удалять контейнеры и другие ресурсы, созданные командой docker-compose up:

$ docker-compose downЭта команда выводит журналы сервисов:

$ docker-compose logs -f [service name]

Например, в нашем проекте её можно использовать в таком виде: $ docker-compose logs -f [service name].

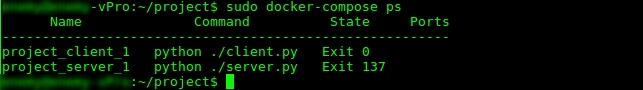

С помощью такой команды можно вывести список контейнеров:

$ docker-compose psДанная команда позволяет выполнить команду в выполняющемся контейнере:

$ docker-compose exec [service name] [command]

Например, она может выглядеть так: docker-compose exec server ls.

Такая команда позволяет вывести список образов:

$ docker-compose imagesИтоги

Мы рассмотрели основы работы с технологией Docker Compose, знание которых позволит вам пользоваться этой технологией и, при желании, приступить к её более глубокому изучению. Вот репозиторий с кодом проекта, который мы здесь рассматривали.

Уважаемые читатели! Пользуетесь ли вы Docker Compose в своих проектах?

Содержание:

- Возможности Docker Compose

- Практика применения

- Создание клиент-серверного приложения

- Работа с Docker Compose

- Дополнительная информация

Инструмент Docker Compose входит в комплект официального программного обеспечения для Docker. Он позволяет решать различные задачи, связанные с управлением одновременно несколькими контейнерами, составляющих в целом один проект.

В процессе изучения основ Docker разработчики часто имеют дело с самыми простыми программами, способными запускаться в одном контейнере. Ведь, любой проект состоит из целого комплекта синхронно работающих приложений.

Самый очевидный пример – веб-сайт, где для авторизации пользователей необходимо подключение к базе данных. Для такого проекта нужно два сервиса – один отвечает за функционирование сайта, а другой за базу данных. Соответственно, разработчику понадобится средство, позволяющее управлять одновременно двумя контейнерами. И тут на помощь приходит Docker Compose, который позволяет включать два и более сервиса всего одной командой.

В этом и заключается разница между Docker и Docker Compose. Первый используется для работы с контейнерами по отдельности. Второй позволяет одновременно управлять несколькими контейнерами, а следовательно, работать с более сложными проектами.

Практика применения

Практуку использования Docker Compose можно рассмотреть на примере веб-проекта, состоящего из двух сайтов. Первый позволяет создать интернет-магазин буквально за несколько кликов мышью. Второй служит для поддержки клиентов. Оба сайта подключены к общей базе данных.

Допустим, по мере развития проекта становится понятно, что мощностей текущего сервера уже недостаточно. Принимается решение перенести сайты на новый сервер. Без Docker Compose придется переносить и настраивать все сервисы заново. Тогда сама работа займет много времени. Кто же возникает вероятность что-нибудь забыть в процессе.

При помощи Docker Compose можно выполнить перенос сайтов при помощи всего нескольких команд. Потребуется лишь изменить некоторые настройки и перенести на другой сервер резервную копию баз данных.

Создание клиент-серверного приложения

Для примера приведен небольшой сайт (сервер) на Python, умеющий отображать файл с текстом. Запрос на него делает программа-клиент, тоже на Python. Когда файл с сервера будет получен, программа выведет текст из файла на экран.

Подразумевается, что разработчик знаком с основами Docker, у него уже произведена установка этой программы и локального веб-сервера для запуска тестируемого проекта.

Примечание. Этот проект создавался и тестировался на дистрибутивах Ubuntu и CentOS 7. Для выполнения всех приведенных ниже команд используется стандартный терминал Linux.

Разработка проекта

Создание основного каталога

Сборка тестируемого клиент-серверного приложения начинается с создания каталога проекта (в примере — «project»).

Компоненты каталога

- Файл docker-compose.yml. В нем сохраняются инструкции, которые используются для запуска и дальнейшей настройки сервисов.

- Каталог server. Здесь будут храниться файлы, отвечающие за функционирование сервера.

- Каталог client. В нем расположены файлы для клиент-приложения.

Содержимое основного каталога проекта будет отображаться в следующем виде:

Работа с папкой server

Подготовка файлов сервера

Следует открыть каталог «server», чтобы создать в нем следующие файлы:

- Файл server.py. Предназначен для хранения программного кода сервера.

- Файл index.html. Здесь сохранен текст, который должно выводить при запросе клиент-приложение.

- Файл Dockerfile. Непосредственно файл контейнера, который содержит директивы для создания серверного окружения.

После создания трех упомянутых выше файлов, содержимое каталога «server» должно выглядеть так:

Работа с файлом server.py

Теперь нужно открыть файл «server.py» предпочитаемым текстовым редактором, чтобы добавить в него следующий код:

#!/usr/bin/env python3

# Импорт системных библиотек Python.

# Эти библиотеки будут использоваться для создания веб-сервера.

# Не нужно устанавливать что-то особенное, эти библиотеки устанавливаются вместе с Python.

import http.server

import socketserver

# Эта переменная нужна для обработки запросов клиента к серверу.

handler = http.server.SimpleHTTPRequestHandler

# Здесь указываемся, что сервер будет запущен на порте 1234.

# Нужно запомнить эти сведения, так как они очень пригодятся в дальнейшем, при работе с docker-compose.

with socketserver.TCPServer(("", 1234), handler) as httpd:

# Благодаря этой команде сервер будет выполняться постоянно, ожидая запросов от клиента.

httpd.serve_forever()

Важно! При добавлении информации нужно обязательно сохранять форматирование, как дано в примере.

Работа с файлом index.html

Далее потребуется отредактировать index.html, добавив в него такое содержимое:

Docker-Compose is magic!

Работа с Dockerfile

Теперь следует произвести настройку файла Dockerfile. С помощью него будет организована среда выполнения для Python-сервера. В примере основой создаваемого контейнера будет официальный образ для запуска Python-приложений.

Ниже приведено содержимое файла:

# На всякий случай – Dockerfile всегда должен начинаться с импорта базового образа. # Для этого используется ключевое слово 'FROM'. # Здесь следует импортировать образ python (с DockerHub). # В результате, в качестве имени образа, нужно указать 'python', а в качестве версии - 'latest'. FROM python:latest # Для того чтобы запустить в контейнере код, написанный на Python, нужно импортировать файлы 'server.py' и 'index.html'. Для этого используется ключевое слово 'ADD'. # Первый параметр, 'server.py', представляет собой имя файла, хранящегося на компьютере. # Второй параметр — '/server/' — это путь, по которому нужно разместить указанный файл в образе. # помещаем файл в папку образа '/server/'. ADD server.py /server/ ADD index.html /server/ # Воспользуемся командой 'WORKDIR'. # Она позволяет изменить рабочую директорию образа. # В качестве директории, в которой будут выполняться все команды, нужно установить '/server/'. WORKDIR /server/

Важно! При добавлении информации нужно обязательно сохранять форматирование, как дано в примере.

Создание клиент-приложения

Можно приступать к разработке клиента. При создании клиент-приложения проекта будут одновременно использоваться основные возможности Docker.

Файлы клиента

Сначала следует открыть каталог «client» и создать в нем файлы:

- Файл client.py. Предназначен для хранения выполняемого кода клиента.

- Файл Dockerfile. Используется так же, как и одноименный файл в папке server. В нем сохранена инструкция по созданию среды запуска кода на стороне клиента.

После этих операций в каталоге client должны храниться следующие файлы:

Работа с файлом Python

Снова следует открыть текстовый редактор, чтобы добавить в client.py такой код:

#!/usr/bin/env python3

# Импортируется системная библиотека Python.

# Она используется для загрузки файла 'index.html' с сервера.

# Специально ничего устанавливать не нужно, эта библиотека устанавливается вместе с Python.

import urllib.request

# Эта переменная содержит запрос к 'http://localhost:1234/'.

# localhost указывает на то, что программа работает с локальным сервером.

# 1234 - номер порта, который предлагается запомнить при настройке серверного кода.

fp = urllib.request.urlopen("http://localhost:1234/")

# 'encodedContent' соответствует закодированному ответу сервера ('index.html').

# 'decodedContent' соответствует раскодированному ответу сервера (тут будет то, что нужно вывести на экран).

encodedContent = fp.read()

decodedContent = encodedContent.decode("utf8")

# Выводим содержимое файла, полученного с сервера ('index.html').

print(decodedContent)

# Закрываем соединение с сервером.

fp.close()

Важно! При добавлении информации нужно обязательно сохранять форматирование, как дано в примере.

Работа с файлом Dockerfile

Аналогично серверу, для клиент-приложения будет создан небольшой Dockerfile. Он будет формировать среду для работы клиента.

Ниже представлен его код:

# То же самое, что и в серверном Dockerfile. FROM python:latest # Импортируем 'client.py' в папку '/client/'. ADD client.py /client/ # Устанавливаем в качестве рабочей директории '/client/'. WORKDIR /client/

Важно! При добавлении информации нужно обязательно сохранять форматирование, как дано в примере.

Работа с Docker Compose

На предыдущих этапах было создано два проекта – серверное и клиент-приложение. Оба они обладают своим файлом Dockerfile. До этого момента применялись только основной функционал Docker. Далее к работе будет подключен Docker Compose — потребуется отредактировать docker-compose.yml, созданный ранее.

В этом примере не стоит задача ознакомиться со всеми возможными командами, доступными для использования в docker-compose.yml. Основная цель – увидеть, как Docker Compose можно применить на практике.

Пример файла docker-compose.yml

Важно! При добавлении информации в файл docker-compose.yml нужно обязательно сохранять форматирование, данное в примере. Это прежде всего касается отступов перед блоками. Если это расстояние нарушить, будет выведена ошибка.

# Файл docker-compose должен начинаться с тега версии.

# Мы используем "3" так как это - самая свежая версия на момент написания этого кода.

version: "3"

# Следует учитывать, что docker-composes работает с сервисами. 1 сервис = 1 контейнер.

# Сервисом может быть клиент, сервер, сервер баз данных...

# Раздел, в котором будут описаны сервисы, начинается с 'services'.

services:

# Будут созданы клиентское и серверное приложения.

# Это означает, что нам нужно два сервиса.

# Первый сервис (контейнер): сервер. Назвать его можно так, как нужно разработчику.

# Понятное название сервиса помогает определить его роль.

# Здесь мы, для именования соответствующего сервиса, используем ключевое слово 'server'.

server:

# Ключевое слово "build" позволяет задать

# путь к файлу Dockerfile, который нужно использовать для создания образа,

# который позволит запустить сервис.

# Здесь 'server/' соответствует пути к папке сервера,

# которая содержит соответствующий Dockerfile.

build: server/

# Команда, которую нужно запустить после создания образа.

# Следующая команда означает запуск "python ./server.py".

command: python ./server.py

# Вспомните о том, что в качестве порта в 'server/server.py' указан порт 1234.

# Если нужно обратиться к серверу со своего компьютера (находясь за пределами контейнера),

# следует организовать перенаправление этого порта на порт компьютера.

# Сделать это поможет ключевое слово 'ports'.

# При его использовании применяется следующая конструкция: [порт компьютера]:[порт контейнера]

# В данном случае нужно использовать порт компьютера 1234 и организовать его связь с портом

# 1234 контейнера (так как именно на этот порт сервер ожидает поступления запросов).

ports:

- 1234:1234

# Второй сервис (контейнер): клиент.

# Этот сервис назван 'client'.

client:

# Здесь 'client/ соответствует пути к папке, которая содержит

# файл Dockerfile для клиентской части системы.

build: client/

# Команда, которую нужно запустить после создания образа.

# Следующая команда означает запуск "python ./client.py".

command: python ./client.py

# Ключевое слово 'network_mode' используется для описания типа сети.

# Тут указывается, что контейнер может обращаться к 'localhost' компьютера.

network_mode: host

# Ключевое слово 'depends_on' позволяет указывать, должен ли сервис,

# прежде чем запуститься, ждать, когда будут готовы к работе другие сервисы.

# Нужно, чтобы сервис 'client' дождался бы готовности к работе сервиса 'server'.

depends_on:

- server

Создание готового образа

Когда docker-compose.yml получит требуемые для работы команды, останется выполнить сборку проекта. Она делается почти аналогично docker build.

Представленная ниже команда позволяет одновременно работать с двумя и более приложениями:

$ docker-compose build

Если все сделано правильно, в терминале будет отображен следующий результат:

Тестирование проекта

Сборка проекта завершена и можно переходить к тестированию проекта. Для этого следует выполнить команду:

$ docker-compose up

Она по сути соответствует команде docker run, используемой в Docker при работе с одним контейнером.

В окне терминала можно увидеть строку «Docker-Compose is magic!». Так клиентская программа сигнализирует, что выполнила запрос на вывод содержимого файла «index.html» серверной программе, после чего вторая передала информацию клиенту. Это значит, что проект успешно запущен и работает.

Аналогичный результат можно получить в окне браузера, после ввода соответствующего веб-адреса (не забыв указать порт 1234):

Дополнительная информация

Ниже приведены несколько часто используемых полезных команд Docker Compose.

- Команда предназначена для остановки и удаления контейнеров, которые были созданы с помощью «docker-compose up»:

$ docker-compose down

- Ознакомиться с журналами сервисов можно выполнив команду:

$ docker-compose logs -f [service name]

- Посмотреть список используемых сервисов можно командой (на примере данного проекта):

$ docker-compose ps

- Чтобы запустить команду в работающем контейнере используется следующий синтаксис:

$ docker-compose exec [service name] [command]

- Увидеть в терминале список образов можно, введя команду:

$ docker-compose images

| description | keywords | title | toc_max | toc_min |

|---|---|---|---|---|

|

Find a quick reference for Docker Compose version 3, including Docker Engine compatibility, memory limitations, and more. |

docker compose ports, docker compose version 3, docker-compose memory limit version 3, docker compose 3 memory limit |

Compose file version 3 reference |

4 |

1 |

{% include compose-eol.md %}

Reference and guidelines

These topics describe version 3 of the Compose file format. This is the newest

version.

Compose and Docker compatibility matrix

There are several versions of the Compose file format – 1, 2, 2.x, and 3.x. The

table below is a quick look. For full details on what each version includes and

how to upgrade, see About versions and upgrading.

{% include content/compose-matrix.md %}

Compose file structure and examples

Here is a sample Compose file from the voting app sample used in the

Docker for Beginners lab

topic on Deploying an app to a Swarm:

Example Compose file version 3

version: "{{ site.compose_file_v3 }}" services:redis: image: redis:alpine ports: - "6379" networks: - frontend deploy: replicas: 2 update_config: parallelism: 2 delay: 10s restart_policy: condition: on-failure

db: image: postgres:9.4 volumes: - db-data:/var/lib/postgresql/data networks: - backend deploy: placement: max_replicas_per_node: 1 constraints: - "node.role==manager"

vote: image: dockersamples/examplevotingapp_vote:before ports: - "5000:80" networks: - frontend depends_on: - redis deploy: replicas: 2 update_config: parallelism: 2 restart_policy: condition: on-failure

result: image: dockersamples/examplevotingapp_result:before ports: - "5001:80" networks: - backend depends_on: - db deploy: replicas: 1 update_config: parallelism: 2 delay: 10s restart_policy: condition: on-failure

worker: image: dockersamples/examplevotingapp_worker networks: - frontend - backend deploy: mode: replicated replicas: 1 labels: [APP=VOTING] restart_policy: condition: on-failure delay: 10s max_attempts: 3 window: 120s placement: constraints: - "node.role==manager"

visualizer: image: dockersamples/visualizer:stable ports: - "8080:8080" stop_grace_period: 1m30s volumes: - "/var/run/docker.sock:/var/run/docker.sock" deploy: placement: constraints: - "node.role==manager"

networks: frontend: backend:

volumes: db-data:

The topics on this reference page are organized alphabetically by top-level key

to reflect the structure of the Compose file itself. Top-level keys that define

a section in the configuration file such as build, deploy, depends_on,

networks, and so on, are listed with the options that support them as

sub-topics. This maps to the <key>: <option>: <value> indent structure of the

Compose file.

Service configuration reference

The Compose file is a YAML file defining

services,

networks and

volumes.

The default path for a Compose file is ./docker-compose.yml.

Tip: You can use either a

.ymlor.yamlextension for this file.

They both work.

A service definition contains configuration that is applied to each

container started for that service, much like passing command-line parameters to

docker run. Likewise, network and volume definitions are analogous to

docker network create and docker volume create.

As with docker run, options specified in the Dockerfile, such as CMD,

EXPOSE, VOLUME, ENV, are respected by default — you don’t need to

specify them again in docker-compose.yml.

You can use environment variables in configuration values with a Bash-like

${VARIABLE} syntax — see variable substitution for

full details.

This section contains a list of all configuration options supported by a service

definition in version 3.

build

Configuration options that are applied at build time.

build can be specified either as a string containing a path to the build

context:

version: "{{ site.compose_file_v3 }}" services: webapp: build: ./dir

Or, as an object with the path specified under context and

optionally Dockerfile and args:

version: "{{ site.compose_file_v3 }}" services: webapp: build: context: ./dir dockerfile: Dockerfile-alternate args: buildno: 1

If you specify image as well as build, then Compose names the built image

with the webapp and optional tag specified in image:

build: ./dir image: webapp:tag

This results in an image named webapp and tagged tag, built from ./dir.

Note when using docker stack deploy

The

buildoption is ignored when

deploying a stack in swarm mode

Thedocker stackcommand does not build images before deploying.

{: .important }

context

Either a path to a directory containing a Dockerfile, or a url to a git repository.

When the value supplied is a relative path, it is interpreted as relative to the

location of the Compose file. This directory is also the build context that is

sent to the Docker daemon.

Compose builds and tags it with a generated name, and uses that image

thereafter.

dockerfile

Alternate Dockerfile.

Compose uses an alternate file to build with. A build path must also be

specified.

build: context: . dockerfile: Dockerfile-alternate

args

Add build arguments, which are environment variables accessible only during the

build process.

First, specify the arguments in your Dockerfile:

# syntax=docker/dockerfile:1 ARG buildno ARG gitcommithash RUN echo "Build number: $buildno" RUN echo "Based on commit: $gitcommithash"

Then specify the arguments under the build key. You can pass a mapping

or a list:

build: context: . args: buildno: 1 gitcommithash: cdc3b19

build: context: . args: - buildno=1 - gitcommithash=cdc3b19

Scope of build-args

In your Dockerfile, if you specify

ARGbefore theFROMinstruction,

ARGis not available in the build instructions underFROM.

If you need an argument to be available in both places, also specify it under

theFROMinstruction. Refer to the understand how ARGS and FROM interact

section in the documentation for usage details.

You can omit the value when specifying a build argument, in which case its value

at build time is the value in the environment where Compose is running.

args: - buildno - gitcommithash

Tip when using boolean values

YAML boolean values (

"true","false","yes","no","on",

"off") must be enclosed in quotes, so that the parser interprets them as

strings.

cache_from

Added in version 3.2 file format

A list of images that the engine uses for cache resolution.

build: context: . cache_from: - alpine:latest - corp/web_app:3.14

labels

Added in version 3.3 file format

Add metadata to the resulting image using Docker labels.

You can use either an array or a dictionary.

It’s recommended that you use reverse-DNS notation to prevent your labels from

conflicting with those used by other software.

build: context: . labels: com.example.description: "Accounting webapp" com.example.department: "Finance" com.example.label-with-empty-value: ""

build: context: . labels: - "com.example.description=Accounting webapp" - "com.example.department=Finance" - "com.example.label-with-empty-value"

network

Added in version 3.4 file format

Set the network containers connect to for the RUN instructions during

build.

build: context: . network: host

build: context: . network: custom_network_1

Use none to disable networking during build:

build: context: . network: none

shm_size

Added in version 3.5 file format

Set the size of the /dev/shm partition for this build’s containers. Specify

as an integer value representing the number of bytes or as a string expressing

a byte value.

build: context: . shm_size: '2gb'

build: context: . shm_size: 10000000

target

Added in version 3.4 file format

Build the specified stage as defined inside the Dockerfile. See the

multi-stage build docs for

details.

build: context: . target: prod

cap_add, cap_drop

Add or drop container capabilities.

See man 7 capabilities for a full list.

cap_add: - ALL cap_drop: - NET_ADMIN - SYS_ADMIN

Note when using docker stack deploy

The

cap_addandcap_dropoptions are ignored when

deploying a stack in swarm mode

{: .important }

cgroup_parent

Specify an optional parent cgroup for the container.

cgroup_parent: m-executor-abcd

Note when using docker stack deploy

The

cgroup_parentoption is ignored when

deploying a stack in swarm mode

{: .important }

command

Override the default command.

command: bundle exec thin -p 3000

The command can also be a list, in a manner similar to

dockerfile:

command: ["bundle", "exec", "thin", "-p", "3000"]

configs

Grant access to configs on a per-service basis using the per-service configs

configuration. Two different syntax variants are supported.

Note: The config must already exist or be

defined in the top-levelconfigsconfiguration

of this stack file, or stack deployment fails.

For more information on configs, see configs.

Short syntax

The short syntax variant only specifies the config name. This grants the

container access to the config and mounts it at /<config_name>

within the container. The source name and destination mountpoint are both set

to the config name.

The following example uses the short syntax to grant the redis service

access to the my_config and my_other_config configs. The value of

my_config is set to the contents of the file ./my_config.txt, and

my_other_config is defined as an external resource, which means that it has

already been defined in Docker, either by running the docker config create

command or by another stack deployment. If the external config does not exist,

the stack deployment fails with a config not found error.

Added in version 3.3 file format.

configdefinitions are only supported in version 3.3 and higher of the

compose file format.

version: "{{ site.compose_file_v3 }}" services: redis: image: redis:latest deploy: replicas: 1 configs: - my_config - my_other_config configs: my_config: file: ./my_config.txt my_other_config: external: true

Long syntax

The long syntax provides more granularity in how the config is created within

the service’s task containers.

source: The identifier of the config as it is defined in this configuration.target: The path and name of the file to be mounted in the service’s

task containers. Defaults to/<source>if not specified.uidandgid: The numeric UID or GID that owns the mounted config file

within in the service’s task containers. Both default to0on Linux if not

specified. Not supported on Windows.mode: The permissions for the file that is mounted within the service’s

task containers, in octal notation. For instance,0444

represents world-readable. The default is0444. Configs cannot be writable

because they are mounted in a temporary filesystem, so if you set the writable

bit, it is ignored. The executable bit can be set. If you aren’t familiar with

UNIX file permission modes, you may find this

permissions calculator{: target=»blank» rel=»noopener» class=»» }

useful.

The following example sets the name of my_config to redis_config within the

container, sets the mode to 0440 (group-readable) and sets the user and group

to 103. The redis service does not have access to the my_other_config

config.

version: "{{ site.compose_file_v3 }}" services: redis: image: redis:latest deploy: replicas: 1 configs: - source: my_config target: /redis_config uid: '103' gid: '103' mode: 0440 configs: my_config: file: ./my_config.txt my_other_config: external: true

You can grant a service access to multiple configs and you can mix long and

short syntax. Defining a config does not imply granting a service access to it.

container_name

Specify a custom container name, rather than a generated default name.

container_name: my-web-container

Because Docker container names must be unique, you cannot scale a service beyond

1 container if you have specified a custom name. Attempting to do so results in

an error.

Note when using docker stack deploy

The

container_nameoption is ignored when

deploying a stack in swarm mode

{: .important }

credential_spec

Added in version 3.3 file format.

The

credential_specoption was added in v3.3. Using group Managed Service

Account (gMSA) configurations with compose files is supported in file format

version 3.8 or up.

Configure the credential spec for managed service account. This option is only

used for services using Windows containers. The credential_spec must be in the

format file://<filename> or registry://<value-name>.

When using file:, the referenced file must be present in the CredentialSpecs

subdirectory in the Docker data directory, which defaults to C:ProgramDataDocker

on Windows. The following example loads the credential spec from a file named

C:ProgramDataDockerCredentialSpecsmy-credential-spec.json.

credential_spec: file: my-credential-spec.json

When using registry:, the credential spec is read from the Windows registry on

the daemon’s host. A registry value with the given name must be located in:

HKLMSOFTWAREMicrosoftWindows NTCurrentVersionVirtualizationContainersCredentialSpecs

The following example load the credential spec from a value named my-credential-spec

in the registry:

credential_spec: registry: my-credential-spec

Example gMSA configuration

When configuring a gMSA credential spec for a service, you only need

to specify a credential spec with config, as shown in the following example:

version: "{{ site.compose_file_v3 }}" services: myservice: image: myimage:latest credential_spec: config: my_credential_spec configs: my_credentials_spec: file: ./my-credential-spec.json|

depends_on

Express dependency between services. Service dependencies cause the following

behaviors:

docker-compose upstarts services in dependency order. In the following

example,dbandredisare started beforeweb.docker-compose up SERVICEautomatically includesSERVICE‘s

dependencies. In the example below,docker-compose up webalso

creates and startsdbandredis.docker-compose stopstops services in dependency order. In the following

example,webis stopped beforedbandredis.

Simple example:

version: "{{ site.compose_file_v3 }}" services: web: build: . depends_on: - db - redis redis: image: redis db: image: postgres

There are several things to be aware of when using

depends_on:

depends_ondoes not wait fordbandredisto be «ready» before

startingweb— only until they have been started. If you need to wait

for a service to be ready, see Controlling startup order

for more on this problem and strategies for solving it.- The

depends_onoption is ignored when

deploying a stack in swarm mode

with a version 3 Compose file.

deploy

Added in version 3 file format.

Specify configuration related to the deployment and running of services. The following

sub-options only takes effect when deploying to a swarm with

docker stack deploy, and is

ignored by docker-compose up and docker-compose run, except for resources.

version: "{{ site.compose_file_v3 }}" services: redis: image: redis:alpine deploy: replicas: 6 placement: max_replicas_per_node: 1 update_config: parallelism: 2 delay: 10s restart_policy: condition: on-failure

Several sub-options are available:

endpoint_mode

Added in version 3.2 file format.

Specify a service discovery method for external clients connecting to a swarm.

-

endpoint_mode: vip— Docker assigns the service a virtual IP (VIP)

that acts as the front end for clients to reach the service on a

network. Docker routes requests between the client and available worker

nodes for the service, without client knowledge of how many nodes

are participating in the service or their IP addresses or ports.

(This is the default.) -

endpoint_mode: dnsrr— DNS round-robin (DNSRR) service discovery does

not use a single virtual IP. Docker sets up DNS entries for the service

such that a DNS query for the service name returns a list of IP addresses,

and the client connects directly to one of these. DNS round-robin is useful

in cases where you want to use your own load balancer, or for Hybrid

Windows and Linux applications.

version: "{{ site.compose_file_v3 }}" services: wordpress: image: wordpress ports: - "8080:80" networks: - overlay deploy: mode: replicated replicas: 2 endpoint_mode: vip mysql: image: mysql volumes: - db-data:/var/lib/mysql/data networks: - overlay deploy: mode: replicated replicas: 2 endpoint_mode: dnsrr volumes: db-data: networks: overlay:

The options for endpoint_mode also work as flags on the swarm mode CLI command

docker service create. For a

quick list of all swarm related docker commands, see

Swarm mode CLI commands.

To learn more about service discovery and networking in swarm mode, see

Configure service discovery

in the swarm mode topics.

labels

Specify labels for the service. These labels are only set on the service,

and not on any containers for the service.

version: "{{ site.compose_file_v3 }}" services: web: image: web deploy: labels: com.example.description: "This label will appear on the web service"

To set labels on containers instead, use the labels key outside of deploy:

version: "{{ site.compose_file_v3 }}" services: web: image: web labels: com.example.description: "This label will appear on all containers for the web service"

mode

Either global (exactly one container per swarm node) or replicated (a

specified number of containers). The default is replicated. (To learn more,

see Replicated and global services

in the swarm topics.)

version: "{{ site.compose_file_v3 }}" services: worker: image: dockersamples/examplevotingapp_worker deploy: mode: global

placement

Specify placement of constraints and preferences. See the docker service create

documentation for a full description of the syntax and available types of

constraints,

preferences,

and specifying the maximum replicas per node

version: "{{ site.compose_file_v3 }}" services: db: image: postgres deploy: placement: constraints: - "node.role==manager" - "engine.labels.operatingsystem==ubuntu 18.04" preferences: - spread: node.labels.zone

max_replicas_per_node

Added in version 3.8 file format.

If the service is replicated (which is the default), limit the number of replicas

that can run on a node at any time.

When there are more tasks requested than running nodes, an error

no suitable node (max replicas per node limit exceed) is raised.

version: "{{ site.compose_file_v3 }}" services: worker: image: dockersamples/examplevotingapp_worker networks: - frontend - backend deploy: mode: replicated replicas: 6 placement: max_replicas_per_node: 1

replicas

If the service is replicated (which is the default), specify the number of

containers that should be running at any given time.

version: "{{ site.compose_file_v3 }}" services: worker: image: dockersamples/examplevotingapp_worker networks: - frontend - backend deploy: mode: replicated replicas: 6

resources

Configures resource constraints.

Changed in compose-file version 3

The

resourcessection replaces the older resource constraint options

in Compose files prior to version 3 (cpu_shares,cpu_quota,cpuset,

mem_limit,memswap_limit,mem_swappiness).

Refer to Upgrading version 2.x to 3.x

to learn about differences between version 2 and 3 of the compose-file format.

Each of these is a single value, analogous to its

docker service create counterpart.

In this general example, the redis service is constrained to use no more than

50M of memory and 0.50 (50% of a single core) of available processing time (CPU),

and has 20M of memory and 0.25 CPU time reserved (as always available to it).

version: "{{ site.compose_file_v3 }}" services: redis: image: redis:alpine deploy: resources: limits: cpus: '0.50' memory: 50M reservations: cpus: '0.25' memory: 20M

The topics below describe available options to set resource constraints on

services or containers in a swarm.

Looking for options to set resources on non swarm mode containers?

The options described here are specific to the

deploykey and swarm mode. If you want to set resource constraints

on non swarm deployments, use

Compose file format version 2 CPU, memory, and other resource options.

If you have further questions, refer to the discussion on the GitHub

issue docker/compose/4513{: target=»blank» rel=»noopener» class=»«}.

{: .important}

Out Of Memory Exceptions (OOME)

If your services or containers attempt to use more memory than the system has

available, you may experience an Out Of Memory Exception (OOME) and a container,

or the Docker daemon, might be killed by the kernel OOM killer. To prevent this

from happening, ensure that your application runs on hosts with adequate memory

and see Understand the risks of running out of memory.

restart_policy

Configures if and how to restart containers when they exit. Replaces

restart.

condition: One ofnone,on-failureorany(default:any).delay: How long to wait between restart attempts, specified as a

duration (default: 5s).max_attempts: How many times to attempt to restart a container before giving

up (default: never give up). If the restart does not succeed within the configured

window, this attempt doesn’t count toward the configuredmax_attemptsvalue.

For example, ifmax_attemptsis set to ‘2’, and the restart fails on the first

attempt, more than two restarts may be attempted.window: How long to wait before deciding if a restart has succeeded,

specified as a duration (default:

decide immediately).

version: "{{ site.compose_file_v3 }}" services: redis: image: redis:alpine deploy: restart_policy: condition: on-failure delay: 5s max_attempts: 3 window: 120s

rollback_config

Added in version 3.7 file format.

Configures how the service should be rollbacked in case of a failing

update.

parallelism: The number of containers to rollback at a time. If set to 0, all containers rollback simultaneously.delay: The time to wait between each container group’s rollback (default 0s).failure_action: What to do if a rollback fails. One ofcontinueorpause(defaultpause)monitor: Duration after each task update to monitor for failure(ns|us|ms|s|m|h)(default 5s) Note: Setting to 0 will use the default 5s.max_failure_ratio: Failure rate to tolerate during a rollback (default 0).order: Order of operations during rollbacks. One ofstop-first(old task is stopped before starting new one), orstart-first(new task is started first, and the running tasks briefly overlap) (defaultstop-first).

update_config

Configures how the service should be updated. Useful for configuring rolling

updates.

parallelism: The number of containers to update at a time.delay: The time to wait between updating a group of containers.failure_action: What to do if an update fails. One ofcontinue,rollback, orpause

(default:pause).monitor: Duration after each task update to monitor for failure(ns|us|ms|s|m|h)(default 5s) Note: Setting to 0 will use the default 5s.max_failure_ratio: Failure rate to tolerate during an update.order: Order of operations during updates. One ofstop-first(old task is stopped before starting new one), orstart-first(new task is started first, and the running tasks briefly overlap) (defaultstop-first) Note: Only supported for v3.4 and higher.

Added in version 3.4 file format.

The

orderoption is only supported by v3.4 and higher of the compose

file format.

version: "{{ site.compose_file_v3 }}" services: vote: image: dockersamples/examplevotingapp_vote:before depends_on: - redis deploy: replicas: 2 update_config: parallelism: 2 delay: 10s order: stop-first

Not supported for docker stack deploy

The following sub-options (supported for docker-compose up and docker-compose run) are not supported for docker stack deploy or the deploy key.

- build

- cgroup_parent

- container_name

- devices

- tmpfs

- external_links

- links

- network_mode

- restart

- security_opt

- userns_mode

Tip

See the section on how to configure volumes for services, swarms, and docker-stack.yml

files. Volumes are supported

but to work with swarms and services, they must be configured as named volumes

or associated with services that are constrained to nodes with access to the

requisite volumes.

devices

List of device mappings. Uses the same format as the --device docker

client create option.

devices: - "/dev/ttyUSB0:/dev/ttyUSB0"

Note when using docker stack deploy

The

devicesoption is ignored when

deploying a stack in swarm mode

{: .important }

dns

Custom DNS servers. Can be a single value or a list.

dns_search

Custom DNS search domains. Can be a single value or a list.

dns_search: - dc1.example.com - dc2.example.com

entrypoint

Override the default entrypoint.

entrypoint: /code/entrypoint.sh

The entrypoint can also be a list, in a manner similar to

dockerfile:

entrypoint: ["php", "-d", "memory_limit=-1", "vendor/bin/phpunit"]

Note

Setting

entrypointboth overrides any default entrypoint set on the service’s

image with theENTRYPOINTDockerfile instruction, and clears out any default

command on the image — meaning that if there’s aCMDinstruction in the

Dockerfile, it is ignored.

env_file

Add environment variables from a file. Can be a single value or a list.

If you have specified a Compose file with docker-compose -f FILE, paths in

env_file are relative to the directory that file is in.

Environment variables declared in the environment section

override these values – this holds true even if those values are

empty or undefined.

env_file: - ./common.env - ./apps/web.env - /opt/runtime_opts.env

Compose expects each line in an env file to be in VAR=VAL format. Lines

beginning with # are treated as comments and are ignored. Blank lines are

also ignored.

# Set Rails/Rack environment RACK_ENV=development

Compose also recognizes inline comments, like in:

MY_VAR = value # this is a comment

To avoid interpreting «#» as an inline comment, use the quotation marks:

MY_VAR = "All the # inside are taken as part of the value"

Note

If your service specifies a build option, variables defined in

environment files are not automatically visible during the build. Use

the args sub-option ofbuildto define build-time environment

variables.

The value of VAL is used as is and not modified at all. For example if the

value is surrounded by quotes (as is often the case of shell variables), the

quotes are included in the value passed to Compose.

Keep in mind that the order of files in the list is significant in determining

the value assigned to a variable that shows up more than once. The files in the

list are processed from the top down. For the same variable specified in file

a.env and assigned a different value in file b.env, if b.env is

listed below (after), then the value from b.env stands. For example, given the

following declaration in docker-compose.yml:

services: some-service: env_file: - a.env - b.env

And the following files:

and

$VAR is hello.

environment

Add environment variables. You can use either an array or a dictionary. Any

boolean values (true, false, yes, no) need to be enclosed in quotes to ensure

they are not converted to True or False by the YML parser.

Environment variables with only a key are resolved to their values on the

machine Compose is running on, which can be helpful for secret or host-specific values.

environment: RACK_ENV: development SHOW: 'true' SESSION_SECRET:

environment: - RACK_ENV=development - SHOW=true - SESSION_SECRET

Note

If your service specifies a build option, variables defined in

environmentare not automatically visible during the build. Use the

args sub-option ofbuildto define build-time environment

variables.

expose

Expose ports without publishing them to the host machine — they’ll only be

accessible to linked services. Only the internal port can be specified.

expose: - "3000" - "8000"

external_links

Link to containers started outside this docker-compose.yml or even outside of

Compose, especially for containers that provide shared or common services.

external_links follow semantics similar to the legacy option links when

specifying both the container name and the link alias (CONTAINER:ALIAS).

external_links: - redis_1 - project_db_1:mysql - project_db_1:postgresql

Note

The externally-created containers must be connected to at least one of the same

networks as the service that is linking to them. Links

are a legacy option. We recommend using networks instead.

Note when using docker stack deploy

The

external_linksoption is ignored when

deploying a stack in swarm mode

{: .important }

extra_hosts

Add hostname mappings. Use the same values as the docker client --add-host parameter.

extra_hosts: - "somehost:162.242.195.82" - "otherhost:50.31.209.229"

An entry with the ip address and hostname is created in /etc/hosts inside containers for this service, e.g:

162.242.195.82 somehost 50.31.209.229 otherhost

healthcheck

Configure a check that’s run to determine whether or not containers for this

service are «healthy». See the docs for the

HEALTHCHECK Dockerfile instruction

for details on how healthchecks work.

healthcheck: test: ["CMD", "curl", "-f", "http://localhost"] interval: 1m30s timeout: 10s retries: 3 start_period: 40s

interval, timeout and start_period are specified as

durations.

Added in version 3.4 file format.

The

start_periodoption was added in file format 3.4.

test must be either a string or a list. If it’s a list, the first item must be

either NONE, CMD or CMD-SHELL. If it’s a string, it’s equivalent to

specifying CMD-SHELL followed by that string.

# Hit the local web app test: ["CMD", "curl", "-f", "http://localhost"]

As above, but wrapped in /bin/sh. Both forms below are equivalent.

test: ["CMD-SHELL", "curl -f http://localhost || exit 1"]

test: curl -f https://localhost || exit 1

To disable any default healthcheck set by the image, you can use disable: true.

This is equivalent to specifying test: ["NONE"].

healthcheck: disable: true

image

Specify the image to start the container from. Can either be a repository/tag or

a partial image ID.

image: example-registry.com:4000/postgresql

If the image does not exist, Compose attempts to pull it, unless you have also

specified build, in which case it builds it using the specified

options and tags it with the specified tag.

init

Added in version 3.7 file format.

Run an init inside the container that forwards signals and reaps processes.

Set this option to true to enable this feature for the service.

version: "{{ site.compose_file_v3 }}" services: web: image: alpine:latest init: true

The default init binary that is used is Tini,

and is installed in/usr/libexec/docker-initon the daemon host. You can

configure the daemon to use a custom init binary through the

init-pathconfiguration option.

isolation

Specify a container’s isolation technology. On Linux, the only supported value

is default. On Windows, acceptable values are default, process and

hyperv. Refer to the

Docker Engine docs

for details.

labels

Add metadata to containers using Docker labels. You can use either an array or a dictionary.

It’s recommended that you use reverse-DNS notation to prevent your labels from conflicting with those used by other software.

labels: com.example.description: "Accounting webapp" com.example.department: "Finance" com.example.label-with-empty-value: ""

labels: - "com.example.description=Accounting webapp" - "com.example.department=Finance" - "com.example.label-with-empty-value"

links

Warning

The

--linkflag is a legacy feature of Docker. It may eventually be removed.

Unless you absolutely need to continue using it, we recommend that you use

user-defined networks

to facilitate communication between two containers instead of using--link.One feature that user-defined networks do not support that you can do with

--linkis sharing environmental variables between containers. However, you

can use other mechanisms such as volumes to share environment variables between

containers in a more controlled way.

{:.warning}

Link to containers in another service. Either specify both the service name and

a link alias ("SERVICE:ALIAS"), or just the service name.

web: links: - "db" - "db:database" - "redis"

Containers for the linked service are reachable at a hostname identical to

the alias, or the service name if no alias was specified.

Links are not required to enable services to communicate — by default,

any service can reach any other service at that service’s name. (See also, the

Link containers section in Networking in Compose.)

Links also express dependency between services in the same way as

depends_on, so they determine the order of service startup.

Note

If you define both links and networks, services with

links between them must share at least one network in common to

communicate.

Note when using docker stack deploy

The

linksoption is ignored when

deploying a stack in swarm mode

{: .important }

logging

Logging configuration for the service.

logging: driver: syslog options: syslog-address: "tcp://192.168.0.42:123"

The driver name specifies a logging driver for the service’s

containers, as with the --log-driver option for docker run

(documented here).

The default value is json-file.

Note

Only the

json-fileandjournalddrivers make the logs available directly

fromdocker-compose upanddocker-compose logs. Using any other driver

does not print any logs.

Specify logging options for the logging driver with the options key, as with the --log-opt option for docker run.

Logging options are key-value pairs. An example of syslog options:

driver: "syslog" options: syslog-address: "tcp://192.168.0.42:123"

The default driver json-file, has options to limit the amount of logs stored. To do this, use a key-value pair for maximum storage size and maximum number of files:

options: max-size: "200k" max-file: "10"

The example shown above would store log files until they reach a max-size of

200kB, and then rotate them. The amount of individual log files stored is

specified by the max-file value. As logs grow beyond the max limits, older log

files are removed to allow storage of new logs.

Here is an example docker-compose.yml file that limits logging storage:

version: "{{ site.compose_file_v3 }}" services: some-service: image: some-service logging: driver: "json-file" options: max-size: "200k" max-file: "10"

Logging options available depend on which logging driver you use

The above example for controlling log files and sizes uses options

specific to the json-file driver.

These particular options are not available on other logging drivers.

For a full list of supported logging drivers and their options, refer to the

logging drivers documentation.

network_mode

Network mode. Use the same values as the docker client --network parameter, plus

the special form service:[service name].

network_mode: "service:[service name]"

network_mode: "container:[container name/id]"

Note

- This option is ignored when

deploying a stack in swarm mode.network_mode: "host"cannot be mixed with links.

{: .important }

networks

Networks to join, referencing entries under the

top-level networks key.

services: some-service: networks: - some-network - other-network

aliases

Aliases (alternative hostnames) for this service on the network. Other containers on the same network can use either the service name or this alias to connect to one of the service’s containers.

Since aliases is network-scoped, the same service can have different aliases on different networks.

Note

A network-wide alias can be shared by multiple containers, and even by multiple

services. If it is, then exactly which container the name resolves to is not

guaranteed.

The general format is shown here.

services: some-service: networks: some-network: aliases: - alias1 - alias3 other-network: aliases: - alias2

In the example below, three services are provided (web, worker, and db),

along with two networks (new and legacy). The db service is reachable at

the hostname db or database on the new network, and at db or mysql on

the legacy network.

version: "{{ site.compose_file_v3 }}" services: web: image: "nginx:alpine" networks: - new worker: image: "my-worker-image:latest" networks: - legacy db: image: mysql networks: new: aliases: - database legacy: aliases: - mysql networks: new: legacy:

ipv4_address, ipv6_address

Specify a static IP address for containers for this service when joining the network.

The corresponding network configuration in the

top-level networks section must have an

ipam block with subnet configurations covering each static address.

If you’d like to use IPv6, you must first ensure that the Docker daemon is configured to support IPv6. See Enable IPv6 for detailed instructions. You can then access IPv6 addressing in a version 3.x Compose file by editing the /etc/docker/daemon.json to contain:

{"ipv6": true, "fixed-cidr-v6": "2001:db8:1::/64"}

Then, reload the docker daemon and edit docker-compose.yml to contain the following under the service:

sysctls: - net.ipv6.conf.all.disable_ipv6=0

The

enable_ipv6

option is only available in a version 2.x Compose file.

IPv6 options do not currently work in swarm mode.

An example:

version: "{{ site.compose_file_v3 }}" services: app: image: nginx:alpine networks: app_net: ipv4_address: 172.16.238.10 ipv6_address: 2001:3984:3989::10 networks: app_net: ipam: driver: default config: - subnet: "172.16.238.0/24" - subnet: "2001:3984:3989::/64"

pid

Sets the PID mode to the host PID mode. This turns on sharing between

container and the host operating system the PID address space. Containers

launched with this flag can access and manipulate other

containers in the bare-metal machine’s namespace and vice versa.

ports

Expose ports.

Note

Port mapping is incompatible with

network_mode: host

Note

docker-compose runignoresportsunless you include--service-ports.

Short syntax

There are three options:

- Specify both ports (

HOST:CONTAINER) - Specify just the container port (an ephemeral host port is chosen for the host port).

- Specify the host IP address to bind to AND both ports (the default is 0.0.0.0, meaning all interfaces): (

IPADDR:HOSTPORT:CONTAINERPORT). If HOSTPORT is empty (for example127.0.0.1::80), an ephemeral port is chosen to bind to on the host.

Note

When mapping ports in the

HOST:CONTAINERformat, you may experience

erroneous results when using a container port lower than 60, because YAML

parses numbers in the formatxx:yyas a base-60 value. For this reason,

we recommend always explicitly specifying your port mappings as strings.

ports: - "3000" - "3000-3005" - "8000:8000" - "9090-9091:8080-8081" - "49100:22" - "127.0.0.1:8001:8001" - "127.0.0.1:5000-5010:5000-5010" - "127.0.0.1::5000" - "6060:6060/udp" - "12400-12500:1240"

Long syntax

The long form syntax allows the configuration of additional fields that can’t be

expressed in the short form.

target: the port inside the containerpublished: the publicly exposed portprotocol: the port protocol (tcporudp)mode:hostfor publishing a host port on each node, oringressfor a swarm

mode port to be load balanced.

ports: - target: 80 published: 8080 protocol: tcp mode: host

Added in version 3.2 file format.

The long syntax is new in the v3.2 file format.

profiles

profiles: ["frontend", "debug"] profiles: - frontend - debug

profiles defines a list of named profiles for the service to be enabled under.

When not set, the service is always enabled. For the services that make up

your core application you should omit profiles so they will always be started.

Valid profile names follow the regex format [a-zA-Z0-9][a-zA-Z0-9_.-]+.

See also Using profiles with Compose to learn more about

profiles.

restart

no is the default restart policy, and it does not restart a container under

any circumstance. When always is specified, the container always restarts. The

on-failure policy restarts a container if the exit code indicates an

on-failure error. unless-stopped always restarts a container, except when the

container is stopped (manually or otherwise).

restart: "no"

restart: always

restart: on-failure

restart: unless-stopped

Note when using docker stack deploy

The

restartoption is ignored when

deploying a stack in swarm mode.

{: .important }

secrets

Grant access to secrets on a per-service basis using the per-service secrets

configuration. Two different syntax variants are supported.

Note when using docker stack deploy

The secret must already exist or be

defined in the top-levelsecretsconfiguration

of the compose file, or stack deployment fails.

{: .important }

For more information on secrets, see secrets.

Short syntax

The short syntax variant only specifies the secret name. This grants the

container access to the secret and mounts it at /run/secrets/<secret_name>

within the container. The source name and destination mountpoint are both set

to the secret name.

The following example uses the short syntax to grant the redis service

access to the my_secret and my_other_secret secrets. The value of

my_secret is set to the contents of the file ./my_secret.txt, and

my_other_secret is defined as an external resource, which means that it has

already been defined in Docker, either by running the docker secret create

command or by another stack deployment. If the external secret does not exist,

the stack deployment fails with a secret not found error.

version: "{{ site.compose_file_v3 }}" services: redis: image: redis:latest deploy: replicas: 1 secrets: - my_secret - my_other_secret secrets: my_secret: file: ./my_secret.txt my_other_secret: external: true

Long syntax

The long syntax provides more granularity in how the secret is created within

the service’s task containers.

source: The identifier of the secret as it is defined in this configuration.target: The name of the file to be mounted in/run/secrets/in the

service’s task containers. Defaults tosourceif not specified.uidandgid: The numeric UID or GID that owns the file within

/run/secrets/in the service’s task containers. Both default to0if not

specified.mode: The permissions for the file to be mounted in/run/secrets/

in the service’s task containers, in octal notation. For instance,0444

represents world-readable. The default in Docker 1.13.1 is0000, but it is

0444in newer versions. Secrets cannot be writable because they are mounted

in a temporary filesystem, so if you set the writable bit, it is ignored. The

executable bit can be set. If you aren’t familiar with UNIX file permission

modes, you may find this

permissions calculator{: target=»blank» rel=»noopener» class=»» }

useful.

The following example sets name of the my_secret to redis_secret within the

container, sets the mode to 0440 (group-readable) and sets the user and group

to 103. The redis service does not have access to the my_other_secret

secret.

version: "{{ site.compose_file_v3 }}" services: redis: image: redis:latest deploy: replicas: 1 secrets: - source: my_secret target: redis_secret uid: '103' gid: '103' mode: 0440 secrets: my_secret: file: ./my_secret.txt my_other_secret: external: true

You can grant a service access to multiple secrets and you can mix long and

short syntax. Defining a secret does not imply granting a service access to it.

security_opt

Override the default labeling scheme for each container.

security_opt: - label:user:USER - label:role:ROLE

Note when using docker stack deploy

The

security_optoption is ignored when

deploying a stack in swarm mode.

{: .important }

stop_grace_period

Specify how long to wait when attempting to stop a container if it doesn’t

handle SIGTERM (or whatever stop signal has been specified with

stop_signal), before sending SIGKILL. Specified

as a duration.

By default, stop waits 10 seconds for the container to exit before sending

SIGKILL.

stop_signal

Sets an alternative signal to stop the container. By default stop uses

SIGTERM. Setting an alternative signal using stop_signal causes

stop to send that signal instead.

sysctls

Kernel parameters to set in the container. You can use either an array or a

dictionary.

sysctls: net.core.somaxconn: 1024 net.ipv4.tcp_syncookies: 0

sysctls: - net.core.somaxconn=1024 - net.ipv4.tcp_syncookies=0

You can only use sysctls that are namespaced in the kernel. Docker does not

support changing sysctls inside a container that also modify the host system.

For an overview of supported sysctls, refer to

configure namespaced kernel parameters (sysctls) at runtime.

Note when using docker stack deploy

This option requires Docker Engine 19.03 or up when

deploying a stack in swarm mode.

tmpfs

Added in version 3.6 file format.

Mount a temporary file system inside the container. Can be a single value or a list.

Note when using docker stack deploy

This option is ignored when

deploying a stack in swarm mode

with a (version 3-3.5) Compose file.

Mount a temporary file system inside the container. Size parameter specifies the size

of the tmpfs mount in bytes. Unlimited by default.

- type: tmpfs target: /app tmpfs: size: 1000

ulimits

Override the default ulimits for a container. You can either specify a single

limit as an integer or soft/hard limits as a mapping.

ulimits: nproc: 65535 nofile: soft: 20000 hard: 40000

userns_mode

Disables the user namespace for this service, if Docker daemon is configured with user namespaces.

See dockerd for

more information.

Note when using docker stack deploy

The

userns_modeoption is ignored when