Подготовка

Этот туториал, и код в нем, требует установки нескольких дополнительных библиотек для Python. Они обеспечивают обертку Python’а в кусок низкоуровневого C-кода, который значительно упрощает создание и скорость исполнения.

Некоторые библиотеки существуют только под Windows. У них могут быть эквиваленты под Mac или linux, но мы не будем их рассматривать.

Вам нужно скачать и установить следующие библиотеки:

- Python Imaging Library (PYL)

- Numpy

- PyWin

Все представленные библиотеки комплектуются установщиками. Запуск их автоматически установит модуль в директорию libsite-packages и, теоретически, добавит соответствующий pythonPath. Однако, на практике это происходит не всегда. Если Вы получите сообщение об ошибке после установки, добавьте их вручную в переменные Path.

Последний инструмент это графический редактор. Я предлагаю использовать Paint.Net как лучший из бесплатных, но подойдет любая программа с линейками и измерениями в пикеслях.

Мы будем использовать несколько игр в качестве примеров.

Введение

Это руководство написано с целью дать базовое понимание основы разработки ботов для браузерных игр. Подход, который мы собираемся дать, вероятно немного отличается от того, что многие ожидают услышать говоря о ботах. Вместо того, чтобы сделать программу, вставляющую код между клиентом и сервером (как боты для Quake или CS), наш бот будет находиться чисто снаружи. Мы будем опираться на методы Компьютерного зрения и вызовы Windows API для сбора необходимой информации и выполнения движений.

С этим подходом мы теряем часть деталей и контроля, но сокращаем время разработки и получим простоту в использовании. Автоматизирование специфичных игровых функций может быть создано в несколько строк кода, и полноценный бот, от начала до конца (для простой игры) может быть собран за несколько часов.

Когда вы привыкните к тому, что компьютер может видеть, начнете смотреть на игры по-другому. Хороший пример это поиск в играх-пазлах. Обычное решение основывается на ограничении скорости игрока, что заставляет принимать не оптимальные решения. Интересно (и довольно легко) «взломать» их скриптами движений которые не повторить человеку.

Эти боты могут быть также очень полезны для тестирования простых игр — в отличии от реальных игроков, боту не надоест играть один сценарий снова и снова.

Исходники примеров из курса, а также одного законченного бота можно найти здесь.

Шаг 1: Создание проекта

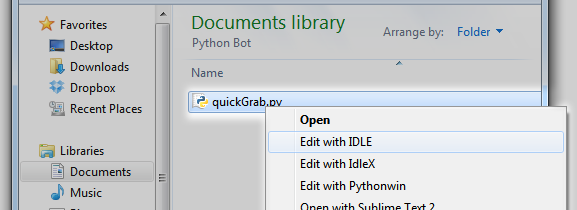

В папке с проектом создайте текстовый файл quickGrab, измените расширение на ‘py’ и откройте его в редакторе кода.

Шаг 2: Создаем приложение, которое делает скриншот экрана

Начнем работу с изучения базовой функции, которая делает скриншот экрана. Один раз создав и запустив, мы будем строчка за строчкой, как эту функцию, создавать каркас нашего кода.

Вставим в наш файл с проектом quickGrab.py следующий код:

ImageGrab

import os

import time

def screenGrab():

box = ()

im = ImageGrab.grab()

im.save(os.getcwd() + '\full_snap__' + str(int(time.time())) + '.png', 'PNG')

def main():

screenGrab()

if __name__ == '__main__':

main()

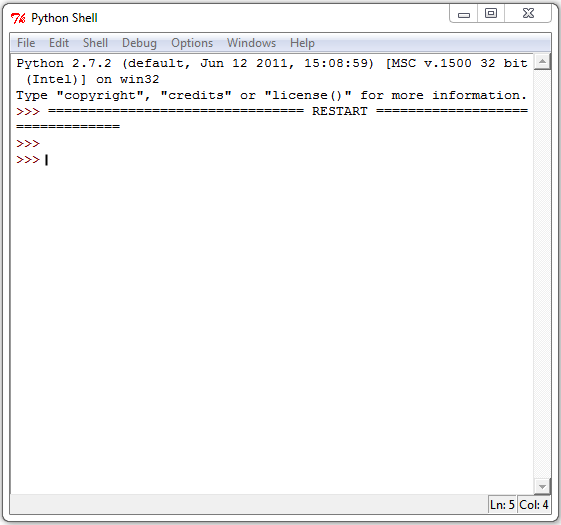

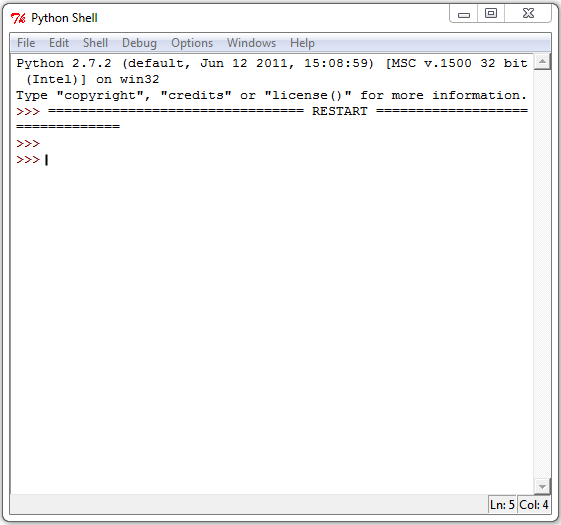

Запустив этот код, вы получите скриншот экрана:

Данный код забирает всю ширину и высоту области экрана и сохраняет в PNG файл в директорию проекта.

Давайте пошагово разберем код, чтобы понять как это работает. Первые три строки:

import ImageGrab

import os

import time

…называются ‘import statements’. Они говорят Pytjon’у какие модули загружать во время выполнения. Это дает доступ к методам этих модулей через синтаксис module.attribute .

Первый модуль Python Image Library мы установили ранее. Как следует из названия, он дает нам функциональность взаимодействия с экраном на которую ссылается бот.

Вторая строка импортирует модуль операционной системы (OS — operating system). Он дает возможность простой навигации по директориям в операционной системе. Это пригодится, когда мы начинаем размещать файлы в разных папках.

Последний импорт создает модуль работы со временем. Мы используем его для установки текущей даты скриншота, также он может быть очень полезным как таймер для ботов, которые выполняют действие в течение заданного количества секунд.

Следующие четыре строки определяют функцию screenGrab().

def screenGrab():

box = ()

im = ImageGrab.grab()

im.save(os.getcwd() + '\full_snap__' + str(int(time.time())) + '.png', 'PNG')

Первая строка def screenGrab() определяет имя функции. Пустые скобки означают, что она не принимает аргументов.

Строка 2, box = () присваивает пустое значение переменной «box». Мы заполним это значение дальше.

Строка 3, im = ImageGrab.grab() создает полный скриншот экрана и возвращает RGB изображение в переменную im .

Строка 4, может быть немного сложнее если вы не очень хорошо знакомы с тем как работает Time module. Первая часть im.save( вызывает метод «save». Он принимает два аргумента. Первый это директория в которую нужно сохранить файл, а второй это формат файла.

Здесь мы устанавливаем директорию вызовом метода os.getcwd() . Функция получает текущую директорию в которой выполняется код и возвращает её как строку. Далее мы добавим «+». Сложение нужно использовать между каждым новым аргументом для соединения всех строк вместе.

Следующая часть '\full_snap__ дает нам простое описание в имени файла. Обратный слеш является экранирующим символом в Python, и мы добавили два, чтобы избежать отмены одного из символов.

Далее идет эта сложная конструкция: str(int(time.time())). Она использует встроенные функции Питона. Мы рассмотрим работу этого куска кода изнутри:

time.time() возвращает количество секунд с начала Эпохи, тип данных Float (число с плавающей точкой). Так как мы используем дату для именования файлов, мы не можем использовать десятичное число, поэтому мы обернем выражение в int(), чтобы конвертировать в целое число (Integer). Это делает нас ближе к решению, но Python не может соединить тип Integer с типом String, поэтому следующим шагом мы обернем все в функцию str(). Далее остается только добавить расширение как часть строки + '.png' и добавить вторым аргументом функции снова расширение: «PNG».

Последняя часть кода определяет функцию main(), которая вызывает функцию screenGrab(), когда исполняется.

И, наконец, условное обозначение, которое позволяет интерпретатору определить, какую функцию запускать в случае, если файл запущен как основной (а не просто импортирован в другой скрипт). В противном случае, если он загружен как модуль другого скрипта — он только передает доступ к этому методу, вместо выполнения.

def main():

screenGrab()

if __name__ == '__main__':

main()

Шаг 3: Область видимости

Функция ImageGrab.grab() принимает один аргумент, который определяет область видимости. Это набор координат по шаблону (x,y,x,y), где

- Первая пара значение (x,y… определяет левый верхний угол рамки;

- Вторая пара …x,y) определяет правый нижний.

Это дает нам возможность скопировать только часть экрана, которая нам нужна.

Рассмотрим это на практике.

Для примера рассмотрим игру Sushi Go Round (Довольно увлекательная. Я Вас предупредил). Откройте игру в новой вкладке и сделайте скриншот использую существующий код screenGrab():

Шаг 4: Задание координат

Пришло время задания координат для нашей области видимости.

Откройте скриншот в редакторе картинок.

Координаты (0,0) это всегда левый верхний угол изображения. Мы хотим заполнить X и Y таким образом, чтобы нашему новому скриншоту функция установила координаты (0,0) в крайний левый угол игровой области.

Этому есть две причины. Во-первых, это упрощает нахождение координат, когда мы должны определять координаты относительно игровой области, по сравнению со всем экраном монитора. Во-вторых, захват меньшей части экрана уменьшает нагрузку на процессор. Полноэкранные скриншоты производят довольно много данных, чтобы их можно было циклично повторять несколько раз в секунду.

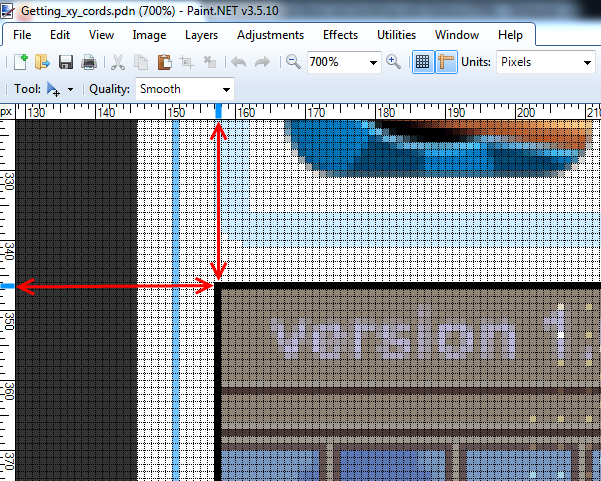

Если вы это еще не сделали, включите линейки в вашем графическом редакторе и приблизьте верхний угол игровой области до той степени, пока не увидите рамки пикселей.

Наведите курсор на первый пиксель игровой области и запишите координаты на линейках. Это будут первые два значения для нашей функции. У меня получились значения (305, 243).

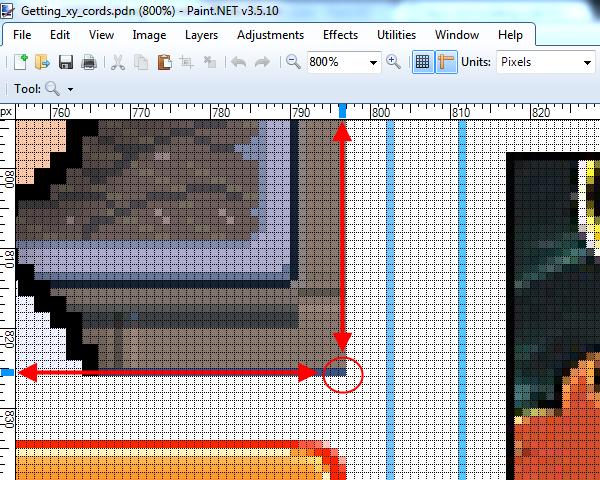

Затем следуйте к нижнему краю и запишите вторую пару координат. У меня получилось (945, 723). Вместе эти пары дают область с координатами (305,243,945,723).

Давайте добавим координаты в код:

import ImageGrab

import os

import time

def screenGrab():

box = (305,243,945,723)

im = ImageGrab.grab(box)

im.save(os.getcwd() + '\full_snap__' + str(int(time.time())) +

'.png', 'PNG')

def main():

screenGrab()

if __name__ == '__main__':

main()

На строке 6 мы обновили массив для хранения координат игровой области.

Сохраните и запустите код. Откройте новое сохраненное изображение и вы увидите следующее:

Отлично! Это идеальный снимок игровой области. Нам не всегда будет требоваться эта напряженная охота за координатами. После того, как мы узнаем о win32api, мы рассмотрим более быстрые методы для установки координат, когда нам нужна идеальная точность.

Шаг 5: Перспективное планирование для гибкости

На данный момент, мы жестко прописали координаты по отношению к текущей настройке, исходя из нашего браузера и нашего разрешения монитора. Вообще, это плохая идея — жестко прописывать координаты таким образом. Если, например, мы хотим запустить код на другом компьютере, или, скажем, что-то на сайте немного сдвинет позицию игровой области — нам придется вручную скрупулезно фиксировать все наши координаты заново.

Давайте создадим две новые переменные: x_pad и y_pad. В них будет храниться расстояние между игровой областью и остальным экраном. Это поможет легко портировать код с места на место, так как каждая новая координата будет задаваться относительно двух глобальных переменных, которые мы создадим. Чтобы настроить изменения экрана нужно сбросить эти две переменные.

Так как мы уже сделали измерения, установить отступы для нашей текущей системы достаточно просто. Мы собираемся установить отступы, чтобы хранить положение первого пикселя за пределами игровой площадки. От первой пары координат нашего кортежа вычесть по 1. Получается 304 и 242.

Давайте добавим это в наш код:

# Globals

# ------------------

x_pad = 304

y_pad = 242

Теперь, когда они установлены, мы скорректируем координаты игровой области относительно них.

def screenGrab():

box = (x_pad+1, y_pad+1,945,723)

im = ImageGrab.grab(box)

im.save(os.getcwd() + '\full_snap__' + str(int(time.time())) + '.png', 'PNG')

Для второй пары значений мы собираемся сначала найти разницу между первой и второй парой координат, чтобы получить размер игрового окна, а затем использовать эти значения с нашими переменными.

def screenGrab():

box = (x_pad+1, y_pad+1, x_pad+641, y_pad+481)

im = ImageGrab.grab(box)

im.save(os.getcwd() + '\full_snap__' + str(int(time.time())) + '.png', 'PNG')

Для координаты x значение стало 945 — 304 = 641, а для y стало 723 — 242 = 481.

Сперва это может показаться излишним, но это дополнительный шаг к более легкому обслуживанию в будущем.

Шаг 6: Создание документации

Перед тем как перейти дальше, создадим документацию в начале нашего проекта. Так как большая часть нашего кода будет базироваться на особых координатах экрана и отношении к этим координатам, важно понимать окружение в котором всё будет работать правильно. Например, таких условия как разрешение монитора, браузер, включенная панель инструментов (так как это меняет размер окна браузера), и другие настройки необходимые для центровки игровой области на экране, все это влияет на относительные позиции координат. Документирование всего этого сильно помогает в решении проблем, когда код запускается на разных браузерах и компьютерах.

Напоследок, нужно следить за постоянно меняющимся рекламным пространством на популярных игровых сайтах. Если функция захвата экрана перестает себя вести, как ожидалось, стоит добавить координатам немного смещения.

Для примера, я обычно добавляю подобный комментарий в начало моего кода:

"""

All coordinates assume a screen resolution of 1280x1024, and Chrome

maximized with the Bookmarks Toolbar enabled.

Down key has been hit 4 times to center play area in browser.

x_pad = 156

y_pad = 345

Play area = x_pad+1, y_pad+1, 796, 825

"""

Добавление всей этой информации в начало файла позволяет быстро и легко перепроверить все настройки и выравнивание экрана без необходимости корпеть над кодом, пытаясь вспомнить, где вы сохранили конкретную x-координату.

Шаг 7: Делаем quickGrab.py удобным инструментом

Мы собираемся клонировать наш проект в этой точке, создавая два файла: один, чтобы писать код нашего бота, другой чтобы хранить функцию снимка экрана. Мы будем делать много снимков, поэтому с отдельным модулем работа пойдет быстрее.

Сохраните и закройте текущий проект.

Создайте копию проекта в этой же папке и переименуйте файл в code.py. Теперь добавление и редактирование всех изменений мы будем производить в code.py, а quickGrab.py оставим исключительно для скриншотов. Только добавим одно финальное изменение: изменим расширение на .pyw

Это расширение сообщает Питону, что нужно запускать скрипт без открытия консоли. Двойной клик по файлу и он быстро выполнится в фоне и сохранит скриншот в рабочую директорию.

Держите игру открытой в фоне (не забудьте отключить зацикленную музыку, иначе она сведет вас с ума); мы скоро к ней вернемся. У нас еще есть несколько инструментов для внедрения, прежде чем начать контролировать вещи на экране.

Шаг 8: win32api — краткий обзор

Работать с win32api может быть немного сложно на начальном этапе. Это обертка в низкоуровневый Windows C, которых хорошо задокументирован здесь, но навигация похожа на лабиринт, так что пару раз придется пройти по кругу.

Если при выполнении Вы видите ошибку «ImportError: No module named win32api», значит не установлен этот модуль. Выполните в консоли команду

pip install pypiwin32

Прежде чем мы начнем писать код, давайте поближе познакомимся с некоторыми функциями API на которые далее мы будем опираться. После того как у нас появится четкое понимание каждого параметра, мы сможем легко настроить их для наших целей в игре.

win32api.mouse_event():

win32api.mouse_event(

dwFlags,

dx,

dy,

dwData

)

Первый параметр dwFlags определяет «действия» мыши. Такие как перемещение, клик, скроллинг и т.п. Следующий список показывает распространенные параметры, используемые для программирования движений.

- win32con.MOUSEEVENTF_LEFTDOWN

- win32con.MOUSEEVENTF_LEFTUP

- win32con.MOUSEEVENTF_MIDDLEDOWN

- win32con.MOUSEEVENTF_MIDDLEUP

- win32con.MOUSEEVENTF_RIGHTDOWN

- win32con.MOUSEEVENTF_RIGHTUP

- win32con.MOUSEEVENTF_WHEEL

Имена говорят сами за себя. Если вы хотите выполнить виртуальный правый клик, нужно отправить параметр win32con.MOUSEEVENTF_RIGHTDOWN в dwFlags.

Следующие два параметра, dx и dy, описывают абсолютную позицию вдоль осей x и y. Пока мы будем использовать эти параметры для программирования движения мыши, они будут использовать систему координат отличную от той, которую мы использовали до этого. Мы зададим нули и будем опираться на другую часть API для движения мыши.

Четвертый параметр это dwData. Эта функция используется тогда и только тогда, когда dwFlags содержит MOUSEEVENTF_WHEEL. В других случаях она может быть опущена или установлена в 0. dwData скорость прокрутки колеса мыши.

Простой пример для закрепления

Если мы представим игру с переключением оружия как в Half-Life 2 (где оружие может быть выбрано вращением колеса) — мы можем использовать эту функцию для выбора оружия из списка:

def browseWeapons():

weaponList = ['crowbar','gravity gun','pistol'...]

for i in weaponList:

win32api.mouse_event(win32con.MOUSEEVENTF_MOUSEEVENTF_WHEEL,0,0,120)

Здесь мы хотим симулировать скроллинг колеса мыши для навигации по нашему теоретическому списку оружия, поэтому мы вносим ...MOUSEEVENTF_WHEEL в dwFlag. Не нужно указывать позиционирование dx и dy, оставим эти значения 0, и нам нужен один скрол вперед для каждого оружия в списке, поэтому устанавливаем значение 120 для dwData, что соответствует одному скролу мыши.

Как вы видите, работа с mouse_event это просто вопрос подключения правильных аргументов в правильном порядке. Давайте перейдем к более полезным функциям.

Шаг 9: Клики мыши

Мы переходим к созданию трех новых функций. Одна общая функция нажатия левой кнопки мыши, и два обработчика состояний нажатия и отпускания.

Откройте code.py в редакторе и добавьте следующее выражение к списку импортов

import win32api, win32conКак и ранее, это дает нам доступ к содержимому модуля через синтаксис module.attribute

Далее создадим первую функцию клика мыши

def leftClick():

win32api.mouse_event(win32con.MOUSEEVENTF_LEFTDOWN,0,0)

time.sleep(.1)

win32api.mouse_event(win32con.MOUSEEVENTF_LEFTUP,0,0)

print "Click." #completely optional. But nice for debugging purposes.

Напомню, что все, что мы делаем здесь это назначаем действие первому аргументу mouse_event. Мы не должны указывать никакую информацию о позиционировании, поэтому мы опускаем параметры координат (0,0), и мы не должны указывать дополнительную информацию, такую как dwData. Функция time.sleep(.1) говорит Питону приостановить выполнение на время указанное в скобках. Добавим это в наш код. Обычно это очень короткий промежуток времени. Без этого клик может получиться до того, как меню обновится.

Мы создали функцию для левого клика. Один раз нажать, один раз отпустить. Мы потратили много времени на нее, но давайте создадим еще две вариации. Это тоже самое, но теперь каждый шаг мы разобьем на отдельную функцию. Это можно использовать когда нам надо удерживать нажатой мышь в течение продолжительного времени (например, для перетаскивания предметов или стрельбы.)

def leftDown():

win32api.mouse_event(win32con.MOUSEEVENTF_LEFTDOWN,0,0)

time.sleep(.1)

print 'left Down'

def leftUp():

win32api.mouse_event(win32con.MOUSEEVENTF_LEFTUP,0,0)

time.sleep(.1)

print 'left release'

Шаг 10: Простые движения мышью

Все, что остается это движение мыши по экрану. Добавим следующие функции в файл code.py

def mousePos(cord):

win32api.SetCursorPos((x_pad + cord[0], y_pad + cord[1])

def get_cords():

x,y = win32api.GetCursorPos()

x = x - x_pad

y = y - y_pad

print x,y

Эти две функции служат совершенно разным целям. Первая будет использоваться для задания движения в программе. Благодаря соглашению об именовании, тело функции делает именно то, что обозначает название SetCursorPos(). Вызов этой функции устанавливает координаты мыши по заданным (x,y). Обратите внимание, что мы добавили поправки x_pad и y_pad к координатам; это важно делать там, где координаты объявляются.

Вторая функция это простой инструмент который мы будем использовать в интерактивном режиме. Он выводит в консоль координаты текущей позиции мыши. Это сильно ускоряет процесс навигации в меню без необходимости делать скриншот и пользоваться линейками. Мы не хотим постоянно использовать эту функцию, так как некоторая активность мыши будет требовать точного позиционирования, но там где это возможно, это хорошо сэкономит нам время.

На следующем шаге мы применим эти техники для начала навигации в игровом меню. Но сначала надо удалить текущий контент у main() в сode.py и заменить его на тот, который мы написали. На следующем шаге мы будем работать с интерактивным режимом , поэтому функция screenGrab() нам пока не понадобиться.

Шаг 11: Навигация в меню

В этом и в следующих нескольких этапах мы попытаемся собрать координаты для разных событий используя метод get_cords(). Используя его мы сможем быстро построить код для таких вещей как навигация по меню, очистка столов, приготовление еды. После сбора мы встроим их в логику бота.

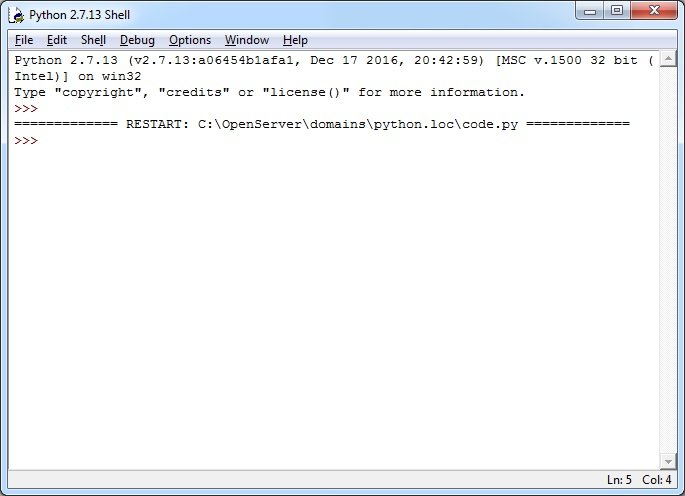

Давайте начнем. Сохраните и запустите код в Python Shell. С тех пор как на прошлом шаге мы заменили тело функции main()на pass, вы должны увидеть пустое окно после запуска Shell.

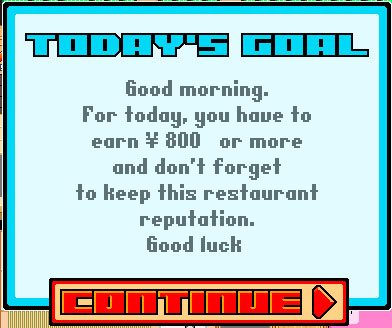

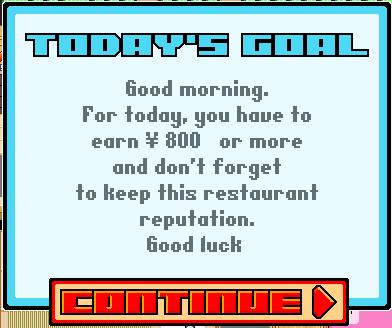

Теперь прежде чем перейти к игровой части, нужно пройти 4 начальных меню.

- Кнопка «Play»

- Кнопка «continue»

- Пропустить обучение «skip»

- Кнопка «continue»

Мы должны получить координаты каждой кнопки и добавить их в новую функцию startGame(). Расположите на экране Shell так, чтобы была видна игровая область. Нужно поставить мышь на кнопку, координаты которой нужно получить и выполнить в Shell функцию get_cords(). Убедитесь, что активным окном является Shell. Мы получим в Shell’е координаты текущей позиции мыши. Повторите это для остальных трех окон.

Оставьте Shell открытым и настройте экран так, чтобы видеть IDLE редактор. Добавим функцию startGame() и заполним новыми координатами.

def startGame():

#location of first menu

mousePos((182, 225))

leftClick()

time.sleep(.1)

#location of second menu

mousePos((193, 410))

leftClick()

time.sleep(.1)

#location of third menu

mousePos((435, 470))

leftClick()

time.sleep(.1)

#location of fourth menu

mousePos((167, 403))

leftClick()

time.sleep(.1)

Теперь у нас есть компактная функция, которую можно вызывать на старте каждой игры. Она устанавливает курсор на каждую позицию в меню, которую мы заранее определили и кликает. time.sleep(.1) говорит Питону остановить выполнение на 1/10 секунды между каждым кликом, чтобы меню успевало обновляться между кликами. Сохраните и запустите код.

У меня, как у медленного человека, прохождение меню вручную занимает больше секунды, тогда как наш бот может сделать это в течение примерно 0,4 секунд. Совсем неплохо!

Шаг 12: Зададим координаты еды

Давайте повторим процесс для каждой кнопки.

С помощью get_cords(), соберите координаты еды из меню. Еще раз в Python Shell напишите get_cords(), наведите мышь на еду и выполните команду.

Как вариант, для ускорения работы, если у вас есть второй монитор или вы можете организовать расположение таким образом, чтобы видеть браузер и окно Shell, можно не вводить каждый раз get_cords(), а сделать простой цикл for. Используйте метод time.sleep() чтобы успевать перемещать мышь между итерациями цикла.

for i in range(6):

time.sleep(1.2)

print get_cords()

Нам нужно создать новый класс Cord, чтобы хранить в нем собранные координаты. Возможность вызова через Cord.f_rice дает большие преимущества, так как можно передававть координаты прямо в mousePos(). Как вариант, можно хранить всё в словарях, но я нахожу синтаксис классов более удобным.

class Cord:

f_shrimp = (40,340)

f_rice = (90, 340)

f_nori = (40, 387)

f_roe = (90, 387)

f_salmon = (40, 440)

f_unagi = (90, 440)

Мы будем хранить много наших координат в этом классе, там будет некоторое дублирование, поэтому добавив префикс ‘f_’ мы будем знать, что это ссылка на еду, а не, скажем, на заказ еды по телефону.

Продолжим добавлять координаты.

Шаг 13: Координаты пустых мест

Каждый раз после еды посетители оставляют пустые тарелки, на которые нужно кликать, чтобы убрать. Поэтому нам нужно знать расположение тарелок.

Повторите действия из предыдущих шагов, чтобы получить координаты тарелок. Сохраните их пока в закомментированной строке.

"""

Plate cords:

87, 208

194, 208

288, 208

395, 208

491, 208

591, 208

Осталось всего несколько шагов до действительно интересных штук.

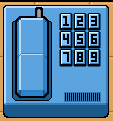

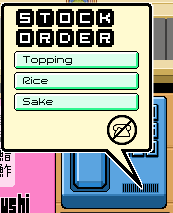

Шаг 14: Координаты телефона

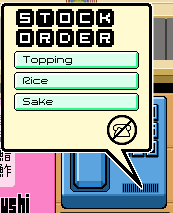

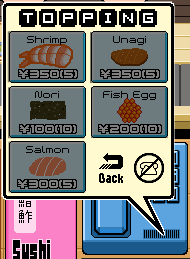

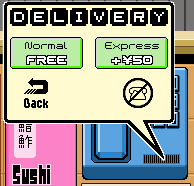

Итак, это будет последняя часть координат. Здесь понадобиться намного больше действий, поэтому вы можете сделать это вручную функцией get_cords(), вместо цикла. Мы собираемся прокликать всё меню телефона, чтобы получить координаты каждого пункта.

Здесь есть сложности, так как нам нужно иметь достаточно денег, чтобы купить что-то. Поэтому нам нужно сделать несколько порций суши, прежде чем вбивать координаты телефонных сделок. Нам придется сделать два суши рола , чтобы купить немного риса.

Есть шесть меню, через которые нам надо пройти.

- Телефон

- Начальное меню

- Начинки

- Рис

- Доставка

Нам нужно получить координаты всех, кроме Саке (можете её тоже добавить, если хотите. На мой взгляд бот отлично работает и без нее).

class Cord:

f_shrimp = (40,340)

f_rice = (90, 340)

f_nori = (40, 387)

f_roe = (90, 387)

f_salmon = (40, 440)

f_unagi = (90, 440)

#-----------------------------------

phone = (574, 358)

menu_toppings = (528, 273)

t_shrimp = (495, 224)

t_nori = (490, 287)

t_roe = (574, 279)

t_salmon = (494, 340)

t_unagi = (576, 218)

t_exit = (591, 342)

menu_rice = (532, 293)

buy_rice = (548, 281)

delivery_norm = (490, 292)

Окей! Мы наконец собрали все необходимые координаты. Давайте создадим что-нибудь полезное!

Шаг 15: Убираем со стола

Мы используем координаты собранные ранее для создания функции clear_tables().

def clear_tables():

mousePos((87, 208))

leftClick()

mousePos((194, 208))

leftClick()

mousePos((288, 208))

leftClick()

mousePos((395, 208))

leftClick()

mousePos((491, 208))

leftClick()

mousePos((591, 208))

leftClick()

time.sleep(1)

Как вы можете видеть, это выглядит более менее похоже на нашу прошлую функцию startGame(). С одним небольшим отличием: нет функции time.sleep() между кликами. Нам не нужно ждать обновления меню, поэтому не нужно ждать задержку между кликами.

Однако, у нас есть функция time.sleep() в самом конце. Хотя это и не обязательно, лучше добавить паузы в выполнение кода, чтобы была возможность вручную завершить цикл, если это потребуется. В противном случае скрипт будет менять позицию мыши снова и снова и вы не будете в состоянии переместить фокус на Shell, чтобы остановить сценарий. Это прикольно первые два или три раза, но быстро теряет свое очарование.

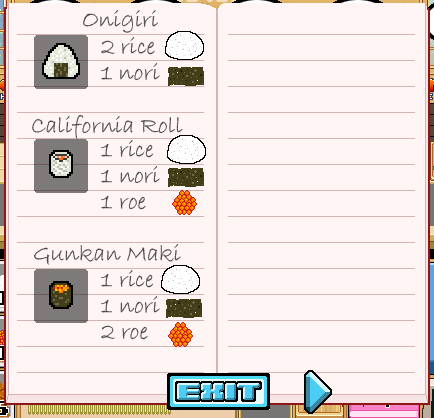

Шаг 16: Создание суши

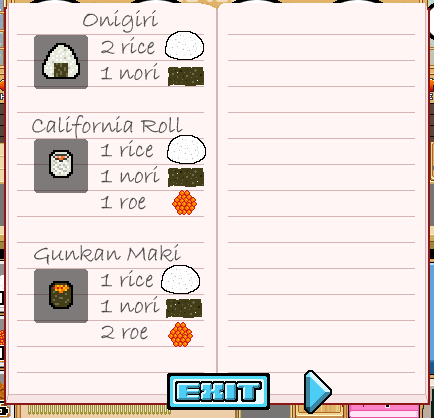

Сначала нужно понять как сделать суши. Кликните на книгу рецептов, чтобы открыть инструкции. Все виды суши, встречающиеся в игре, могут быть найдены на страницах этой книги. Оставлю первые три ниже, остальные вы можете найти в книге по ходу игры.

'''

Recipes:

onigiri

2 rice, 1 nori

caliroll:

1 rice, 1 nori, 1 roe

gunkan:

1 rice, 1 nori, 2 roe

'''

Теперь давайте создадим функцию, которая будет принимать в виде аргумента тип суши и затем собирать требуемые ингредиенты для переданного значения.

def makeFood(food):

if food == 'caliroll':

print 'Making a caliroll'

mousePos(Cord.f_rice)

leftClick()

time.sleep(.05)

mousePos(Cord.f_nori)

leftClick()

time.sleep(.05)

mousePos(Cord.f_roe)

leftClick()

time.sleep(.1)

foldMat()

time.sleep(1.5)

elif food == 'onigiri':

print 'Making a onigiri'

mousePos(Cord.f_rice)

leftClick()

time.sleep(.05)

mousePos(Cord.f_rice)

leftClick()

time.sleep(.05)

mousePos(Cord.f_nori)

leftClick()

time.sleep(.1)

foldMat()

time.sleep(.05)

time.sleep(1.5)

elif food == 'gunkan':

mousePos(Cord.f_rice)

leftClick()

time.sleep(.05)

mousePos(Cord.f_nori)

leftClick()

time.sleep(.05)

mousePos(Cord.f_roe)

leftClick()

time.sleep(.05)

mousePos(Cord.f_roe)

leftClick()

time.sleep(.1)

foldMat()

time.sleep(1.5)

Эта функция такая же как и все остальные, но с одним небольшим отличием: мы не передаем координаты непосредственно, а вызываем их в качестве атрибутов класса Cord.

Функция foldMat() вызывается в конце каждого приготовления. Она кликает по циновке, чтобы завернуть суши, которое мы приготовили. Давайте зададим её:

def foldMat():

mousePos((Cord.f_rice[0]+40,Cord.f_rice[1]))

leftClick()

time.sleep(.1)

Давайте кратко пройдемся по функции mousePos(). Мы обращаемся к первому значению f_rice через добавление [0] в конце атрибута. Напомню, что это координата x. Для клика по циновке нам необходимо добавить небольшое смещение по оси х, и мы прибавим 40 к значению координаты x и передадим f_price[1] в y. Это сдвинет нашу позицию по x достаточно, чтобы активировать циновку.

Обратите внимание, что после вызова foldMat() у нас идет длинный time.sleep(). Циновка будет закручиваться и ингредиенты будут не доступны для клика, поэтому придется подождать конца анимации.

Шаг 17: Навигация в телефонном меню

В этом шаге мы зададим все точки mousePos() для подходящий пунктов меню, координаты которых были оставлены для этого момента. Эта часть программы которая будет обернута и контролируема логикой бота. Мы вернемся к этой функции, после того как обзаведемся несколькими новыми техниками.

def buyFood(food):

mousePos(Cord.phone)

mousePos(Cord.menu_toppings)

mousePos(Cord.t_shrimp)

mousePos(Cord.t_nori)

mousePos(Cord.t_roe)

mousePos(Cord.t_salmon)

mousePos(Cord.t_unagi)

mousePos(Cord.t_exit)

mousePos(Cord.menu_rice)

mousePos(Cord.buy_rice)

mousePos(Cord.delivery_norm)

Краткое введение в компьютерное зрение

Сейчас в нашем распоряжении имеются очень интересные куски кода. Давайте рассмотрим как научить компьютер «видеть» события. Это очень увлекательная часть процесса.

Еще одна сторона построения бота заключается в том, что в конечном итоге бот может предоставить нам достаточное количество информации, что дальнейшем облегчит работу. Например, в случае суши-бота, как только мы пройдем первый уровень, бот будет предоставлять нам достаточное количество данных о том, что происходит на экране, и все что нам останется сделать это объяснить ему как реагировать на эти новые данные.

Другая большая часть в написании бота это обучение игре. Понимание какие значения нужно отслеживать в игре, а какие можно игнорировать. Например, можно не отслеживать деньги в кассе. Это то, что в конечном счете не имеет отношения к боту. Все, что ему надо знать это достаточно ли еды, чтобы продолжать работать. Таким образом, вместо того, чтобы мониторить количество денег, он просто проверяет, может ли бот что-то купить независимо от цены, потому что в игре это вопрос лишь нескольких секунд. Поэтому если бот не может что-то купить, он просто ждет несколько секунд.

Это подводит нас к финальной точке. Это брутфорс против элегантного решения. Алгоритмы зрения требуют значительного процессорного времени. Проверка нескольких точек во многих разных областях игровой области могут сильно снижать производительность. Таким образом все сводится к вопросу «должен бот узнать о том что что-то случилось или нет?»

Например, посетитель может проходить через четыре состояния: отсутствует, ожидает, ест и закончил есть. Когда закончил есть, он оставляет пустую тарелку. Мы могли бы затратить ресурсы на проверку всех мест просмотрев их, а затем кликнуть напротив ожидаемой тарелки (что может приводить к ошибкам, так как тарелки мигают, давая ложный сигнал). Или можно убирать их простым перебором, прокликивая все места через каждые несколько секунд. На практике прокликивание оказывается таким же эффективным, как и элегантное решение, позволяющее определить состояние клиента. Прокликать шесть мест занимает доли секунды, в то время как захват и обработка шести изображений сравнительно медленный способ. Мы можем использовать сэкономленное время для других более важных задач, связанных с обработкой изображений.

Шаг 18: Импорт библиотек Numpy и ImageOps

Добавим следующие выражения импорта

import ImageOps

from numpy import *

ImageOps это еще одна библиотека для работы с изображениями Python’а. Она используется для выполнения операций над изображениями (таких как перевод в черно-белый формат).

Я кратко поясню вторую строку для тех, кто близко не знаком с Питоном. Стандартное выражение импорта загружает пространство имен модуля (коллекцию имен переменных и функций). Таким образом, для доступа к элементам из области видимости мы используем синтаксис module.attribute. Однако, используя выражение from _ import мы наследуем имена в локальную область видимости. То есть синтаксис module.attribute больше не нужен. Это не верхний уровень, поэтому мы можем использовать их как встроенные функции Питона, как str() или list(). Импорт Numpy таким способом дает нам возможность просто вызвать array() вместо numpy.array().

Символ * означает импорт всего из модуля.

Шаг 19: Создаем компьютерное зрение

Первый метод сравнивает значения RGB у пикселей с ожидаемым значением. Этот метод отлично подходит для статичных объектов, таких как меню. Так как нужно иметь дело с конкретными пикселями, то метод не слишком надежен для движущихся объектов. Однако, это варьируется от случая к случаю. Иногда это отличная техника, а в другой раз приходится искать другой метод.

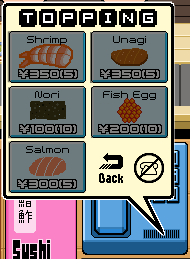

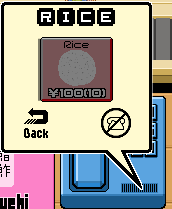

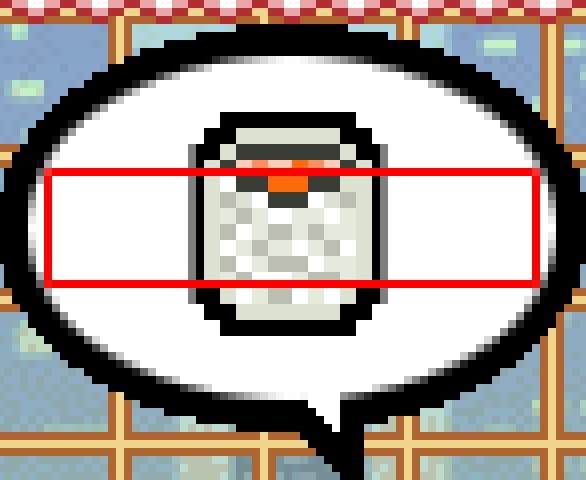

Запустите Sushi Go Round в браузере и начните новую игру. Откройте телефонное меню. Можете пока не обращать внимание на посетителей. Вы начинаете игру без денег, поэтому все пункты меню будут серыми как показано ниже. Это и будут те значения RGB, которые мы будем проверять.

В code.py перейдите к функции screenGrub(). Нужно внести следующие изменения:

def screenGrab():

b1 = (x_pad + 1,y_pad+1,x_pad+640,y_pad+480)

im = ImageGrab.grab(b1)

##im.save(os.getcwd() + '\Snap__' + str(int(time.time())) +'.png', 'PNG')

return im

Мы сделали два небольших изменения. Во—первых, мы закомментировали строку, которая сохраняет скриншот. Во—вторых, на шестой строке мы возвращаем объект с изображением после выполнения функции.

Сохраните и запустите код.

Во время того как открыто телефонное меню и все пункты серые, выполните следующий код:

>>>im = screenGrab()

>>>

Это сохранит скриншот, который мы сделали с помощью функции screenGrub() в переменную im. Теперь мы можем вызвать функцию getpixel(xy) чтобы получить данные о заданных пикселях.

Теперь нам надо получить RGB значения для каждого серого элемента меню. Они нужны для сравнения со значениями, которые бот будет сравнивать с теми, которые он будет получать вызывая getpixel().

Мы же имеем необходимые координаты после выполнения предыдущих шагов, поэтому просто передадим их в качестве аргументов в функцию getpixel() и запишем результаты.

>>> im = screenGrab()

>>> im.getpixel(Cord.t_nori)

(109, 123, 127)

>>> im.getpixel(Cord.t_roe)

(127, 61, 0)

>>> im.getpixel(Cord.t_salmon)

(127, 71, 47)

>>> im.getpixel(Cord.t_shrimp)

(127, 102, 90)

>>> im.getpixel(Cord.t_unagi)

(94, 49, 8)

>>> im = screenGrab()

>>> im.getpixel(Cord.buy_rice)

(127, 127, 127)

>>>

Если мы добавим эти значения в функцию buyFood(), чтобы знать доступна покупка в данный момент или нет.

def buyFood(food):

if food == 'rice':

mousePos(Cord.phone)

time.sleep(.1)

leftClick()

mousePos(Cord.menu_rice)

time.sleep(.05)

leftClick()

s = screenGrab()

if s.getpixel(Cord.buy_rice) != (109, 123, 127):

print 'rice is available'

mousePos(Cord.buy_rice)

time.sleep(.1)

leftClick()

mousePos(Cord.delivery_norm)

time.sleep(.1)

leftClick()

time.sleep(2.5)

else:

print 'rice is NOT available'

mousePos(Cord.t_exit)

leftClick()

time.sleep(1)

buyFood(food)

if food == 'nori':

mousePos(Cord.phone)

time.sleep(.1)

leftClick()

mousePos(Cord.menu_toppings)

time.sleep(.05)

leftClick()

s = screenGrab()

print 'test'

time.sleep(.1)

if s.getpixel(Cord.t_nori) != (109, 123, 127):

print 'nori is available'

mousePos(Cord.t_nori)

time.sleep(.1)

leftClick()

mousePos(Cord.delivery_norm)

time.sleep(.1)

leftClick()

time.sleep(2.5)

else:

print 'nori is NOT available'

mousePos(Cord.t_exit)

leftClick()

time.sleep(1)

buyFood(food)

if food == 'roe':

mousePos(Cord.phone)

time.sleep(.1)

leftClick()

mousePos(Cord.menu_toppings)

time.sleep(.05)

leftClick()

s = screenGrab()

time.sleep(.1)

if s.getpixel(Cord.t_roe) != (127, 61, 0):

print 'roe is available'

mousePos(Cord.t_roe)

time.sleep(.1)

leftClick()

mousePos(Cord.delivery_norm)

time.sleep(.1)

leftClick()

time.sleep(2.5)

else:

print 'roe is NOT available'

mousePos(Cord.t_exit)

leftClick()

time.sleep(1)

buyFood(food)

Мы передаем имя ингредиента в функцию buyFood(). Серия выражений if/else получает переданный параметр и дает соответствующий ответ. Каждая ветка следует одинаковой логике, поэтому мы рассмотрим только одну.

if food == 'rice':

mousePos(Cord.phone)

time.sleep(.1)

leftClick()

mousePos(Cord.menu_rice)

time.sleep(.05)

leftClick()

s = screenGrab()

time.sleep(.1)

Первое, что мы должны сделать это кликнуть на телефон и открыть нужное меню. В этом случае меню с рисом.

s = screenGrab()

if s.getpixel(Cord.buy_rice) != (109, 123, 127):

Далее мы делаем скриншот области и вызываем getpixel(), чтобы получить RGB-значение пикселя у координат Cord.buy_rice. Мы сравниваем их с RGB-значением пикселя, полученного до этого на неактивном элементе. Если мы получаем в результате сравнения значение True, значит кнопка больше не серая и у нас достаточно денег для покупки. Соответственно, если получаем False, значит не можем себе это позволить.

print 'rice is available'

mousePos(Cord.buy_rice)

time.sleep(.1)

leftClick()

mousePos(Cord.delivery_norm)

time.sleep(.1)

leftClick()

time.sleep(2.5)

Если у нас достаточно денег, мы просто проходим через оставшиеся этапы, необходимые для покупки.

else:

print 'rice is NOT available'

mousePos(Cord.t_exit)

leftClick()

time.sleep(1)

buyFood(food)

Наконец, если нам не хватает денег, то мы говорим боту закрыть меню, подождать секунду и повторить все сначала. Обычно это вопрос секунд, когда нам снова становится доступна покупка. Довольно просто добавить дополнительную логику, чтобы бот мог решить, нужно ли продолжать ждать или заняться в это время чем-то полезным и вернуться позже.

Шаг 20: Следим за ингредиентами

Окей, до этого момента мы медленно продвигались шаг за шагом. Перепишем часть нашего кода, точнее внешний объект, обеспечивающий входящие данные и принятие решений посредством логики, которая может запускаться сама.

Мы должны придумать способ хранить информацию как много ингредиентов у нас сейчас на руках. Мы будем запрашивать экран в определенной области, или усредняя каждую ячейку ингредиента (к этой технике мы вернемся позже), но в дальнейшем, простой и наиболее быстрый способ просто хранить все элементы в словаре.

Количество каждого ингредиента остается постоянным на старте каждого уровня. Всегда начинаем с 10 обычных ингредиентов (рис, нори, икра), и по 5 дефицитных ингредиентов (креветки, лосось, угорь).

Давайте добавим информацию о них в массив.

foodOnHand = {'shrimp':5,

'rice':10,

'nori':10,

'roe':10,

'salmon':5,

'unagi':5}

Ключи массива содержат имена ингредиентов, по ним мы получаем доступ к значениям.

Шаг 21: Добавим отслеживание продуктов в код

Каждый раз, когда мы готовим, мы расходуем ингредиенты. И также пополняем их, когда делаем покупки. Давайте немного расширим нашу функцию makeFood()

def makeFood(food):

if food == 'caliroll':

print 'Making a caliroll'

foodOnHand['rice'] -= 1

foodOnHand['nori'] -= 1

foodOnHand['roe'] -= 1

mousePos(Cord.f_rice)

leftClick()

time.sleep(.05)

mousePos(Cord.f_nori)

leftClick()

time.sleep(.05)

mousePos(Cord.f_roe)

leftClick()

time.sleep(.1)

foldMat()

time.sleep(1.5)

elif food == 'onigiri':

print 'Making a onigiri'

foodOnHand['rice'] -= 2

foodOnHand['nori'] -= 1

mousePos(Cord.f_rice)

leftClick()

time.sleep(.05)

mousePos(Cord.f_rice)

leftClick()

time.sleep(.05)

mousePos(Cord.f_nori)

leftClick()

time.sleep(.1)

foldMat()

time.sleep(.05)

time.sleep(1.5)

elif food == 'gunkan':

print 'Making a gunkan'

foodOnHand['rice'] -= 1

foodOnHand['nori'] -= 1

foodOnHand['roe'] -= 2

mousePos(Cord.f_rice)

leftClick()

time.sleep(.05)

mousePos(Cord.f_nori)

leftClick()

time.sleep(.05)

mousePos(Cord.f_roe)

leftClick()

time.sleep(.05)

mousePos(Cord.f_roe)

leftClick()

time.sleep(.1)

foldMat()

time.sleep(1.5)

Теперь каждый раз при приготовлении Суши, мы уменьшаем значения наших ингредиентов на соответствующие значения. Теперь дополним код в функции buyFood()

def buyFood(food):

if food == 'rice':

mousePos(Cord.phone)

time.sleep(.1)

leftClick()

mousePos(Cord.menu_rice)

time.sleep(.05)

leftClick()

s = screenGrab()

print 'test'

time.sleep(.1)

if s.getpixel(Cord.buy_rice) != (127, 127, 127):

print 'rice is available'

mousePos(Cord.buy_rice)

time.sleep(.1)

leftClick()

mousePos(Cord.delivery_norm)

foodOnHand['rice'] += 10

time.sleep(.1)

leftClick()

time.sleep(2.5)

else:

print 'rice is NOT available'

mousePos(Cord.t_exit)

leftClick()

time.sleep(1)

buyFood(food)

if food == 'nori':

mousePos(Cord.phone)

time.sleep(.1)

leftClick()

mousePos(Cord.menu_toppings)

time.sleep(.05)

leftClick()

s = screenGrab()

print 'test'

time.sleep(.1)

if s.getpixel(Cord.t_nori) != (33, 30, 11):

print 'nori is available'

mousePos(Cord.t_nori)

time.sleep(.1)

leftClick()

mousePos(Cord.delivery_norm)

foodOnHand['nori'] += 10

time.sleep(.1)

leftClick()

time.sleep(2.5)

else:

print 'nori is NOT available'

mousePos(Cord.t_exit)

leftClick()

time.sleep(1)

buyFood(food)

if food == 'roe':

mousePos(Cord.phone)

time.sleep(.1)

leftClick()

mousePos(Cord.menu_toppings)

time.sleep(.05)

leftClick()

s = screenGrab()

time.sleep(.1)

if s.getpixel(Cord.t_roe) != (127, 61, 0):

print 'roe is available'

mousePos(Cord.t_roe)

time.sleep(.1)

leftClick()

mousePos(Cord.delivery_norm)

foodOnHand['roe'] += 10

time.sleep(.1)

leftClick()

time.sleep(2.5)

else:

print 'roe is NOT available'

mousePos(Cord.t_exit)

leftClick()

time.sleep(1)

buyFood(food)

Шаг 22: Проверка запасов еды

Теперь когда функции makeFood() и buyFood() могут менять количество ингредиентов, нам нужно создать функцию, которая будет отслеживать что количество какого-то ингредиента стало ниже критического уровня.

def checkFood():

for i, j in foodOnHand.items():

if i == 'nori' or i == 'rice' or i == 'roe':

if j <= 3:

print '%s is low and needs to be replenished' % i

buyFood(i)

Мы будем циклом обходить пары ключ:значение в массиве с запасами ингредиентов. Если нори, риса или икры останется меньше 4, вызывается функция buyFood(), параметром в которую передается имя ингредиента.

Шаг 23: Перевод RGB значений — Установка

Для того, чтобы двигаться дальше, мы должны получать информацию о том, какой тип суши запрашивает клиент. Сделать это с помощью функции getpixel() было бы достаточно тяжело, так как нам пришлось бы искать область с уникальным значением RGB для каждого вида суши для каждого посетителя. Кроме того, для каждого нового типа суши, вам придется вручную осмотреть его, чтобы увидеть, есть ли у него уникальный RGB, который не найден ни в одном из других типов суши. Это значит, что нам пришлось бы хранить 6 мест, по 8 типов суши. Это 48 уникальных координат.

Очевидно, нам нужен метод попроще.

Метод номер два: усреднение изображения. Этот способ работает с набором RGB-значений, вместо конкретного пикселя. Для каждого скриншота, переведенного в оттенки серого, и загруженного в массив, мы просуммируем все пиксели. Эта сумма обрабатывается также как значение RGB в методе getpixel().

Гибкость этого метода в том, что, когда он настроен, от нас больше ничего не требуется. По мере ввода новых суши, их значения RGB суммируются и выводятся для нашего использования. Нет необходимости искать конкретные координаты с помощью getpixel().

Тем не менее, для этого метода требуется настройка. Нам нужно получать скрин только той области, в которой отображается желаемое суши конкретного клиента, а не всего игрового окна.

Найдите уже написанную функцию screenGrab() и скопируйте ее рядом. Переименуйте копию в grab(), и внесите следующие изменения:

def grab():

box = (x_pad + 1,y_pad+1,x_pad+641,y_pad+481)

im = ImageOps.grayscale(ImageGrab.grab(box))

a = array(im.getcolors())

a = a.sum()

print a

return a

На второй строке мы переводим скриншот в оттенки серого и записываем в переменную im. Такой скриншот позволяет работать с ним намного быстрее, так как вместо 3 значений Красного, Зеленого и Голубого, каждый пиксель имеет только одно значение от 0 до 255.

На третьей строчке мы создаем массив значений цветов использую PIL метод getcolors() и записываем в переменную im.

На четвертой строке мы суммируем все точки и выводим их в консоль. Это число по которому мы будем сравнивать изображения.

Шаг 24: Зададим области для скринов заказов

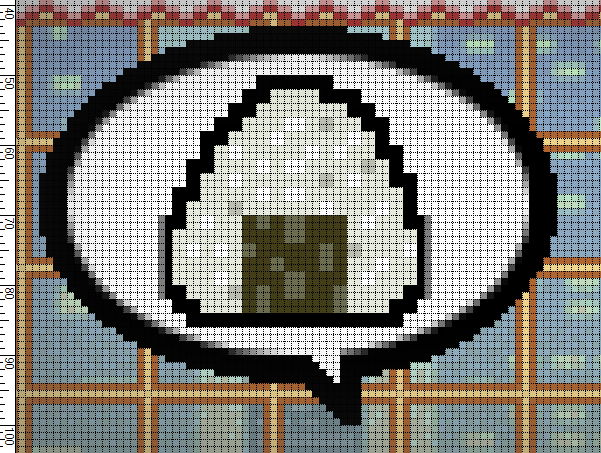

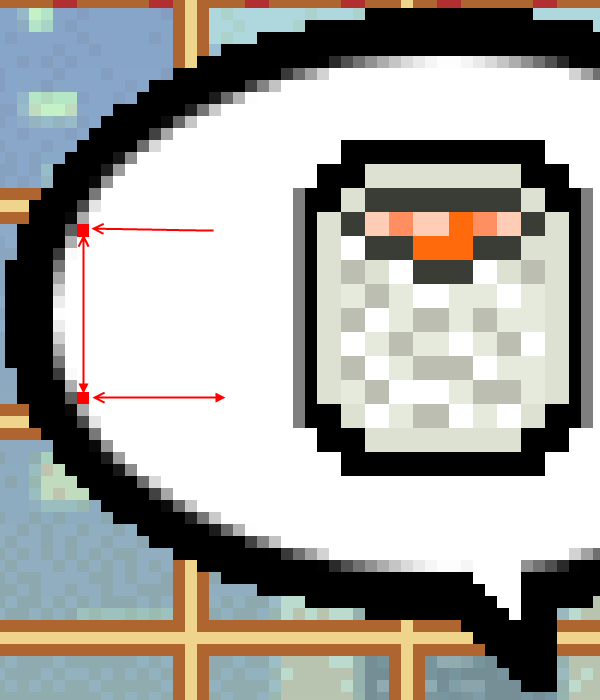

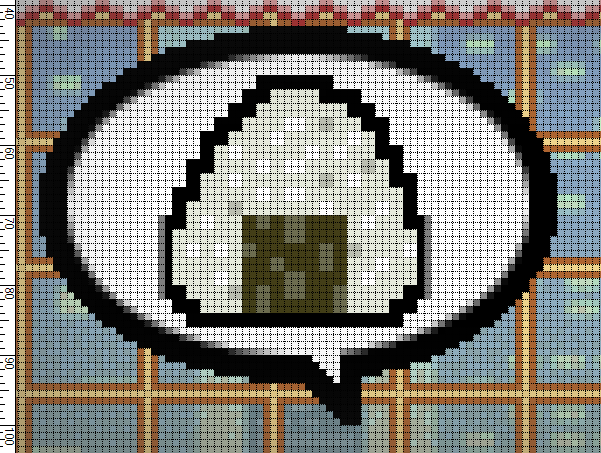

Начните новую игру и дождитесь когда все посетители рассядутся по своим местам. Сделайте скрин двойным кликом по quickGrab.py.

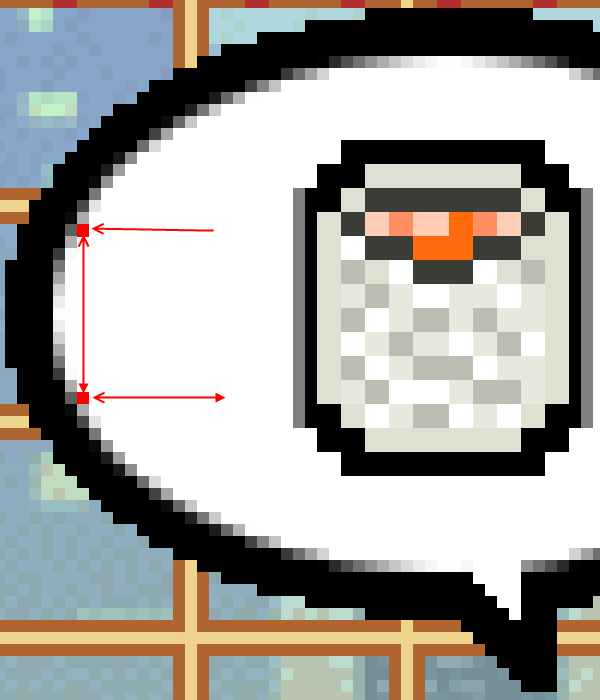

Нам нужно задать ограничивающие области внутри каждого из этих спич-баблов (белые облака с рисунком суши). Приблизьте из в редакторе так, чтобы было видно пиксели:

Для каждого спич-бабла мы должны быть уверены что верхний левый край начинается в одном и том же месте. Для этого отступим два пикселя от внутреннего края спич-бабла. Первый белый пиксель на второй ступеньке будет началом отсчета.

Для создания пары координат, отсчитайте 63 по оси x и 16 по оси y. Это даст подобный прямоугольник:

Не беспокойтесь о том, что не весь рисунок с суши попал в прямоугольник. Когда мы просуммируем все пиксели, даже небольшие изменения в одном пикселе повлияют на сумму, и мы сможем отличить заказ посетителя.

Приступим к созданию 6 новых функций, каждая будет уточнением функции grab() и будет передавать аргументом координаты спич-баблов. Как только закончим, создадим функцию, запускающую их все сразу для тестирования.

def get_seat_one():

box = (45,427,45+63,427+16)

im = ImageOps.grayscale(ImageGrab.grab(box))

a = array(im.getcolors())

a = a.sum()

print a

im.save(os.getcwd() + '\seat_one__' + str(int(time.time())) + '.png', 'PNG')

return a

def get_seat_two():

box = (146,427,146+63,427+16)

im = ImageOps.grayscale(ImageGrab.grab(box))

a = array(im.getcolors())

a = a.sum()

print a

im.save(os.getcwd() + '\seat_two__' + str(int(time.time())) + '.png', 'PNG')

return a

def get_seat_three():

box = (247,427,247+63,427+16)

im = ImageOps.grayscale(ImageGrab.grab(box))

a = array(im.getcolors())

a = a.sum()

print a

im.save(os.getcwd() + '\seat_three__' + str(int(time.time())) + '.png', 'PNG')

return a

def get_seat_four():

box = (348,427,348+63,427+16)

im = ImageOps.grayscale(ImageGrab.grab(box))

a = array(im.getcolors())

a = a.sum()

print a

im.save(os.getcwd() + '\seat_four__' + str(int(time.time())) + '.png', 'PNG')

return a

def get_seat_five():

box = (449,427,449+63,427+16)

im = ImageOps.grayscale(ImageGrab.grab(box))

a = array(im.getcolors())

a = a.sum()

print a

im.save(os.getcwd() + '\seat_five__' + str(int(time.time())) + '.png', 'PNG')

return a

def get_seat_six():

box = (550,427,550+63,427+16)

im = ImageOps.grayscale(ImageGrab.grab(box))

a = array(im.getcolors())

a = a.sum()

print a

im.save(os.getcwd() + '\seat_six__' + str(int(time.time())) + '.png', 'PNG')

return a

def get_all_seats():

get_seat_one()

get_seat_two()

get_seat_three()

get_seat_four()

get_seat_five()

get_seat_six()

Отлично! Много кода, но это только вариации функции ImageGrab.Grab. Теперь нужно перейти в игру и протестировать. Нужно убедиться, что не зависимо от того в каком спич-бабле находится суши, один и тот же заказ отображает одну и ту же сумму.

Шаг 25: Создаем массив с типами Суши

Как только Вы убедились, что каждый тип суши дает одинаковое значение суммы пикселей, запишите эти суммы в массив:

sushiTypes = {1893:'onigiri',

2537:'caliroll',

1900:'gunkan',}

Здесь значение стоит на месте ключа потому, что по нему будет осуществляться поиск.

Шаг 26: Создаем массив мест без спич-баблов

Для работы нам нужны значения сумм скриншотов мест под спич-баблами, чтобы понимать что посетитель отсутствует в данном месте.

Нужно начать игру и выполнить функцию get_all_seats() до того как придет первый посетитель. Полученные значения запишем в массив Blank.

class Blank:

seat_1 = 8041

seat_2 = 5908

seat_3 = 10984

seat_4 = 10304

seat_5 = 6519

seat_6 = 8963

Шаг 27: Соединяем все вместе

Время окончательно передать контроль нашему боту. Напишем скрипт, который позволит ему реагировать на клиентов, готовить еду и пополнять запасы.

Основа логики будет следующая: Проверка мест > Проверка заказов > Если не хватает ингредиентов, то купить > почистить столы > Повторить сначала

def check_bubs():

checkFood()

s1 = get_seat_one()

if s1 != Blank.seat_1:

if sushiTypes.has_key(s1):

print 'table 1 is occupied and needs %s' % sushiTypes[s1]

makeFood(sushiTypes[s1])

else:

print 'sushi not found!n sushiType = %i' % s1

else:

print 'Table 1 unoccupied'

clear_tables()

checkFood()

s2 = get_seat_two()

if s2 != Blank.seat_2:

if sushiTypes.has_key(s2):

print 'table 2 is occupied and needs %s' % sushiTypes[s2]

makeFood(sushiTypes[s2])

else:

print 'sushi not found!n sushiType = %i' % s2

else:

print 'Table 2 unoccupied'

checkFood()

s3 = get_seat_three()

if s3 != Blank.seat_3:

if sushiTypes.has_key(s3):

print 'table 3 is occupied and needs %s' % sushiTypes[s3]

makeFood(sushiTypes[s3])

else:

print 'sushi not found!n sushiType = %i' % s3

else:

print 'Table 3 unoccupied'

checkFood()

s4 = get_seat_four()

if s4 != Blank.seat_4:

if sushiTypes.has_key(s4):

print 'table 4 is occupied and needs %s' % sushiTypes[s4]

makeFood(sushiTypes[s4])

else:

print 'sushi not found!n sushiType = %i' % s4

else:

print 'Table 4 unoccupied'

clear_tables()

checkFood()

s5 = get_seat_five()

if s5 != Blank.seat_5:

if sushiTypes.has_key(s5):

print 'table 5 is occupied and needs %s' % sushiTypes[s5]

makeFood(sushiTypes[s5])

else:

print 'sushi not found!n sushiType = %i' % s5

else:

print 'Table 5 unoccupied'

checkFood()

s6 = get_seat_six()

if s6 != Blank.seat_6:

if sushiTypes.has_key(s6):

print 'table 1 is occupied and needs %s' % sushiTypes[s6]

makeFood(sushiTypes[s6])

else:

print 'sushi not found!n sushiType = %i' % s6

else:

print 'Table 6 unoccupied'

clear_tables()

Первое что мы делаем — это проверяем запасы. Далее делаем скрин позиции заказа первого посетителя и записываем в s1. После этого проверяем скрин на неравенство пустому месту. Если они не равны, значит у нас есть посетитель. Далее проверяем массив sushiTypes чтобы определить какой заказ сделал посетитель и передаем этот аргумент в функцию makeFood().

Clear_tables() выполняется через проверку каждых двух мест.

Теперь надо это зациклить.

Шаг 28: Главный цикл

Мы создаем цикл. Так как мы не задаем никакого условия выхода из цикла, то чтобы завершить игру, нужно в консоли нажать CTRL + C.

def main():

startGame()

while True:

check_bubs()

Вот и все! Обновите страницу, дождитесь загрузки игры и запустите бота!

Бот немного неуклюжий и нуждается в доработках. Но это отличный скелет для того чтобы продолжить экспериментировать!

В этом уроке мы рассмотрим все тонкости создания игрового бота на основе Computer Vision на Python, который сможет играть в популярную флеш-игру Sushi Go Round . Вы можете использовать методы, описанные в этом руководстве, для создания ботов для автоматического тестирования ваших собственных веб-игр.

Окончательный результат предварительного просмотра

Давайте посмотрим на конечный результат, к которому мы будем стремиться:

Предпосылки

Для этого руководства и всего кода в нем требуется установить несколько дополнительных библиотек Python. Они обеспечивают хорошую оболочку Python для связки низкоуровневого кода C, что значительно облегчает процесс и скорость написания сценариев для ботов.

Некоторые из кода и библиотек являются специфичными для Windows. Могут быть эквиваленты Mac или Linux, но мы не будем рассматривать их в этом руководстве.

Вам необходимо скачать и установить следующие библиотеки:

- Библиотека изображений Python

- Numpy

- PyWin

У всего вышеперечисленного есть самостоятельные установщики; Запустив их, вы автоматически установите модули в каталог libsite-packages и, теоретически, настроите ваш pythonPath соответствующим образом. Однако на практике это не всегда происходит. Если вы начнете получать какие-либо сообщения об Import Error после установки, вам, вероятно, потребуется вручную настроить переменные среды. Более подробную информацию о настройке переменных пути можно найти здесь .

Последний инструмент, который нам понадобится, – достойная программа рисования. Я предлагаю Paint.NET как отличный бесплатный вариант, но можно использовать любую программу с линейками, которые отображают свои измерения в пикселях.

Мы будем использовать несколько игр в качестве примеров по пути.

Кстати, если вы хотите воспользоваться ярлыком, вы можете найти множество браузерных игровых шаблонов для работы на Envato Market.

Вступление

Это руководство написано, чтобы дать базовое введение в процесс создания ботов, которые играют в браузерные игры. Подход, который мы собираемся предпринять, вероятно, немного отличается от того, что большинство ожидает, когда они думают о боте. Вместо того, чтобы создавать программу, которая находится между клиентом и сервером, внедряющим код (например, бот Quake или C / S), наш бот будет сидеть «снаружи». Мы будем полагаться на методы Computer Vision-esque и вызовы API Windows для сбора необходимой информации и создания движений.

При таком подходе мы теряем немного утонченных деталей и контроля, но компенсируем это сокращением времени разработки и простотой использования. Автоматизация определенной игровой функции может быть выполнена в несколько коротких строк кода, а полноценный, от начала до конца бот (для простой игры) может быть запущен за несколько часов.

Радости такого быстрого подхода таковы, что как только вы ознакомитесь с тем, что компьютер может легко «увидеть», вы начнете просматривать игры немного по-другому. Хороший пример можно найти в играх-головоломках. Обычная конструкция включает в себя использование ограничений скорости человека, чтобы заставить вас принять решение, которое не является оптимальным. Забавно (и довольно легко) «сломать» эти игры, используя сценарии в движениях, которые никогда не сможет выполнить человек.

Эти боты также очень полезны для тестирования простых игр – в отличие от человека, бот не будет скучать, играя один и тот же сценарий снова и снова.

Исходный код для всех примеров учебника, а также для одного из завершенных примеров ботов, можно найти здесь.

Веселиться!

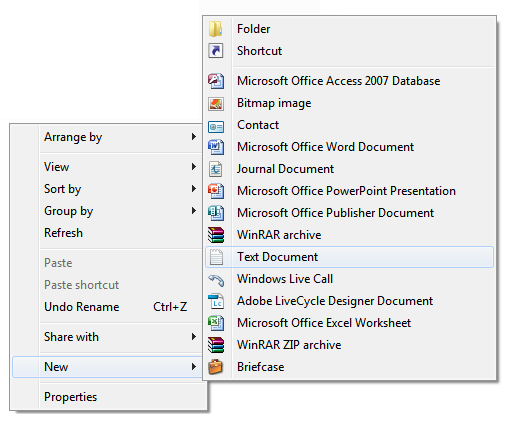

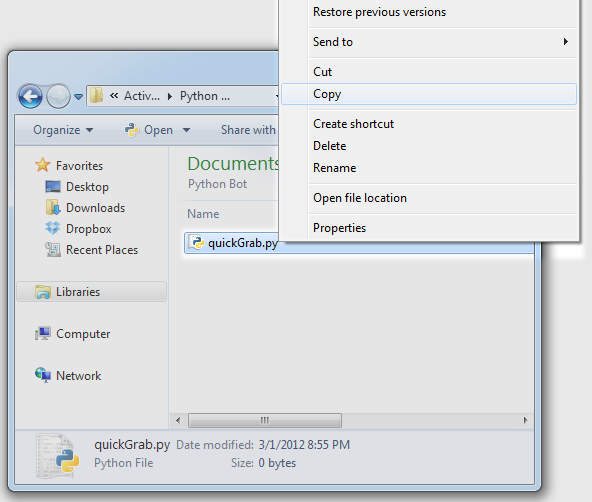

Шаг 1: Создайте новый проект Python

В новой папке щелкните правой кнопкой мыши и выберите « New > Text Document .

После этого переименуйте файл из «New Text Document» в «quickGrab.py» (без кавычек) и подтвердите, что вы хотите изменить расширение имени файла.

Наконец, щелкните правой кнопкой мыши на нашем вновь созданном файле и выберите «Редактировать с IDLE» в контекстном меню, чтобы запустить редактор

Шаг 2: Настройка первого захвата экрана

Мы начнем работу над нашим ботом с изучения основной функции захвата экрана. После запуска мы пройдем его построчно, так как эта функция (и множество ее итераций) будет служить основой нашего кода.

В quickgrab.py введите следующий код:

|

01 02 03 04 05 06 07 08 09 10 11 12 13 14 15 |

import ImageGrab import os import time def screenGrab(): box = () im = ImageGrab.grab() im.save(os.getcwd() + ‘\full_snap__’ + str(int(time.time())) + ‘.png’, ‘PNG’) def main(): screenGrab() if __name__ == ‘__main__’: main() |

Запуск этой программы должен дать вам полный снимок области экрана:

Текущий код захватывает всю ширину и высоту области экрана и сохраняет ее как PNG в вашем текущем рабочем каталоге.

Теперь давайте пройдемся по коду, чтобы увидеть, как именно он работает.

Первые три строки:

|

1 2 3 |

import ImageGrab import os import time |

… метко названы «операторы импорта». Они говорят Python загружать перечисленные модули во время выполнения. Это дает нам доступ к их методам через синтаксис module.attribute .

Первый модуль является частью библиотеки изображений Python, которую мы установили ранее. Как следует из его названия, он дает нам базовую функциональность для захвата экрана, на которую будет опираться наш бот.

Вторая строка импортирует модуль ОС (операционной системы). Это дает нам возможность легко перемещаться по каталогам нашей операционной системы. Это пригодится, когда мы начнем организовывать ресурсы в разные папки.

Этот финальный импорт является встроенным модулем времени. Хорошо использовать это главным образом для отметки текущего времени на снимках, но это может быть очень полезно в качестве таймера для ботов, которым нужны события, запускаемые в течение заданного количества секунд.

Следующие четыре строки составляют screenGrab() нашей функции screenGrab() .

|

1 2 3 4 5 |

def screenGrab(): box = () im = ImageGrab.grab() im.save(os.getcwd() + ‘\full_snap__’ + str(int(time.time())) + ‘.png’, ‘PNG’) |

Первая строка def screenGrab() определяет имя нашей функции. Пустые скобки означают, что они не ожидают аргументов.

Строка 2, box=() назначает пустой кортеж переменной с именем «box». Мы заполним это аргументами на следующем шаге.

В строке 3 im = ImageGrab.grab() создает полный снимок экрана и возвращает RGB-изображение экземпляру im

Строка 4 может быть немного хитрой, если вы не знакомы с тем, как работает модуль Time . Первая часть im.save( вызывает метод «save» из класса Image. Он ожидает два аргумента. Первый – это место, в котором нужно сохранить файл, а второй – формат файла.

Здесь мы устанавливаем местоположение, сначала вызывая os.getcwd() . Это получает текущий каталог, из которого выполняется код, и возвращает его в виде строки. Затем мы добавим + . Это будет использоваться между каждым новым аргументом для объединения всех строк вместе.

Следующая часть '\full_snap__ дает нашему файлу простое описательное имя. (Поскольку в Python обратная косая черта является escape-символом, мы должны добавить два из них, чтобы не пропустить одну из наших букв).

Далее идет волосатый бит: str(int(time.time())) . Это использует преимущества встроенных в Python методов Type. Мы объясним эту часть, работая изнутри:

time.time() возвращает количество секунд с начала эпохи, которое задается как тип Float. Поскольку мы создаем имя файла, у нас не может быть десятичного числа, поэтому мы сначала преобразуем его в целое число, заключив его в int() . Это приближает нас, но Python не может объединить тип Int с типом String , поэтому последний шаг заключается в том, чтобы обернуть все в функцию str() чтобы дать нам удобную временную метку для имени файла. Отсюда остается только добавить расширение как часть строки: + '.png' и передать второй аргумент, который снова является типом расширения: "PNG" .

Последняя часть нашего кода определяет функцию main() и говорит ей вызывать screenGrab() всякий раз, когда она выполняется.

И здесь, в конце, соглашение Python, которое проверяет, является ли скрипт верхнего уровня, и если да, позволяет ему работать. В переводе это просто означает, что он выполняет main() если он запускается сам по себе. В противном случае – если, например, он загружен как модуль другим скриптом Python – он предоставляет только свои методы вместо выполнения своего кода.

|

1 2 3 4 5 |

def main(): screenGrab() if __name__ == ‘__main__’: main() |

Шаг 3: Ограничительная рамка

Функция ImageGrab.grab() принимает один аргумент, который определяет ограничивающий прямоугольник. Это кортеж координат по схеме (x, y, x, y), где,

- Первая пара значений (

x,y..определяет верхний левый угол поля - Вторая пара

..x,y) определяет нижний правый.

Комбинируя их, мы можем скопировать только ту часть экрана, которая нам нужна.

Давайте применим это на практике.

Для этого примера мы будем использовать игру под названием Sushi Go Round . ( Довольно увлекательно. Вас предупредили.) Откройте игру на новой вкладке и сделайте снимок, используя наш существующий screenGrab() :

Снимок всей области экрана.

Шаг 4: Получение координат

Теперь пришло время начать добывать некоторые координаты для нашей ограничительной рамки.

Откройте свой последний снимок в редакторе изображений.

Положение (0,0) всегда находится в верхнем левом углу изображения. Мы хотим заполнить координаты x и y так, чтобы наша новая функция снимка установила (0,0) в крайнем левом углу игровой области игры.

Причины этого двоякие. Во-первых, это значительно упрощает поиск внутриигровых координат, когда нам нужно только настроить значения в зависимости от игровой зоны в зависимости от разрешения вашего экрана. Во-вторых, захват меньшей части экрана уменьшает необходимые накладные расходы на обработку. Полноэкранные захваты производят довольно мало данных, что может усложнить просмотр их несколько раз в секунду.

Если это еще не сделано, включите отображение линейки в редакторе и увеличивайте верхний угол игровой зоны, пока не увидите детали в пикселях:

Наведите курсор на первый пиксель игровой площадки и проверьте координаты, отображаемые на линейке. Это будут первые два значения нашего кортежа Box. На моей конкретной машине эти значения 157, 162 .

Перейдите к нижнему краю игровой площадки, чтобы получить нижнюю пару координат.

Это показывает координаты 796 и 641. Объединение их с нашей предыдущей парой дает коробку с координатами (157,162,796,641) .

Давайте добавим это в наш код.

|

01 02 03 04 05 06 07 08 09 10 11 12 13 14 15 |

import ImageGrab import os import time def screenGrab(): box = (157,346,796,825) im = ImageGrab.grab(box) im.save(os.getcwd() + ‘\full_snap__’ + str(int(time.time())) + ‘.png’, ‘PNG’) def main(): screenGrab() if __name__ == ‘__main__’: main() |

В строке 6 мы обновили кортеж, чтобы он содержал координаты игровой зоны.

Сохраните и запустите код. Откройте недавно сохраненное изображение, и вы должны увидеть:

Успех! Идеальный захват игровой площадки. Нам не всегда нужно заниматься интенсивной охотой за координатами. Как только мы войдем в win32api, мы рассмотрим несколько более быстрых методов для установки координат, когда нам не нужна идеальная точность пикселей.

Шаг 5. Планирование гибкости

В настоящее время мы жестко закодировали координаты относительно нашей текущей настройки, предполагая наш браузер и наше разрешение. Обычно плохая идея так жестко кодировать координаты. Если, например, мы хотим запустить код на другом компьютере – или, скажем, новое объявление на веб-сайте немного меняет положение игровой площадки – нам придется вручную и кропотливо исправлять все наши координатные вызовы.

Итак, мы собираемся создать две новые переменные: x_pad и y_pad . Они будут использоваться для хранения отношений между игровой областью и остальной частью экрана. Это позволит очень легко переносить код с места на место, поскольку каждая новая координата будет относиться к двум глобальным переменным, которые мы собираемся создать, и для корректировки изменений в области экрана все, что требуется, – это сброс этих двух переменные.

Поскольку мы уже выполнили измерения, установка пэдов для нашей нынешней системы очень проста. Мы собираемся установить пэды для хранения местоположения первого пикселя за пределами игровой зоны. Из первой пары координат x, y в нашем кортеже вычтите 1 из каждого значения. Таким образом, 157 становится 156 , а 346 становится 345 .

Давайте добавим это в наш код.

|

1 2 3 4 5 |

# Globals # —————— x_pad = 156 y_pad = 345 |

Теперь, когда они установлены, мы начнем настраивать кортеж коробки, чтобы он соответствовал этим значениям.

|

1 2 3 4 5 |

def screenGrab(): box = (x_pad+1, y_pad+1, 796, 825) im = ImageGrab.grab() im.save(os.getcwd() + ‘\full_snap__’ + str(int(time.time())) + ‘.png’, ‘PNG’) |

Для второй пары мы сначала вычтем значения площадок (156 и 345) из координат (796, 825), а затем используем эти значения в том же формате Pad + Value .

|

1 2 3 4 5 |

def screenGrab(): box = (x_pad+1, y_pad+1, x_pad+640, y_pad+479) im = ImageGrab.grab() im.save(os.getcwd() + ‘\full_snap__’ + str(int(time.time())) + ‘.png’, ‘PNG’) |

Здесь координата x становится 640 (769-156), а y становится 480 (825-345)

Поначалу это может показаться немного излишним, но выполнение этого дополнительного шага гарантирует простоту обслуживания в будущем.

Шаг 6: Создание строки документации

Прежде чем идти дальше, мы собираемся создать строку документации в верхней части нашего проекта. Поскольку большая часть нашего кода будет основана на конкретных экранных координатах и взаимосвязях с координатами, важно знать обстоятельства, при которых все выстроится правильно. Например, такие вещи, как текущее разрешение, браузер, включенные панели инструментов (поскольку они изменяют область браузера) и любые настройки, необходимые для центрирования области воспроизведения на экране, все влияют на относительное положение координат. Документирование всего этого очень помогает при поиске и устранении неисправностей при запуске кода в нескольких браузерах и компьютерах.

И последнее, о чем следует знать, – это постоянно меняющееся рекламное пространство на популярных игровых сайтах. Если все ваши звонки внезапно перестают вести себя, как ожидалось, хорошая добавка, слегка изменяющая положение на экране – хорошая ставка.

В качестве примера, у меня обычно есть следующие комментарии в верхней части моего кода Python:

|

1 2 3 4 5 6 7 8 9 |

“”” All coordinates assume a screen resolution of 1280×1024, and Chrome maximized with the Bookmarks Toolbar enabled. Down key has been hit 4 times to center play area in browser. x_pad = 156 y_pad = 345 Play area = x_pad+1, y_pad+1, 796, 825 “”” |

Удаление всей этой информации в начале вашего файла Python позволяет быстро и легко перепроверить все ваши настройки и выравнивание экрана без необходимости анализировать код, пытаясь вспомнить, где вы сохранили эту конкретную x-координату.

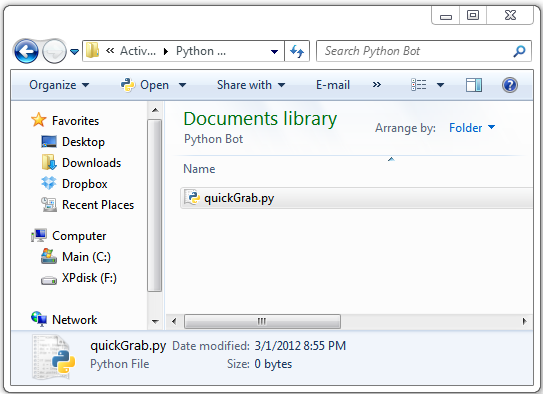

Шаг 7: Превращение quickGrab.py в полезный инструмент

На этом этапе мы собираемся раскошелиться на наш проект, создав два файла: один для хранения всего кода нашего бота, а другой для использования в качестве обычной утилиты для создания снимков экрана. Мы собираемся сделать много снимков экрана, когда будем искать координаты, поэтому наличие отдельного модуля, готового к работе, значительно ускорит процесс.

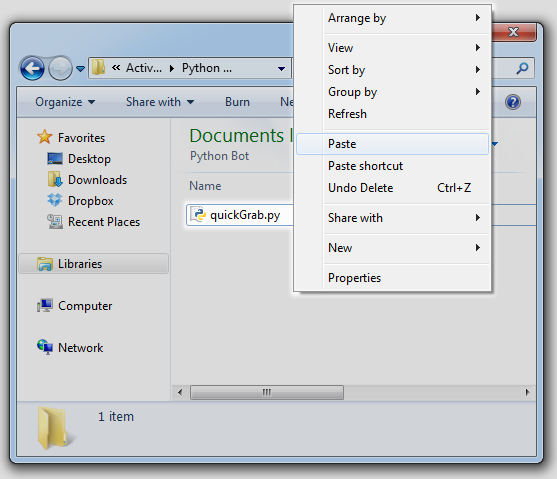

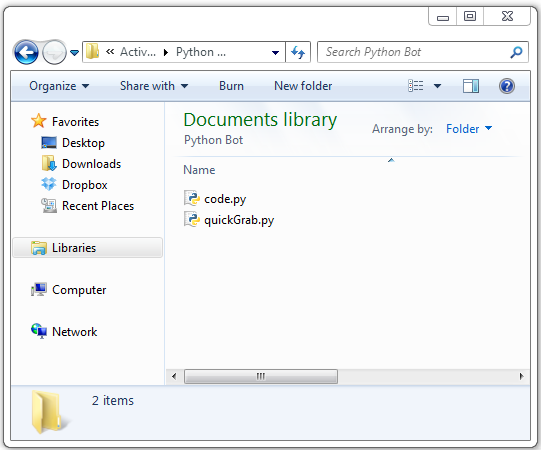

Сохраните и закройте наш текущий проект.

В вашей папке щелкните правой кнопкой мыши quickGrab.py и выберите «Копировать» из меню.

Теперь щелкните правой кнопкой мыши и выберите «вставить» из меню

Выберите скопированный файл и переименуйте его в «code.py»

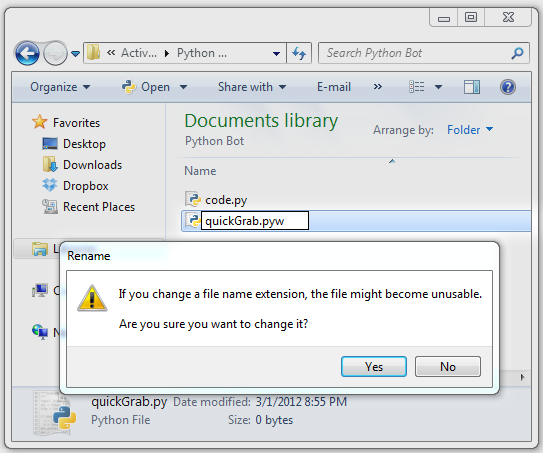

Отныне все новые дополнения и изменения кода будут вноситься в code.py. quickGrab.py теперь будет функционировать исключительно как инструмент для создания снимков. Нам просто нужно сделать одно окончательное изменение:

Измените расширение файла с .py на .pyw и подтвердите изменения.

Это расширение указывает Python запускать скрипт без запуска консоли. Таким образом, quickGrab.pyw соответствует своему названию. Дважды щелкните файл, и он тихо выполнит свой код в фоновом режиме и сохранит снимок в рабочий каталог.

Держите игру открытой на заднем плане (не забудьте заглушить ее, пока зацикленная музыка не сведет вас с ума); мы вернемся к этому в ближайшее время. У нас есть еще несколько концепций / инструментов, которые нужно представить, прежде чем мы начнем контролировать вещи на экране.

Шаг 8: Win32api – краткий обзор

Работа с win32api может показаться немного сложной. Он оборачивает низкоуровневый код Windows C – который, к счастью, очень хорошо задокументирован здесь , но немного похож на лабиринт для навигации по вашей первой паре обходов.

Прежде чем мы начнем писать полезные действия, мы рассмотрим некоторые функции API, на которые мы будем полагаться. Как только мы получим четкое представление о каждом параметре, их будет легко настроить для удовлетворения любых целей, которые нам нужны в игре.

win32api.mouse_event() :

|

1 2 3 4 5 6 |

win32api.mouse_event( dwFlags, dx, dy, dwData ) |

Первый параметр dwFlags определяет «действие» мыши. Он контролирует такие вещи, как движение, щелчок, прокрутка и т. Д.

В следующем списке показаны наиболее распространенные параметры, используемые при движении сценариев.

dwFlags :

-

win32con.MOUSEEVENTF_LEFTDOWN -

win32con.MOUSEEVENTF_LEFTUP -

win32con.MOUSEEVENTF_MIDDLEDOWN -

win32con.MOUSEEVENTF_MIDDLEUP -

win32con.MOUSEEVENTF_RIGHTDOWN -

win32con.MOUSEEVENTF_RIGHTUP -

win32con.MOUSEEVENTF_WHEEL

Каждое имя говорит само за себя. Если вы хотите отправить виртуальный щелчок правой кнопкой мыши, вы win32con.MOUSEEVENTF_RIGHTDOWN dwFlags параметру dwFlags .

Следующие два параметра, dx и dy , описывают абсолютное положение мыши вдоль осей x и y. Хотя мы могли бы использовать эти параметры для сценариев движения мыши, они используют систему координат, отличную от той, которую мы использовали. Поэтому мы оставим их равными нулю и будем полагаться на другую часть API для удовлетворения наших потребностей в перемещении мыши.

Четвертый параметр – dwData . Эта функция используется, если (и только если) dwFlags содержит MOUSEEVENTF_WHEEL . В противном случае его можно опустить или установить на ноль. dwData определяет количество движения на колесе прокрутки вашей мыши.

Быстрый пример, чтобы укрепить эти методы:

Если мы представим игру с системой выбора оружия, похожую на Half-Life 2, в которой оружие можно выбрать, вращая колесико мыши, мы предложим следующую функцию для просмотра списка оружия:

|

1 2 3 4 |

def browseWeapons(): weaponList = [‘crowbar’,’gravity gun’,’pistol’…] for i in weaponList: win32api.mouse_event(win32con.MOUSEEVENTF_MOUSEEVENTF_WHEEL,0,0,120) |

Здесь мы хотим смоделировать прокрутку колесика мыши для навигации по списку теоретического оружия, поэтому мы передали ...MOUSEEVENTF_WHEEL действие “MOUSEEVENTF_WHEEL” dwFlag. Нам не нужны dx или dy , позиционные данные, поэтому мы оставили их равными нулю, и мы хотели прокрутить один щелчок в направлении вперед для каждого «оружия» в списке, поэтому мы передали целое число 120 в dwData (каждый щелчок колеса равен 120).

Как видите, работа с mouse_event – это просто вопрос mouse_event правильных аргументов в нужное место. Давайте теперь перейдем к более полезным функциям

Шаг 5: щелчок мышью

Мы собираемся сделать три новые функции. Одна общая функция левого щелчка и две, которые обрабатывают определенные состояния «вниз» и «вверх».

Откройте code.py с IDLE и добавьте следующее в наш список операторов импорта:

|

1 |

import win32api, win32con |

Как и раньше, это дает нам доступ к содержимому модуля через синтаксис module.attribute .

Далее мы сделаем нашу первую функцию щелчка мышью.

|

1 2 3 4 5 |

def leftClick(): win32api.mouse_event(win32con.MOUSEEVENTF_LEFTDOWN,0,0) time.sleep(.1) win32api.mouse_event(win32con.MOUSEEVENTF_LEFTUP,0,0) print “Click.” |

Напомним, что все, что мы здесь делаем, это присваиваем «действие» первому аргументу mouse_event . Нам не нужно передавать какую-либо информацию о местоположении, поэтому мы оставляем параметры координат в (0,0), и нам не нужно отправлять дополнительную информацию, поэтому dwData опускается. Функция time.sleep(.1) сообщает Python прекратить выполнение на время, указанное в скобках. Мы добавим их через наш код, обычно в течение очень короткого промежутка времени. Без них «щелчок» может опередить себя и сработать до того, как у меню появится возможность обновить.

Итак, что мы сделали здесь, это общий щелчок левой кнопкой мыши. Одно нажатие, один выпуск. Мы проведем большую часть нашего времени с этим, но мы собираемся сделать еще два варианта.

Следующие два – это одно и то же, но теперь каждый шаг разделен на свою собственную функцию. Они будут использоваться, когда нам нужно некоторое время удерживать мышь (для перетаскивания, съемки и т. Д.).

|

1 2 3 4 5 6 7 8 9 |

def leftDown(): win32api.mouse_event(win32con.MOUSEEVENTF_LEFTDOWN,0,0) time.sleep(.1) print ‘left Down’ def leftUp(): win32api.mouse_event(win32con.MOUSEEVENTF_LEFTUP,0,0) time.sleep(.1) print ‘left release’ |

Шаг 9: Основное движение мыши

С помощью щелчка мышью все, что осталось, – это перемещать мышь по экрану.

Добавьте следующие функции в code.py :

|

1 2 3 4 5 6 7 8 |

def mousePos(cord): win32api.SetCursorPos((x_pad + cord[0], y_pad + cord[1]) def get_cords(): x,y = win32api.GetCursorPos() x = x – x_pad y = y – y_pad print x,y |

Эти две функции служат совершенно разным целям. Первый будет использоваться для скриптинга движения в программе. Благодаря превосходным соглашениям об именах, тело функции выполняется в точности так, как SetCursorPos() . Вызов этой функции устанавливает мышь в координаты, переданные ей в виде кортежа x,y . Обратите внимание, что мы добавили в наши пэды x и y ; важно делать это везде, где называется координата.

Второй – простой инструмент, который мы будем использовать при интерактивном запуске Python. Он выводит на консоль текущую позицию мыши в виде кортежа x,y . Это значительно ускоряет процесс навигации по меню без необходимости делать снимок и вырывать линейку. Мы не всегда сможем использовать его, поскольку некоторые действия мыши должны быть привязаны к пикселям, но когда мы можем, это фантастическая экономия времени.

На следующем шаге мы рассмотрим некоторые из этих новых методов и начнем навигацию по игровым меню. Но перед этим удалите текущее содержимое main() в code.py и замените его на pass . Мы будем работать с интерактивной подсказкой для следующего шага, поэтому нам не понадобится screenGrab() .

Шаг 10: навигация по игровым меню

В этом и следующих нескольких шагах мы попытаемся собрать как можно больше координат события, используя наш get_cords() . Используя его, мы сможем быстро создать код для таких вещей, как навигация по меню, очистка таблиц и приготовление пищи. Как только мы получим эти наборы, нужно будет просто подключить их к логике бота.

Давайте начнем. Сохраните и запустите свой код, чтобы вызвать оболочку Python. Поскольку в последнем шаге мы заменили тело main() на pass , вы должны увидеть пустую оболочку при запуске.

Теперь, прежде чем мы перейдем к игровой части игры, нам нужно пройти четыре начальных меню. Они заключаются в следующем:

- Начальная кнопка воспроизведения

- Кнопка «Продолжить» на iPhone

- Учебник “Пропустить”, кнопка

- Сегодняшняя цель “Продолжить” кнопка

Нам нужно получить координаты для каждого из них и добавить их в новую функцию startGame() . Расположите оболочку IDLE так, чтобы вы могли видеть ее и игровую зону. Введите get_cords() но пока не нажимайте return; наведите курсор мыши на кнопку, для которой вам нужны координаты. Не нажимайте пока, потому что мы хотим, чтобы фокус оставался в оболочке. Наведите указатель мыши на элемент меню и нажмите клавишу возврата. Это захватит текущее местоположение мыши и выведет на консоль кортеж, содержащий значения x,y . Повторите это для оставшихся трех меню.

Оставьте оболочку открытой и расположите ее так, чтобы вы могли видеть ее так же, как и редактор IDLE. Теперь мы собираемся добавить нашу startGame() и заполнить ее вновь полученными координатами.

|

01 02 03 04 05 06 07 08 09 10 11 12 13 14 15 16 17 18 19 20 |

def startGame(): #location of first menu mousePos((182, 225)) leftClick() time.sleep(.1) #location of second menu mousePos((193, 410)) leftClick() time.sleep(.1) #location of third menu mousePos((435, 470)) leftClick() time.sleep(.1) #location of fourth menu mousePos((167, 403)) leftClick() time.sleep(.1) |

Теперь у нас есть хорошая компактная функция для вызова в начале каждой игры. Он устанавливает позицию курсора для каждого из пунктов меню, которые мы ранее определили, а затем приказывает щелкнуть мышью. time.sleep(.1) говорит Python прекратить выполнение на 1/10 секунды между каждым кликом, что дает меню достаточно времени для обновления между ними.

Сохраните и запустите ваш код, и вы должны увидеть результат, подобный следующему:

Как слабый человек, мне нужно чуть больше секунды, чтобы пройтись по всем меню вручную, но теперь наш бот может сделать это за 0,4 секунды. Совсем неплохо!

Шаг 11: Получение координат еды