Статья написана по мотивам очередной домашки в MADE, где мы учили нейронку писать стихи с помощью рекурентных сетей.

Для начала, договоримся, что будем делать «глупую» нейросеть, которая не разбирается в языке, построении фраз, предложений, смыслах, а просто учится предсказывать следующий символ по предыдущему тексту.

Из плюсов такого подхода — не нужно париться о пунктуации, больших и маленьких буквах, нейронка их расставит сама. Из минусов — такая нейросеть «туповата».

Так же можно генерировать любые последовательности. К примеру, музыку. MIDI конвертируем в формат ABC, получаем текст (точнее, последовательность символов). На этом тексте учимся, генерируем свой, превращаем его обратно в MIDI и получаем «нейромузыку».

Если генерировать тексты, будет получаться что-то вроде:

Потом ахали на наших специалистов: они, не имея вакцины, не зная, как мы действуем сейчас: малейшее подозрение — мы проверяем человека, надо на карантин — пожалуйста, давайте на карантин. Именно точечно, профессионально надо действовать, а не территориально не сможем, это невозможно. Особенно там, но полоза. Потому что они живут, как обычно (находятся не только в каких-то все обсуждать, но и проблема. Надо «желтые жилеты» вернуть с улиц. У кого-то выборы. У кого-то еще чего-то. И каждый начинает вертерах на неменех, не дали было спросы.

Нейросеть, обученная на изречениях бессменного лидера РБ

А иногда выходит что-то совсем прекрасное:

Стоит ли любить?

Стоит ли любить?

Стоит ли любить?

Стоит и приплыли.Нейросеть, обученная на хокку

Практическое применение этому мне сложно придумать. Скорее, это — про побаловаться. Ну и сотворить что-то забавное. Fake news этом не сделаешь. Точнее, сделаешь, но они будут наредкость забавны.

И важный момент. Если что-то непонятно или просто неинтересно, а попробовать генерировать текст хочется, то достаточно просто перейти по ссылке в Google Colab в конце статьи, закинуть туда свой файлик с текстом и запустить все ячейки с кодом.

Итак, поехали.

1. Импортируем нужные библиотеки

Из внешних библиотек нам понадобятся только numpy и pytorch:

from collections import Counter import torch import torch.nn as nn import torch.nn.functional as F import numpy as np

2. Готовим данные для сети

Токенизируем текст. Превращаем его в индексы. Т.е. достаем все уникальные символы: буквы, пробелы, знаки препинания в тексте и каждому символу присваиваем число. Например:

- ‘a’ => 1

- ‘Щ’ => 2

- ‘!’ => 3

- …

Это будем называть словарем. А числа — индексами.

Делаем прямой и обратный (индексы в символы) словарь. А потом проходимся по всему тексту и превращаем с помощью составленного нами словаря каждый символ в индекс.

TRAIN_TEXT_FILE_PATH = 'train_text.txt'

with open(TRAIN_TEXT_FILE_PATH) as text_file:

text_sample = text_file.readlines()

text_sample = ' '.join(text_sample)

def text_to_seq(text_sample):

char_counts = Counter(text_sample)

char_counts = sorted(char_counts.items(), key = lambda x: x[1], reverse=True)

sorted_chars = [char for char, _ in char_counts]

print(sorted_chars)

char_to_idx = {char: index for index, char in enumerate(sorted_chars)}

idx_to_char = {v: k for k, v in char_to_idx.items()}

sequence = np.array([char_to_idx[char] for char in text_sample])

return sequence, char_to_idx, idx_to_char

sequence, char_to_idx, idx_to_char = text_to_seq(text_sample)

3. Генерируем батчи из текста

Генерируем из последовательности наших индексов батчи (сразу несколько строк текста) для обучения сети. Не будем усложнять, просто достанем несколько случайных строк из текста фиксированной длины.

Будем генерировать сразу обучающую выборку (то, на чем будем учить сеть) и таргет для нее. Таргет (правильные ответы для нейросети) — это просто сдвинутый на один символ вперед текст.

Условно:

- Обучающая выборка:

Привет как дел - Таргет:

ривет как дела

Размерность тензора батча: [BATCH_SIZE x SEQ_LEN x 1]

SEQ_LEN = 256

BATCH_SIZE = 16

def get_batch(sequence):

trains = []

targets = []

for _ in range(BATCH_SIZE):

batch_start = np.random.randint(0, len(sequence) - SEQ_LEN)

chunk = sequence[batch_start: batch_start + SEQ_LEN]

train = torch.LongTensor(chunk[:-1]).view(-1, 1)

target = torch.LongTensor(chunk[1:]).view(-1, 1)

trains.append(train)

targets.append(target)

return torch.stack(trains, dim=0), torch.stack(targets, dim=0)

4. Пишем функцию, которая генерирует текст

Теперь напишем функцию, которая предсказывает текст с помощью нашей обученной нейросети. Это удобно сделать заранее, чтобы смотреть, что генерирует сеть во время обучения.

Сеть предсказывает нам вероятности следующей буквы, и мы с помощью этих вероятностей достаем случайно по одной букве. Если повторить операцию 1000 раз, получим текст из 1000 символов.

Параметр start_text нам нужен, чтобы было что-то, для чего предсказывать следующий символ. У нас этот символ по умолчанию — пробел, и задача сети сначала — предсказать следующий символ после пробела. Потом — следующий после этих 2-х символов. И т.д.

Параметр temp — это уровень «случайности» генерируемого текста. Так называемая «температура» с отсылкой к понятию «энтропии». То, на что делим логиты в softmax. Поставим высокую — вероятность каждой буквы будет почти одинакова и текст превратится в случайную белиберду. Поставим низкую — каждый раз будем предсказывать одно и то же и можем зациклиться на одной фразе.

def evaluate(model, char_to_idx, idx_to_char, start_text=' ', prediction_len=200, temp=0.3):

hidden = model.init_hidden()

idx_input = [char_to_idx[char] for char in start_text]

train = torch.LongTensor(idx_input).view(-1, 1, 1).to(device)

predicted_text = start_text

_, hidden = model(train, hidden)

inp = train[-1].view(-1, 1, 1)

for i in range(prediction_len):

output, hidden = model(inp.to(device), hidden)

output_logits = output.cpu().data.view(-1)

p_next = F.softmax(output_logits / temp, dim=-1).detach().cpu().data.numpy()

top_index = np.random.choice(len(char_to_idx), p=p_next)

inp = torch.LongTensor([top_index]).view(-1, 1, 1).to(device)

predicted_char = idx_to_char[top_index]

predicted_text += predicted_char

return predicted_text

5. Создаем класс нашей нейросети

И наконец наша маленькая и уютная нейросеть. Она работает так:

- Превращаем каждый символ на входе сети в вектор (так называемный эмбеддинг).

- Скармливаем эти векторы нашему LSTM слою. У этого слоя есть особенность: он работает не независимо для каждого символа, а помнит, что к нему раньше приходило на вход. Притом, помнит не все: ненужное он умеет забывать. Такие слои называют рекуррентными и часто используют при работе с последовательностями.

- Выходы из LSTM слоя пропускаем через Dropout. Этот слой «мешает» сети учиться, чтобы ей сложнее было выучить весть текст.

- Дальше отправляем выход из Dropout на линейный слой размерности словаря, чтобы на выходе получить столько чисел, сколько у нас символов в словаре. Потом мы этот вектор чисел будем превращать в «вероятности» каждого символа с помощью функции softmax.

class TextRNN(nn.Module):

def __init__(self, input_size, hidden_size, embedding_size, n_layers=1):

super(TextRNN, self).__init__()

self.input_size = input_size

self.hidden_size = hidden_size

self.embedding_size = embedding_size

self.n_layers = n_layers

self.encoder = nn.Embedding(self.input_size, self.embedding_size)

self.lstm = nn.LSTM(self.embedding_size, self.hidden_size, self.n_layers)

self.dropout = nn.Dropout(0.2)

self.fc = nn.Linear(self.hidden_size, self.input_size)

def forward(self, x, hidden):

x = self.encoder(x).squeeze(2)

out, (ht1, ct1) = self.lstm(x, hidden)

out = self.dropout(out)

x = self.fc(out)

return x, (ht1, ct1)

def init_hidden(self, batch_size=1):

return (torch.zeros(self.n_layers, batch_size, self.hidden_size, requires_grad=True).to(device),

torch.zeros(self.n_layers, batch_size, self.hidden_size, requires_grad=True).to(device))

6. Создаем нейросеть и обучаем ее

Теперь создаем нейросеть и обучаем ее. LSTM блок принимает немного другой формат батча:

[SEQ_LEN x BATCH_SIZE x 1], поэтому делаем permute для тензоров train и target, чтобы поменять 0 и 1 размерность местами.

Параметры нейросети, которые может понадобиться подкрутить:

hidden_size— влияет на сложность сети. Стоит повышать для текстов большого размера. Если выставить большое значение для текста маленького размера, то сеть просто выучит весь текст и будет генерировать его же.n_layers— опять же, влияет на сложность сети. Грубо говоря, позволяет делать несколько LSTM слоев подряд просто меняя эту цифру.embedding_size— размер обучаемого эмбеддинга. Можно выставить в несколько раз меньше размера словаря (числа уникальных символов в тексте) или примерно такой же. Больше — нет смысла.

Дальше — стандартный для PyTorch цикл обучения нейросети: выбираем функцию потерь, оптимизатор и настраиваем расписание, по которому меняем шаг оптимизатора. В нашем случае снижаем шаг в 2 раза, если ошибка (loss) не падает 5 шагов подряд.

Если очень грубо, то здесь мы много раз подаем в нейросеть разные кусочки текста и учим ее делать все меньше и меньше ошибок, когда она предсказывает следующую букву по предыдущему тексту.

device = torch.device('cuda') if torch.cuda.is_available() else torch.device('cpu')

model = TextRNN(input_size=len(idx_to_char), hidden_size=128, embedding_size=128, n_layers=2)

model.to(device)

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=1e-2, amsgrad=True)

scheduler = torch.optim.lr_scheduler.ReduceLROnPlateau(

optimizer,

patience=5,

verbose=True,

factor=0.5

)

n_epochs = 50000

loss_avg = []

for epoch in range(n_epochs):

model.train()

train, target = get_batch(sequence)

train = train.permute(1, 0, 2).to(device)

target = target.permute(1, 0, 2).to(device)

hidden = model.init_hidden(BATCH_SIZE)

output, hidden = model(train, hidden)

loss = criterion(output.permute(1, 2, 0), target.squeeze(-1).permute(1, 0))

loss.backward()

optimizer.step()

optimizer.zero_grad()

loss_avg.append(loss.item())

if len(loss_avg) >= 50:

mean_loss = np.mean(loss_avg)

print(f'Loss: {mean_loss}')

scheduler.step(mean_loss)

loss_avg = []

model.eval()

predicted_text = evaluate(model, char_to_idx, idx_to_char)

print(predicted_text)

При обучении должно получиться на выходе что-то вроде:

Loss: 3.0337722063064576

В то не не посто на на не не на на не на помотророне на онот потарити не сем посто нат на рото сто на но на то тосте на посто нал на на на на росмоно посто но это воме на не вотато не не но на не нам на

Loss: 2.4729482173919677

В поторовововать оточели не не тора на на на на подовать не то не на подени не на вобомать не не прорус не сто на на сторы домем водем не сто не это соторовоста вомать на на проденить не бостова сто пор

Loss: 2.2126503944396974

В это надо поторовать на содолько не полодали не то начения. Нако не надо на работать на на полили на на наши наши подули сотовать на нало обранить на на постовать не наши на поставил в ирания стравом м

Loss: 2.028042938709259

В кому просторы на наши на комперами на только полоблимать должны поровать не том приратить подурать рас совеловали полжно от востание в мостам в сего принимали сотрать в нам нам от проблимать больно на

.......

.......

.......

Loss: 0.5439809119701385

В ибыратий от безработицы и доклады. Авторов мы сегодня по тому сли нас дороге, чтобы они смогли выйти и пережил уже многие психозом особенно надо выживать на эту тему в этот пережил уже многие психозы,

Loss: 0.5482879960536957

В ибывать на сегодняшний день отношение домерми вде выписов из меня частся с вами и серация — ни одного сказать, что мы сейчас делаем, они понятный их сполоси, которые основной пофтомие потери людям за

Loss: 0.5576688635349274

В конятно к этой пришетов не проблема станок их работать, потому что это повторилось.

Результатом стал устойчивый рост благосостояния населения. Мы точно дошло предложено. Политически запрещаю. ДавайтеМожете остановить обучение в любой момент. К примеру, тогда, когда ошибка (Loss) перестанет снижаться.

7. Генерируем текст

Итак, наша сеть обучилась. Давайте что-нибудь сгенерируем:

model.eval()

print(evaluate(

model,

char_to_idx,

idx_to_char,

temp=0.3,

prediction_len=1000,

start_text='. '

)

)

Рекомендую поиграть с параметром temp и, конечно же, start_text. С помощью start_text можно попробовать «задать тему/направление» для генерируемого текста. Желательно, ту, которая есть в тексте, на котором сеть училась, конечно.

Надеюсь, все получилось и нигде ничего не свалилось.

Не хочу ничего делать, хочу сразу генерировать текст

Так тоже можно. Просто откройте jupyter notebook в Google Colab, скопируйте туда файлик с текстом и выполните все ячейки.

Открыть готовый код в Google Colab

После того, как открыли, нужно скопировать туда и файл с текстом, на котором будет тренироваться нейросеть.

Вот и все. Можно развлекаться. Просто запустите подряд все ячейки с кодом. Когда будете учить нейросеть (предпоследняя ячейка), можете не ждать, пока обучение дойдет до конца и остановить в любой момент.

И еще крайне рекомендую в настройках Colab «Runtime» => «Change runtime type» => «Hardware accelerator» выбрать «GPU». На видеокарте сеть учится в разы быстрее.

На всякий случай, выложил код на github.

Если есть какие-то вопросы, что-то не работает или вы нашли баг, пишите, постараюсь помочь.

P.S.: если получится сгенерировать что-то забавное, сбросьте это сюда в комментарии 🙂

Дата публикации: 17.02.2023

Время чтения: 8 мин.

Светлана Трегубова

ЭКСПЕРТ

Копирайтер-маркетолог. Работаю с проектами EdTech, консалтинговыми фирмами и соцсетями с 2018 года

Нейросеть — искусственный интеллект, который способен генерировать контент, в том числе и тексты. Мучающий многих вопрос: смогут ли нейросети заменить людей-креаторов, или до этого еще далеко?

В этой статье разберемся, как нейросеть пишет текст, посмотрим 10 лучших нейросетей для написания осмысленных предложений и проверим возможности одной из них.

Тысячи надёжных каналов для продвижения бизнеса в Telegram

Telega.in — платформа нативных интеграций с блогерами в Telegram. Каждый канал в каталоге проверен вручную, а админы готовы к сотрудничеству — никаких долгих переговоров!

- Выбирайте лучшие каналы в открытом каталоге самостоятельно или с помощью менеджера.

- Планируйте кампании эффективно: интеграции гарантированно будут опубликованы в срок и в том виде, в котором их согласует заказчик.

- Экономьте время: отчёты по каждой кампании предоставляются в удобной таблице со всеми необходимыми данными.

Как происходит генерация текста

Нейросеть для создания контента — это набор алгоритмов, которые анализируют огромное количество информации и собирают похожий на нужный результат контент.

В процессе работы нейросеть не только запоминает все больше новых кусков текста, которые она может использовать для составления предложений, но и обучается на своих ошибках. Обучение позволяет ей выстраивать осмысленный текст, а не просто генерировать набор символов.

Сегодня «уроки» текстовых нейросетей тесно связаны с NLP (Natural Language Processing) — анализом и генерацией естественного языка. Искусственный интеллект не просто запоминает, какое слово чаще употребляется в том или ином контексте, но и учится понимать этот контекст.

Для самых продвинутых нейросетей-трансформеров текст — это набор цифровых кодов. Каждый символ — это код из нулей и единиц.

Самые медленные и слабые нейросети пытаются учиться на буквах, но такой подход пока не показывает хороших результатов — на анализ букв алгоритму нужно больше времени, чем на анализ нулей и единиц.

Такой упрощенный формат бинарной системы исчисления, помогает нейросети быстро генерировать текст, подбирая зафиксированные в памяти сочетания нулей и единиц, а не букв.

На основе нейросетей-трансформеров программисты строят огромные базы данных, вычленяя из них нужный символ в нужное время с помощью сложных математических алгоритмов.

База данных нейросети состоит из:

- бинарных кодов символов (нули и единицы),

- информации о синтаксисе языка,

- огромного массива данных о внешнем мире.

Такое сочетание ускоряет обучение нейросетей. Некоторые из них могут сразу же продолжать набранный человеком текст без промедления и длительного анализа данных и обучения. Эта модель генерации называется Few-shot learning, когда нейросеть в процессе написания текста, учится на своих ошибках.

Лучшие нейросети для написания текстов

Российские онлайн-сервисы

1. Gerwin AI

Самая продвинутая нейросеть для креаторов контента.

Gerwin AI пишет статьи, посты и заголовки. Внутри редактора нейросети вы можете изменять текст и сразу же проверять его на уникальность. Можно задавать тон написания материала: от шутливого до агрессивного.

Сервис платный. Тестового бесплатного периода для «пробы пера» нет. Доступ можно купить по подписке — платите один раз 4 990 рублей и получаете вечный доступ ко всем функциям Gerwin AI.

Или можно приобрести пакеты символов:

При покупке подписки на все пакеты символов действует скидка 40%.

2. Балабоба от Яндекс

Сайт: https://yandex.ru/lab/yalm

Молодая нейросеть от российского IT-гиганта, запущенная в июне 2021 года.

Бесплатная нейросеть

Балабоба работает на основе модели, похожей на GPT-3 американской компании Илона Маска Open AI. По типу модели GPT-3 также создан скандально известный бот-помощник ChatGPT.

Балабоба сама обучается — использует модель Optimization-based. Она знает правила русского языка, умеет осмысленно сочетать слова, запомнить свои ошибки. Она может дописать историю, пост или придумать короткую фразу.

Для обучения нейросети разработчики Яндекс загрузили в Балобобу все страницы, которые можно найти в поиске Яндекс. Она «прочитала» всю Википедию, все доступные в поисковике книги и всевозможные сайты и форумы.

Таким же методом программисты обучали голосового помощника Алису подбирать грамматически верные ответы при разговоре с пользователем.

Сама думать Балабоба не умеет. Она лишь парсит интернет в поиске подходящих осмысленных предложений.

В конце статьи дадим Балабобе задание и посмотрим, как она справится с ним.

3. Порфирьевич

Сайт: https://porfirevich.ru

Российский программист Максим Гранкин создал в 2019 нейросеть на основе прошлой модели GPT-2 Open AI и выложил ее в свободный доступ. Порфирьевич специализируется на написании коротких историй. Вы задаете начало рассказа — нейросеть продолжает его.

Бесплатная нейросеть

Обучение нейросети проходило с помощью классической и современной литературы, поэтому она может использовать интересные речевые обороты для рассказов, но писать посты и инструкции — невыполнимая задача для Порфирьевича.

Технические тексты тоже даются программе с трудом. Все научные тексты она сводит к размышлениям и риторическим вопросам.

4. ruGPT-3 от Сбер

Сайт: https://developers.sber.ru/portal/products/rugpt-3

Сбер все больше вкладывается в разработку систем искусственного интеллекта, о чем говорит выпуск своего голосового помощника в виде колонки и отдельная команда по работе с ИИ Sberbank.AI. И вот, в 2020 году Сбер выпускает переделанную версию GPT-3.

Бесплатная нейросеть

Для обучения нейросети разработчики составили массив данных на 600Гб из русской литературы, новостных порталов, страниц русско- и англоязычной Википедии. Да, ruGPT-3 может немного печатать на английском, но только короткие малоосмысленные предложения.

Для дополнения русского текста нейросети хватит всего пары предложений, чтобы она дописала осмысленный рассказ на 2 страницы с раскрытием героев и закрученным сюжетом.

Зарубежные нейросети

Зарубежные компании по разработке искусственного интеллекта делают акцент не на грамотном написании текстов, а на помощи креаторам.

Российские нейросети — это пока экспериментальные разработки, которые не могут полностью заменить сотрудника. По сранвению с зарубежным ИИ они еще «сырые». Иностранные же нейросети создаются для того, чтобы человек мог делегировать рутинные задачи искусственному интеллекту.

Все нейросети из подборки работают без VPN.

1. AdCreative.AI

Сайт: https://www.adcreative.ai

Американская нейросеть для создания рекламных постов и креативов.

Разработчики утверждают, что при использовании текстов, написанных AdCreative.AI, конверсии кликабельности объявлений увеличиваются на 14%.

Нейросеть создает не просто осмысленные предложения, а продающие тексты, задача которых не только быть читаемыми, но и продавать вашу услугу/товар аудитории. Также нейросеть создает рекламные баннеры в любом разрешении.

AdCreative.AI — платная нейросеть. Использовать ее можно по ежемесячной подписке стоимостью от 25 до 145$ в месяц. Есть бесплатный тестовый 7-дневный период.

2. Bertha.ai

Сайт: https://bertha.ai

Зарубежная нейросеть для создания продающих описаний товаров и услуг.

Сервис платный. Создатели предлагают 2 тарифа: 45$ и 150$ в месяц. Цена зависит от нужного количества текстов.

Также можно заплатить 25$ за 10 тысяч слов или 15$ за 100 изображений.

Еще Bertha.ai может создать текстовую копию веб-страницы, предложить идеи для публикаций и сгенерировать оригинальное изображение.

3. Writersonic

Сайт: https://writesonic.com

Мощная нейросеть для созданий креатива. Разработчики обещают, что создание контента ускорится в 10 раз при использованиии Writersonic.

Нейросеть может писать множество разных текстов: посты для блога, рекламные посевы, email-рассылки, наполнение сайта.

Тексты Writersonic SEO-оптимизированы. Сеть подбирает слова так, чтобы ваш блог или сайт был одним из первых в поисковой выдаче.

Программа платная. Цена использования нейросети зависит от количества сотрудник, которые будут генерировать контент с помощью Writersonic, и количества слов в месяц. Минимальный пакет на 1 человека и 47.5 тысяч слов стоит 12.67$, максимальный пакет для 15 человек и 5 миллионов слов — 666$.

4. CopyMonkey

Сайт: https://www.copymonkey.app

Зарубежная нейросеть, полностью адаптированная под русскоязычного пользователя.

CopyMonkey полностью платная: от 1 599 до 7 999 рублей в месяц. Можно связаться с менеджером платформы и обсудить с ним персональные условия для внедрения нейросети в бизнес-процессы своего предприятия.

Нейросеть может написать текст для сайта, пост для блога, заполнить карточку товара на Ozon или Wildberries.

5. PepperType.ai

Сайт: https://www.peppertype.ai

Создатели нейросети утверждают, что тексты PepperType.ai увеличивают конверсии продаж в несколько раз, а алгоритмы нейросети работают в 10 раз быстрее, недели алгоритмы других сервисов-конкурентов.

На платформе есть пространство для работы маркетингового отдела, где вы можете курировать работу креаторов и ставить им задачи. Они же, не выходя из рабочего пространства, могут создавать контент с помощью нейросети.

Нейросеть платная. Чтобы подключить нейросеть к работе, необходимо оплатить 35$ за одного сотрудника или 199$ за 5 человек.

6. Copy.ai

Сайт: https://www.copy.ai

Нейросеть для создания коротких рекламных текстов.

Copy.ai можно пользоваться бесплатно, но с ограничением — до 2000 сгенерированных слов в месяц. Или можно подключить тариф за 49$ в месяц без ограничений по количеству слов.

Но за приятной ценой стоит большой недостаток — тексты и креативы начинают повторяться со временем. Для генерации разных вариантов нейросеть должна обучаться на большом количестве данных. Разработчики Copy.ai не заложили в свое создание достаточно информации для создания уникального контента на месяцы вперед.

Как написать текст с помощью нейросети

Посмотрим, что умеет отечественный сервис Балабоба.

Чтобы попасть на страницу нейросети, заходим в поиск Яндекса, печатаем название сервиса и открываем самую верхнюю строку поиска.

Поисковик предложит 2 варианта Балабобы: русскую версию и английскую. Мы остановимся на русской.

Разработчики оставили заботливое послание на первом экране сайта нейросети, что Балабоба несовершенна, она может написать ерунду, и обижаться за это на нее не стоит.

Нажимаем «Договорились» и переходим на страницу-редактор текста.

Вверху мы можем выбрать стиль написания текста:

- Без стиля. Нейросеть допишет текст без какого-либо авторского стиля на любую тему.

- Новогодние открытки. Балабоба подберет картинку для открытки и допишет текст поздравления.

- Балабоба и Sports.ru. Написание комментариев к новостям спорта. Алгоритм разработчики Яндекс приурочили к чемпионату мира по футболу 2021 года в России и создали его совместно со спортивной редакцией Sports.ru.

- Инструкция по применению. Понятный простой текст с последовательными действиями.

- Рецепты. Те же «вкусные» инструкции.

- Народные мудрости. Пишем начало мудрости и получаем ее окончание от Балабобы.

- Короткие истории. Пишем рассказ вместе с Балабобой.

- Короче, Википедия. Балабоба даст определение к любому слову, которое вводит пользователь.

- Синопсисы фильмов. Пишем название существующего фильма — нейросеть находит его сюжет. Придумываем название фильма — нейросеть попробует пофантазировать, какой сюжет был бы у кинофильма с таким названием.

- Предсказания. Пишем имя или знак зодиака и получаем шутливое гадание от Балабобы.

Начнем с простого: дадим название несуществующего фильма и посмотрим, какой сюжет предложит нейросеть.

Первая попытка провалена. Почему-то нейросеть посчитала, что фраза «Опасные ящерицы 2: погоня за хот-догом» содержит в себе острую тему.

«Розовый слон вышел на прогул» больше понравился Балабобе, и она написала завязку для фильма в стиле романтических комедий Вуди Аллена. Но последние предложения смешиваются в кашу: становится невозможным понять, какой именно предмет розового цвета не понравился домохозяйке и что она она должна перекрасить в другой оттенок.

Вводим начало народной мудрости. В ответ нейросеть находит ее продолжение в интернете.

Если написать несуществующую пословицу, то Балабоба генерирует осмысленное продолжение на основе текстов из интернета:

Попробуем написать в соавторстве с Балабобой историю:

Лихозакрученный сюжет нейросеть не предложит — только допишет короткий рассказ на основе предложенных данных пользователем.

И последнее самое сложное задание: попробуем написать вместе с Балабобой пост для блога. Для этого выберем вариант стилизации «Без стиля»:

В этом случае нейросеть предлагает уже более осмысленный вариант — целостный текст с логическим завершением.

Заключение

Нейросети — новый инструмент, который может помогать креаторам создавать контент или улучшать его качество. С каждым годом они становятся все более совершенными, а с такими темпами развития, кто знает, возможно, искусственный интеллект сможет полностью писать тексты за людей уже в недалеком будущем.

Вам понравилась статья?

17

0

В прошлый раз мы разбирались с теорией про цепи Маркова. Вот основные тезисы:

- Цепь Маркова — это последовательность событий, где каждое новое событие зависит только от предыдущего. Например, после одного слова может стоять другое слово.

- Существуют алгоритмы, которые способны генерировать текст на основании цепей Маркова. Они изучают, какие связи могут быть между словами, и потом проходят по этим связям и составляют новый текст.

- Для нашей работы алгоритму всегда нужен исходный текст (он же корпус) — глядя на этот текст, алгоритм поймёт, какие слова обычно идут друг за другом.

- Чем больше размер исходного текста, тем больше связей между цепями и тем разнообразнее получается текст на выходе.

Сегодня попробуем это в деле и напишем самый простой генератор текста на цепях Маркова. Это будет похоже на работу нейросети, но на самом деле никаких «нейро» там нет — просто сети, которые сделаны на алгоритме цепей Маркова. А сеть — это просто таблица со связями между элементами.

Короче: никакого искусственного интеллекта, просто озверевшие алгоритмы вслепую дёргают слова.

Логика проекта

Код будем писать на Python, потому что от отлично подходит под задачи такого плана — обработка текста и построение моделей со сложными связями.

Логика будет такой:

- Берём файл с исходным текстом и разбиваем его на слова.

- Все слова, которые стоят рядом, соединяем в пары.

- Используя эти пары, составляем словарь цепочек, где указано первое слово и все, которые могут идти после него.

- Выбираем случайное слово для старта.

- Задаём длину текста на выходе и получаем результат.

Сделаем всё по шагам, как обычно.

Проверяем, что у нас есть Python

Python не так-то просто запустить, поэтому, если вы ещё ничего не делали на Python, прочитайте нашу статью в тему. Там всё описано по шагам.

Разбиваем исходный текст

Для тренировки мы взяли восьмой том полного собрания сочинений Чехова — повести и рассказы. В нём примерно 150 тысяч слов, поэтому должно получиться разнообразно. Этот файл нужно сохранить как che.txt и положить в ту же папку, что и код программы.

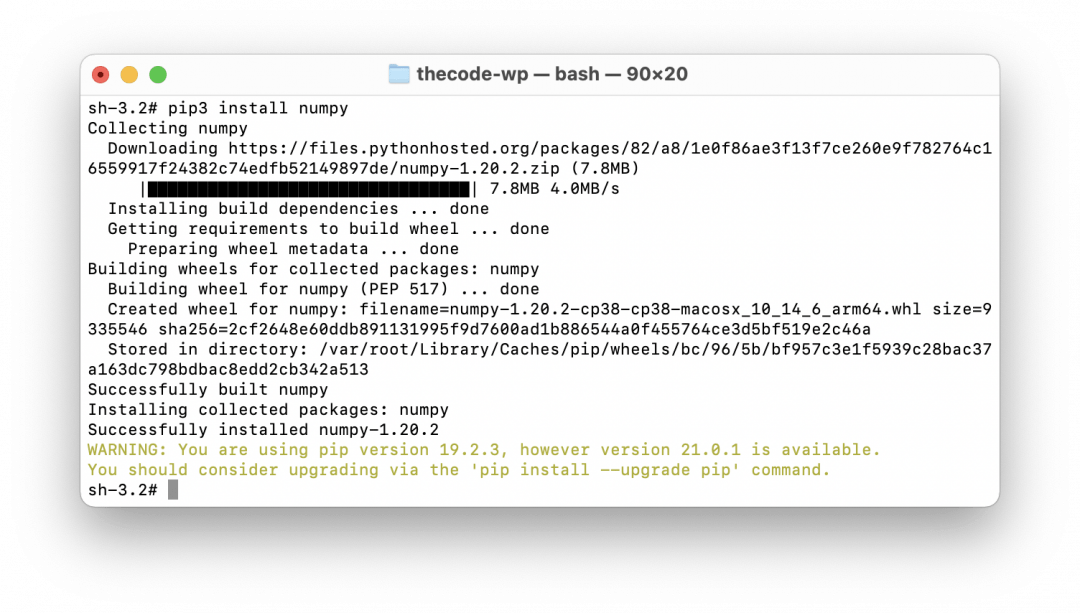

👉 Чтобы быстро работать с большими массивами данных, будем использовать библиотеку numpy — она написана специально для биг-даты, работы с нейросетями и обработки больших матриц. Для установки можно использовать команду pip3 install numpy:

# подключаем библиотеку numpy

import numpy as np

# отправляем в переменную всё содержимое текстового файла

text = open('che.txt', encoding='utf8').read()

# разбиваем текст на отдельные слова (знаки препинания останутся рядом со своими словами)

corpus = text.split()Генерируем пары

Для этого используем специальную команду-генератор: yield. В функциях она работает как return — возвращает какое-то значение, а нам она нужна из-за особенностей своей работы. Дело в том, что yield не хранит и не запоминает никакие значения — она просто генерирует что-то, тут же про это забывает и переходит к следующему. Именно так и работают цепи Маркова — они не запоминают все предыдущие состояния, а работают только с конкретными парами в данный момент.

👉 Мы разберём генераторы более подробно в отдельной статье, а пока просто используем их в нашем коде.

# делаем новую функцию-генератор, которая определит пары слов

def make_pairs(corpus):

# перебираем все слова в корпусе, кроме последнего

for i in range(len(corpus)-1):

# генерируем новую пару и возвращаем её как результат работы функции

yield (corpus[i], corpus[i+1])

# вызываем генератор и получаем все пары слов

pairs = make_pairs(corpus)В результате мы получаем все пары слов, которые идут друг за другом — с повторениями и в том порядке, как они расположены в исходном тексте. Теперь можно составлять словарь для цепочек.

Составляем словарь

Пойдём по самому простому пути: не будем высчитывать вероятности продолжения для каждого слова, а просто укажем вторым элементом в паре все слова, которые могут быть продолжением. Например, у нас в переменной pairs есть такие пары:

привет → это

привет → друг

привет → как

привет → друг

привет → друг

Видно, что «друг» встречается в 3 раза чаще остальных слов, поэтому вероятность его появления — ⅗. Но чтобы не считать вероятности, мы сделаем так:

- Составим пару привет → (это, друг, как, друг, друг).

- При выборе мы просто случайным образом выберем одно из значений для продолжения.

👉 Это, конечно, не так изящно, как в серьёзных алгоритмах с матрицами и вероятностями, зато работает точно так же и более просто в реализации.

Вот блок с этим кодом на Python:

# словарь, на старте пока пустой

word_dict = {}

# перебираем все слова попарно из нашего списка пар

for word_1, word_2 in pairs:

# если первое слово уже есть в словаре

if word_1 in word_dict.keys():

# то добавляем второе слово как возможное продолжение первого

word_dict[word_1].append(word_2)

# если же первого слова у нас в словаре не было

else:

# создаём новую запись в словаре и указываем второе слово как продолжение первого

word_dict[word_1] = [word_2]Выбираем слово для старта

Чтобы было совсем непредсказуемо, начальное слово тоже будем выбирать случайным образом. Главное требование к начальному слову — первая заглавная буква. Выполним это условие так:

- Случайно выберем первое слово.

- Проверим, есть ли в нём большие буквы. Для простоты допустим, что если есть, то они стоят в начале и нам подходят.

- Если есть — отлично, если нет — выбираем слово заново и повторяем все шаги.

- Делаем так до тех пор, пока не найдём подходящее слово.

# случайно выбираем первое слово для старта

first_word = np.random.choice(corpus)

# если в нашем первом слове нет больших букв

while first_word.islower():

# то выбираем новое слово случайным образом

# и так до тех пор, пока не найдём слово с большой буквой

first_word = np.random.choice(corpus)Запускаем алгоритм

У нас почти всё готово для запуска. Единственное, что нам осталось сделать — установить количество слов в готовом тексте. После этого наш алгоритм возьмёт первое слово, добавит в цепочку, потом выберет для этого слова случайное продолжение, потом выберет случайное продолжение уже для второго слова и так далее. Так он будет делать, пока не наберёт нужное количество слов, после чего остановится.

# делаем наше первое слово первым звеном

chain = [first_word]

# сколько слов будет в готовом тексте

n_words = 100

# делаем цикл с нашим количеством слов

for i in range(n_words):

# на каждом шаге добавляем следующее слово из словаря, выбирая его случайным образом из доступных вариантов

chain.append(np.random.choice(word_dict[chain[-1]]))

# выводим результат

print(' '.join(chain))Результат

После обработки Чехова наш алгоритм выдал такое:

В октябре 1894 г. Текст статьи, написанные за вечерним чаем сидела за ивы. Они понятия о равнодушии к себе в целом — бич божий! Егор Семеныч и боялась. В повести пассивности, пессимизма, равнодушия («формализма») писали это она отвечала она не застав его лоб. Он пишет, что сам Песоцкий впервые явилась мысль о ненормальностях брака. Поймите мои руки; он, — а женщин небось поставил крест на о. Сахалине (см.: М. — Нет, вы тоже, согласитесь, сытость есть две ночи и белые, пухлые руки и мог не содержащем единой и не заслуживает «ни закрепления, ни мне не знаю, для меня с 50 рисунками

Здесь нет смысла, хотя все слова связаны друг с другом. Чтобы результат был более читабельным, нам нужно увеличить количество слов в парах и оптимизировать алгоритм. Это сделаем в другой раз, на сегодня пока всё.

Неправильно ты, Дядя Фёдор, на Питоне кодишь

Опытные питонисты абсолютно справедливо сделают нам замечание: нужно не писать новый алгоритм для обработки цепей Маркова, а использовать какую-нибудь готовую библиотеку типа Markovify.

Всецело поддерживаем. В рабочих проектах, где вам нужно будет быстро получить правильный и предсказуемый результат, нужно не изобретать алгоритмы с нуля, а использовать опыт предыдущих поколений.

Но нам было интересно сделать собственный алгоритм. А когда человеку интересно, ничто не должно стоять на его пути.

Но в другой раз сделаем на библиотеке, окей.

# подключаем библиотеку numpy

import numpy as np

# отправляем в переменную всё содержимое текстового файла

text = open('che.txt', encoding='utf8').read()

# разбиваем текст на отдельные слова (знаки препинания останутся рядом со своими словами)

corpus = text.split()

# делаем новую функцию-генератор, которая определит пары слов

def make_pairs(corpus):

# перебираем все слова в корпусе, кроме последнего

for i in range(len(corpus)-1):

# генерируем новую пару и возвращаем её как результат работы функции

yield (corpus[i], corpus[i+1])

# вызываем генератор и получаем все пары слов

pairs = make_pairs(corpus)

# словарь, на старте пока пустой

word_dict = {}

# перебираем все слова попарно из нашего списка пар

for word_1, word_2 in pairs:

# если первое слово уже есть в словаре

if word_1 in word_dict.keys():

# то добавляем второе слово как возможное продолжение первого

word_dict[word_1].append(word_2)

# если же первого слова у нас в словаре не было

else:

# создаём новую запись в словаре и указываем второе слово как продолжение первого

word_dict[word_1] = [word_2]

# случайно выбираем первое слово для старта

first_word = np.random.choice(corpus)

# если в нашем первом слове нет больших букв

while first_word.islower():

# то выбираем новое слово случайным образом

# и так до тех пор, пока не найдём слово с большой буквой

first_word = np.random.choice(corpus)

# делаем наше первое слово первым звеном

chain = [first_word]

# сколько слов будет в готовом тексте

n_words = 100

# делаем цикл с нашим количеством слов

for i in range(n_words):

# на каждом шаге добавляем следующее слово из словаря, выбирая его случайным образом из доступных вариантов

chain.append(np.random.choice(word_dict[chain[-1]]))

# выводим результат

print(' '.join(chain))

Перевод

Ссылка на автора

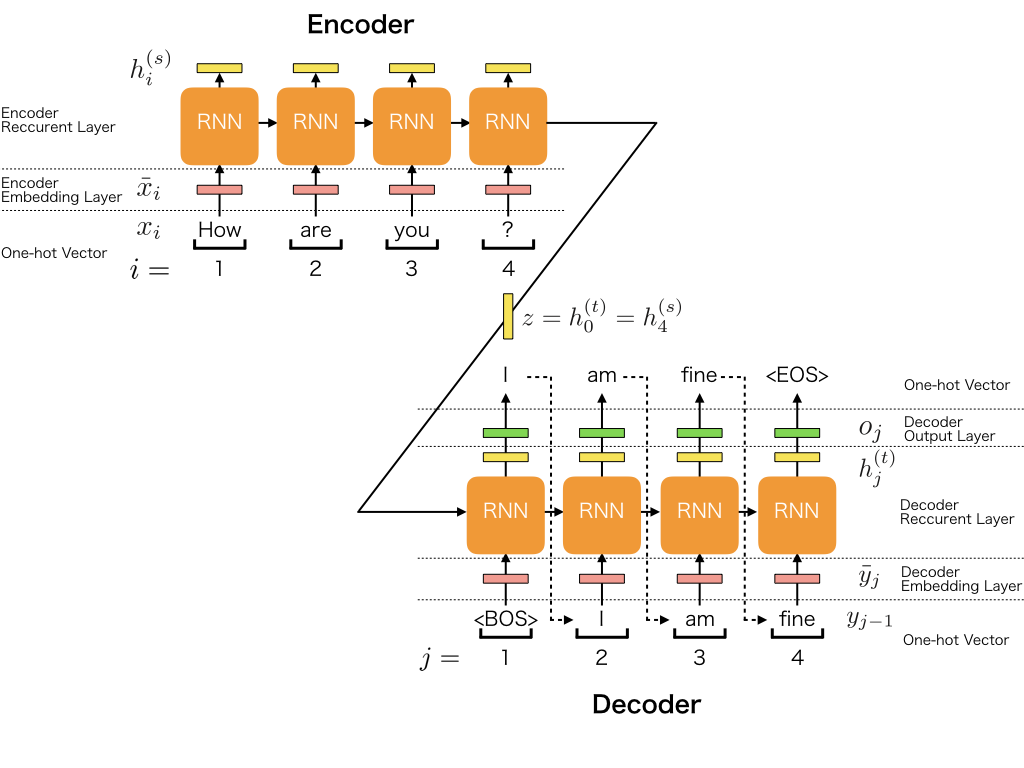

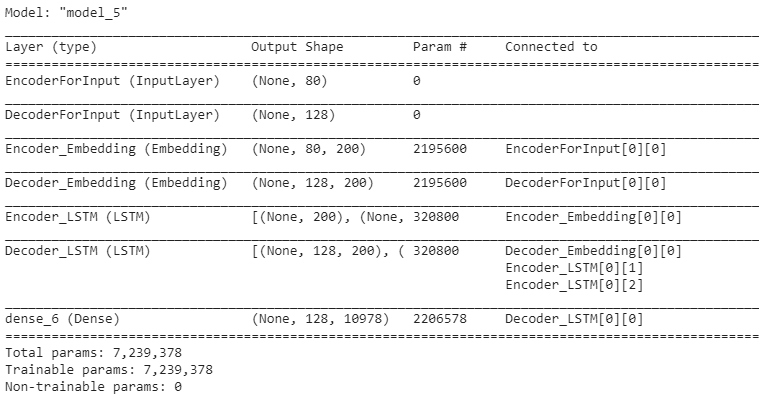

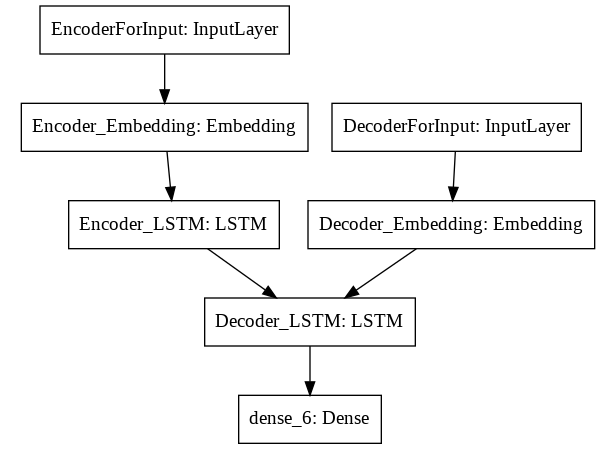

Рекуррентные нейронные сети также могут быть использованы в качестве генеративных моделей.

Это означает, что в дополнение к тому, что они используются для прогнозных моделей (создания прогнозов), они могут изучать последовательности проблемы, а затем генерировать совершенно новые вероятные последовательности для проблемной области.

Подобные генеративные модели полезны не только для изучения того, насколько хорошо модель выявила проблему, но и для того, чтобы узнать больше о самой проблемной области.

В этом посте вы узнаете, как создать генеративную модель для текста, посимвольный, используя рекуррентные нейронные сети LSTM в Python с Keras.

Прочитав этот пост, вы узнаете:

- Где скачать бесплатный корпус текста, который вы можете использовать для обучения генеративных моделей текста.

- Как поставить проблему текстовых последовательностей в рекуррентную модель генерации нейронной сети.

- Как разработать LSTM для генерации правдоподобных текстовых последовательностей для данной проблемы.

Давайте начнем.

Заметка: Рекуррентные нейронные сети LSTM могут работать медленно, поэтому настоятельно рекомендуется обучать их на оборудовании с графическим процессором. Вы можете получить доступ к оборудованию графического процессора в облаке очень дешево, используя Amazon Web Services, см. учебник здесь,

- Обновление октябрь 2016: Исправлено несколько незначительных опечаток в коде.

- Обновление март / 2017: Обновлен пример для Keras 2.0.2, TensorFlow 1.0.1 и Theano 0.9.0.

Описание проблемы: проект Гутенберг

Многие из классических текстов больше не защищены авторским правом.

Это означает, что вы можете скачать весь текст этих книг бесплатно и использовать их в экспериментах, например, при создании генеративных моделей. Возможно, лучшее место для получения доступа к бесплатным книгам, которые больше не защищены авторским правом, это Проект Гутенберг,

В этом уроке мы собираемся использовать любимую книгу из детства в качестве набора данных: Приключения Алисы в Стране Чудес Льюиса Кэрролла,

Мы собираемся изучить зависимости между символами и условные вероятности символов в последовательностях, чтобы мы могли, в свою очередь, генерировать совершенно новые и оригинальные последовательности символов.

Это очень весело, и я рекомендую повторить эти эксперименты с другими книгами из проекта Гутенберга, вот список самых популярных книг на сайте,

Эти эксперименты не ограничиваются текстом, вы также можете поэкспериментировать с другими данными ASCII, такими как компьютерный исходный код, размеченные документы в LaTeX, HTML или Markdown и другие.

Вы можете скачать полный текст в формате ASCII (Обычный текст UTF-8) для этой книги бесплатно и поместите ее в свой рабочий каталог с именем файлаwonderland.txt,

Теперь нам нужно подготовить набор данных к моделированию.

Project Gutenberg добавляет стандартный колонтитул к каждой книге, и это не является частью исходного текста. Откройте файл в текстовом редакторе и удалите верхний и нижний колонтитулы.

Заголовок очевиден и заканчивается текстом:

*** START OF THIS PROJECT GUTENBERG EBOOK ALICE'S ADVENTURES IN WONDERLAND ***Нижний колонтитул — весь текст после строки текста, которая говорит:

THE ENDВы должны остаться с текстовым файлом, который содержит около 3330 строк текста.

Нужна помощь с LSTM для прогнозирования последовательности?

Пройдите мой бесплатный 7-дневный курс по электронной почте и откройте для себя 6 различных архитектур LSTM (с кодом).

Нажмите, чтобы зарегистрироваться, а также получите бесплатную PDF-версию курса Ebook.

Начни свой БЕСПЛАТНЫЙ мини-курс сейчас!

Разработка малой рекуррентной нейронной сети LSTM

В этом разделе мы разработаем простую сеть LSTM для изучения последовательностей персонажей Алисы в стране чудес. В следующем разделе мы будем использовать эту модель для генерации новых последовательностей символов.

Давайте начнем с импорта классов и функций, которые мы намереваемся использовать для обучения нашей модели.

import numpy

from keras.models import Sequential

from keras.layers import Dense

from keras.layers import Dropout

from keras.layers import LSTM

from keras.callbacks import ModelCheckpoint

from keras.utils import np_utilsЗатем нам нужно загрузить текст ASCII для книги в память и преобразовать все символы в нижний регистр, чтобы уменьшить словарный запас, который должна выучить сеть.

# load ascii text and covert to lowercase

filename = "wonderland.txt"

raw_text = open(filename).read()

raw_text = raw_text.lower()Теперь, когда книга загружена, мы должны подготовить данные для моделирования нейронной сетью. Мы не можем моделировать символы напрямую, вместо этого мы должны преобразовать символы в целые числа.

Мы можем сделать это легко, сначала создав набор всех отдельных символов в книге, а затем создав карту каждого символа с уникальным целым числом.

# create mapping of unique chars to integers

chars = sorted(list(set(raw_text)))

char_to_int = dict((c, i) for i, c in enumerate(chars))Например, список уникальных отсортированных строчных символов в книге выглядит следующим образом:

['n', 'r', ' ', '!', '"', "'", '(', ')', '*', ',', '-', '.', ':', ';', '?', '[', ']', '_', 'a', 'b', 'c', 'd', 'e', 'f', 'g', 'h', 'i', 'j', 'k', 'l', 'm', 'n', 'o', 'p', 'q', 'r', 's', 't', 'u', 'v', 'w', 'x', 'y', 'z', 'xbb', 'xbf', 'xef']Вы можете видеть, что могут быть некоторые символы, которые мы могли бы удалить для дальнейшей очистки набора данных, что уменьшит словарный запас и может улучшить процесс моделирования.

Теперь, когда книга загружена и карта подготовлена, мы можем суммировать набор данных.

n_chars = len(raw_text)

n_vocab = len(chars)

print "Total Characters: ", n_chars

print "Total Vocab: ", n_vocabЗапуск кода до этой точки приводит к следующему выводу.

Total Characters: 147674

Total Vocab: 47Мы видим, что книга содержит менее 150000 символов и что при преобразовании в строчные буквы в словаре есть только 47 различных символов для изучения сетью. Гораздо больше, чем 26 в алфавите.

Теперь нам нужно определить данные обучения для сети Существует большая гибкость в том, как вы решаете разбивать текст и выставлять его в сети во время обучения.

В этом уроке мы разделим текст книги на подпоследовательности с фиксированной длиной в 100 символов произвольной длины. Мы могли бы так же легко разделить данные по предложениям, дополнить более короткие последовательности и укоротить более длинные.

Каждый обучающий шаблон сети состоит из 100 временных шагов одного символа (X), за которыми следует один символьный вывод (y). При создании этих последовательностей мы перемещаем это окно по всей книге по одному символу за раз, позволяя каждому персонажу выучить шанс из 100 предшествующих ему символов (кроме, конечно, первых 100 символов).

Например, если длина последовательности равна 5 (для простоты), то первые два шаблона обучения будут следующими:

CHAPT -> E

HAPTE -> RРазделяя книгу на эти последовательности, мы конвертируем символы в целые числа, используя нашу таблицу поиска, которую мы подготовили ранее.

# prepare the dataset of input to output pairs encoded as integers

seq_length = 100

dataX = []

dataY = []

for i in range(0, n_chars - seq_length, 1):

seq_in = raw_text[i:i + seq_length]

seq_out = raw_text[i + seq_length]

dataX.append([char_to_int[char] for char in seq_in])

dataY.append(char_to_int[seq_out])

n_patterns = len(dataX)

print "Total Patterns: ", n_patternsВыполнение кода к этому моменту показывает нам, что когда мы разбили набор данных на тренировочные данные для сети, чтобы узнать, что у нас чуть менее 150 000 обучающих патентов. Это имеет смысл, поскольку исключая первые 100 символов, у нас есть один тренировочный шаблон для прогнозирования каждого из оставшихся символов.

Total Patterns: 147574Теперь, когда мы подготовили наши тренировочные данные, нам нужно преобразовать их так, чтобы они подходили для использования с Keras.

Сначала мы должны преобразовать список входных последовательностей в форму[образцы, временные шаги, особенности]ожидается сетью LSTM.

Затем нам нужно изменить масштаб целых чисел в диапазоне от 0 до 1, чтобы облегчить изучение шаблонов сетью LSTM, которая по умолчанию использует функцию активации сигмовидной кишки.

Наконец, нам нужно преобразовать выходные шаблоны (отдельные символы, преобразованные в целые числа) в одну горячую кодировку. Это сделано для того, чтобы мы могли настроить сеть так, чтобы она предсказывала вероятность каждого из 47 различных символов в словаре (более простое представление), а не пыталась заставить ее предсказать точно следующий символ. Каждое значение y преобразуется в разреженный вектор длиной 47, полный нулей, за исключением 1 в столбце для буквы (целое число), которую представляет шаблон.

Например, когда «n» (целочисленное значение 31) является горячим кодированием, оно выглядит следующим образом:

[ 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0.

0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 1. 0. 0. 0. 0.

0. 0. 0. 0. 0. 0. 0. 0.]Мы можем реализовать эти шаги, как показано ниже.

# reshape X to be [samples, time steps, features]

X = numpy.reshape(dataX, (n_patterns, seq_length, 1))

# normalize

X = X / float(n_vocab)

# one hot encode the output variable

y = np_utils.to_categorical(dataY)Теперь мы можем определить нашу модель LSTM. Здесь мы определяем один скрытый слой LSTM с 256 единицами памяти. Сеть использует выпадение с вероятностью 20. Выходной уровень — это Плотный уровень, использующий функцию активации softmax для вывода прогнозирования вероятности для каждого из 47 символов в диапазоне от 0 до 1.

Эта проблема на самом деле представляет собой проблему классификации отдельных символов с 47 классами, и поэтому она определяется как оптимизация потерь в журнале (перекрестная энтропия) с использованием алгоритма оптимизации ADAM по скорости.

# define the LSTM model

model = Sequential()

model.add(LSTM(256, input_shape=(X.shape[1], X.shape[2])))

model.add(Dropout(0.2))

model.add(Dense(y.shape[1], activation='softmax'))

model.compile(loss='categorical_crossentropy', optimizer='adam')Тестового набора данных нет. Мы моделируем весь обучающий набор данных, чтобы узнать вероятность каждого персонажа в последовательности.

Нас не интересует наиболее точная (точность классификации) модель учебного набора данных. Это будет модель, которая идеально предсказывает каждого персонажа в наборе обучающих данных. Вместо этого мы заинтересованы в обобщении набора данных, который минимизирует выбранную функцию потерь. Мы ищем баланс между обобщением и переоснащением, но без запоминания.

Сеть работает медленно (около 300 секунд на эпоху на графическом процессоре Nvidia K520). Из-за медлительности и из-за наших требований по оптимизации мы будем использовать контрольные точки модели для записи всех сетевых весов, чтобы каждый раз регистрировать улучшение потерь в конце эпохи. Мы будем использовать лучший набор весов (наименьшая потеря), чтобы реализовать нашу генеративную модель в следующем разделе.

# define the checkpoint

filepath="weights-improvement-{epoch:02d}-{loss:.4f}.hdf5"

checkpoint = ModelCheckpoint(filepath, monitor='loss', verbose=1, save_best_only=True, mode='min')

callbacks_list = [checkpoint]Теперь мы можем приспособить нашу модель к данным. Здесь мы используем скромное количество из 20 эпох и большой размер пакета из 128 шаблонов.

model.fit(X, y, epochs=20, batch_size=128, callbacks=callbacks_list)Полный список кодов приведен ниже для полноты.

# Small LSTM Network to Generate Text for Alice in Wonderland

import numpy

from keras.models import Sequential

from keras.layers import Dense

from keras.layers import Dropout

from keras.layers import LSTM

from keras.callbacks import ModelCheckpoint

from keras.utils import np_utils

# load ascii text and covert to lowercase

filename = "wonderland.txt"

raw_text = open(filename).read()

raw_text = raw_text.lower()

# create mapping of unique chars to integers

chars = sorted(list(set(raw_text)))

char_to_int = dict((c, i) for i, c in enumerate(chars))

# summarize the loaded data

n_chars = len(raw_text)

n_vocab = len(chars)

print "Total Characters: ", n_chars

print "Total Vocab: ", n_vocab

# prepare the dataset of input to output pairs encoded as integers

seq_length = 100

dataX = []

dataY = []

for i in range(0, n_chars - seq_length, 1):

seq_in = raw_text[i:i + seq_length]

seq_out = raw_text[i + seq_length]

dataX.append([char_to_int[char] for char in seq_in])

dataY.append(char_to_int[seq_out])

n_patterns = len(dataX)

print "Total Patterns: ", n_patterns

# reshape X to be [samples, time steps, features]

X = numpy.reshape(dataX, (n_patterns, seq_length, 1))

# normalize

X = X / float(n_vocab)

# one hot encode the output variable

y = np_utils.to_categorical(dataY)

# define the LSTM model

model = Sequential()

model.add(LSTM(256, input_shape=(X.shape[1], X.shape[2])))

model.add(Dropout(0.2))

model.add(Dense(y.shape[1], activation='softmax'))

model.compile(loss='categorical_crossentropy', optimizer='adam')

# define the checkpoint

filepath="weights-improvement-{epoch:02d}-{loss:.4f}.hdf5"

checkpoint = ModelCheckpoint(filepath, monitor='loss', verbose=1, save_best_only=True, mode='min')

callbacks_list = [checkpoint]

# fit the model

model.fit(X, y, epochs=20, batch_size=128, callbacks=callbacks_list)Вы увидите разные результаты из-за стохастической природы модели и из-за того, что трудно исправить случайное начальное число для моделей LSTM, чтобы получить 100% воспроизводимые результаты. Это не касается этой генеративной модели.

После запуска примера у вас должно быть несколько файлов контрольных точек веса в локальном каталоге.

Вы можете удалить их все, кроме одного с наименьшим значением потери. Например, когда я запускал этот пример, ниже был контрольный пункт с наименьшей потерей, которую я достиг.

weights-improvement-19-1.9435.hdf5Потери в сети уменьшались почти каждую эпоху, и я ожидаю, что сеть может извлечь выгоду из обучения для многих других эпох.

В следующем разделе мы рассмотрим использование этой модели для генерации новых текстовых последовательностей.

Генерация текста с помощью сети LSTM

Генерация текста с использованием обученной сети LSTM относительно проста.

Во-первых, мы загружаем данные и определяем сеть точно таким же образом, за исключением того, что веса сети загружаются из файла контрольных точек, и сеть не нуждается в обучении.

# load the network weights

filename = "weights-improvement-19-1.9435.hdf5"

model.load_weights(filename)

model.compile(loss='categorical_crossentropy', optimizer='adam')Кроме того, при подготовке сопоставления уникальных символов с целыми числами мы также должны создать обратное отображение, которое мы можем использовать для преобразования целых чисел обратно в символы, чтобы мы могли понять предсказания.

int_to_char = dict((i, c) for i, c in enumerate(chars))Наконец, нам нужно делать прогнозы.

Простейший способ использования модели Keras LSTM для прогнозирования — сначала начать с последовательности начальных чисел в качестве входных данных, сгенерировать следующий символ, затем обновить последовательность начальных чисел, чтобы добавить сгенерированный символ в конце, и обрезать первый символ. Этот процесс повторяется до тех пор, пока мы хотим предсказать новые символы (например, последовательность длиной 1000 символов).

Мы можем выбрать случайный шаблон ввода в качестве нашей начальной последовательности, а затем распечатать сгенерированные символы по мере их генерации.

# pick a random seed

start = numpy.random.randint(0, len(dataX)-1)

pattern = dataX[start]

print "Seed:"

print """, ''.join([int_to_char[value] for value in pattern]), """

# generate characters

for i in range(1000):

x = numpy.reshape(pattern, (1, len(pattern), 1))

x = x / float(n_vocab)

prediction = model.predict(x, verbose=0)

index = numpy.argmax(prediction)

result = int_to_char[index]

seq_in = [int_to_char[value] for value in pattern]

sys.stdout.write(result)

pattern.append(index)

pattern = pattern[1:len(pattern)]

print "nDone."Полный пример кода для генерации текста с использованием загруженной модели LSTM приведен ниже для полноты.

# Load LSTM network and generate text

import sys

import numpy

from keras.models import Sequential

from keras.layers import Dense

from keras.layers import Dropout

from keras.layers import LSTM

from keras.callbacks import ModelCheckpoint

from keras.utils import np_utils

# load ascii text and covert to lowercase

filename = "wonderland.txt"

raw_text = open(filename).read()

raw_text = raw_text.lower()

# create mapping of unique chars to integers, and a reverse mapping

chars = sorted(list(set(raw_text)))

char_to_int = dict((c, i) for i, c in enumerate(chars))

int_to_char = dict((i, c) for i, c in enumerate(chars))

# summarize the loaded data

n_chars = len(raw_text)

n_vocab = len(chars)

print "Total Characters: ", n_chars

print "Total Vocab: ", n_vocab

# prepare the dataset of input to output pairs encoded as integers

seq_length = 100

dataX = []

dataY = []

for i in range(0, n_chars - seq_length, 1):

seq_in = raw_text[i:i + seq_length]

seq_out = raw_text[i + seq_length]

dataX.append([char_to_int[char] for char in seq_in])

dataY.append(char_to_int[seq_out])

n_patterns = len(dataX)

print "Total Patterns: ", n_patterns

# reshape X to be [samples, time steps, features]

X = numpy.reshape(dataX, (n_patterns, seq_length, 1))

# normalize

X = X / float(n_vocab)

# one hot encode the output variable

y = np_utils.to_categorical(dataY)

# define the LSTM model

model = Sequential()

model.add(LSTM(256, input_shape=(X.shape[1], X.shape[2])))

model.add(Dropout(0.2))

model.add(Dense(y.shape[1], activation='softmax'))

# load the network weights

filename = "weights-improvement-19-1.9435.hdf5"

model.load_weights(filename)

model.compile(loss='categorical_crossentropy', optimizer='adam')

# pick a random seed

start = numpy.random.randint(0, len(dataX)-1)

pattern = dataX[start]

print "Seed:"

print """, ''.join([int_to_char[value] for value in pattern]), """

# generate characters

for i in range(1000):

x = numpy.reshape(pattern, (1, len(pattern), 1))

x = x / float(n_vocab)

prediction = model.predict(x, verbose=0)

index = numpy.argmax(prediction)

result = int_to_char[index]

seq_in = [int_to_char[value] for value in pattern]

sys.stdout.write(result)

pattern.append(index)

pattern = pattern[1:len(pattern)]

print "nDone."При выполнении этого примера сначала выводится выбранное случайное начальное число, а затем каждый символ по мере его создания.

Например, ниже приведены результаты одного запуска этого текстового генератора. Случайное семя было:

be no mistake about it: it was neither more nor less than a pig, and she

felt that it would be quitСгенерированный текст со случайным начальным числом (очищенный для представления) был:

be no mistake about it: it was neither more nor less than a pig, and she

felt that it would be quit e aelin that she was a little want oe toiet

ano a grtpersent to the tas a little war th tee the tase oa teettee

the had been tinhgtt a little toiee at the cadl in a long tuiee aedun

thet sheer was a little tare gereen to be a gentle of the tabdit soenee

the gad ouw ie the tay a tirt of toiet at the was a little

anonersen, and thiu had been woite io a lott of tueh a tiie and taede

bot her aeain she cere thth the bene tith the tere bane to tee

toaete to tee the harter was a little tire the same oare cade an anl ano

the garee and the was so seat the was a little gareen and the sabdit,

and the white rabbit wese tilel an the caoe and the sabbit se teeteer,

and the white rabbit wese tilel an the cade in a lonk tfne the sabdi

ano aroing to tea the was sf teet whitg the was a little tane oo thete

the sabeit she was a little tartig to the tar tf tee the tame of the

cagd, and the white rabbit was a little toiee to be anle tite thete ofs

and the tabdit was the wiite rabbit, andМожно отметить некоторые замечания по поводу сгенерированного текста.

- Как правило, он соответствует формату строки, наблюдаемому в исходном тексте длиной менее 80 символов перед новой строкой.

- Символы разделены на словесные группы, и большинство групп представляют собой настоящие английские слова (например, «the», «little» и «was»), но многие этого не делают (например, «lott», «tiie» и «taede»).

- Некоторые слова в последовательности имеют смысл (например, «и белый кролик«», Но многие этого не делают (например, «Wese Tilel«).

Тот факт, что эта модель книги, основанная на персонажах, дает такой результат, очень впечатляет. Это дает вам представление о возможностях обучения сетей LSTM.

Результаты не идеальны. В следующем разделе мы рассмотрим улучшение качества результатов за счет развития гораздо большей сети LSTM.

Большая LSTM Рекуррентная Нейронная Сеть

Мы получили результаты, но не отличные результаты в предыдущем разделе. Теперь мы можем попытаться улучшить качество сгенерированного текста, создав гораздо большую сеть.

Мы оставим количество блоков памяти равным 256, но добавим второй слой.

model = Sequential()

model.add(LSTM(256, input_shape=(X.shape[1], X.shape[2]), return_sequences=True))

model.add(Dropout(0.2))

model.add(LSTM(256))

model.add(Dropout(0.2))

model.add(Dense(y.shape[1], activation='softmax'))

model.compile(loss='categorical_crossentropy', optimizer='adam')Мы также изменим имя файла весов контрольных точек, чтобы мы могли определить разницу между весами этой сети и предыдущей (добавив слово «больше» в имени файла).

filepath="weights-improvement-{epoch:02d}-{loss:.4f}-bigger.hdf5"Наконец, мы увеличим количество обучающих эпох с 20 до 50 и уменьшим размер пакета со 128 до 64, чтобы дать сети больше возможностей для обновления и обучения.

Полный список кодов представлен ниже для полноты.

# Larger LSTM Network to Generate Text for Alice in Wonderland

import numpy

from keras.models import Sequential

from keras.layers import Dense

from keras.layers import Dropout

from keras.layers import LSTM

from keras.callbacks import ModelCheckpoint

from keras.utils import np_utils

# load ascii text and covert to lowercase

filename = "wonderland.txt"

raw_text = open(filename).read()

raw_text = raw_text.lower()

# create mapping of unique chars to integers

chars = sorted(list(set(raw_text)))

char_to_int = dict((c, i) for i, c in enumerate(chars))

# summarize the loaded data

n_chars = len(raw_text)

n_vocab = len(chars)

print "Total Characters: ", n_chars

print "Total Vocab: ", n_vocab

# prepare the dataset of input to output pairs encoded as integers

seq_length = 100

dataX = []

dataY = []

for i in range(0, n_chars - seq_length, 1):

seq_in = raw_text[i:i + seq_length]

seq_out = raw_text[i + seq_length]

dataX.append([char_to_int[char] for char in seq_in])

dataY.append(char_to_int[seq_out])

n_patterns = len(dataX)

print "Total Patterns: ", n_patterns

# reshape X to be [samples, time steps, features]

X = numpy.reshape(dataX, (n_patterns, seq_length, 1))

# normalize

X = X / float(n_vocab)

# one hot encode the output variable

y = np_utils.to_categorical(dataY)

# define the LSTM model

model = Sequential()

model.add(LSTM(256, input_shape=(X.shape[1], X.shape[2]), return_sequences=True))

model.add(Dropout(0.2))

model.add(LSTM(256))

model.add(Dropout(0.2))

model.add(Dense(y.shape[1], activation='softmax'))

model.compile(loss='categorical_crossentropy', optimizer='adam')

# define the checkpoint

filepath="weights-improvement-{epoch:02d}-{loss:.4f}-bigger.hdf5"

checkpoint = ModelCheckpoint(filepath, monitor='loss', verbose=1, save_best_only=True, mode='min')

callbacks_list = [checkpoint]

# fit the model

model.fit(X, y, epochs=50, batch_size=64, callbacks=callbacks_list)Выполнение этого примера занимает некоторое время, по меньшей мере, 700 секунд на эпоху.

После запуска этого примера вы можете потерять около 1,2. Например, лучший результат, которого я достиг от запуска этой модели, был сохранен в файле контрольных точек с именем:

weights-improvement-47-1.2219-bigger.hdf5Достижение потери 1.2219 в эпоху 47.

Как и в предыдущем разделе, мы можем использовать эту лучшую модель из прогона для генерации текста.

Единственное изменение, которое мы должны внести в скрипт генерации текста из предыдущего раздела, заключается в спецификации топологии сети и из какого файла нужно заполнить сетевые веса.

Полный список кодов приведен ниже для полноты.

# Load Larger LSTM network and generate text

import sys

import numpy

from keras.models import Sequential

from keras.layers import Dense

from keras.layers import Dropout

from keras.layers import LSTM

from keras.callbacks import ModelCheckpoint

from keras.utils import np_utils

# load ascii text and covert to lowercase

filename = "wonderland.txt"

raw_text = open(filename).read()

raw_text = raw_text.lower()

# create mapping of unique chars to integers, and a reverse mapping

chars = sorted(list(set(raw_text)))

char_to_int = dict((c, i) for i, c in enumerate(chars))

int_to_char = dict((i, c) for i, c in enumerate(chars))

# summarize the loaded data

n_chars = len(raw_text)

n_vocab = len(chars)

print "Total Characters: ", n_chars

print "Total Vocab: ", n_vocab

# prepare the dataset of input to output pairs encoded as integers

seq_length = 100

dataX = []

dataY = []

for i in range(0, n_chars - seq_length, 1):

seq_in = raw_text[i:i + seq_length]

seq_out = raw_text[i + seq_length]

dataX.append([char_to_int[char] for char in seq_in])

dataY.append(char_to_int[seq_out])

n_patterns = len(dataX)

print "Total Patterns: ", n_patterns

# reshape X to be [samples, time steps, features]

X = numpy.reshape(dataX, (n_patterns, seq_length, 1))

# normalize

X = X / float(n_vocab)

# one hot encode the output variable

y = np_utils.to_categorical(dataY)

# define the LSTM model

model = Sequential()

model.add(LSTM(256, input_shape=(X.shape[1], X.shape[2]), return_sequences=True))

model.add(Dropout(0.2))

model.add(LSTM(256))

model.add(Dropout(0.2))

model.add(Dense(y.shape[1], activation='softmax'))

# load the network weights

filename = "weights-improvement-47-1.2219-bigger.hdf5"

model.load_weights(filename)

model.compile(loss='categorical_crossentropy', optimizer='adam')

# pick a random seed

start = numpy.random.randint(0, len(dataX)-1)

pattern = dataX[start]

print "Seed:"

print """, ''.join([int_to_char[value] for value in pattern]), """

# generate characters

for i in range(1000):

x = numpy.reshape(pattern, (1, len(pattern), 1))

x = x / float(n_vocab)

prediction = model.predict(x, verbose=0)

index = numpy.argmax(prediction)

result = int_to_char[index]

seq_in = [int_to_char[value] for value in pattern]

sys.stdout.write(result)

pattern.append(index)

pattern = pattern[1:len(pattern)]

print "nDone."Один из примеров запуска этого сценария генерации текста приводит к выводу ниже.

Случайно выбранный начальный текст был:

d herself lying on the bank, with her

head in the lap of her sister, who was gently brushing away sСгенерированный текст с семенами (очищенный для представления) был:

herself lying on the bank, with her

head in the lap of her sister, who was gently brushing away

so siee, and she sabbit said to herself and the sabbit said to herself and the sood

way of the was a little that she was a little lad good to the garden,

and the sood of the mock turtle said to herself, 'it was a little that

the mock turtle said to see it said to sea it said to sea it say it

the marge hard sat hn a little that she was so sereated to herself, and

she sabbit said to herself, 'it was a little little shated of the sooe

of the coomouse it was a little lad good to the little gooder head. and

said to herself, 'it was a little little shated of the mouse of the

good of the courte, and it was a little little shated in a little that

the was a little little shated of the thmee said to see it was a little

book of the was a little that she was so sereated to hare a little the

began sitee of the was of the was a little that she was so seally and

the sabbit was a little lad good to the little gooder head of the gad

seared to see it was a little lad good to the little goodМы видим, что, как правило, ошибок орфографии меньше, и текст выглядит более реалистичным, но все же совершенно бессмысленным.

Например, одни и те же фразы повторяются снова и снова, как «сказала себе» а также «немного«. Котировки открыты, но не закрыты.

Это лучшие результаты, но есть еще много возможностей для улучшения.

10 идей расширения для улучшения модели

Ниже приведены 10 идей, которые могут еще больше улучшить модель, с которой вы можете поэкспериментировать:

- Прогнозировать менее 1000 символов в качестве вывода для данного семени.

- Удалите все знаки препинания из исходного текста и, следовательно, из словаря моделей.

- Попробуйте один горячий код для входных последовательностей.

- Тренируйте модель на дополненных предложениях, а не на случайных последовательностях символов.

- Увеличьте количество тренировочных эпох до 100 или многих сотен.

- Добавьте отсев к видимому входному слою и рассмотрите возможность настройки процента отсева.

- Настройте размер партии, попробуйте размер партии 1 в качестве (очень медленной) базовой линии и увеличьте размеры оттуда.

- Добавьте больше блоков памяти к слоям и / или нескольким слоям.

- Эксперимент с масштабными коэффициентами (температура) при интерпретации вероятностей прогноза.

- Измените слои LSTM на «сохраняющие состояние», чтобы поддерживать состояние между партиями

Вы пробовали какие-либо из этих расширений? Поделитесь своими результатами в комментариях.

Ресурсы

Эта модель текстового символа является популярным способом генерации текста с использованием рекуррентных нейронных сетей.

Ниже приведены дополнительные ресурсы и учебные материалы по этой теме, если вы заинтересованы в углублении. Пожалуй, самым популярным является учебник Андрея Карпати под названием « Необоснованная эффективность рекуррентных нейронных сетей «.

- Генерация текста с помощью рекуррентных нейронных сетей [pdf], 2011

- Пример кода Keras для LSTM для генерации текста,

- Пример кода лазаньи LSTM для генерации текста,

- Учебник по MXNet для использования LSTM для генерации текста,

- Автогенерация Clickbait с рекуррентными нейронными сетями,

Резюме

В этой статье вы узнали, как можно разработать рекуррентную нейронную сеть LSTM для генерации текста в Python с помощью библиотеки глубокого обучения Keras.

После прочтения этого поста вы знаете:

- Где бесплатно скачать текст ASCII для классических книг, который вы можете использовать для обучения.

- Как обучить сеть LSTM текстовым последовательностям и как использовать обученную сеть для генерации новых последовательностей.

- Как разрабатывать стекированные сети LSTM и повышать производительность модели.

У вас есть вопросы о генерации текста в сетях LSTM или об этом посте? Задайте свои вопросы в комментариях ниже, и я сделаю все возможное, чтобы ответить на них.

Генерация текста с помощью LSTM рекуррентных нейронных сетей в Python с Keras

Text Generation With LSTM Recurrent Neural Networks in Python with Keras

Recurrent neural networks can also be used as generative models.

This means that in addition to being used for predictive models (making predictions) they can learn the sequences of a problem and then generate entirely new plausible sequences for the problem domain.

Generative models like this are useful not only to study how well a model has learned a problem, but to learn more about the problem domain itself.

In this post you will discover how to create a generative model for text, character-by-character using LSTM recurrent neural networks in Python with Keras.

After reading this post you will know:

- Where to download a free corpus of text that you can use to train text generative models.

- How to frame the problem of text sequences to a recurrent neural network generative model.

- How to develop an LSTM to generate plausible text sequences for a given problem.

Let’s get started.

Note : LSTM recurrent neural networks can be slow to train and it is highly recommend that you train them on GPU hardware. You can access GPU hardware in the cloud very cheaply using Amazon Web Services, see the tutorial here .

- Update Oct/2016 : Fixed a few minor comment typos in the code.

- Update Mar/2017 : Updated example for Keras 2.0.2, TensorFlow 1.0.1 and Theano 0.9.0.

Problem Description: Project Gutenberg

Many of the classical texts are no longer protected under copyright.

This means that you can download all of the text for these books for free and use them in experiments, like creating generative models. Perhaps the best place to get access to free books that are no longer protected by copyright is Project Gutenberg .

In this tutorial we are going to use a favorite book from childhood as the dataset: Alice’s Adventures in Wonderland by Lewis Carroll .

We are going to learn the dependencies between characters and the conditional probabilities of characters in sequences so that we can in turn generate wholly new and original sequences of characters.

This is a lot of fun and I recommend repeating these experiments with other books from Project Gutenberg, here is a list of the most popular books on the site .

These experiments are not limited to text, you can also experiment with other ASCII data, such as computer source code, marked up documents in LaTeX, HTML or Markdown and more.

You can download the complete text in ASCII format (Plain Text UTF-8) for this book for free and place it in your working directory with the filename wonderland.txt .

Now we need to prepare the dataset ready for modeling.

Project Gutenberg adds a standard header and footer to each book and this is not part of the original text. Open the file in a text editor and delete the header and footer.

The header is obvious and ends with the text:

*** START OF THIS PROJECT GUTENBERG EBOOK ALICE'S ADVENTURES IN WONDERLAND ***

The footer is all of the text after the line of text that says:

You should be left with a text file that has about 3,330 lines of text.

Develop a Small LSTM Recurrent Neural Network

In this section we will develop a simple LSTM network to learn sequences of characters from Alice in Wonderland. In the next section we will use this model to generate new sequences of characters.

Let’s start off by importing the classes and functions we intend to use to train our model.

import numpy from keras.models import Sequential from keras.layers import Dense from keras.layers import Dropout from keras.layers import LSTM from keras.callbacks import ModelCheckpoint from keras.utils import np_utils

Next, we need to load the ASCII text for the book into memory and convert all of the characters to lowercase to reduce the vocabulary that the network must learn.

# load ascii text and covert to lowercase filename = "wonderland.txt" raw_text = open(filename).read() raw_text = raw_text.lower()

Now that the book is loaded, we must prepare the data for modeling by the neural network. We cannot model the characters directly, instead we must convert the characters to integers.

We can do this easily by first creating a set of all of the distinct characters in the book, then creating a map of each character to a unique integer.

# create mapping of unique chars to integers chars = sorted(list(set(raw_text))) char_to_int = dict((c, i) for i, c in enumerate(chars))

For example, the list of unique sorted lowercase characters in the book is as follows:

['n', 'r', ' ', '!', '"', "'", '(', ')', '*', ',', '-', '.', ':', ';', '?', '[', ']', '_', 'a', 'b', 'c', 'd', 'e', 'f', 'g', 'h', 'i', 'j', 'k', 'l', 'm', 'n', 'o', 'p', 'q', 'r', 's', 't', 'u', 'v', 'w', 'x', 'y', 'z', 'xbb', 'xbf', 'xef']

You can see that there may be some characters that we could remove to further clean up the dataset that will reduce the vocabulary and may improve the modeling process.

Now that the book has been loaded and the mapping prepared, we can summarize the dataset.

n_chars = len(raw_text) n_vocab = len(chars) print "Total Characters: ", n_chars print "Total Vocab: ", n_vocab

Running the code to this point produces the following output.

Total Characters: 147674

Total Vocab: 47

We can see that the book has just under 150,000 characters and that when converted to lowercase that there are only 47 distinct characters in the vocabulary for the network to learn. Much more than the 26 in the alphabet.

We now need to define the training data for the network. There is a lot of flexibility in how you choose to break up the text and expose it to the network during training.

In this tutorial we will split the book text up into subsequences with a fixed length of 100 characters, an arbitrary length. We could just as easily split the data up by sentences and pad the shorter sequences and truncate the longer ones.

Each training pattern of the network is comprised of 100 time steps of one character (X) followed by one character output (y). When creating these sequences, we slide this window along the whole book one character at a time, allowing each character a chance to be learned from the 100 characters that preceded it (except the first 100 characters of course).

For example, if the sequence length is 5 (for simplicity) then the first two training patterns would be as follows:

As we split up the book into these sequences, we convert the characters to integers using our lookup table we prepared earlier.

# prepare the dataset of input to output pairs encoded as integers seq_length = 100 dataX = [] dataY = [] for i in range(0, n_chars - seq_length, 1): seq_in = raw_text[i:i + seq_length] seq_out = raw_text[i + seq_length] dataX.append([char_to_int[char] for char in seq_in]) dataY.append(char_to_int[seq_out]) n_patterns = len(dataX) print "Total Patterns: ", n_patterns

Running the code to this point shows us that when we split up the dataset into training data for the network to learn that we have just under 150,000 training pattens. This makes sense as excluding the first 100 characters, we have one training pattern to predict each of the remaining characters.

Now that we have prepared our training data we need to transform it so that it is suitable for use with Keras.

First we must transform the list of input sequences into the form [samples, time steps, features] expected by an LSTM network.

Next we need to rescale the integers to the range 0-to-1 to make the patterns easier to learn by the LSTM network that uses the sigmoid activation function by default.