В данной статье мы рассмотрим, что такое рекуррентные нейронные сети и как создать нейронную сеть с нуля в Python.

Содержание

- Зачем нужны рекуррентные нейронные сети

- Создание рекуррентной нейронной сети на примере

- Поставление задачи для рекуррентной нейронной сети

- Составление плана для нейронной сети

- Предварительная обработка рекуррентной нейронной сети RNN

- Фаза прямого распространения нейронной сети

- Фаза обратного распространения нейронной сети

- Параметры рассматриваемой нейронной сети

- Тестирование рекуррентной нейронной сети

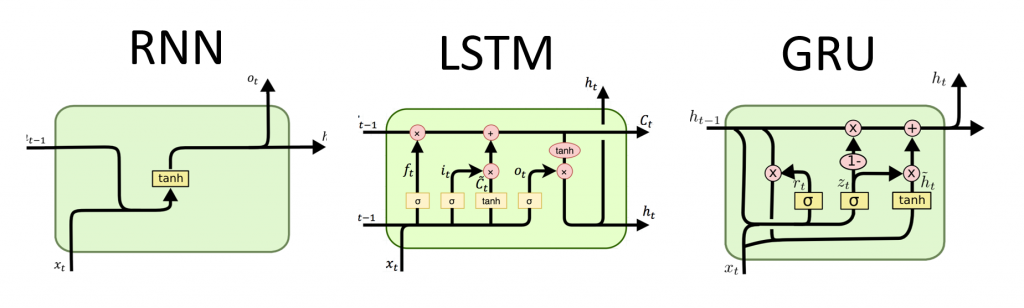

Рекуррентные нейронные сети (RNN) — это тип нейронных сетей, которые специализируются на обработке последовательностей. Зачастую их используют в таких задачах, как обработка естественного языка (Natural Language Processing) из-за их эффективности в анализе текста. В данной статье мы наглядно рассмотрим рекуррентные нейронные сети, поймем принцип их работы, а также создадим одну сеть в Python, используя numpy.

Данная статья подразумевает наличие у читателя базовых знаний о нейронных сетях. Будет не лишним прочитать от том как создать нейронную сеть в Python, в которой показаны простые примеры использования нейронов в Python.

Приступим!

Зачем нужны рекуррентные нейронные сети

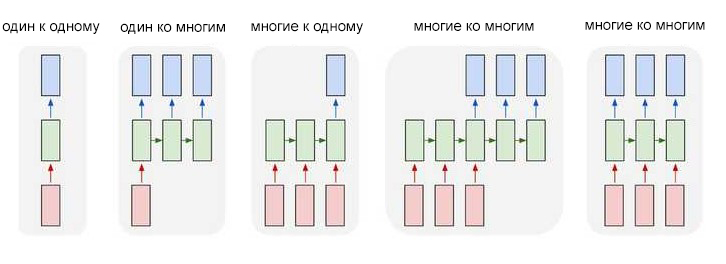

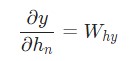

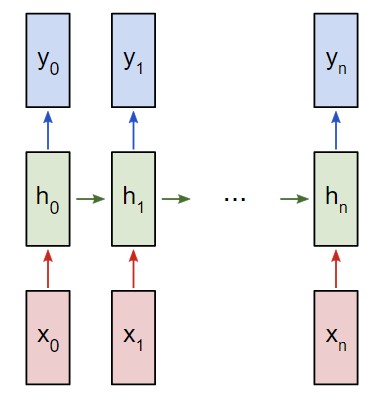

Один из нюансов работы с нейронными сетями (а также CNN) заключается в том, что они работают с предварительно заданными параметрами. Они принимают входные данные с фиксированными размерами и выводят результат, который также является фиксированным. Плюс рекуррентных нейронных сетей, или RNN, в том, что они обеспечивают последовательности с вариативными длинами как для входа, так и для вывода. Вот несколько примеров того, как может выглядеть рекуррентная нейронная сеть:

Входные данные отмечены красным, нейронная сеть RNN — зеленым, а вывод — синим.

Способность обрабатывать последовательности делает рекуррентные нейронные сети RNN весьма полезными. Области использования:

- Машинный перевод (пример Google Translate) выполняется при помощи нейронных сетей с принципом «многие ко многим». Оригинальная последовательность текста подается в рекуррентную нейронную сеть, которая затем создает переведенный текст в качестве результата вывода;

- Анализ настроений часто выполняется при помощи рекуррентных нейронных сетей с принципом «многие к одному». Этот отзыв положительный или отрицательный? Такая постановка является одним из примеров анализа настроений. Анализируемый текст подается нейронную сеть, которая затем создает единственную классификацию вывода. Например — Этот отзыв положительный.

Есть вопросы по Python?

На нашем форуме вы можете задать любой вопрос и получить ответ от всего нашего сообщества!

Telegram Чат & Канал

Вступите в наш дружный чат по Python и начните общение с единомышленниками! Станьте частью большого сообщества!

Паблик VK

Одно из самых больших сообществ по Python в социальной сети ВК. Видео уроки и книги для вас!

Далее в статье будет показан пример создания рекуррентной нейронной сети по схеме «многие к одному» для анализа настроений.

Создание рекуррентной нейронной сети на примере

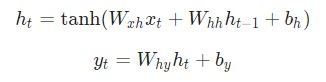

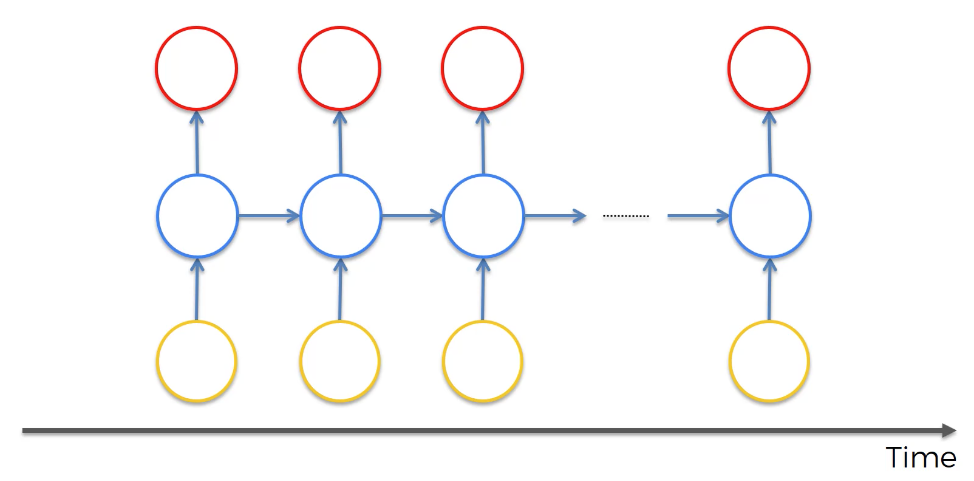

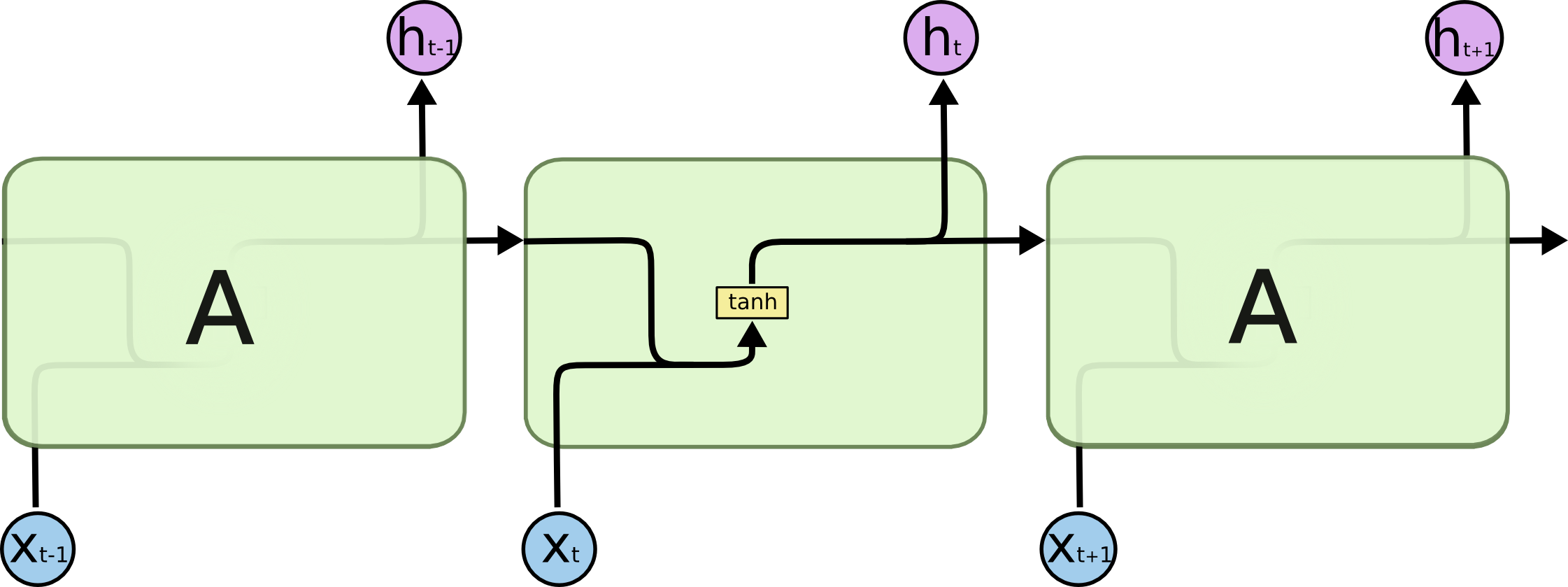

Представим, что у нас есть нейронная сеть, которая работает по принципу «многое ко многим«. Входные данные — x0, х1, … xn, а результаты вывода — y0, y1, … yn. Данные xi и yi являются векторами и могут быть произвольных размеров.

Рекуррентные нейронные сети RNN работают путем итерированного обновления скрытого состояния h, которое является вектором, что также может иметь произвольный размер. Стоит учитывать, что на любом заданном этапе t:

- Следующее скрытое состояние

htподсчитывается при помощи предыдущегоht - 1и следующим вводомxt; - Следующий вывод

ytподсчитывается при помощиht.

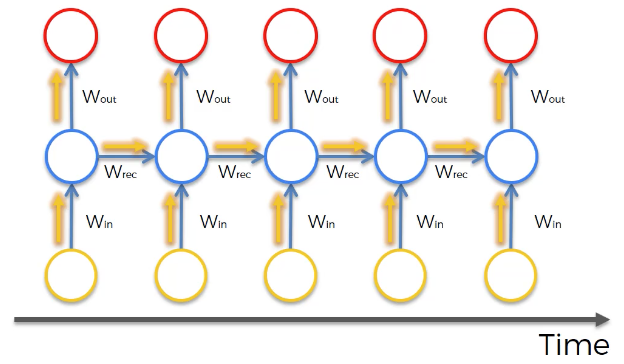

Вот что делает нейронную сеть рекуррентной: на каждом шаге она использует один и тот же вес. Говоря точнее, типичная классическая рекуррентная нейронная сеть использует только три набора параметров веса для выполнения требуемых подсчетов:

Wxhиспользуется для всех связокxt → htWhhиспользуется для всех связокht-1 → htWhyиспользуется для всех связокht → yt

Для рекуррентной нейронной сети мы также используем два смещения:

bhдобавляется при подсчетеhtbyдобавляется при подсчетеyt

Вес будет представлен как матрица, а смещение как вектор. В данном случае рекуррентная нейронная сеть состоит их трех параметров веса и двух смещений.

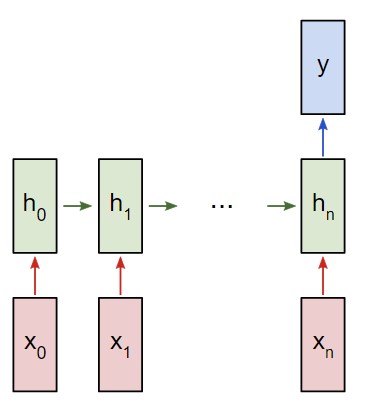

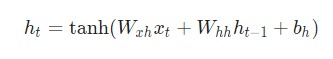

Следующие уравнения являются компактным представлением всего вышесказанного:

Разбор уравнений лучше не пропускать. Остановитесь на минутку и изучите их внимательно. Помните, что вес — это матрица, а другие переменные являются векторами.

Говоря о весе, мы используем матричное умножение, после чего векторы вносятся в конечный результат. Затем применяется гиперболическая функция в качестве функции активации первого уравнения. Стоит иметь в виду, что другие методы активации, например, сигмоиду, также можно использовать.

Не знаете, что такое функция активации? Вы можете ознакомиться с ними в вводной статье о нейронных сетях. Для оптимальной работы это важно.

Поставление задачи для рекуррентной нейронной сети

К текущему моменту мы смогли реализовать рекуррентную нейронную сеть RNN с нуля. Она должна выполнить простой анализ настроения. В дальнейшем примере мы попросим сеть определить, будет заданная строка нести позитивный или негативный характер.

Вот несколько примеров из небольшого набора данных, который был собран для данной статьи:

| Текст | Позитивный? |

| Я хороший | Да |

| Я плохой | Нет |

| Это очень хорошо | Да |

| Это неплохо | Да |

| Я плохой, а не хороший | Нет |

| Я несчастен | Нет |

| Это было хорошо | Да |

| Я чувствую себя неплохо, мне не грустно | Да |

Составление плана для нейронной сети

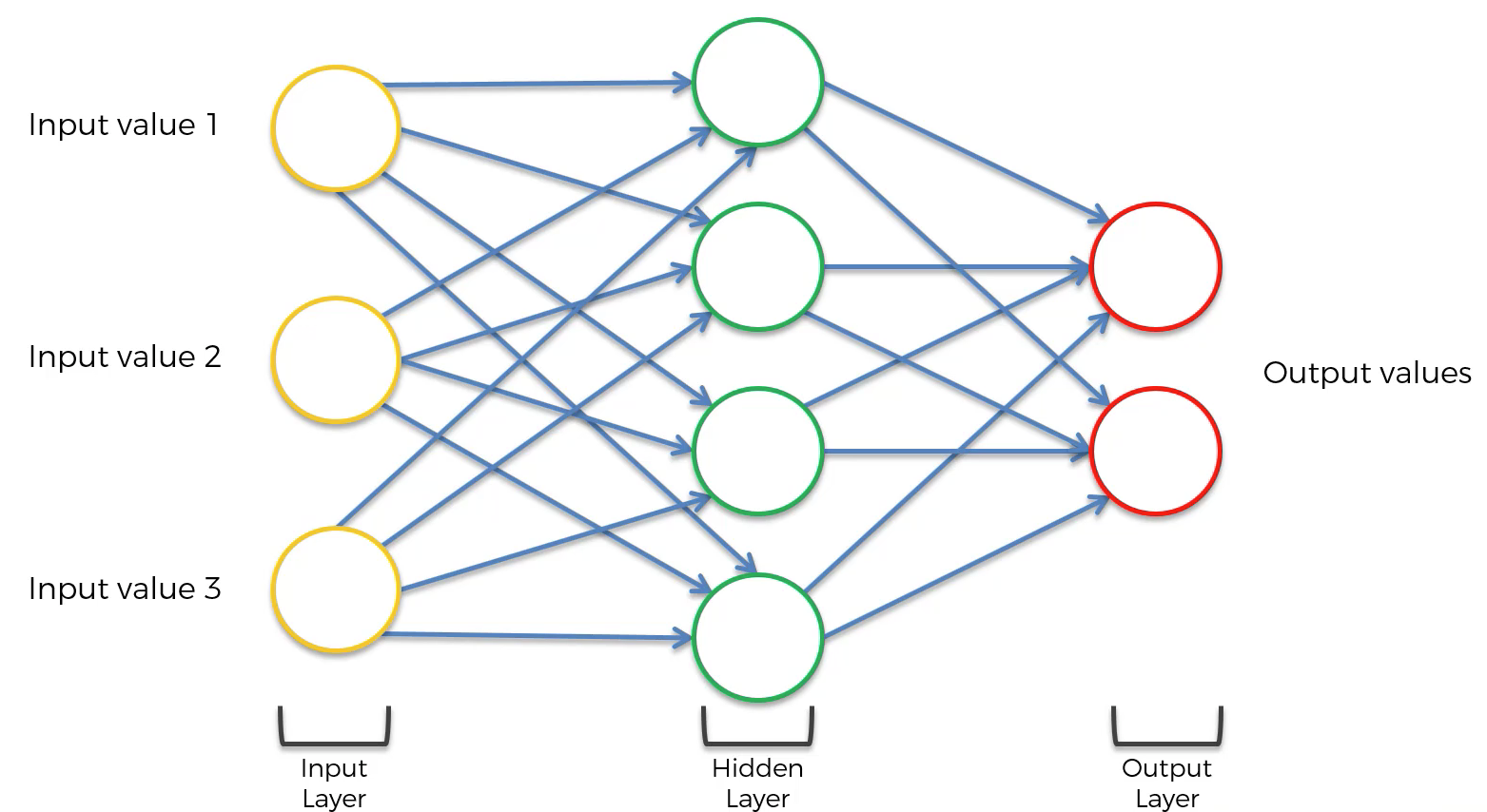

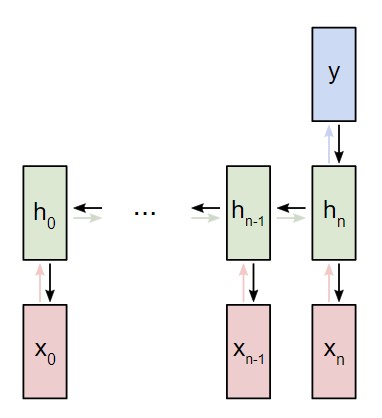

В следующем примере будет использована классификация рекуррентной сети «многие к одному». Принцип ее использования напоминает работу схемы «многие ко многим», что была описана ранее. Однако на этот раз будет задействовано только скрытое состояние для одного пункта вывода y:

Рекуррентная нейронная сеть RNN многие к одному

Каждый xi будет вектором, представляющим определенное слово из текста. Вывод y будет вектором, содержащим два числа. Одно представляет позитивное настроение, а второе — негативное. Мы используем функцию Softmax, чтобы превратить эти значения в вероятности, и в конечном счете выберем между позитивным и негативным.

Приступим к созданию нашей рекуррентной нейронной сети.

Предварительная обработка рекуррентной нейронной сети RNN

Упомянутый ранее набор данных состоит из двух словарей Python:

|

train_data = { ‘good’: True, ‘bad’: False, # … больше данных } test_data = { ‘this is happy’: True, ‘i am good’: True, # … больше данных } |

True = Позитивное, False = Негативное

Для получения данных в удобном формате потребуется сделать определенную предварительную обработку. Для начала необходимо создать словарь в Python из всех слов, которые употребляются в наборе данных:

|

from data import train_data, test_data # Создание словаря vocab = list(set([w for text in train_data.keys() for w in text.split(‘ ‘)])) vocab_size = len(vocab) print(‘%d unique words found’ % vocab_size) # найдено 18 уникальных слов |

vocab теперь содержит список всех слов, которые употребляются как минимум в одном учебном тексте. Далее присвоим каждому слову из vocab индекс типа integer (целое число).

|

# Назначить индекс каждому слову word_to_idx = { w: i for i, w in enumerate(vocab) } idx_to_word = { i: w for i, w in enumerate(vocab) } print(word_to_idx[‘good’]) # 16 (это может измениться) print(idx_to_word[0]) # грустно (это может измениться) |

Теперь можно отобразить любое заданное слово при помощи индекса целого числа. Это очень важный пункт, так как:

Рекуррентная нейронная сеть не различает слов — только числа.

Напоследок напомним, что каждый ввод xi для рассматриваемой рекуррентной нейронной сети является вектором. Мы будем использовать веторы, которые представлены в виде унитарного кода. Единица в каждом векторе будет находиться в соответствующем целочисленном индексе слова.

Так как в словаре 18 уникальных слов, каждый xi будет 18-мерным унитарным вектором.

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 |

import numpy as np def createInputs(text): »’ Возвращает массив унитарных векторов которые представляют слова в введенной строке текста — текст является строкой string — унитарный вектор имеет форму (vocab_size, 1) »’ inputs = [] for w in text.split(‘ ‘): v = np.zeros((vocab_size, 1)) v[word_to_idx[w]] = 1 inputs.append(v) return inputs |

Мы используем createInputs() позже для создания входных данных в виде векторов и последующей их передачи в рекуррентную нейронную сеть RNN.

Фаза прямого распространения нейронной сети

Пришло время для создания рекуррентной нейронной сети. Начнем инициализацию с тремя параметрами веса и двумя смещениями.

|

import numpy as np from numpy.random import randn class RNN: # Классическая рекуррентная нейронная сеть def __init__(self, input_size, output_size, hidden_size=64): # Вес self.Whh = randn(hidden_size, hidden_size) / 1000 self.Wxh = randn(hidden_size, input_size) / 1000 self.Why = randn(output_size, hidden_size) / 1000 # Смещения self.bh = np.zeros((hidden_size, 1)) self.by = np.zeros((output_size, 1)) |

Обратите внимание: для того, чтобы убрать внутреннюю вариативность весов, мы делим на 1000. Это не самый лучший способ инициализации весов, но он довольно простой, подойдет для новичков и неплохо работает для данного примера.

Для инициализации веса из стандартного нормального распределения мы используем np.random.randn().

Затем мы реализуем прямую передачу рассматриваемой нейронной сети. Помните первые два уравнения, рассматриваемые ранее?

Эти же уравнения, реализованные в коде:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 |

class RNN: # … def forward(self, inputs): »’ Выполнение передачи нейронной сети при помощи входных данных Возвращение результатов вывода и скрытого состояния Вывод — это массив одного унитарного вектора с формой (input_size, 1) »’ h = np.zeros((self.Whh.shape[0], 1)) # Выполнение каждого шага в нейронной сети RNN for i, x in enumerate(inputs): h = np.tanh(self.Wxh @ x + self.Whh @ h + self.bh) # Compute the output y = self.Why @ h + self.by return y, h |

Довольно просто, не так ли? Обратите внимание на то, что мы инициализировали h для нулевого вектора в первом шаге, так как у нас нет предыдущего h, который теперь можно использовать.

Давайте попробуем следующее:

|

# … def softmax(xs): # Применение функции Softmax для входного массива return np.exp(xs) / sum(np.exp(xs)) # Инициализация нашей рекуррентной нейронной сети RNN rnn = RNN(vocab_size, 2) inputs = createInputs(‘i am very good’) out, h = rnn.forward(inputs) probs = softmax(out) print(probs) # [[0.50000095], [0.49999905]] |

Наша рекуррентная нейронная сеть работает, однако ее с трудом можно назвать полезной. Давайте исправим этот недочет.

Фаза обратного распространения нейронной сети

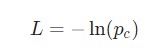

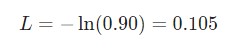

Для тренировки рекуррентной нейронной сети будет использована функция потери. Здесь будет использована потеря перекрестной энтропии, которая в большинстве случаев совместима с функцией Softmax. Формула для подсчета:

Здесь pc является предсказуемой вероятностью рекуррентной нейронной сети для класса correct (позитивный или негативный). Например, если позитивный текст предсказывается рекуррентной нейронной сетью как позитивный текст на 90%, то потеря составит:

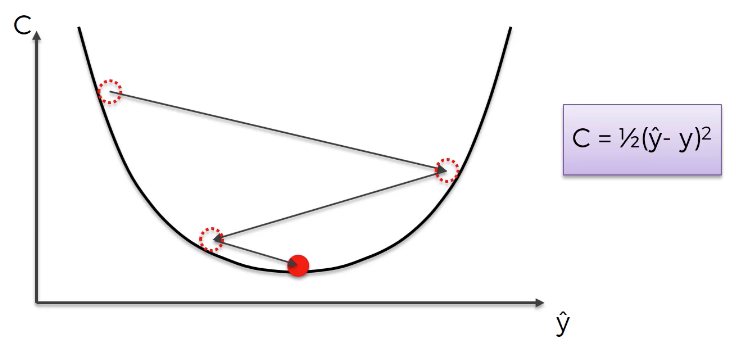

При наличии параметров потери можно натренировать нейронную сеть таким образом, чтобы она использовала градиентный спуск для минимизации потерь. Следовательно, здесь понадобятся градиенты.

Обратите внимание: следующий раздел подразумевает наличие у читателя базовых знаний об многовариантном исчислении. Вы можете пропустить несколько абзацев, однако мы рекомендуем все пробежаться по ним глазами. По мере получения новых данных код будет дополняться, и объяснения станут понятнее.

Оригиналы всех кодов, которые использованы в данной инструкции, доступны на GitHub.

Готовы? Продолжим!

Параметры рассматриваемой нейронной сети

Параметры данных, которые будут использованы в дальнейшем:

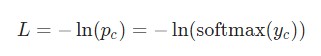

y— необработанные входные данные нейронной сети;р— конечная вероятность:р = softmax(y);с— истинная метка определенного образца текста, так называемый «правильный» класс;L— потеря перекрестной энтропии:L = -ln(pc);Wxh,WhhиWhy— три матрицы веса в рассматриваемой нейронной сети;bhиby— два вектора смещения в рассматриваемой рекуррентной нейронной сети RNN.

Установка

Следующим шагом будет настройка фазы прямого распространения. Это необходимо для кеширования отдельных данных, которые будут использоваться в фазе обратного распространения нейронной сети. Параллельно с этим можно будет установить основной скелет для фазы обратного распространения. Это будет выглядеть следующим образом:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 |

class RNN: # … def forward(self, inputs): »’ Выполнение фазы прямого распространения нейронной сети с использованием введенных данных. Возврат итоговой выдачи и скрытого состояния. — Входные данные в массиве однозначного вектора с формой (input_size, 1). »’ h = np.zeros((self.Whh.shape[0], 1)) self.last_inputs = inputs self.last_hs = { 0: h } # Выполнение каждого шага нейронной сети RNN for i, x in enumerate(inputs): h = np.tanh(self.Wxh @ x + self.Whh @ h + self.bh) self.last_hs[i + 1] = h # Подсчет вывода y = self.Why @ h + self.by return y, h def backprop(self, d_y, learn_rate=2e—2): »’ Выполнение фазы обратного распространения нейронной сети RNN. — d_y (dL/dy) имеет форму (output_size, 1). — learn_rate является вещественным числом float. »’ pass |

Градиенты

Настало время математики! Начнем с вычисления . Что нам известно:

Здесь используется фактическое значение , а также применяется дифференцирование сложной функции. Результат следующий:

К примеру, если p = [0.2, 0.2, 0.6], а корректным классом является с = 0, то конечным результатом будет значение

= [-0.8, 0.2, 0.6]. Данное выражение несложно перевести в код:

|

# Цикл для каждого примера тренировки for x, y in train_data.items(): inputs = createInputs(x) target = int(y) # Прямое распространение out, _ = rnn.forward(inputs) probs = softmax(out) # Создание dL/dy d_L_d_y = probs d_L_d_y[target] -= 1 # Обратное распространение rnn.backprop(d_L_d_y) |

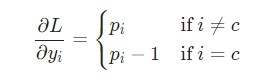

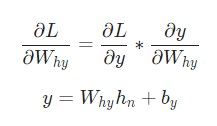

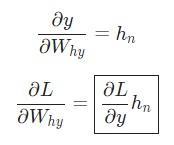

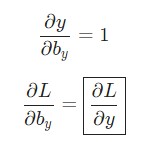

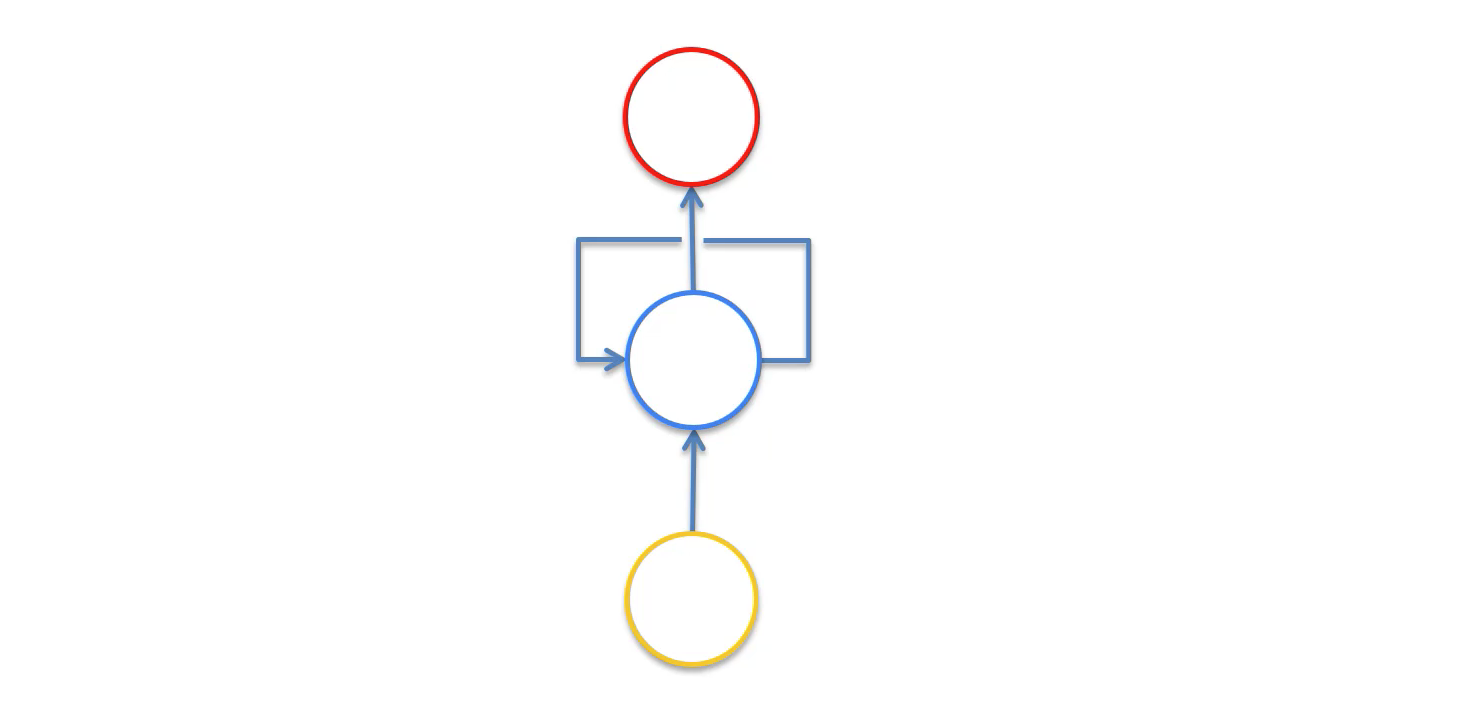

Отлично. Теперь разберемся с градиентами для Why и by, которые используются только для перехода конечного скрытого состояния в результат вывода рассматриваемой нейронной сети RNN. Используем следующие данные:

Здесь hn является конечным скрытым состоянием. Таким образом:

Аналогичным способом вычисляем:

Теперь можно приступить к реализации backprop().

|

class RNN: # … def backprop(self, d_y, learn_rate=2e—2): »’ Выполнение фазы обратного распространения нейронной сети RNN. — d_y (dL/dy) имеет форму (output_size, 1). — learn_rate является вещественным числом float. »’ n = len(self.last_inputs) # Подсчет dL/dWhy и dL/dby. d_Why = d_y @ self.last_hs[n].T d_by = d_y |

Напоминание: мы создали

self.last_hsвforward()в предыдущих примерах.

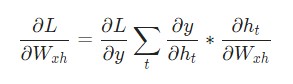

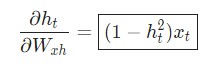

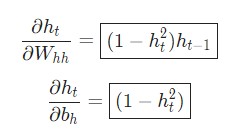

Наконец, нам понадобятся градиенты для Whh, Wxh, и bh, которые использовались в каждом шаге нейронной сети. У нас есть:

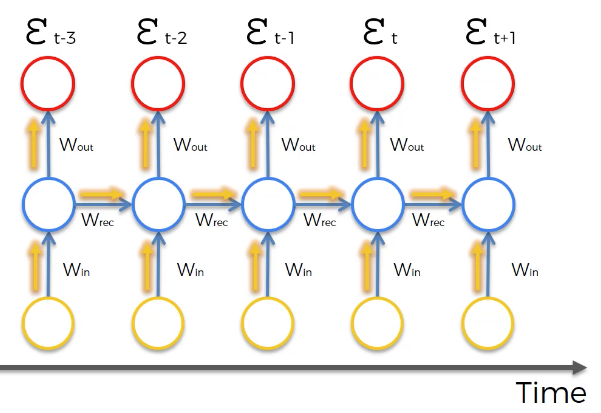

Изменение Wxh влияет не только на каждый ht, но и на все у , что, в свою очередь, приводит к изменениям в L. Для того, чтобы полностью подсчитать градиент Wxh, необходимо провести обратное распространение через все временные шаги. Его также называют Обратным распространением во времени, или Backpropagation Through Time (BPTT):

Wxh используется для всех прямых ссылок xt → ht, поэтому нам нужно провести обратное распространение назад к каждой из этих ссылок.

Приблизившись к заданному шагу t, потребуется подсчитать :

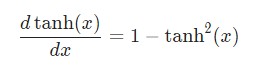

Производная гиперболической функции tanh нам уже известна:

Используем дифференцирование сложной функции, или цепное правило:

Аналогичным способом вычисляем:

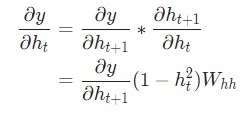

Последнее нужное значение — . Его можно подсчитать рекурсивно:

Реализуем обратное распространение во времени, или BPTT, отталкиваясь от скрытого состояния в качестве начальной точки. Далее будем работать в обратном порядке. Поэтому на момент подсчета значение

будет известно. Исключением станет только последнее скрытое состояние

hn:

Теперь у нас есть все необходимое, чтобы наконец реализовать обратное распространение во времени ВРТТ и закончить backprop():

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 |

class RNN: # … def backprop(self, d_y, learn_rate=2e—2): »’ Выполнение фазы обратного распространения RNN. — d_y (dL/dy) имеет форму (output_size, 1). — learn_rate является вещественным числом float. »’ n = len(self.last_inputs) # Вычисление dL/dWhy и dL/dby. d_Why = d_y @ self.last_hs[n].T d_by = d_y # Инициализация dL/dWhh, dL/dWxh, и dL/dbh к нулю. d_Whh = np.zeros(self.Whh.shape) d_Wxh = np.zeros(self.Wxh.shape) d_bh = np.zeros(self.bh.shape) # Вычисление dL/dh для последнего h. d_h = self.Why.T @ d_y # Обратное распространение во времени. for t in reversed(range(n)): # Среднее значение: dL/dh * (1 — h^2) temp = ((1 — self.last_hs[t + 1] ** 2) * d_h) # dL/db = dL/dh * (1 — h^2) d_bh += temp # dL/dWhh = dL/dh * (1 — h^2) * h_{t-1} d_Whh += temp @ self.last_hs[t].T # dL/dWxh = dL/dh * (1 — h^2) * x d_Wxh += temp @ self.last_inputs[t].T # Далее dL/dh = dL/dh * (1 — h^2) * Whh d_h = self.Whh @ temp # Отсекаем, чтобы предотвратить разрыв градиентов. for d in [d_Wxh, d_Whh, d_Why, d_bh, d_by]: np.clip(d, —1, 1, out=d) # Обновляем вес и смещение с использованием градиентного спуска. self.Whh -= learn_rate * d_Whh self.Wxh -= learn_rate * d_Wxh self.Why -= learn_rate * d_Why self.bh -= learn_rate * d_bh self.by -= learn_rate * d_by |

Моменты, на которые стоит обратить внимание:

Мы сделали это! Наша рекуррентная нейронная сеть готова.

Тестирование рекуррентной нейронной сети

Наконец настал тот момент, которого мы так долго ждали — протестируем готовую рекуррентную нейронную сеть.

Для начала, напишем вспомогательную функцию для обработки данных рассматриваемой рекуррентной нейронной сети:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 |

import random def processData(data, backprop=True): »’ Возврат потери рекуррентной нейронной сети и точности для данных — данные представлены как словарь, что отображает текст как True или False. — backprop определяет, нужно ли использовать обратное распределение »’ items = list(data.items()) random.shuffle(items) loss = 0 num_correct = 0 for x, y in items: inputs = createInputs(x) target = int(y) # Прямое распределение out, _ = rnn.forward(inputs) probs = softmax(out) # Вычисление потери / точности loss -= np.log(probs[target]) num_correct += int(np.argmax(probs) == target) if backprop: # Создание dL/dy d_L_d_y = probs d_L_d_y[target] -= 1 # Обратное распределение rnn.backprop(d_L_d_y) return loss / len(data), num_correct / len(data) |

Теперь можно написать цикл для тренировки сети:

|

# Цикл тренировки for epoch in range(1000): train_loss, train_acc = processData(train_data) if epoch % 100 == 99: print(‘— Epoch %d’ % (epoch + 1)) print(‘Train:tLoss %.3f | Accuracy: %.3f’ % (train_loss, train_acc)) test_loss, test_acc = processData(test_data, backprop=False) print(‘Test:tLoss %.3f | Accuracy: %.3f’ % (test_loss, test_acc)) |

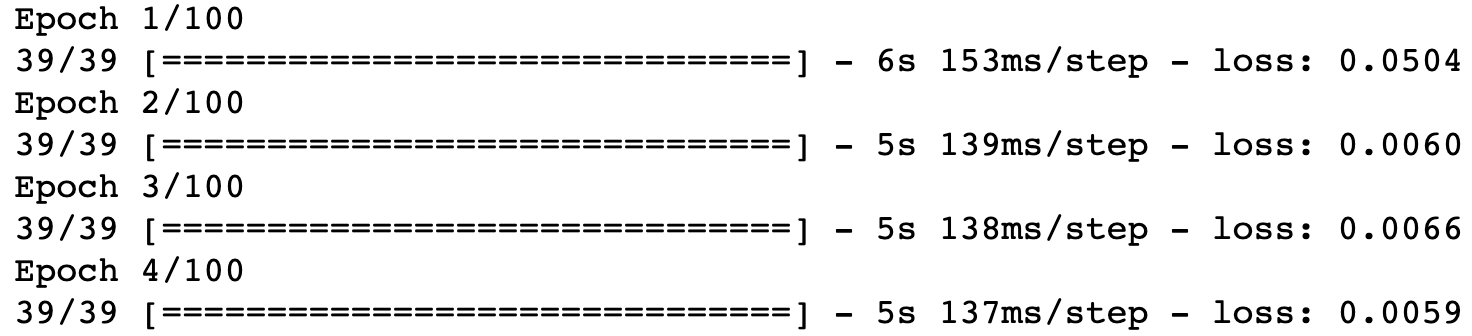

Результат вывода main.py выглядит следующим образом:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 |

—— Epoch 100 Train: Loss 0.688 | Accuracy: 0.517 Test: Loss 0.700 | Accuracy: 0.500 —— Epoch 200 Train: Loss 0.680 | Accuracy: 0.552 Test: Loss 0.717 | Accuracy: 0.450 —— Epoch 300 Train: Loss 0.593 | Accuracy: 0.655 Test: Loss 0.657 | Accuracy: 0.650 —— Epoch 400 Train: Loss 0.401 | Accuracy: 0.810 Test: Loss 0.689 | Accuracy: 0.650 —— Epoch 500 Train: Loss 0.312 | Accuracy: 0.862 Test: Loss 0.693 | Accuracy: 0.550 —— Epoch 600 Train: Loss 0.148 | Accuracy: 0.914 Test: Loss 0.404 | Accuracy: 0.800 —— Epoch 700 Train: Loss 0.008 | Accuracy: 1.000 Test: Loss 0.016 | Accuracy: 1.000 —— Epoch 800 Train: Loss 0.004 | Accuracy: 1.000 Test: Loss 0.007 | Accuracy: 1.000 —— Epoch 900 Train: Loss 0.002 | Accuracy: 1.000 Test: Loss 0.004 | Accuracy: 1.000 —— Epoch 1000 Train: Loss 0.002 | Accuracy: 1.000 Test: Loss 0.003 | Accuracy: 1.000 |

Неплохо для рекуррентной нейронной сети, которую мы построили сами!

Хотите поэкспериментировать с этим кодом сами? Можете запустить данную рекуррентную нейронную сеть RNN у себя в браузере. Она также доступна на GitHub.

Подведем итоги

Вот и все, пошаговое руководство по рекуррентным нейронным сетям на этом закончено. Мы узнали, что такое RNN, как они работают, почему они полезны, как их создавать и тренировать. Это очень малый аспект мира нейронных сетей. При желании вы можете продолжить изучение темы самостоятельно, используя следующие ресурсы:

- Подробнее ознакомьтесь с LTSM. Это долгая краткосрочная память, которая характерна более мощной архитектурой рекуррентных нейронных сетей. Будет не лишним ознакомиться с управляемым рекуррентными блоками, или GRU. Это наиболее популярная вариация LTSM;

- Поэкспериментируйте с более крупными и сложными RNN. Для этого используйте подходящие ML библиотеки, например, Tensorflow, Keras или PyTorch;

- Прочтите о двунаправленных нейронных сетях, которые обрабатывают последовательности как в прямом, так и в обратном направлении. Это позволяет получить больше информации на уровне вывода;

- Ознакомьтесь с векторными представлением слов. Для этого можно использовать GloVe или Word2Vec;

- Познакомьтесь поближе с Natural Language Toolkit (NLTK), популярной библиотекой Python для работы с данными на языках, которые используют люди, а не машины.

Благодарим за внимание!

Являюсь администратором нескольких порталов по обучению языков программирования Python, Golang и Kotlin. В составе небольшой команды единомышленников, мы занимаемся популяризацией языков программирования на русскоязычную аудиторию. Большая часть статей была адаптирована нами на русский язык и распространяется бесплатно.

E-mail: vasile.buldumac@ati.utm.md

Образование

Universitatea Tehnică a Moldovei (utm.md)

- 2014 — 2018 Технический Университет Молдовы, ИТ-Инженер. Тема дипломной работы «Автоматизация покупки и продажи криптовалюты используя технический анализ»

- 2018 — 2020 Технический Университет Молдовы, Магистр, Магистерская диссертация «Идентификация человека в киберпространстве по фотографии лица»

N+1 совместно с МФТИ продолжает знакомить читателя с наиболее яркими аспектами современных исследований в области искусственного интеллекта. В прошлый раз мы писали об общих принципах машинного обучения и конкретно о методе обратного распространения ошибки для обучения нейросетей. Сегодня наш собеседник — Валентин Малых, младший научный сотрудник Лаборатории нейронных систем и глубокого обучения. Вместе с ним мы поговорим о необычном классе этих систем — рекуррентных нейросетях, их особенностях и перспективах, как на поприще всевозможных развлечений в стиле DeepDream, так и в «полезных» областях. Поехали.

Что такое рекуррентные нейросети (РНС) и чем они отличаются от обычных?

Давайте сначала вспомним, что такое «обычные» нейросети, и тогда сразу станет понятно, чем они отличаются от реккурентных. Представим себе самую простую нейросеть — перцептрон. Он представляет собой один слой нейронов, каждый из которых принимает кусочек входных данных (один или несколько битов, действительных чисел, пикселей и т.п.), модифицирует его с учетом собственного веса и передает дальше. В однослойном перцептроне выдача всех нейронов объединяется тем или иным образом, и нейросеть дает ответ, но возможности такой архитектуры сильно ограниченны. Если вы хотите получить более продвинутый функционал, можно пойти несколькими путями, например, увеличить количество слоев и добавить операцию свертки, которая бы «расслаивала» входящие данные на кусочки разных масштабов. В этом случае у вас получатся сверточные нейросети для глубинного обучения, которые преуспели в обработке изображений и распознавании котиков. Однако что у примитивного перцептрона, что у сверточной нейросети есть общее ограничение: и входные и выходные данные имеют фиксированный, заранее обозначенный размер, например, картинка 100×100 пикселей или последовательность из 256 бит. Нейросеть с математической точки зрения ведет себя как обычная функция, хоть и очень сложно устроенная: у нее есть заранее обозначенное число аргументов, а также обозначенный формат, в котором она выдает ответ. Простой пример — функция x2, она принимает один аргумент и выдает одно значение.

Вышеперечисленные особенности не представляет больших трудностей, если речь идет о тех же картинках или заранее определенных последовательностях символов. Но что, если вы хотите использовать нейросеть для обработки текста или музыки? В общем случае — любой условно бесконечной последовательности, в которой важно не только содержание, но и порядок, в котором следует информация. Вот для этих задач и были придуманы рекуррентные нейросети. Их противоположности, которые мы называли «обычными», имеют более строгое название — нейросети прямого распространения (feed-forward neural networks), так как в них информация передается только вперед по сети, от слоя к слою. В рекуррентных нейросетях нейроны обмениваются информацией между собой: например, вдобавок к новому кусочку входящих данных нейрон также получает некоторую информацию о предыдущем состоянии сети. Таким образом в сети реализуется «память», что принципиально меняет характер ее работы и позволяет анализировать любые последовательности данных, в которых важно, в каком порядке идут значения — от звукозаписей до котировок акций.

Наличие памяти у рекуррентных нейросетей позволяет несколько расширить нашу аналогию с x

2

. Если нейросети прямого распространения мы назвали «простой» функцией, то рекуррентные нейросети можно почти с чистой совестью назвать программой. В самом деле, память рекуррентных нейросетей (хотя и не полноценная, но об этом позже) делает их Тьюринг-полными: при правильном задании весов нейросеть может успешно эмулировать работу компьютерных программ.

Немного углубимся в историю: когда были придуманы РНС, для каких задач и в чем, как тогда казалось, должно было заключаться их преимущество перед обычным перцептроном?

Вероятно, первой РНС была сеть Хопфилда (впервые упомянута в 1974 году, окончательно оформилась в 1982-м), которая реализовывала на практике ячейку ассоциативной памяти. От современных РНС она отличается тем, что работает с последовательностями фиксированного размера. В простейшем случае сеть Хопфилда имеет один слой внутренних нейронов, связанных между собой, а каждая связь характеризуется определенным весом, задающим ее значимость. С такой сетью ассоциируется некий эквивалент физической «энергии», который зависит от всех весов в системе. Сеть можно обучить при помощи градиентного спуска по энергии, когда минимум соответствует состоянию, в котором сеть «запомнила» определенный шаблон, например 10101. Теперь, если ей на вход подать искаженный, зашумленный или неполный шаблон, скажем, 10000, она «вспомнит» и восстановит его аналогично тому, как работает ассоциативная память у человека. Эта аналогия достаточно отдаленна, поэтому не стоит воспринимать ее чересчур серьезно. Тем не менее, сети Хопфилда успешно справлялись со своей задачей и обходили по возможностям существовавшие тогда перцептроны. Интересно, что оригинальная публикация Джона Хопфилда в Proceedings of the National Academy of Sciences вышла в разделе «Биофизика».

Следующим шагом в эволюции РНС была

Джеффа Элмана, описанная в 1990 году. В ней автор подробно затронул вопрос о том, как можно (и можно ли вообще) обучить нейросеть распознавать временные последовательности. Например, если есть входящие данные

1100

и

0110

, можно ли их считать одним и тем же набором, сдвинутым во времени? Конечно, можно, но как обучить этому нейросеть? Обычный перцептрон легко запомнит эту закономерность для любых примеров, которые ему предложат, но каждый раз это будет задачей сравнения двух разных сигналов, а не задачей об эволюции или сдвиге одного и того же сигнала. Решение Элмана, основанное на предыдущих наработках в этой области, основывалось на том, что в простую нейросеть добавлялся еще один — «контекстный» — слой, в который просто копировалось состояние внутреннего слоя нейронов на каждом цикле работы сети. При этом связь между контекстным и внутренним слоями можно было обучать. Такая архитектура позволяла сравнительно легко воспроизводить временные ряды, а также обрабатывать последовательности произвольной длины, что резко отличало простую РНС Элмана от предыдущих концепций. Более того, эта сеть смогла распознать и даже классифицировать существительные и глаголы в предложении, основываясь только на порядке слов, что было настоящим прорывом для своего времени и вызвало огромный интерес как лингвистов, так и специалистов по исследованию сознания.

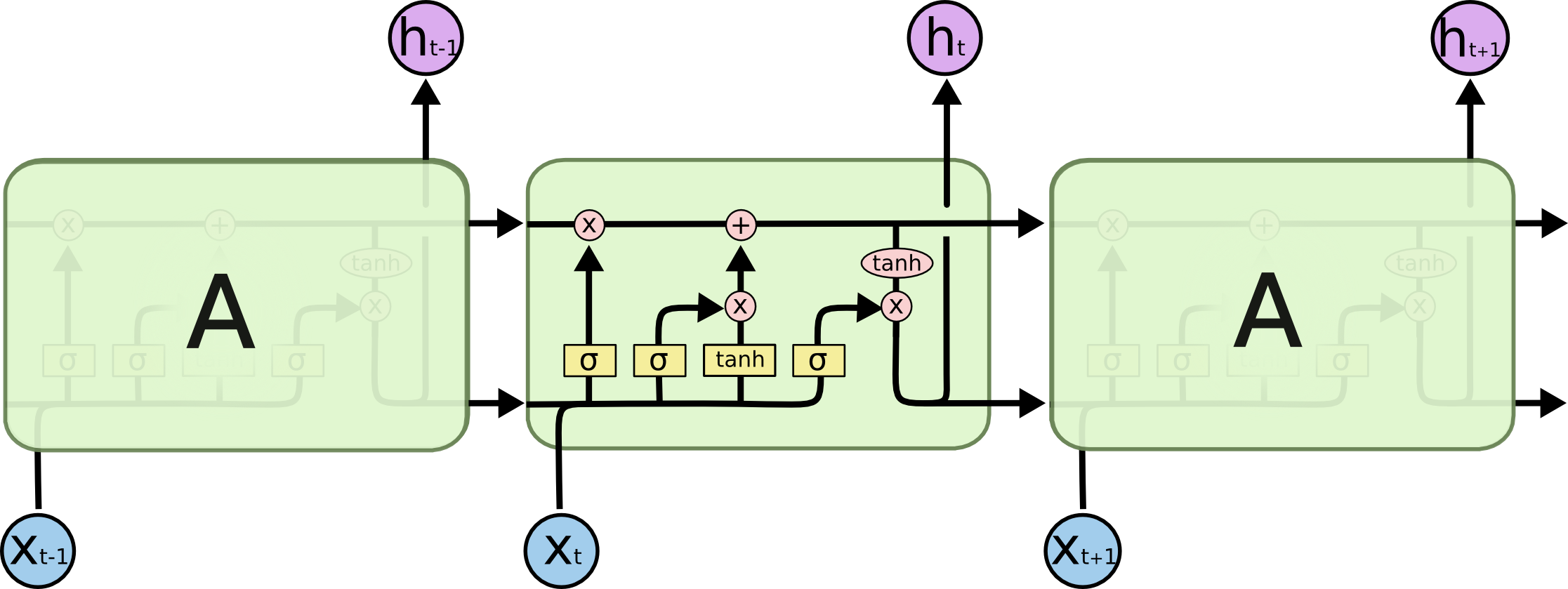

За простой РНС Элмана последовали все новые разработки, а в 1997 году Хохрейтер и Шмидхубер опубликовали статью «

» («долгосрочная краткосрочная память», также существует множество других вариаций перевода), заложившую основу для большинства современных РНС. В своей работе авторы описывали модификацию, решавшую проблему долгосрочной памяти простых РНС: их нейроны хорошо «помнят» недавно полученную информацию, но не имеют возможности надолго сохранить в памяти что-то, что обработали много циклов назад, какой бы важной та информация ни была. В LSTM-сетях внутренние нейроны «оборудованы» сложной системой так называемых ворот (gates), а также концепцией клеточного состояния (cell state), которая и представляет собой некий вид долгосрочной памяти. Ворота же определяют, какая информация попадет в клеточное состояние, какая сотрется из него, и какая повлияет на результат, который выдаст РНС на данном шаге. Подробно разбирать LSTM мы не будем, однако отметим, что именно эти вариации РНС широко используется сейчас, например, для машинного перевода Google.

Все прекрасно звучит на словах, но что все-таки РНС умеют делать? Вот дали им текст почитать или музыку послушать — а дальше что?

Одна из главных областей применения РНС на сегодняшний день — работа с языковыми моделями, в частности — анализ контекста и общей связи слов в тексте. Для РНС структура языка — это долгосрочная информация, которую надо запомнить. К ней относятся грамматика, а также стилистические особенности того корпуса текстов, на которых производится обучение. Фактически РНС запоминает, в каком порядке обычно следуют слова, и может дописать предложение, получив некоторую затравку. Если эта затравка случайная, может получиться совершенно бессмысленный текст, стилистически напоминающий шаблон, на котором училась РНС. Если же исходный текст был осмысленным, РНС поможет его стилизовать, однако в последнем случае одной РНС будет мало, так как результат должен представлять собой «смесь» случайного, но стилизованного текста от РНС и осмысленной, но «неокрашенной» исходной части. Эта задача уже настолько напоминает популярные ныне

для обработки фотографий в стиле Моне и Ван Гога, что невольно напрашивается аналогия.

Действительно, задача переноса стиля с одного изображения на другой решается при помощи нейросетей и операции свертки, которая разбивает изображение на несколько масштабов и позволяет нейросетям анализировать их независимо друг от друга, а впоследствии и перемешивать между собой. Аналогичные операции

и с музыкой (также с помощью сверточных нейросетей): в этом случае мелодия является содержанием, а аранжировка — стилем. И вот с написанием музыки РНС как раз успешно

. Поскольку обе задачи — и написание, и смешивание мелодии с произвольным стилем — уже успешно решены при помощи нейросетей, совместить эти решения остается делом техники.

Наконец, давайте разберемся, почему музыку РНС худо-бедно пишут, а с полноценными текстами Толстого и Достоевского возникают проблемы? Дело в том, что в инструментальной музыке, как бы по-варварски это ни звучало, нет

смысла

в том же значении, в каком он есть в большинстве текстов. То есть музыка может нравиться или не нравиться, но если в ней нет слов — она не несет информационной нагрузки (конечно, если это не секретный код). Именно с приданием своим произведениям смысла и наблюдаются проблемы у РНС: они могут превосходно выучить грамматику языка и запомнить, как должен

выглядеть

текст в определенном стиле, но создать и донести какую-то идею или информацию РНС (пока) не могут.

Особый случай в этом вопросе — это автоматическое написание программного кода. Действительно, поскольку язык программирования по определению представляет собой

язык

, РНС может его выучить. На практике оказывается, что программы, написанные РНС, вполне успешно компилируются и запускаются, однако они не делают ничего полезного, если им заранее не

. А причина этого та же, что и в случае литературных текстов: для РНС язык программирования — не более чем стилизация, в которую они, к сожалению, не могут вложить никакого смысла.

«Генерация бреда» это забавно, но бессмысленно, а для каких настоящих задач применяются РНС?

Разумеется, РНС, помимо развлекательных, должны преследовать и более прагматичные цели. Из их дизайна автоматически следует, что главные области их применения должны быть требовательны к контексту и/или временной зависимости в данных, что по сути одно и то же. Поэтому РНС используются, к примеру, для анализа изображений. Казалось бы, эта область обычно воспринимается в контексте сверточных нейросетей, однако и для РНС здесь находятся задачи: их архитектура позволяет быстрее распознавать детали, основываясь на контексте и окружении. Аналогичным образом РНС работают в сферах анализа и генерации текстов. Из более необычных задач можно

попытки использовать ранние РНС для классификации углеродных спектров ядерного магнитного резонанса различных производных бензола, а из современных — анализ появления негативных отзывов о товарах.

А каковы успехи РНС в машинном переводе? В Google Translate ведь именно они используются?

На текущий момент в Google для машинного перевода

РНС типа LSTM, что позволило добиться наибольшей точности по сравнению с существующими аналогами, однако, по словам самих авторов, машинному переводу еще очень далеко до уровня человека. Сложности, с которыми сталкиваются нейросети в задачах перевода, обусловлены сразу несколькими факторами: во-первых, в любой задаче существует неизбежный размен между качеством и скоростью. На данный момент человек очень сильно опережает искусственный интеллект по этому показателю. Поскольку машинный перевод чаще всего используется в онлайн-сервисах, разработчики вынуждены жертвовать точностью в угоду быстродействию. В недавней публикации Google на эту тему разработчики подробно описывают многие решения, которые позволили оптимизировать текущую версию Google Translate, однако проблема до сих пор остается. Например, редкие слова, или сленг, или нарочитое искажение слова (например, для более яркого заголовка) может сбить с толку даже переводчика-человека, которому придется потратить время, чтобы подобрать наиболее адекватный аналог в другом языке. Машину же такая ситуация поставит в полный тупик, и переводчик будет вынужден «выбросить» сложное слово и оставить его без перевода. В итоге проблема машинного перевода не настолько обусловлена архитектурой (РНС успешно справляются с рутинными задачами в этой области), насколько сложностью и многообразием языка. Радует то, что эта проблема имеет более технический характер, чем написание осмысленных текстов, где, вероятно, требуется кардинально новый подход.

А более необычные способы применения РНС есть? Вот нейронная машина Тьюринга, например, в чем тут идея?

Нейронная машина Тьюринга (

), предложенная два года назад коллективом из Google DeepMind, отличается от других РНС тем, что последние на самом деле не хранят информацию в явном виде — она кодируется в весах нейронов и связей, даже в продвинутых вариациях вроде LSTM. В нейронной машине Тьюринга разработчики придерживались более понятной идеи «ленты памяти», как в классической машине Тьюринга: в ней информация в явном виде записывается «на ленту» и может быть считана в случае необходимости. При этом отслеживание того, какая информация нужна, ложится на особую нейросеть-контроллер. В целом можно отметить, что идея НМТ действительно завораживает своей простотой и доступностью для понимания. С другой стороны, в силу технических ограничений современного аппаратного обеспечения применить НМТ на практике не представляется возможным, потому что обучение такой сети становится чрезвычайно долгим. В этом смысле РНС являются промежуточным звеном между более простыми нейросетями и НМТ, так как хранят некий «слепок» информации, который при этом не смертельно ограничивает их быстродействие.

А что такое концепция внимания применительно к РНС? Что нового она позволяет делать?

Концепция внимания (attention) — это способ «подсказать» сети, на что следует потратить больше внимания при обработке данных. Другими словами, внимание в рекуррентной нейронной сети — это способ увеличить важность одних данных по сравнению с другими. Поскольку человек не может выдавать подсказки каждый раз (это нивелировало бы всю пользу от РНС), сеть должна научиться подсказывать себе сама. Вообще, концепция внимания является очень сильным инструментом в работе с РНС, так как позволяет быстрее и качественнее подсказать сети, на какие данные стоит обращать внимание, а на какие — нет. Также этот подход может в перспективе решить проблему быстродействия в системах с большим объемом памяти. Чтобы лучше понять, как это работает, надо рассмотреть две модели внимания: «мягкую» (soft) и «жесткую» (hard). В первом случае сеть все равно обратится ко всем данным, к которым имеет доступ, но значимость (то есть вес) этих данных будет разной. Это делает РНС более точной, но не более быстрой. Во втором случае из всех существующих данных сеть обратится лишь к некоторым (у остальных будут нулевые веса), что решает сразу две проблемы. Минусом «жесткой» концепции внимания является тот факт, что эта модель перестает быть непрерывной, а значит — дифференцируемой, что резко усложняет задачу ее обучения. Тем не менее, существуют решения, позволяющие исправить этот недостаток. Поскольку концепция внимания активно развивается в последние пару лет, нам остается ждать в ближайшее время новостей с этого поля.

Под конец можно привести пример системы, использующей концепцию внимания: это Dynamic Memory Networks — разновидность, предложенная исследовательским подразделением Facebook. В ней разработчики описывают «модуль эпизодической памяти» (episodic memory module), который на основании памяти о событиях, заданных в виде входных данных, а также вопроса об этих событиях, создает «эпизоды», которые в итоге помогают сети найти правильный ответ на вопрос. Такая архитектура была опробована на bAbI, крупной базе сгенерированных заданий на простой логический вывод (например, дается цепочка из трех фактов, нужно выдать правильный ответ: «Мэри дома. Она вышла во двор. Где Мэри? Во дворе».), и показала результаты, превосходящие классические архитектуры вроде LSTM.

Что еще происходит в мире рекуррентных нейросетей прямо сейчас?

По словам Андрея Карпатого (Andrej Karpathy) — специалиста по нейросетям и автора превосходного блога, «концепция внимания — это самое интересное из недавних архитектурных решений в мире нейросетей». Однако не только на внимании акцентируются исследования в области РНС. Если постараться кратко сформулировать основной тренд, то им сейчас стало сочетание различных архитектур и применение наработок из других областей для улучшения РНС. Из примеров можно назвать уже упомянутые нейросети от Google, в которых используют методы, взятые из работ по обучению с подкреплением, нейронные машины Тьюринга, алгоритмы оптимизации вроде Batch Normalization и многое другое, — все это вместе заслуживает отдельной статьи. В целом отметим, что хотя РНС не привлекли столь же широкого внимания, как любимцы публики — сверточные нейросети, это объясняется лишь тем, что объекты и задачи, с которыми работают РНС, не так бросаются в глаза, как DeepDream или Prisma. Это как в социальных сетях — если пост публикуют без картинки, ажиотажа вокруг него будет меньше.

Поэтому всегда публикуйтесь с картинкой.

Тарас Молотилин

Перевод

Ссылка на автора

Основная цель этого поста — внедрить RNN с нуля и дать простое объяснение, чтобы сделать его полезным для читателей. Внедрение любой нейронной сети с нуля хотя бы один раз является ценным упражнением. Это поможет вам понять, как работают нейронные сети, и здесь мы внедряем RNN, который имеет свою сложность и, таким образом, дает нам хорошую возможность отточить наши навыки.

Существуют различные учебные пособия, которые предоставляют очень подробную информацию о внутренностях RNN. Вы можете найти некоторые из очень полезных ссылок в конце этого поста. Я довольно быстро понял, как работает RNN, но больше всего меня беспокоило то, как проходили расчеты BPTT и их реализация. Мне пришлось потратить некоторое время, чтобы понять и, наконец, собрать все вместе. Не теряя больше времени, давайте сначала быстро пройдемся по основам RNN.

Что такое RNN?

Рекуррентная нейронная сеть — это нейронная сеть, которая специализируется на обработке последовательности данных.x(t)= x(1), . . . , x(τ)с индексом временного шагаtначиная от1 to τ, Для задач, которые включают последовательные вводы, такие как речь и язык, часто лучше использовать RNN. В задаче НЛП, если вы хотите предсказать следующее слово в предложении, важно знать слова перед ним. RNNs называютсявозвратныйпотому что они выполняют одну и ту же задачу для каждого элемента последовательности с выходом, зависящим от предыдущих вычислений. Еще один способ думать о RNN — это то, что у них есть «память», которая собирает информацию о том, что было рассчитано до сих пор.

Архитектура:Давайте кратко пройдемся по базовой сети RNN.

Левая сторона вышеприведенной диаграммы показывает обозначение RNN, а справа — RNN.развернутый(или развернутый) в полную сеть. Развертывание означает, что мы выписываем сеть для полной последовательности. Например, если интересующая нас последовательность представляет собой предложение из трех слов, сеть будет развернута в трехслойную нейронную сеть, по одному слою для каждого слова.

Входные данные:х (т)Принимается за вход в сеть на шаге по временит.Например,x1,может быть горячим вектором, соответствующим слову предложения.

Скрытое состояние: ч (т)Представляет скрытое состояние в момент времени t и действует как «память» сети.ч (т)Рассчитывается на основе текущего ввода и скрытого состояния предыдущего временного шага:h(t) = f(U x(t) + W h(t−1)).Функцияfпринимается за нелинейное преобразование, такое какTANH,РЕЛУ.

Веса: RNN имеет вход для скрытых соединений, параметризованных весовой матрицей U, скрытых к скрытым рекуррентным соединениям, параметризованным весовой матрицей W, и скрытых к выходу соединений, параметризованных весовой матрицей V и всеми этими весами (U,В,W)распределяются по времени.

Выход:о (т)Иллюстрирует вывод сети. На рисунке я просто поместил стрелку послео (т)который также часто подвергается нелинейности, особенно когда сеть содержит дополнительные уровни ниже по потоку.

Форвард Пасс

На рисунке не указан выбор функции активации для скрытых юнитов. Прежде чем продолжить, сделаем несколько предположений: 1) мы предполагаем гиперболическую касательную функцию активации для скрытого слоя. 2) Мы предполагаем, что выходные данные являются дискретными, как будто RNN используется для предсказания слов или символов. Естественным способом представления дискретных переменных является учет выходных данных.oкак предоставление ненормированных логарифмических вероятностей каждого возможного значения дискретной переменной. Затем мы можем применить операцию softmax в качестве шага постобработки, чтобы получить векторŷнормированных вероятностей на выходе.

Прямой проход RNN, таким образом, может быть представлен нижеследующей системой уравнений.

Это пример рекуррентной сети, которая отображает входную последовательность на выходную последовательность той же длины. Общая потеря для данной последовательностиxзначения в паре с последовательностьюyЗначения тогда будут просто суммой потерь за все временные шаги. Мы предполагаем, что выводыo(t)используются в качестве аргумента функции softmax для получения вектораŷвероятностей на выходе. Мы также предполагаем, что потеряLотрицательная логарифмическая вероятность истинной целиy(t)учитывая вклад до сих пор.

Обратный проход

Вычисление градиента включает выполнение прохода прямого распространения, перемещающегося слева направо по графику, показанному выше, за которым следует проход обратного распространения, перемещающийся справа налево по графику. Время выполнения равно O (τ) и не может быть уменьшено путем распараллеливания, поскольку граф прямого распространения по своей природе является последовательным; каждый временной шаг может быть вычислен только после предыдущего. Состояния, вычисленные в прямом проходе, должны храниться до их повторного использования во время обратного прохода, поэтому стоимость памяти также равна O (τ) Алгоритм обратного распространения, применяемый к развернутому графу со стоимостью O (τ), называется обратным распространением во времени (BPTT). Поскольку параметры являются общими для всех временных шагов в сети, градиент на каждом выходе зависит не только от вычислений текущего временного шага, но и от предыдущих временных шагов.

Вычислительные градиенты

Учитывая нашу функцию потерьLнам нужно вычислить градиенты для наших трех весовых матрицU, V, W иусловия смещенияДо нашей эрыи обновить ихсо скоростью обученияα, Подобно нормальному обратному распространению, градиент дает нам представление о том, как изменяется потеря по отношению к каждому весовому параметру. Мы обновляем веса W, чтобы минимизировать потери с помощью следующего уравнения:

То же самое должно быть сделано и для других весов U, V, b, c.

Давайте теперь вычислим градиенты по BPTT для приведенных выше уравнений RNN. Узлы нашего вычислительного графа включают в себя параметры U, V, W, b и c, а также последовательность узлов, индексированных t для x (t), h (t), o (t) и L (t). Для каждого узлаnнам нужно вычислить градиент∇nLрекурсивно, на основе градиента, вычисленного в узлах, следующих за ним в графе.

Градиент по выходу o (t)рассчитывается при условии, что o (t) используются в качестве аргумента функции softmax для получения вектораŷвероятностей на выходе. Мы также предполагаем, что потеря является отрицательной логарифмической вероятностью истинной цели y (t).

Пожалуйста, обратитесь Вот для получения вышеуказанного элегантного решения.

Давайте теперь разберемся, как градиент течет через скрытое состояние h (t). Это ясно видно из диаграммы ниже, что в момент времени t скрытое состояние h (t) имеет градиент, вытекающий как из токового выхода, так и из следующего скрытого состояния.

Мы работаем в обратном направлении, начиная с конца последовательности. На конечном шаге по времени τ h (τ) имеет только o (τ) в качестве потомка, поэтому его градиент прост:

Затем мы можем выполнить итерацию назад во времени для обратного распространения градиентов во времени, от t = τ − 1 до t = 1, отметив, что h (t) (для t <τ) имеет в качестве потомков o (t) и h ( T + 1). Таким образом, его градиент определяется как:

Как только градиенты на внутренних узлах вычислительного графа получены, мы можем получить градиенты на узлах параметров. Расчет градиента с использованием правила цепочки для всех параметров:

Мы не заинтересованы выводить эти уравнения здесь, а реализуем их. Там очень хорошие посты Вот а также Вот предоставляя подробный вывод этих уравнений.

Реализация

Мы реализуем полную Рекуррентную Нейронную Сеть с нуля, используя Python. Мы попытаемся построить модель генерации текста с использованием RNN. Мы обучаем нашу модель прогнозированию вероятности персонажа с учетом предыдущих символов. Этогенеративная модель, Учитывая существующую последовательность символов, мы выбираем следующий символ из предсказанных вероятностей и повторяем процесс, пока у нас не будет полного предложения. Эта реализация от Андрея Карпарти отличный пост построение уровня персонажа RNN. Здесь мы обсудим детали реализации шаг за шагом.

Общие шаги, чтобы следовать:

- Инициализировать весовые матрицыU, V, Wот случайного распределенияи смещение b, c с нулями

- Прямое распространение для вычисления прогнозов

- Вычислить потери

- Обратное распространение для вычисления градиентов

- Обновление весов на основе градиентов

- Повторите шаги 2–5

Шаг 1: Инициализация

Чтобы начать с реализации базовой ячейки RNN, мы сначала определим размеры различных параметров U, V, W, b, c.

Размеры: Допустим, мы выбрали размер словаряvocab_size= 8000и скрытый размер слояhidden_size=100, Тогда мы имеем:

Размер словаря может быть числом уникальных символов для модели на основе символов или количеством уникальных слов для модели на основе слов.

С нашими немногими гиперпараметрами и другими параметрами модели давайте начнем определять нашу ячейку RNN.

Правильная инициализация весов, похоже, влияет на результаты тренировок, в этой области было проведено много исследований. Оказывается, что лучшая инициализация зависит от функции активации (в нашем случае tanh) и одной рекомендуемые подход состоит в том, чтобы инициализировать веса случайным образом в интервале от[ -1/sqrt(n), 1/sqrt(n)]гдеnэто количество входящих соединений с предыдущего слоя.

Шаг 2: прямой проход

В соответствии с нашими уравнениями для каждой временной метки t мы вычисляем скрытое состояние hs [t] и выводим os [t], применяя softmax, чтобы получить вероятность для следующего символа.

Вычисление softmax и численная стабильность:

Функция Softmax берет N-мерный вектор действительных чисел и преобразует его в вектор действительного числа в диапазоне (0,1), который складывается в 1. Отображение выполняется с использованием приведенной ниже формулы

Реализация softmax это:

Хотя это выглядит хорошо, однако, когда мы называем это softmax с большим числом, как показано ниже, это дает значения «nan»

Числовой диапазон чисел с плавающей точкой, используемых Numpy, ограничен. Для float64 максимальное представляемое число порядка 10³⁰⁸. Экспонирование в функции softmax позволяет легко сбросить это число, даже для входов довольно скромного размера. Хороший способ избежать этой проблемы — нормализовать входные данные, чтобы они не были слишком большими или слишком маленькими. Существует небольшой математический трюк Вот для деталей. Итак, наш софтмакс выглядит так:

Шаг 3: вычислить потери

Поскольку мы реализуем модель генерации текста, следующим символом может быть любой из уникальных символов в нашем словаре. Таким образом, наша потеря будет кросс-энтропийной потерей. В мультиклассовой классификации мы берем сумму значений логарифмических потерь для каждого прогноза класса в наблюдении.

- M — количество возможных меток классов (уникальные символы в нашем словаре)

- y — двоичный индикатор (0 или 1) того, является ли метка класса

Cправильная классификация для наблюденияO - р — прогнозируемая вероятность модели, что наблюдение

Шаг 4: обратный проход

Если мы обращаемся к уравнениям BPTT, реализация осуществляется в соответствии с уравнениями. Добавлены достаточные комментарии, чтобы понять код.

вопросы

Хотя RNN в принципе является простой и мощной моделью, на практике ее трудно обучить должным образом. Среди основных причин, почему эта модель настолько громоздкая, являютсяисчезающий градиента такжевзрывной градиентпроблемы. Во время тренировки с использованием BPTT градиенты должны пройти от последней ячейки до первой. Произведение этих градиентов может стремиться к нулю или возрастать экспоненциально. Проблема взрывающихся градиентов связана с большим увеличением нормы градиента во время тренировки. Проблема исчезающих градиентов относится к противоположному поведению, когда долгосрочные компоненты стремительно экспоненциально стремятся к норме 0, что делает невозможным для модели изучение корреляции между временно удаленными событиями.

Принимая во внимание, что взрывающийся градиент может быть исправлен с помощью метода ограничения градиента, который используется здесь в примере кода, проблема исчезающего градиента все еще является главной проблемой для RNN.

Это исчезающее ограничение градиента было преодолено различными сетями, такими как длинная кратковременная память (LSTM), стробируемые рекуррентные блоки (GRU) и остаточные сети (ResNets), где первые две являются наиболее часто используемыми вариантами RNN в приложениях NLP.

Шаг 5: Обновление весов

Используя BPTT, мы рассчитали градиент для каждого параметра модели. Настало время обновить вес.

В оригинале реализация Андрей Карпарти, Adagrad используется для обновления градиента. Адаград работает намного лучше, чем СГД. Пожалуйста, проверьте и сравните оба.

Шаг 6: повторите шаги 2–5

Для того, чтобы наша модель извлекла уроки из данных и сгенерировала текст, нам необходимо некоторое время обучать ее и проверять потери после каждой итерации. Если потеря уменьшается в течение определенного периода времени, это означает, что наша модель узнает, что от нее ожидается.

Создать текст

Мы тренируемся некоторое время, и если все пойдет хорошо, мы должны подготовить нашу модель, чтобы предсказать некоторый текст. Давайте посмотрим, как это работает для нас.

Мы будем реализовывать метод прогнозирования для прогнозирования нескольких слов, как показано ниже:

Давайте посмотрим, как наш RNN учится после нескольких эпох обучения.

Вывод больше похож на реальный текст с границами слов и некоторой грамматикой. Таким образом, наш малыш RNN начал изучать язык и мог предсказать следующие несколько слов.

Представленная здесь реализация подразумевает простоту понимания и понимания концепций. Если вы хотите поэкспериментировать с гиперпараметрами модели, ноутбук Вот,

Бонус:Хотите увидеть, что на самом деле происходит во время обучения RNN, смотрите Вот,

Надеюсь, что это было полезно для вас. Спасибо за прочитанное.

Ссылки:

[1] http://www.deeplearningbook.org/contents/rnn.html

[2] https://gist.github.com/karpathy/d4dee566867f8291f086

[3] http://www.wildml.com/2015/09/recurrent-neural-networks-tutorial-part-1-introduction-to-rnns/

[4] https://medium.com/towards-artificial-intelligence/whirlwind-tour-of-rnns-a11effb7808f

Recurrent neural networks are deep learning models that are typically used to solve time series problems. They are used in self-driving cars, high-frequency trading algorithms, and other real-world applications.

This tutorial will teach you the fundamentals of recurrent neural networks. You’ll also build your own recurrent neural network that predicts tomorrow’s stock price for Facebook (FB).

The Intuition of Recurrent Neural Networks

Recurrent neural networks are an example of the broader field of neural networks. Other examples include:

- Artificial neural networks

- Convolutional neural networks

This article will be focused on recurrent neural networks.

This tutorial will begin our discussion of recurrent neural networks by discussing the intuition behind recurrent neural networks.

The Types of Problems Solved By Recurrent Neural Networks

Although we have not explicitly discussed it yet, there are generally broad swathes of problems that each type of neural network is designed to solve:

- Artificial neural networks: classification and regression problems

- Convolutional neural networks: computer vision problems

In the case of recurrent neural networks, they are typically used to solve time series analysis problems.

Each of these three types of neural networks (artificial, convolutional, and recurrent) are used to solve supervised machine learning problems.

Mapping Neural Networks to Parts of the Human Brain

As you’ll recall, neural networks were designed to mimic the human brain. This is true for both their construction (both the brain and neural networks are composed of neurons) and their function (they are both used to make decisions and predictions).

The three main parts of the brain are:

- The cerebrum

- The brainstem

- The cerebellum

Arguably the most important part of the brain is the cerebrum. It contains four lobes:

- The frontal lobe

- The parietal lobe

- The temporal lobe

- The occipital lobe

The main innovation that neural networks contain is the idea of weights.

Said differently, the most important characteristic of the brain that neural networks have mimicked is the ability to learn from other neurons.

The ability of a neural network to change its weights through each epoch of its training stage is similar to the long-term memory that is seen in humans (and other animals).

The temporal lobe is the part of the brain that is associated with long-term memory. Separately, the artificial neural network was the first type of neural network that had this long-term memory property. In this sense, many researchers have compared artificial neural networks with the temporal lobe of the human brain.

Similarly, the occipital lobe is the component of the brain that powers our vision. Since convolutional neural networks are typically used to solve computer vision problems, you could say that they are equivalent to the occipital lobe in the brain.

As mentioned, recurrent neural networks are used to solve time series problems. They can learn from events that have happened in recent previous iterations of their training stage. In this way, they are often compared to the frontal lobe of the brain – which powers our short-term memory.

To summarize, researchers often pair each of the three neural nets with the following parts of the brain:

- Artificial neural networks: the temporal lobe

- Convolutional neural networks: the occipital lobe

- Recurrent neural networks: the frontal lobe

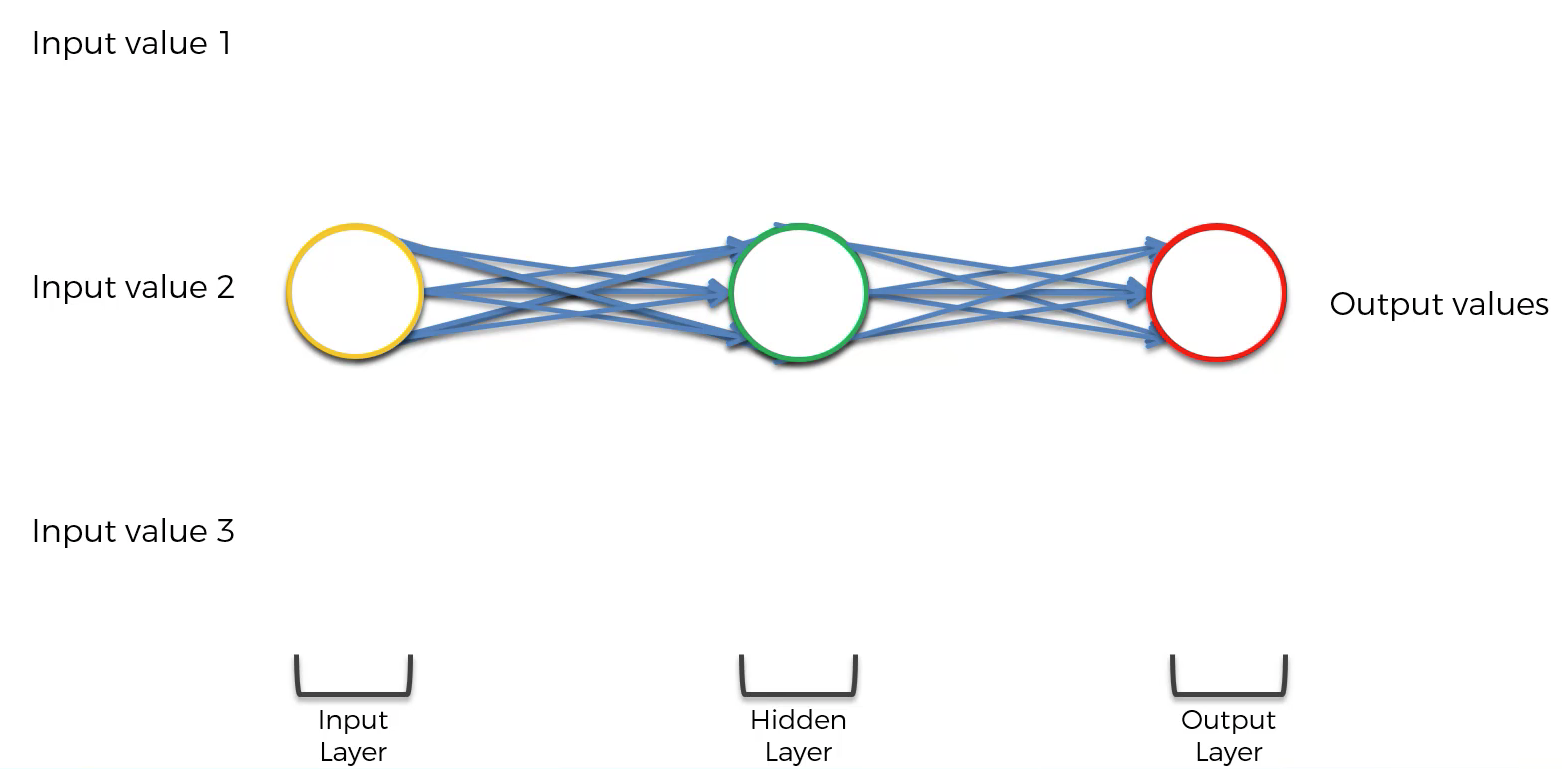

The Composition of a Recurrent Neural Network

Let’s now discuss the composition of a recurrent neural network. First, recall that the composition of a basic neural network has the following appearance:

The first modification that needs to be made to this neural network is that each layer of the network should be squashed together, like this:

Then, three more modifications need to be made:

- The neural network’s neuron synapses need to be simplified to a single line

- The entire neural network needs to be rotated 90 degrees

- A loop needs to be generated around the hidden layer of the neural net

The neural network will now have the following appearance:

That line that circles the hidden layer of the recurrent neural network is called the temporal loop. It is used to indicate that the hidden layer not only generates an output, but that output is fed back as the input into the same layer.

A visualization is helpful in understanding this. As you can see in the following image, the hidden layer used on a specific observation of a data set is not only used to generate an output for that observation, but it is also used to train the hidden layer of the next observation.

This property of one observation helping to train the next observation is why recurrent neural networks are so useful in solving time series analysis problems.

Summary – The Intuition of Recurrent Neural Networks

In this tutorial, you had your first introduction to recurrent neural networks. More specifically, we discussed the intuition behind recurrent neural networks.

Here is a brief summary of what we discussed in this tutorial:

- The types of problems solved by recurrent neural networks

- The relationships between the different parts of the brain and the different neural networks we’ve studied in this course

- The composition of a recurrent neural network and how each hidden layer can be used to help train the hidden layer from the next observation in the data set

The Vanishing Gradient Problem in Recurrent Neural Networks

The vanishing gradient problem has historically been one of the largest barriers to the success of recurrent neural networks.

Because of this, having an understanding of the vanishing gradient problem is important before you build your first RNN.

This section will explain the vanishing gradient problem in plain English, including a discussion of the most useful solutions to this interesting problem.

What Is The Vanishing Gradient Problem?

Before we dig in to the details of the vanishing gradient problem, it’s helpful to have some understanding of how the problem was initially discovered.

The vanishing gradient problem was discovered by Sepp Hochreiter, a German computer scientist who has had an influential role in the development of recurrent neural networks in deep learning.

Now let’s explore the vanishing gradient problem in detail. As its name implies, the vanishing gradient problem is related to deep learning gradient descent algorithms. Recall that a gradient descent algorithm looks something like this:

This gradient descent algorithm is then combined with a backpropagation algorithm to update the synapse weights throughout the neural network.

Recurrent neural networks behave slightly differently because the hidden layer of one observation is used to train the hidden layer of the next observation.

This means that the cost function of the neural net is calculated for each observation in the data set. These cost function values are depicted at the top of the following image:

The vanishing gradient problem occurs when the backpropagation algorithm moves back through all of the neurons of the neural net to update their weights. The nature of recurrent neural networks means that the cost function computed at a deep layer of the neural net will be used to change the weights of neurons at shallower layers.

The mathematics that computes this change is multiplicative, which means that the gradient calculated in a step that is deep in the neural network will be multiplied back through the weights earlier in the network. Said differently, the gradient calculated deep in the network is “diluted” as it moves back through the net, which can cause the gradient to vanish – giving the name to the vanishing gradient problem!

The actual factor that is multiplied through a recurrent neural network in the backpropagation algorithm is referred to by the mathematical variable Wrec. It poses two problems:

- When

Wrecis small, you experience a vanishing gradient problem - When

Wrecis large, you experience an exploding gradient problem

Note that both of these problems are generally referred to by the simpler name of the “vanishing gradient problem”.

To summarize, the vanishing gradient problem is caused by the multiplicative nature of the backpropagation algorithm. It means that gradients calculated at a deep stage of the recurrent neural network either have too small of an impact (in a vanishing gradient problem) or too large of an impact (in an exploding gradient problem) on the weights of neurons that are shallower in the neural net.

How to Solve The Vanishing Gradient Problem

There are a number of strategies that can be used to solve the vanishing gradient problem. We will explore strategies for both the vanishing gradient and exploding gradient problems separately. Let’s start with the latter.

Solving the Exploding Gradient Problem

For exploding gradients, it is possible to use a modified version of the backpropagation algorithm called truncated backpropagation. The truncated backpropagation algorithm limits that number of timesteps that the backproporation will be performed on, stopping the algorithm before the exploding gradient problem occurs.

You can also introduce penalties, which are hard-coded techniques for reduces a backpropagation’s impact as it moves through shallower layers in a neural network.

Lastly, you could introduce gradient clipping, which introduces an artificial ceiling that limits how large the gradient can become in a backpropagation algorithm.

Solving the Vanishing Gradient Problem

Weight initialization is one technique that can be used to solve the vanishing gradient problem. It involves artificially creating an initial value for weights in a neural network to prevent the backpropagation algorithm from assigning weights that are unrealistically small.

You could also use echo state networks, which is a specific type of neural network designed to avoid the vanishing gradient problem. Echo state networks are outside the scope of this course. Having knowledge of their existence is sufficient for now.

The most important solution to the vanishing gradient problem is a specific type of neural network called Long Short-Term Memory Networks (LSTMs), which were pioneered by Sepp Hochreiter and Jürgen Schmidhuber. Recall that Mr. Hochreiter was the scientist who originally discovered the vanishing gradient problem.

LSTMs are used in problems primarily related to speech recognition, with one of the most notable examples being Google using an LSTM for speech recognition in 2015 and experiencing a 49% decrease in transcription errors.

LSTMs are considered to be the go-to neural net for scientists interested in implementing recurrent neural networks. We will be largely focusing on LSTMs through the remainder of this course.

Summary – The Vanishing Gradient Problem

In this section, you learned about the vanishing gradient problem of recurrent neural networks.

Here is a brief summary of what we discussed:

- That Sepp Hochreiter was the first scientist to discover the vanishing gradient problem in recurrent neural networks

- What the vanishing gradient problem (and its cousin, the exploding gradient problem) involves

- The role of

Wrecin vanishing gradient problems and exploding gradient problems - How vanishing gradient problems and exploding gradient problems are solved

- The role of LSTMs as the most common solution to the vanishing gradient problem

Long Short-Term Memory Networks (LSTMs)

Long short-term memory networks (LSTMs) are a type of recurrent neural network used to solve the vanishing gradient problem.

They differ from “regular” recurrent neural networks in important ways.

This tutorial will introduce you to LSTMs. Later in this course, we will build and train an LSTM from scratch.

Table of Contents

You can skip to a specific section of this LSTM tutorial using the table of contents below:

- The History of LSTMs

- How LSTMs Solve The Vanishing Gradient Problem

- How LSTMs Work

- Variations of LSTM Architectures

- The Peephole Variation

- The Coupled Gate Variation

- Other LSTM Variations

- Final Thoughts

The History of LSTMs

As we alluded to in the last section, the two most important figures in the field of LSTMs are Sepp Hochreiter and Jürgen Schmidhuber.

The latter was the former’s PhD supervisor at the Technical University of Munich in Germany.

Hochreiter’s PhD thesis introduced LSTMs to the world for the first time.

How LSTMs Solve The Vanishing Gradient Problem

In the last tutorial, we learned how the Wrec term in the backpropagation algorithm can lead to either a vanishing gradient problem or an exploding gradient problem.

We explored various possible solutions for this problem, including penalties, gradient clipping, and even echo state networks. LSTMs are the best solution.

So how do LSTMs work? They simply change the value of Wrec.

In our explanation of the vanishing gradient problem, you learned that:

- When

Wrecis small, you experience a vanishing gradient problem - When

Wrecis large, you experience an exploding gradient problem

We can actually be much more specific:

- When

Wrec < 1, you experience a vanishing gradient problem - When

Wrec > 1, you experience an exploding gradient problem

This makes sense if you think about the multiplicative nature of the backpropagation algorithm.

If you have a number that is smaller than 1 and you multiply it against itself over and over again, you’ll end up with a number that vanishes. Similarly, multiplying a number greater than 1 against itself many times results in a very large number.

To solve this problem, LSTMs set Wrec = 1. There is certainly more to LSTMS than setting Wrec = 1, but this is definitely the most important change that this specification of recurrent neural networks makes.

How LSTMs Work

This section will explain how LSTMs work. Before proceeding ,it’s worth mentioning that I will be using images from Christopher Olah’s blog post Understanding LSTMs, which was published in August 2015 and has some of the best LSTM visualizations that I have ever seen.

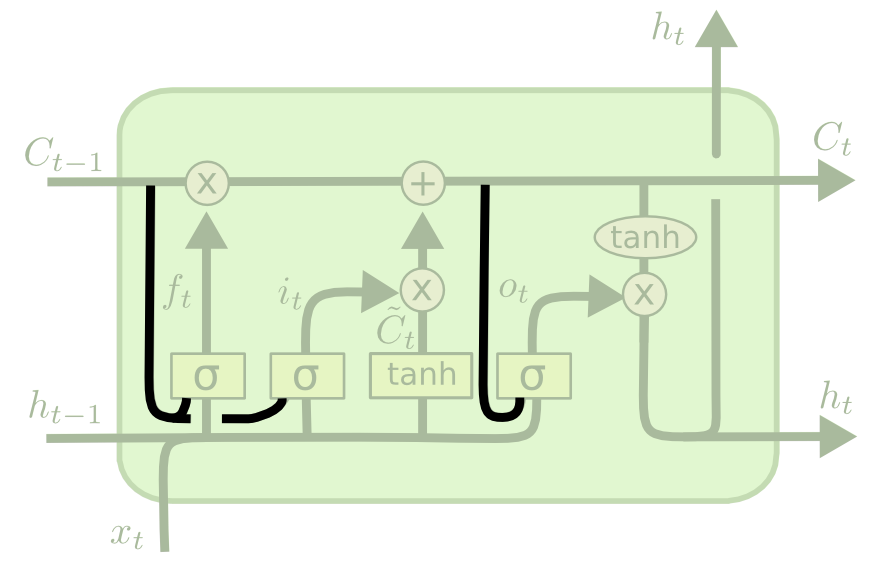

To start, let’s consider the basic version of a recurrent neural network:

This neural network has neurons and synapses that transmit the weighted sums of the outputs from one layer as the inputs of the next layer. A backpropagation algorithm will move backwards through this algorithm and update the weights of each neuron in response to he cost function computed at each epoch of its training stage.

By contrast, here is what an LSTM looks like:

As you can see, an LSTM has far more embedded complexity than a regular recurrent neural network. My goal is to allow you to fully understand this image by the time you’ve finished this tutorial.

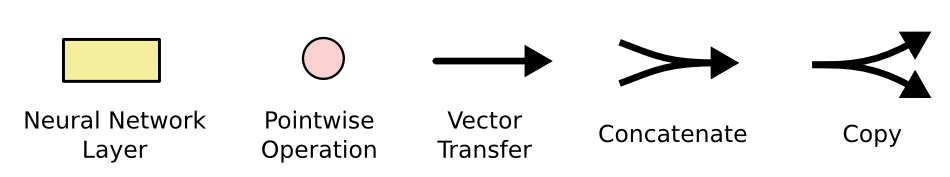

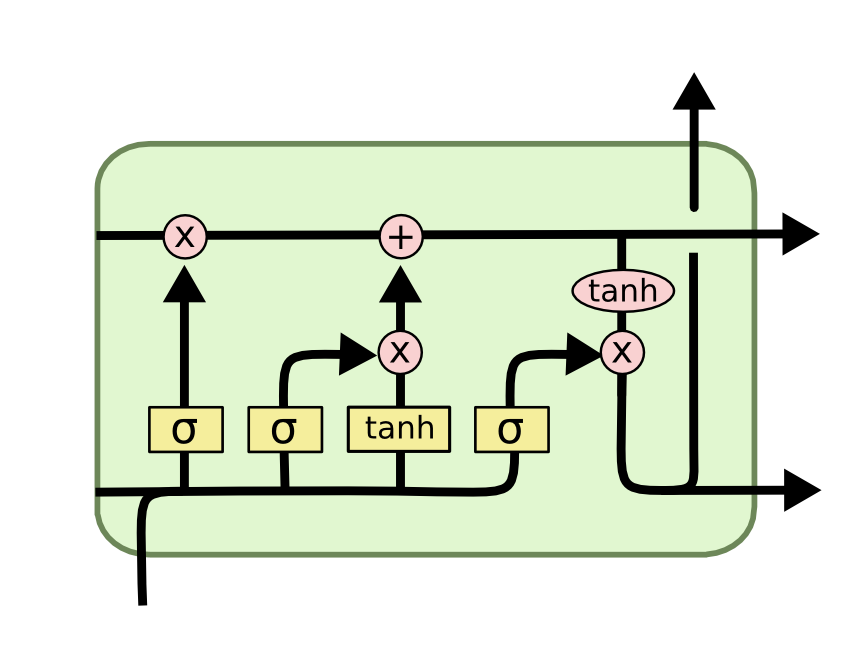

First, let’s get comfortable with the notation used in the image above:

Now that you have a sense of the notation we’ll be using in this LSTM tutorial, we can start examining the functionality of a layer within an LSTM neural net. Each layer has the following appearance:

Before we dig into the functionality of nodes within an LSTM neural network, it’s worth noting that every input and output of these deep learning models is a vector. In Python, this is generally represented by a NumPy array or another one-dimensional data structure.

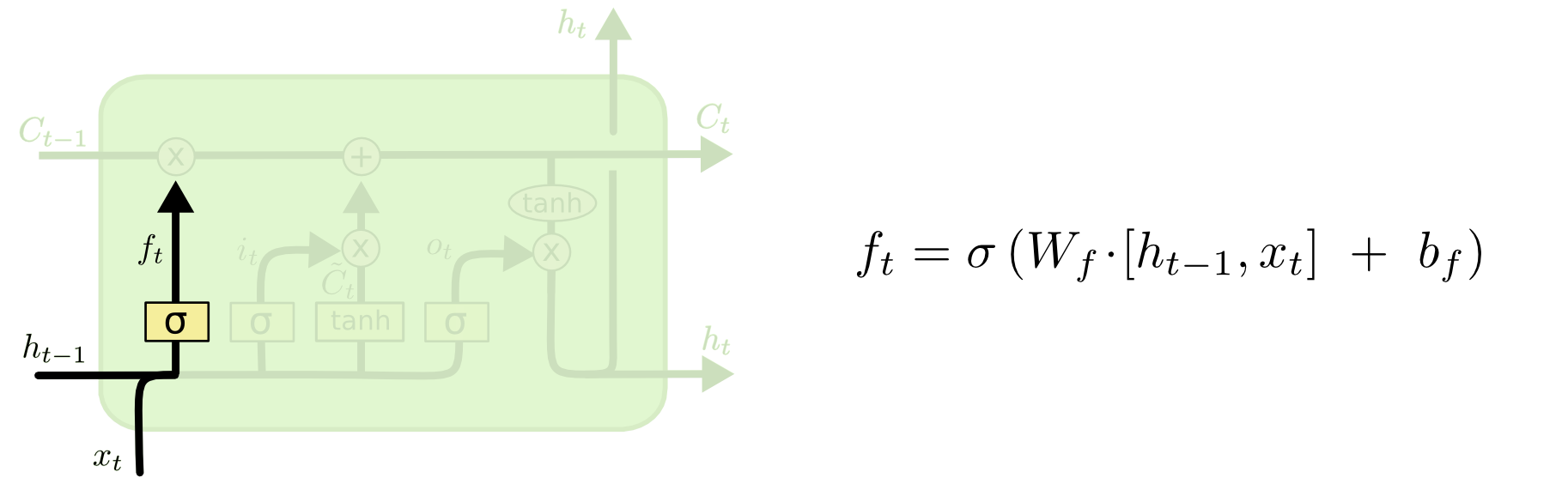

The first thing that happens within an LSTM is the activation function of the forget gate layer. It looks at the inputs of the layer (labelled xt for the observation and ht for the output of the previous layer of the neural network) and outputs either 1 or 0 for every number in the cell state from the previous layer (labelled Ct-1).

Here’s a visualization of the activation of the forget gate layer:

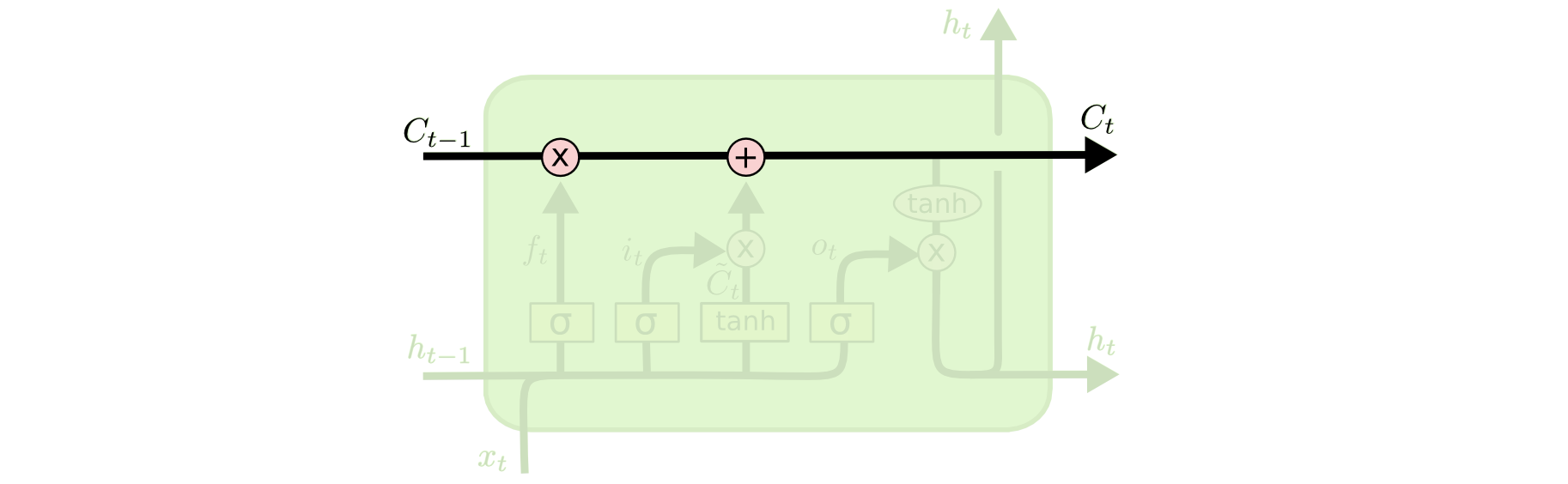

We have not discussed cell state yet, so let’s do that now. Cell state is represented in our diagram by the long horizontal line that runs through the top of the diagram. As an example, here is the cell state in our visualizations:

The cell state’s purpose is to decide what information to carry forward from the different observations that a recurrent neural network is trained on. The decision of whether or not to carry information forward is made by gates — of which the forget gate is a prime example. Each gate within an LSTM will have the following appearance:

The σ character within these gates refers to the Sigmoid function, which you have probably seen used in logistic regression machine learning models. The sigmoid function is used as a type of activation function in LSTMs that determines what information is passed through a gate to affect the network’s cell state.

By definition, the Sigmoid function can only output numbers between 0 and 1. It’s often used to calculate probabilities because of this. In the case of LSTM models, it specifies what proportion of each output should be allowed to influence the sell state.

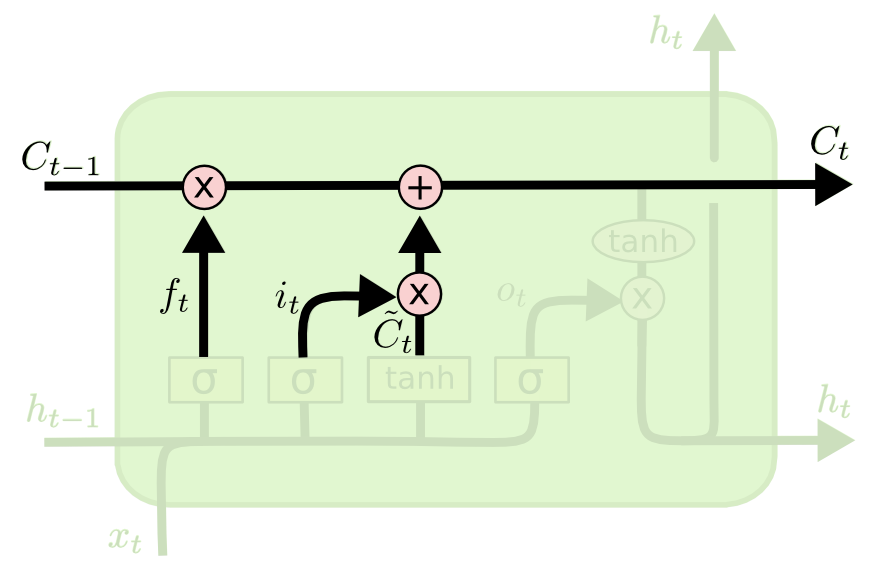

The next two steps of an LSTM model are closely related: the input gate layer and the tanh layer. These layers work together to determine how to update the cell state. At the same time, the last step is completed, which allows the cell to determine what to forget about the last observation in the data set.

Here is a visualization of this process:

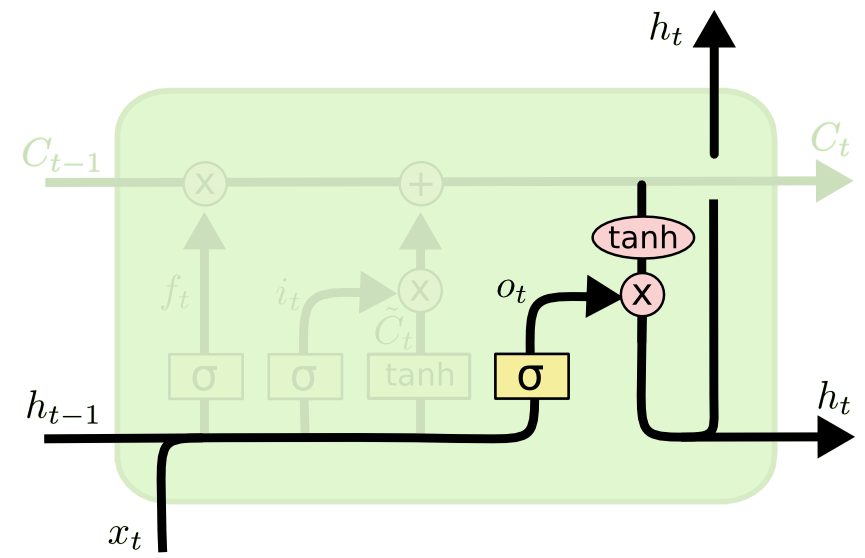

The last step of an LSTM determines the output for this observation (denoted ht). This step runs through both a sigmoid function and a hyperbolic tangent function. It can be visualized as follows:

That concludes the process of training a single layer of an LSTM model. As you might imagine, there is plenty of mathematics under the surface that we have glossed over. The point of this section is to broadly explain how LSTMs work, not for you to deeply understand each operation in the process.

Variations of LSTM Architectures

I wanted to conclude this tutorial by discussing a few different variations of LSTM architecture that are slightly different from the basic LSTM that we’ve discussed so far.

As a quick recap, here is what a generalized node of an LSTM looks like:

The Peephole Variation

Perhaps the most important variation of the LSTM architecture is the peephole variant, which allows the gate layers to read data from the cell state.

Here is a visualization of what the peephole variant might look like:

Note that while this diagram adds a peephole to every gate in the recurrent neural network, you could also add peepholes to some gates and not other gates.

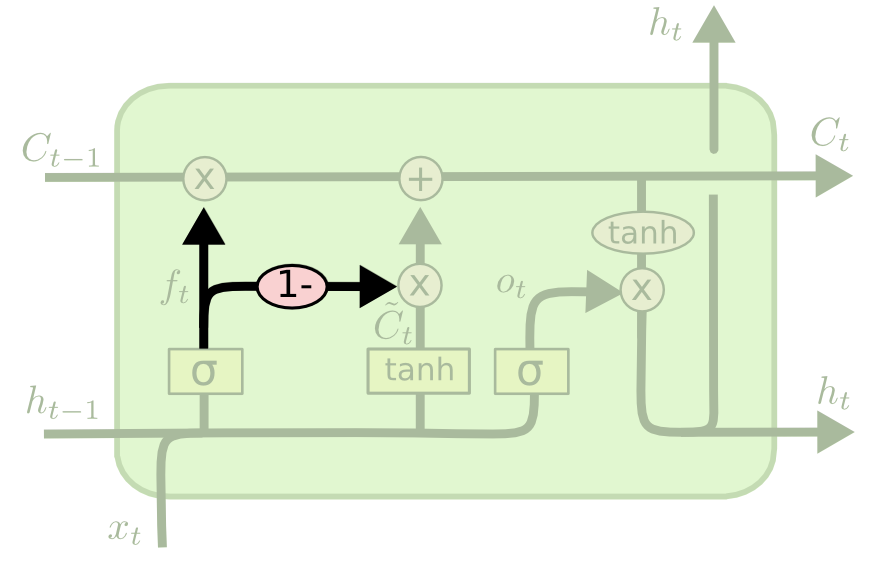

The Coupled Gate Variation

There is another variation of the LSTM architecture where the model makes the decision of what to forget and what to add new information to together. In the original LSTM model, these decisions were made separately.

Here is a visualization of what this architecture looks like:

Other LSTM Variations

These are only two examples of variants to the LSTM architecture. There are many more. A few are listed below:

- Gated Recurrent Units (GRUs)

- Depth Gated RNNs

- Clockwork RNNs

Summary — Long Short-Term Memory Networks

In this tutorial, you had your first exposure to long short-term memory networks (LSTMs).

Here is a brief summary of what you learned:

- A (very) brief history of LSTMs and the role that Sepp Hochreiter and Jürgen Schmidhuber played in their development

- How LSTMs solve the vanishing gradient problem

- How LSTMs work

- The role of gates, sigmoid functions, and the hyperbolic tangent function in LSTMs

- A few of the most popular variations of the LSTM architecture

How To Build And Train A Recurrent Neural Network

So far in our discussion of recurrent neural networks, you have learned:

- The basic intuition behind recurrent neural networks

- The vanishing gradient problem that historically impeded the progress of recurrent neural networks

- How long short-term memory networks (LSTMs) help to solve the vanishing gradient problem

It’s now time to build your first recurrent neural network! More specifically, this tutorial will teach you how to build and train an LSTM to predict the stock price of Facebook (FB).

Table of Contents

You can skip to a specific section of this Python recurrent neural network tutorial using the table of contents below:

- Downloading the Data Set For This Tutorial

- Importing The Libraries You’ll Need For This Tutorial

- Importing Our Training Set Into The Python Script

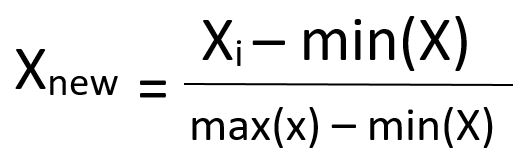

- Applying Feature Scaling To Our Data Set

- Specifying The Number Of Timesteps For Our Recurrent Neural Network

- Finalizing Our Data Sets By Transforming Them Into NumPy Arrays

- Importing Our TensorFlow Libraries

- Building Our Recurrent Neural Network

- Adding Our First LSTM Layer

- Adding Some Dropout Regularization

- Adding Three More LSTM Layers With Dropout Regularization

- Adding The Output Layer To Our Recurrent Neural Network

- Compiling Our Recurrent Neural Network

- Fitting The Recurrent Neural Network On The Training Set

- Making Predictions With Our Recurrent Neural Network

- Importing Our Test Data

- Building The Test Data Set We Need To Make Predictions

- Scaling Our Test Data

- Grouping Our Test Data

- Actually Making Predictions

- The Full Code For This Tutorial

- Final Thoughts

Downloading the Data Set For This Tutorial

To proceed through this tutorial, you will need two download two data sets:

- A set of training data that contains information on Facebook’s stock price from teh start of 2015 to the end of 2019

- A set of test data that contains information on Facebook’s stock price during the first month of 2020

Our recurrent neural network will be trained on the 2015-2019 data and will be used to predict the data from January 2020.

You can download the training data and test data using the links below:

- Training Data

- Test Data

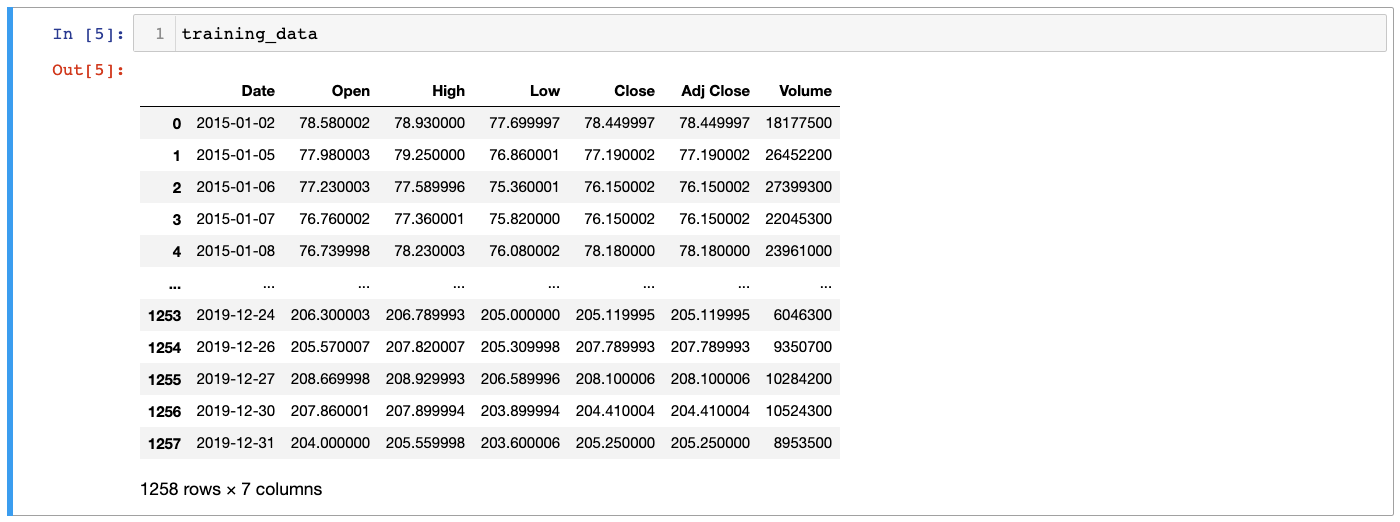

Each of these data sets are simply exports from Yahoo! Finance. They look like this (when opened in Microsoft Excel):

Once the files are downloaded, move them to the directory you’d like to work in and open a Jupyter Notebook.

Importing The Libraries You’ll Need For This Tutorial

This tutorial will depend on a number of open-source Python libraries, including NumPy, pandas, and matplotlib.

Let’s start our Python script by importing some of these libraries:

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

Importing Our Training Set Into The Python Script

The next task that needs to be completed is to import our data set into the Python script.

We will initially import the data set as a pandas DataFrame using the read_csv method. However, since the keras module of TensorFlow only accepts NumPy arrays as parameters, the data structure will need to be transformed post-import.

Let’s start by importing the entire .csv file as a DataFrame:

training_data = pd.read_csv('FB_training_data.csv')

You will notice in looking at the DataFrame that it contains numerous different ways of measuring Facebook’s stock price, including opening price, closing price, high and low prices, and volume information:

We will need to select a specific type of stock price before proceeding. Let’s use Close, which indicates the unadjusted closing price of Facebook’s stock.