Нейросетевой синтез речи своими руками

Время на прочтение

12 мин

Количество просмотров 74K

Синтез речи на сегодняшний день применяется в самых разных областях. Это и голосовые ассистенты, и IVR-системы, и умные дома, и еще много чего. Сама по себе задача, на мой вкус, очень наглядная и понятная: написанный текст должен произноситься так, как это бы сделал человек.

Некоторое время назад в область синтеза речи, как и во многие другие области, пришло машинное обучение. Выяснилось, что целый ряд компонентов всей системы можно заменить на нейронные сети, что позволит не просто приблизиться по качеству к существующим алгоритмам, а даже значительно их превзойти.

Я решил попробовать сделать полностью нейросетевой синтез своими руками, а заодно и поделиться с сообществом своим опытом. Что из этого получилось, можно узнать, заглянув под кат.

Синтез речи

Чтобы построить систему синтеза речи, нужна целая команда специалистов из разных областей. По каждой из них существует целая масса алгоритмов и подходов. Написаны докторские диссертации и толстые книжки с описанием фундаментальных подходов. Давайте для начала поверхностно разберемся с каждой их них.

Лингвистика

- Нормализация текста. Для начала нам нужно развернуть все сокращения, числа и даты в текст. 50е годы XX века должно превратиться в пятидесятые годы двадцатого века, а г. Санкт-Петербург, Большой пр. П.С. в город Санкт-Петербург, Большой проспект Петроградской Стороны. Это должно происходить так естественно, как если бы человека попросили прочитать написанное.

- Подготовка словаря ударений. Расстановка ударений может производиться по правилам языка. В английском ударение часто ставится на первый слог, а в испанском — на предпоследний. При этом из этих правил существует целая масса исключений, не поддающихся какому-то общему правилу. Их обязательно нужно учитывать. Для русского языка в общем смысле правил расстановки ударения вообще не существует, так что без словаря с расставленными ударениями совсем никуда не деться.

- Снятие омографии. Омографы — это слова, которые совпадают в написании, но различаются в произношении. Носитель языка легко расставит ударения: дверной замок и замок на горе. А вот ключ от замка — задача посложнее. Полностью снять омографию без учета контекста невозможно.

Просодика

- Выделение синтагм и расстановка пауз. Синтагма представляет относительно законченный по смыслу отрезок речи. Когда человек говорит, он обычно вставляет паузы между фразами. Нам нужно научиться разделять текст на такие синтагмы.

- Определение типа интонации. Выражение завершенности, вопроса и восклицания — самые простые интонации. А вот выразить иронию, сомнение или воодушевление задача куда сложнее.

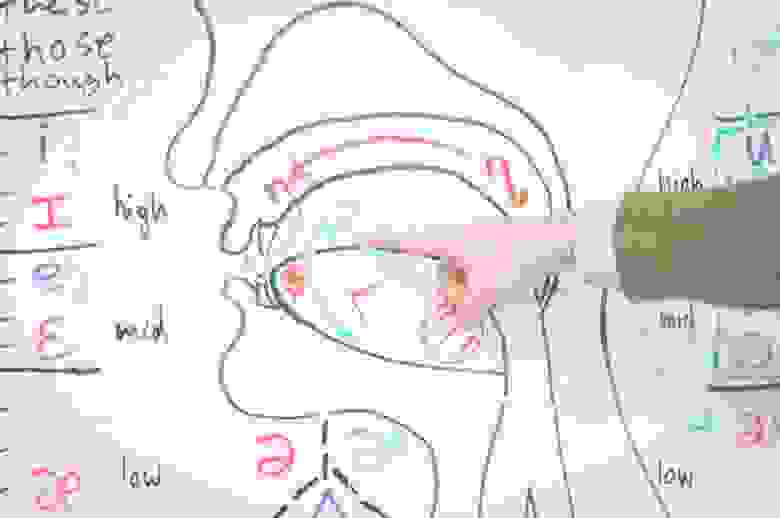

Фонетика

- Получение транскрипции. Так как в конечном итоге мы работаем с произнесением, а не с написанием, то очевидно вместо букв (графем), логично использовать звуки (фонемы). Преобразование графемной записи в фонемную — отдельная задача, состоящая из множества правил и исключений.

- Вычисление параметров интонации. В этот момент нужно решить как будет меняться высота основного тона и скорость произнесения в зависимости от расставленных пауз, подобранной последовательности фонем и типа выражаемой интонации. Помимо основного тона и скорости есть и другие параметры, с которыми можно долго экспериментировать.

Акустика

- Подбор звуковых элементов. Системы синтеза оперируют так называемыми аллофонами — реализациями фонемы, зависящими от окружения. Записи из обучающих данных нарезаются на кусочки по фонемной разметке, которые образуют аллофонную базу. Каждый аллофон характеризуется набором параметров, таких как контекст (фонемы соседи), высота основного тона, длительность и прочие. Сам процесс синтеза представляет собой подбор правильной последовательности аллофонов, наиболее подходящих в текущих условиях.

- Модификация и звуковые эффекты. Для получившихся записей иногда нужна постобработка, какие-то специальные фильтры, делающие синтезируемую речь чуть ближе к человеческой или исправляющие какие-то дефекты.

Если вдруг вам показалось, что все это можно упростить, прикинуть в голове или быстро подобрать какие-то эвристики для отдельных модулей, то просто представьте, что вам нужно сделать синтез на хинди. Если вы не владеете языком, то вам даже не удастся оценить качество вашего синтеза, не привлекая кого-то, кто владел бы языком на нужном уровне. Мой родной язык русский, и я слышу, когда синтез ошибается в ударениях или говорит не с той интонацией. Но в тоже время, весь синтезированный английский для меня звучит примерно одинаково, не говоря уже о более экзотических языках.

Реализации

Мы попытаемся найти End-2-End (E2E) реализацию синтеза, которая бы взяла на себя все сложности, связанные с тонкостями языка. Другими словами, мы хотим построить систему, основанную на нейронных сетях, которая бы на вход принимала текст, а на выходе давала бы синтезированную речь. Можно ли обучить такую сеть, которая позволила бы заменить целую команду специалистов из узких областей на команду (возможно даже из одного человека), специализирующуюся на машинном обучении?

На запрос end2end tts Google выдает целую массу результатов. Во главе — реализация Tacotron от самого Google. Самым простым мне показалось идти от конкретных людей на Github, которые занимаются исследованиям в этой области и выкладывают свои реализации различных архитектур.

Я бы выделил троих:

- Kyubyong Park

- Keith Ito

- Ryuichi Yamamoto

Загляните к ним в репозитории, там целый кладезь информации. Архитектур и подходов к задаче E2E-синтеза довольно много. Среди основных:

- Tacotron (версии 1, 2).

- DeepVoice (версии 1, 2, 3).

- Char2Wav.

- DCTTS.

- WaveNet.

Нам нужно выбрать одну. Я выбрал Deep Convolutional Text-To-Speech (DCTTS) от Kyubyong Park в качестве основы для будущих экспериментов. Оригинальную статью можно посмотреть по ссылке. Давайте поподробнее рассмотрим реализацию.

Автор выложил результаты работы синтеза по трем различным базам и на разных стадиях обучения. На мой вкус, как не носителя языка, они звучат весьма прилично. Последняя из баз на английском языке (Kate Winslet’s Audiobook) содержит всего 5 часов речи, что для меня тоже является большим преимуществом, так как моя база содержит примерно сопоставимое количество данных.

Через некоторое время после того, как я обучил свою систему, в репозитории появилась информация о том, что автор успешно обучил модель для корейского языка. Это тоже довольно важно, так как языки могут сильно разниться и робастность по отношению к языку — это приятное дополнение. Можно ожидать, что в процессе обучения не потребуется особого подхода к каждому набору обучающих данных: языку, голосу или еще каким-то характеристикам.

Еще один важный момент для такого рода систем — это время обучения. Tacotron на том железе, которое у меня есть, по моим оценкам учился бы порядка 2 недель. Для прототипирования на начальном уровне мне показалось это слишком ресурсоемким. Педали, конечно, крутить не пришлось бы, но на создание какого-то базового прототипа потребовалось бы очень много календарного времени. DCTTS в финальном варианте учится за пару дней.

У каждого исследователя есть набор инструментов, которыми он пользуется в своей работе. Каждый подбирает их себе по вкусу. Я очень люблю PyTorch. К сожалению, на нем реализации DCTTS я не нашел, и пришлось использовать TensorFlow. Возможно в какой-то момент выложу свою реализацию на PyTorch.

Данные для обучения

Хорошая база для реализации синтеза — это основной залог успеха. К подготовке нового голоса подходят очень основательно. Профессиональный диктор произносит заранее подготовленные фразы в течение многих часов. Для каждого произнесения нужно выдержать все паузы, говорить без рывков и замедлений, воспроизвести правильный контур основного тона и все это в купе с правильной интонацией. Кроме всего прочего, не все голоса одинаково приятно звучат.

У меня на руках была база порядка 8 часов, записанная профессиональным диктором. Сейчас мы с коллегами обсуждаем возможность выложить этот голос в свободный доступ для некоммерческого использования. Если все получится, то дистрибутив с голосом помимо самих записей будет включать в себя точные текстовки для каждой из них.

Начнем

Мы хотим создать сеть, которая на вход принимала бы текст, а на выходе давала бы синтезированный звук. Обилие реализаций показывает, что это возможно, но есть конечно и ряд оговорок.

Основные параметры системы обычно называют гиперпараметрами и выносят в отдельный файл, который называется соответствующим образом: hparams.py или hyperparams.py, как в нашем случае. В гиперпараметры выносится все, что можно покрутить, не трогая основной код. Начиная от директорий для логов, заканчивая размерами скрытых слоев. После этого гиперпараметры в коде используются примерно вот так:

from hyperparams import Hyperparams as hp

batch_size = hp.B # размер батча берем из гиперпараметровДалее по тексту все переменные имеющие префикс hp. берутся именно из файла гиперпараметров. Подразумевается, что эти параметры не меняются в процессе обучения, поэтому будьте осторожны перезапуская что-то с новыми параметрами.

Текст

Для обработки текста обычно используются так называемый embedding-слой, который ставится самым первым. Суть его простая — это просто табличка, которая каждому символу из алфавита ставит в соответствие некий вектор признаков. В процессе обучения мы подбираем оптимальные значения для этих векторов, а когда синтезируем по готовой модели, просто берем значения из этой самой таблички. Такой подход применяется в уже довольно широко известных Word2Vec, где строится векторное представление для слов.

Для примера возьмем простой алфавит:

['a', 'b', 'c']В процессе обучения мы выяснили, что оптимальные значения каждого их символов вот такие:

{

'a': [0, 1],

'b': [2, 3],

'c': [4, 5]

}Тогда для строчки aabbcc после прохождения embedding-слоя мы получим следующую матрицу:

[[0, 1], [0, 1], [2, 3], [2, 3], [4, 5], [4, 5]]Эта матрица дальше подается на другие слои, которые уже не оперируют понятием символ.

В этот момент мы видим первое ограничение, которое у нас появляется: набор символов, который мы можем отправлять на синтез, ограничен. Для каждого символа должно быть какое-то ненулевое количество примеров в обучающих данных, лучше с разным контекстом. Это значит, что нам нужно быть осторожными в выборе алфавита.

В своих экспериментах я остановился на варианте:

# Алфавит задается в файле с гиперпараметрами

vocab = "E абвгдеёжзийклмнопрстуфхцчшщъыьэюя-" Это алфавит русского языка, дефис, пробел и обозначение конца строки. Тут есть несколько важных моментов и допущений:

- Я не добавлял в алфавит знаки препинания. С одной стороны, мы действительно их не произносим. С другой, по знакам препинания мы делим фразу на части (синтагмы), разделяя их паузами. Как система произнесет казнить нельзя помиловать?

- В алфавите нет цифр. Мы ожидаем, что они будут развернуты в числительные перед подачей на синтез, то есть нормализованы. Вообще все E2E-архитектуры, которые я видел, требуют именно нормализованный текст.

- В алфавите нет латинских символов. Английский система уметь произносить не будет. Можно попробовать транслитерацию и получить сильный русский акцент — пресловутый лет ми спик фром май харт.

- В алфавите есть буква ё. В данных, на который я обучал систему, она стояла там, где нужно, и я решил этот расклад не менять. Однако, в тот момент, когда я оценивал получившиеся результаты, выяснилось, что теперь перед подачей на синтез эту букву тоже нужно ставить правильно, иначе система произносит именно е, а не ё.

В будущих версиях можно уделить каждому из пунктов более пристальное внимание, а пока оставим в таком немного упрощенном виде.

Звук

Почти все системы оперируют не самим сигналом, а разного рода спектрами полученными на окнах с определенным шагом. Я не буду вдаваться в подробности, по этой теме довольно много разного рода литературы. Сосредоточимся на реализации и использованию. В реализации DCTTS используются два вида спектров: амплитудный спектр и мел-спектр.

Считаются они следующим образом (код из этого листинга и всех последующих взят из реализации DCTTS, но видоизменен для наглядности):

# Получаем сигнал фиксированной частоты дискретизации

y, sr = librosa.load(wavename, sr=hp.sr)

# Обрезаем тишину по краям

y, _ = librosa.effects.trim(y)

# Pre-emphasis фильтр

y = np.append(y[0], y[1:] - hp.preemphasis * y[:-1])

# Оконное преобразование Фурье

linear = librosa.stft(y=y,

n_fft=hp.n_fft,

hop_length=hp.hop_length,

win_length=hp.win_length)

# Амплитудный спектр

mag = np.abs(linear)

# Мел-спектр

mel_basis = librosa.filters.mel(hp.sr, hp.n_fft, hp.n_mels)

mel = np.dot(mel_basis, mag)

# Переводим в децибелы

mel = 20 * np.log10(np.maximum(1e-5, mel))

mag = 20 * np.log10(np.maximum(1e-5, mag))

# Нормализуем

mel = np.clip((mel - hp.ref_db + hp.max_db) / hp.max_db, 1e-8, 1)

mag = np.clip((mag - hp.ref_db + hp.max_db) / hp.max_db, 1e-8, 1)

# Транспонируем и приводим к нужным типам

mel = mel.T.astype(np.float32)

mag = mag.T.astype(np.float32)

# Добиваем нулями до правильных размерностей

t = mel.shape[0]

num_paddings = hp.r - (t % hp.r) if t % hp.r != 0 else 0

mel = np.pad(mel, [[0, num_paddings], [0, 0]], mode="constant")

mag = np.pad(mag, [[0, num_paddings], [0, 0]], mode="constant")

# Понижаем частоту дискретизации для мел-спектра

mel = mel[::hp.r, :]

Для вычислений почти во всех проектах E2E-синтеза используется библиотека LibROSA (https://librosa.github.io/librosa/). Она содержит много полезного, рекомендую заглянуть в документацию и посмотреть, что в ней есть.

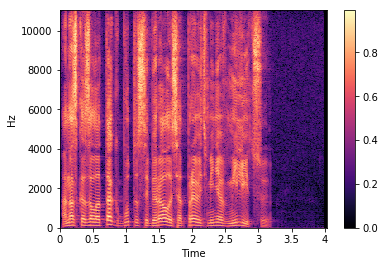

Теперь давайте посмотрим как амплитудный спектр (magnitude spectrum) выглядит на одном из файлов из базы, которую я использовал:

Такой вариант представления оконных спекторов называется спектрограммой. На оси абсцисс располагается время в секундах, на оси ординат — частота в герцах. Цветом выделяется амплитуда спектра. Чем точка ярче, тем значение амплитуды больше.

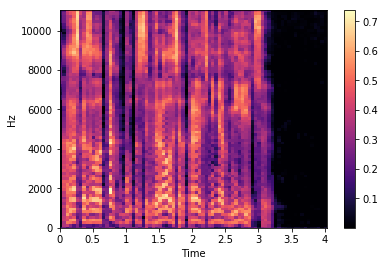

Мел-спектр — это амплитудный спектр, но взятый на мел-шкале с определенным шагом и окном. Количество шагов мы задаем заранее, в большинстве реализаций для синтеза используется значение 80 (задается параметром hp.n_mels). Переход к мел-спектру позволяет сильно сократить количество данных, но этом сохранить важные для речевого сигнала характеристики. Мел-спектрограмма для того же файла выглядит следующим образом:

Обратите внимание на прореживание мел-спектров во времени на последней строке листинга. Мы берем только каждый 4 вектор (hp.r == 4), соответственно уменьшая тем самым частоту дискретизации. Синтез речи сводится к предсказанию мел-спектров по последовательности символов. Идея простая: чем меньше сети приходится предсказывать, тем лучше она будет справляться.

Хорошо, мы можем получить спектрограмму по звуку, но послушать мы ее не можем. Соответственно нам нужно уметь восстанавливать сигнал обратно. Для этих целей в системах часто используется алгоритм Гриффина-Лима и его более современные интерпретации (к примеру, RTISILA, ссылка). Алгоритм позволяет восстановить сигнал по его амплитудным спектрам. Реализация, которую использовал я:

def griffin_lim(spectrogram, n_iter=hp.n_iter):

x_best = copy.deepcopy(spectrogram)

for i in range(n_iter):

x_t = librosa.istft(x_best,

hp.hop_length,

win_length=hp.win_length,

window="hann")

est = librosa.stft(x_t,

hp.n_fft,

hp.hop_length,

win_length=hp.win_length)

phase = est / np.maximum(1e-8, np.abs(est))

x_best = spectrogram * phase

x_t = librosa.istft(x_best,

hp.hop_length,

win_length=hp.win_length,

window="hann")

y = np.real(x_t)

return yА сигнал по амплитудной спектрограмме можно восстановить вот так (шаги, обратные получению спектра):

# Транспонируем

mag = mag.T

# Денормализуем

mag = (np.clip(mag, 0, 1) * hp.max_db) - hp.max_db + hp.ref_db

# Возвращаемся от децибел к аплитудам

mag = np.power(10.0, mag * 0.05)

# Восстанавливаем сигнал

wav = griffin_lim(mag**hp.power)

# De-pre-emphasis фильтр

wav = signal.lfilter([1], [1, -hp.preemphasis], wav)Давайте попробуем получить амплитудный спектр, восстановить его обратно, а затем послушать.

Оригинал:

Восстановленный сигнал:

На мой вкус, результат стал хуже. Авторы Tacotron (первая версия также использует этот алгоритм) отмечали, что использовали алгоритм Гриффина-Лима как временное решение для демонстрации возможностей архитектуры. WaveNet и ему подобные архитектуры позволяют синтезировать речь лучшего качества. Но они более тяжеловесные и требуют определенных усилий для обучения.

Обучение

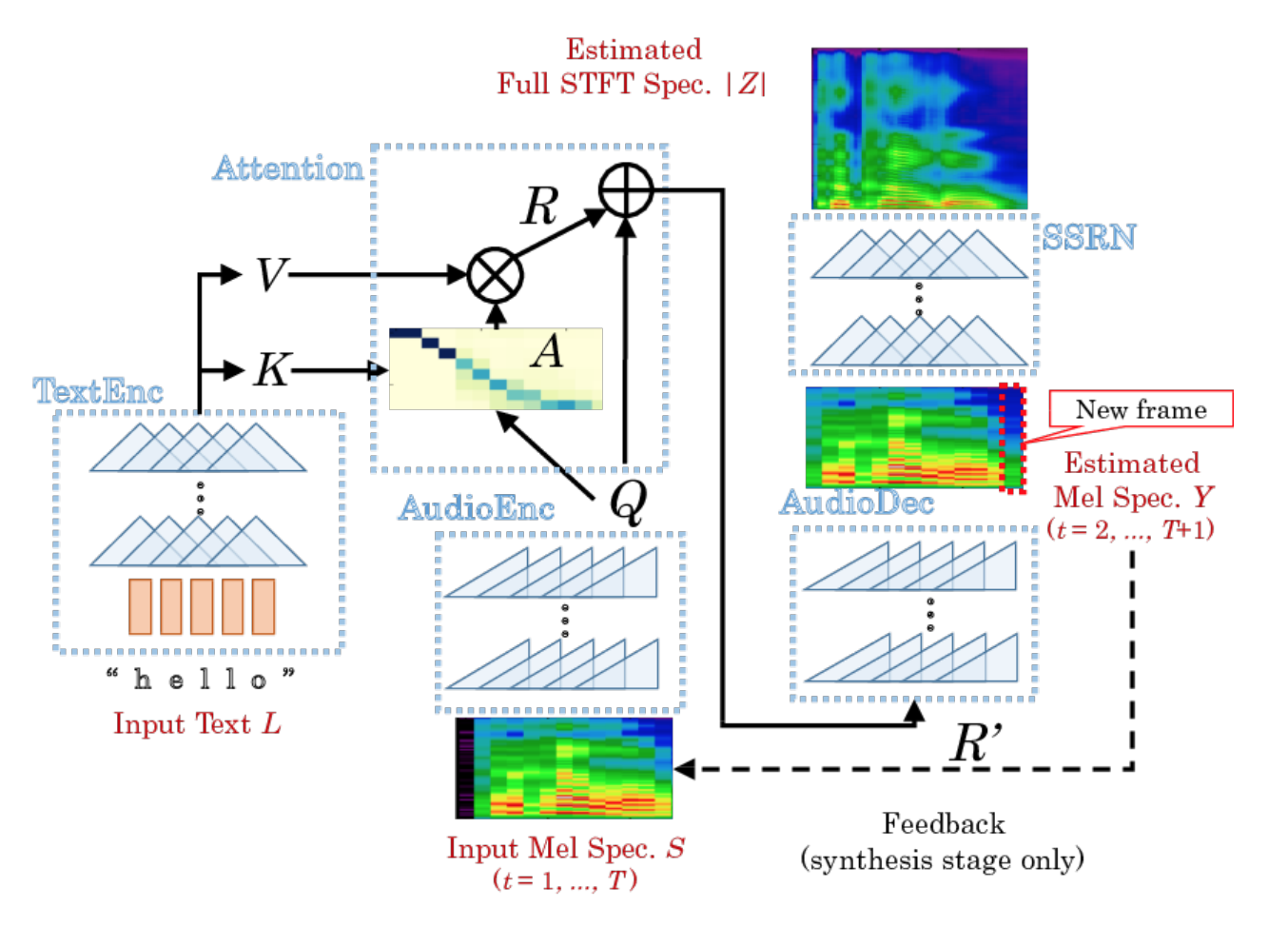

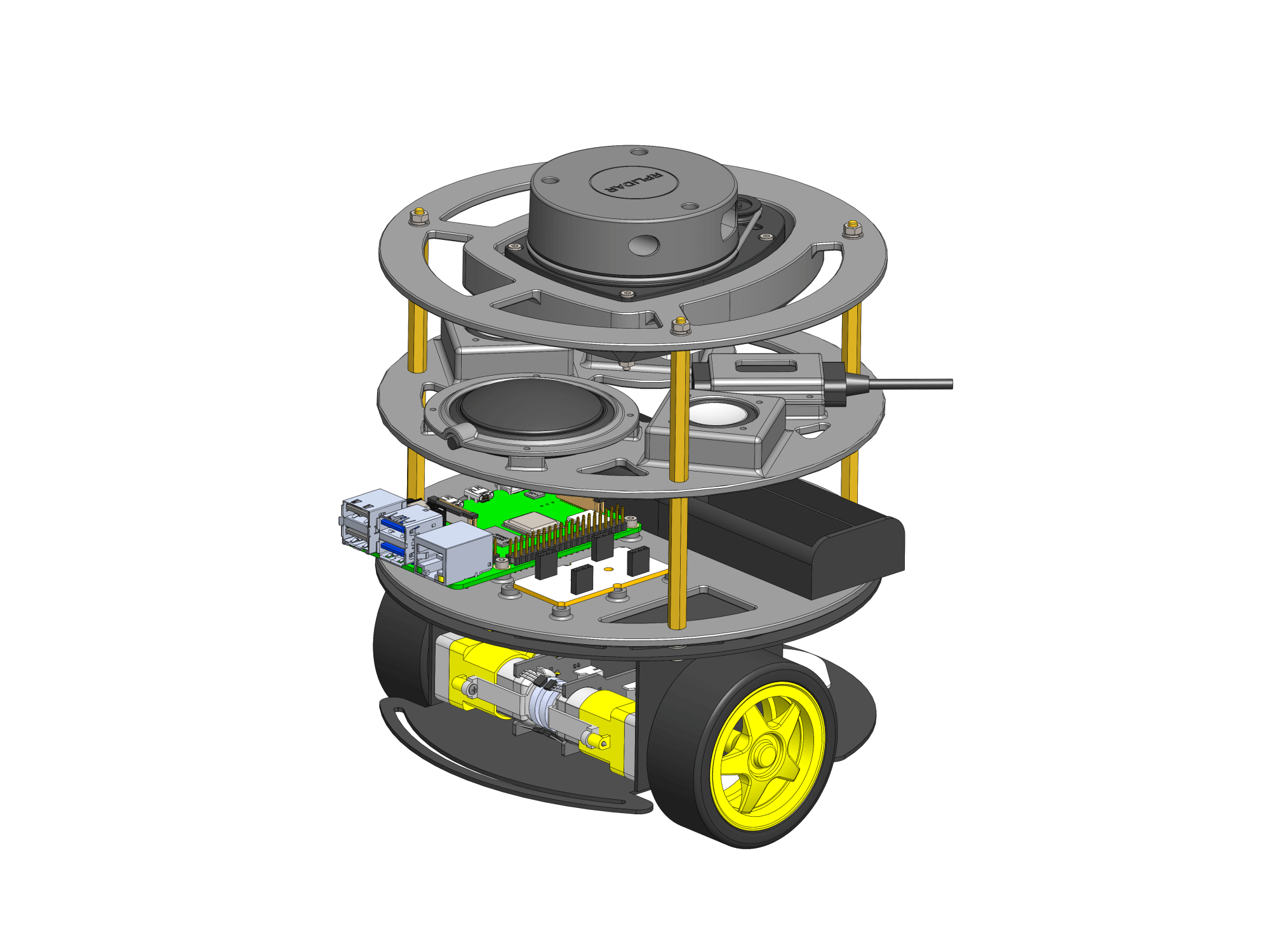

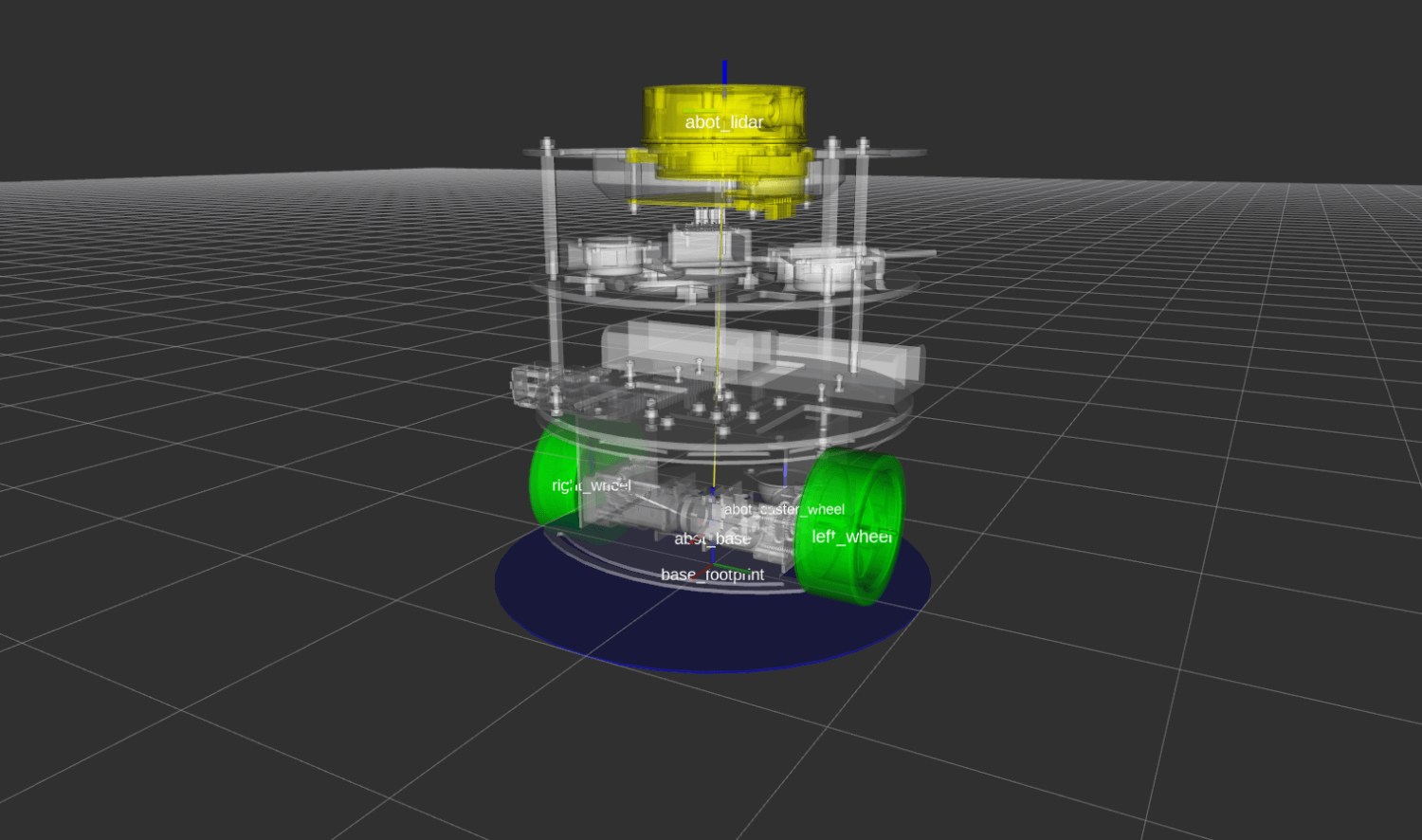

DCTTS, который мы выбрали, состоит из двух практически независимых нейронных сетей: Text2Mel и Spectrogram Super-resolution Network (SSRN).

Text2Mel предсказывает мел-спектр по тексту, используя механизм внимания (Attention), который увязывает два энкодера (TextEnc, AudioEnc) и один декодер (AudioDec). Обратите внимание, что Text2Mel восстанавливает именно разреженный мел-спектр.

SSRN восстанавливает из мел-спектра полноценный амплитудный спектр, учитывая пропуски кадров и восстанавливая частоту дискретизации.

Последовательность вычислений довольно подробно описана в оригинальной статье. К тому же есть исходный код реализации, так что всегда можно отладиться и вникнуть в тонкости. Обратите внимание, что автор реализации отошел в некоторых местах от статьи. Я бы выделил два момента:

- Появились дополнительные слои для нормализации (normalization layers), без которых, по словам автора, ничего не работало.

- В реализации используется механизм исключения (dropout) для лучшей регуляризации. В статье этого нет.

Я взял голос, включающий в себя 8 часов записей (несколько тысяч файлов). Оставил только записи, которые:

- В текстовках содержат только буквы, пробелы и дефисы.

- Длина текстовок не превышает hp.max_N.

- Длина мел-спектров после разреживания не превышает hp.max_T.

У меня получилось чуть больше 5 часов. Посчитал для всех записей нужные спекты и поочередно запустил обучение Text2Mel и SSRN. Все это делается довольно безхитростно:

$ python prepro.py

$ python train.py 1

$ python train.py 2Обратите внимание, что в оригинальном репозитории prepro.py именуется как prepo.py. Мой внутренний перфекционист не смог этого терпеть, так что я его переименовал.

DCTTS содержит только сверточные слои, и в отличие от RNN реализаций, вроде Tacotron, учится значительно быстрее.

На моей машине с Intel Core i5-4670, 16 Gb RAM и GeForce 1080 на борту 50 тыс. шагов для Text2Mel учится за 15 часов, а 75 тыс. шагов для SSRN — за 5 часов. Время требуемое на тысячу шагов в процессе обучения у меня почти не менялось, так что можно легко прикинуть, сколько потребуется времени на обучение с большим количеством шагов.

Размер батча можно регулировать параметром hp.B. Периодически процесс обучения у меня валился с out-of-memory, так что я просто делил на 2 размер батча и перезапускал обучение с нуля. Полагаю, что проблема кроется где-то в недрах TensorFlow (я использовал не самый свежий) и тонкостях реализации батчинга. Я с этим разбираться не стал, так как на значении 8 все падать перестало.

Результат

После того, как модели обучились, можно наконец запустить и синтез. Для этого заполняем файлик с фразами и запускаем:

$ python synthesize.pyЯ немного поправил реализацию, чтобы генерировать фразы из нужного файла.

Результаты в виде WAV-файлов будут сохранены в директорию samples. Вот примеры синтеза системой, которая получилась у меня:

Выводы и ремарки

Результат превзошел мои личные ожидания по качеству. Система расставляет ударения, речь получается разборчивой, а голос узнаваем. В целом получилось неплохо для первой версии, особенно с учетом того, что для обучения использовалось всего 5 часов обучающих данных.

Остаются вопросы по управляемости таким синтезом. Пока невозможно даже исправить ударение в слове, если оно неверное. Мы жестко завязаны на максимальную длину фразы и размер мел-спектрограммы. Нет возможности управлять интонацией и скоростью воспроизведения.

Я не выкладывал мои изменения в коде оригинальной реализации. Они коснулись только загрузки обучающих данных и фраз для синтеза уже по готовой системе, а также значений гиперпараметров: алфавит (hp.vocab) и размер батча (hp.B). В остальном реализация осталась оригинальная.

В рамках рассказа я совсем не коснулся темы продакшн реализации таких систем, до этого полностью E2E-системам синтеза речи пока очень далеко. Я использовал GPU c CUDA, но даже в этом случае все работает медленнее реального времени. На CPU все работает просто неприлично медленно.

Все эти вопросы будут решаться в ближайшие годы крупными компаниями и научными сообществами. Уверен, что это будет очень интересно.

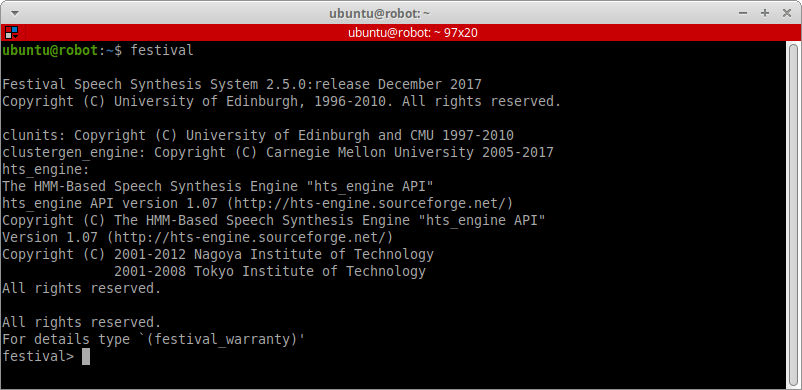

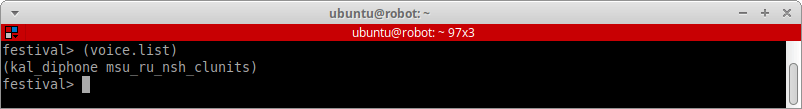

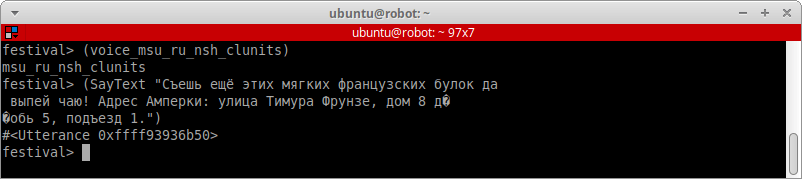

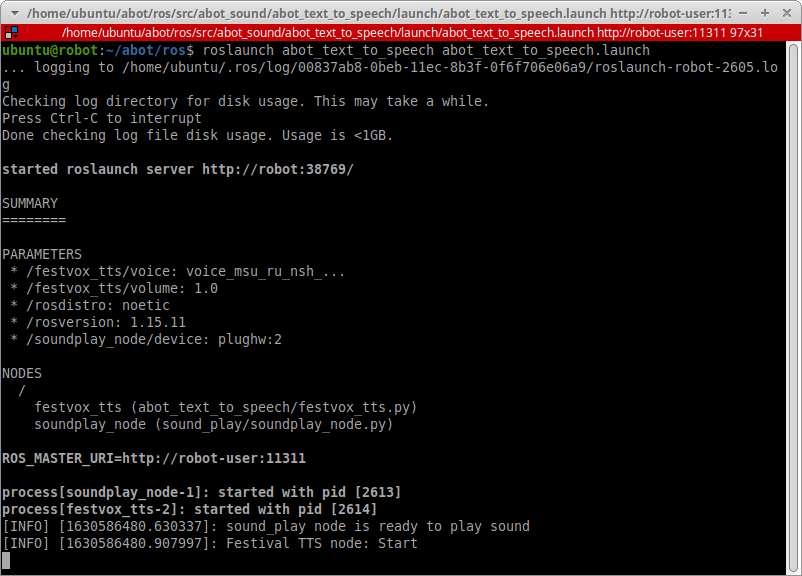

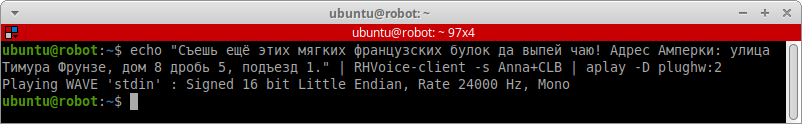

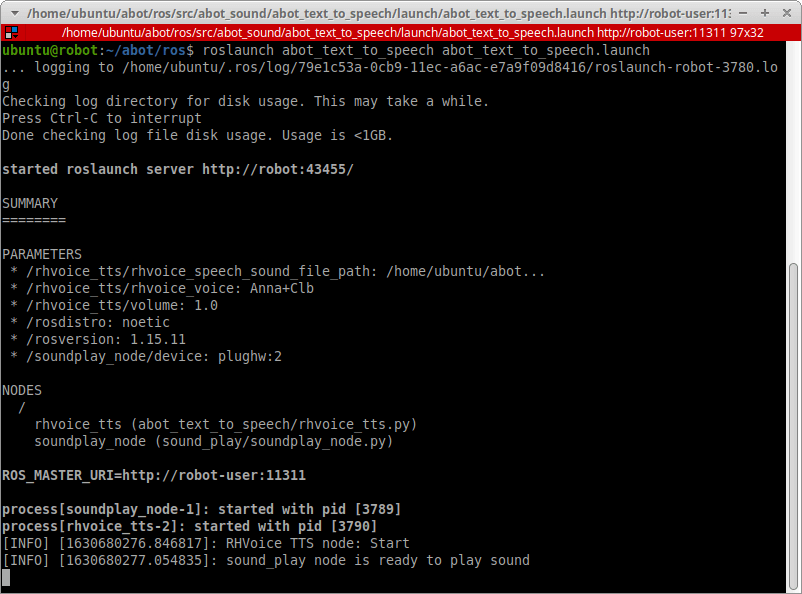

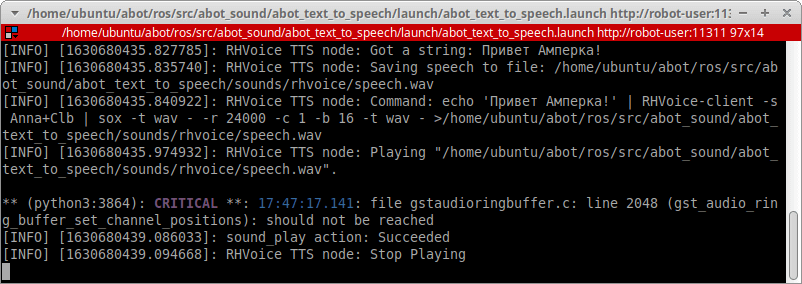

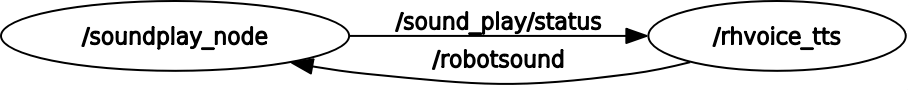

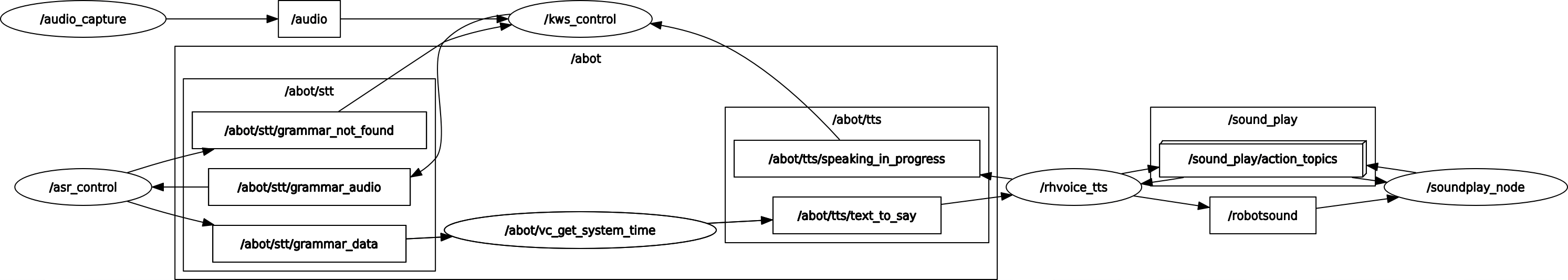

Озвучиваем системное время и любой текст в Windows и Linux. Используем pytts3, espeak, RHVoice, gTTS, Speech dispatcher.

https://gbcdn.mrgcdn.ru/uploads/post/1991/og_image/84f8204b6001e08386ade835e344324a.png

Синтез речи может пригодиться вам в работе над мобильным помощником, умным домом на Raspberry Pi, искусственным интеллектом, игрой, системой уведомлений и звуковым интерфейсом. Голосовые сообщения донесут информацию до пользователя, которому некогда читать текст. Кроме того, если программа умеет озвучивать свой интерфейс, она доступна незрячим и слабовидящим. Есть системы управления компьютером без опоры на зрение. Одна из самых популярных — NVDA (NonVisual Desktop Access) — написана на Python с добавлением C++.

Давайте посмотрим, как использовать text-to-speech (TTS) в Python и подключать синтезаторы голоса к вашей программе. Эту статью я хотела назвать «Говорящая консоль», потому что мы будем писать консольное приложение для Windows, Linux, а потенциально — и MacOS. Потом решила выбрать более общее название, ведь от наличия GUI суть не меняется. На всякий случай поясню: консоль в данном случае — терминал Linux или знакомая пользователям Windows командная строка.

Цель выберем очень скромную: создадим приложение, которое будет каждую минуту озвучивать текущее системное время.

Готовим поляну

Прежде чем писать и тестировать код, убедимся, что операционная система готова к синтезу речи, в том числе на русском языке.

Чтобы компьютер заговорил, нужны:

- голосовой движок (синтезатор речи) с поддержкой нужных нам языков,

- голоса дикторов для этого движка.

В Windows есть штатный речевой интерфейс Microsoft Speech API (SAPI). Голоса к нему выпускают, помимо Microsoft, сторонние производители: Nuance Communications, Loquendo, Acapela Group, IVONA Software.

Есть и свободные кроссплатформенные голосовые движки:

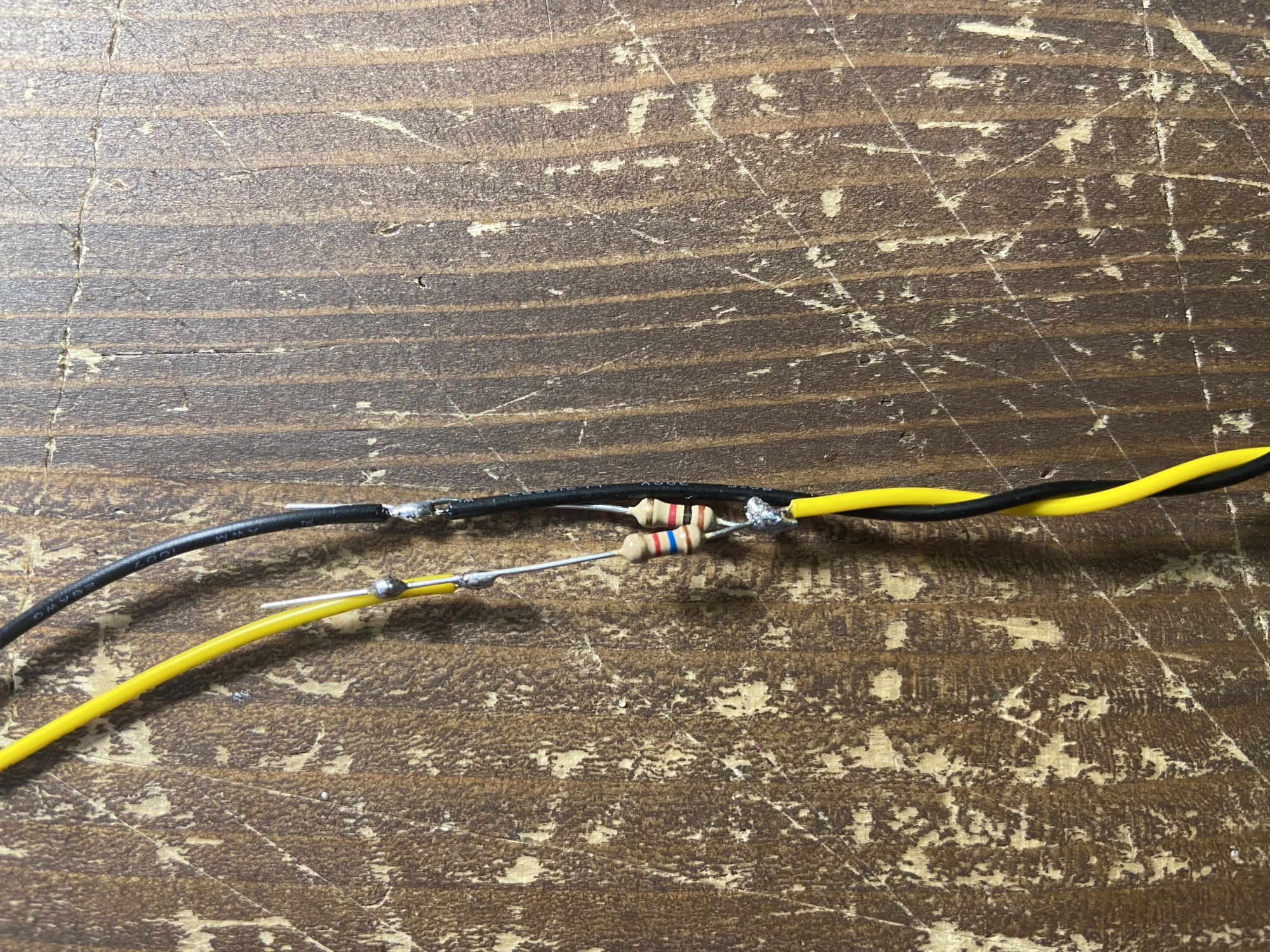

- RHVoice от Ольги Яковлевой — имеет четыре голоса для русского языка (один мужской и три женских), а также поддерживает татарский, украинский, грузинский, киргизский, эсперанто и английский. Работает в Windows, GNU/Linux и Android.

- eSpeak и его ответвление — eSpeak NG — c поддержкой более 100 языков и диалектов, включая даже латынь. NG означает New Generation — «новое поколение». Эта версия разрабатывается сообществом с тех пор, как автор оригинальной eSpeak перестал выходить на связь. Система озвучит ваш текст в Windows, Android, Linux, Mac, BSD. При этом старый eSpeak стабилен в ОС Windows 7 и XP, а eSpeak NG совместим с Windows 8 и 10.

В статье я ориентируюсь только на перечисленные свободные синтезаторы, чтобы мы могли писать кроссплатформенный код и не были привязаны к проприетарному софту.

По качеству голоса RHVoice неплох и к нему быстро привыкаешь, а вот eSpeak очень специфичен и с акцентом. Зато eSpeak запускается на любом утюге и подходит как вариант на крайний случай, когда ничто другое не работает или не установлено у пользователя.

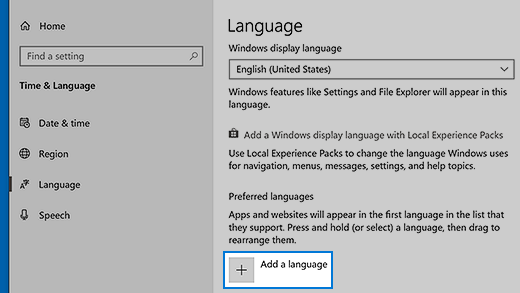

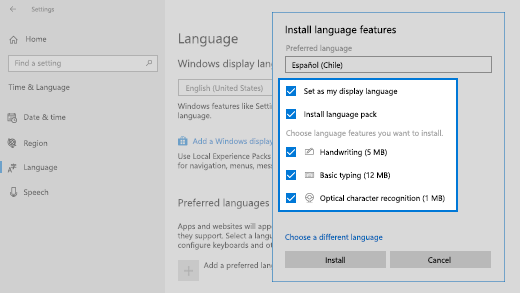

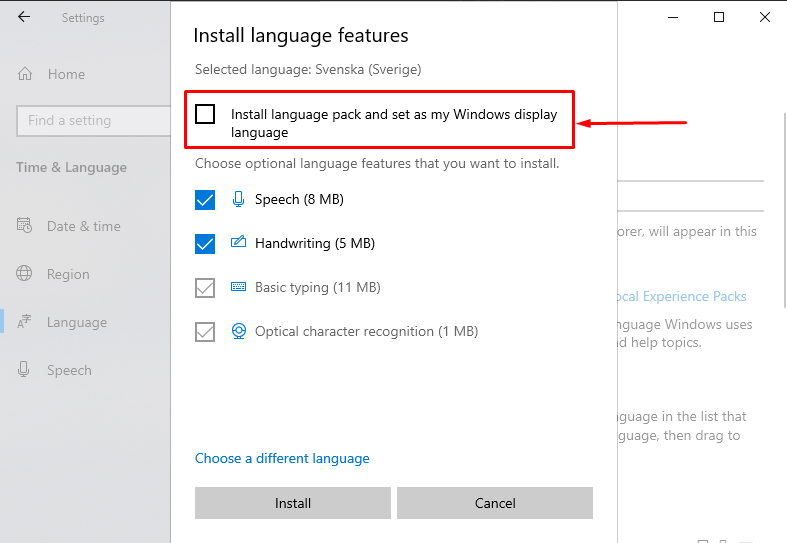

Установка речевых движков, голосов и модулей в Windows

С установкой синтезаторов в Windows проблем возникнуть не должно. Единственный нюанс — для русского голоса eSpeak и eSpeak NG нужно скачать расширенный словарь произношения. Распакуйте архив в подкаталог espeak-data или espeak-ng-data в директории программы. Теперь замените старый словарь новым: переименуйте ru_dict-48 в ru_dict, предварительно удалив имеющийся файл с тем же именем (ru_dict).

Теперь установите модули pywin32, python-espeak и py-espeak-ng, которые потребуются нам для доступа к возможностям TTS:

pip install pywin32 python-espeak pyttsx3 py-espeak-ng

Если у вас на компьютере соседствуют Python 2 и 3, здесь и далее пишите «pip3», а при запуске скриптов — «python3».

Установка eSpeak(NG) в Linux

Подружить «пингвина» с eSpeak, в том числе NG, можно за минуту:

sudo apt-get install espeak-ng python-espeak

pip3 install py-espeak-ng pyttsx3

Дальше загружаем и распаковываем словарь ru_dict с официального сайта:

wget http://espeak.sourceforge.net/data/ru_dict-48.zip

unzip ru_dict-48.zip

Теперь ищем адрес каталога espeak-data (или espeak-ng-data) где-то в /usr/lib/ и перемещаем словарь туда. В моем случае команда на перемещение выглядела так:

sudo mv ru_dict-48 /usr/lib/i386-linux-gnu/espeak-data/ru_dict

Обратите внимание: вместо «i386» у вас в системе может быть «x86_64…» или еще что-то. Если не уверены, воспользуйтесь поиском:

find /usr/lib/ -name «espeak-data»

Готово!

RHVoice в Linux

Инструкцию по установке RHVoice в Linux вы найдете, например, в начале этой статьи. Ничего сложного, но времени занимает больше, потому что придется загрузить несколько сотен мегабайт.

Смысл в том, что мы клонируем git-репозиторий и собираем необходимые компоненты через scons.

Для экспериментов в Windows и Linux я использую одни и те же русские голоса: стандартный ‘ru’ в eSpeak и Aleksandr в RHVoice.

Как проверить работоспособность синтезатора

Прежде чем обращаться к движку, убедитесь, что он установлен и работает правильно.

Проверить работу eSpeak в Windows проще всего через GUI — достаточно запустить TTSApp.exe в папке с программой. Дальше открываем список голосов, выбираем eSpeak-RU, вводим текст в поле редактирования и жмем на кнопку Speak.

Обратиться к espeak можно и из терминала. Базовые консольные команды для eSpeak и NG совпадают — надо только добавлять или убирать «-ng» после «espeak»:

espeak -v ru -f D:my.txt

espeak-ng -v en «The Cranes are Flying»

echo «Да, это от души. Замечательно. Достойно восхищения» |RHVoice-test -p Aleksandr

Как нетрудно догадаться, первая команда с ключом -f читает русский текст из файла. Чтобы в Windows команда espeak подхватывалась вне зависимости от того, в какой вы директории, добавьте путь к консольной версии eSpeak (по умолчанию — C:Program FileseSpeakcommand_line) в переменную окружения Path. Вот как это сделать.

Библиотека pyttsx3

PyTTSx3 — удобная кроссплатформенная библиотека для реализации TTS в приложениях на Python 3. Использует разные системы синтеза речи в зависимости от текущей ОС:

- в Windows — SAPI5,

- в Mac OS X — nsss,

- в Linux и на других платформах — eSpeak.

Это очень удобно: пишете код один раз и он работает везде. Кстати, eSpeak NG поддерживается наравне с исходной версией.

А теперь примеры!

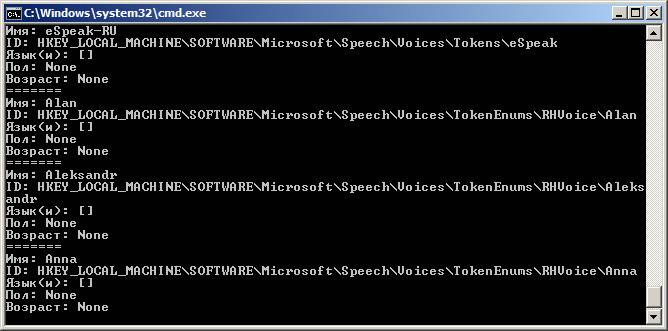

Просмотр голосов

У каждого голоса есть несколько параметров, с которыми можно работать:

- id (идентификатор в операционной системе),

- name (имя),

- languages (поддерживаемые языки),

- gender (пол),

- age (возраст).

Первый вопрос всегда в том, какие голоса установлены на стороне пользователя. Поэтому создадим скрипт, который покажет все доступные голоса, их имена и ID. Назовем файл, например, list_voices.py:

import pyttsx3

tts = pyttsx3.init() # Инициализировать голосовой движок.

У активного движка есть стандартный параметр ‘voices’, где содержится список всех доступных этому движку голосов. Это нам и нужно:

voices = tts.getProperty(‘voices’)

# Перебрать голоса и вывести параметры каждого

for voice in voices:

print(‘=======’)

print(‘Имя: %s’ % voice.name)

print(‘ID: %s’ % voice.id)

print(‘Язык(и): %s’ % voice.languages)

print(‘Пол: %s’ % voice.gender)

print(‘Возраст: %s’ % voice.age)

Теперь открываем терминал или командную строку, переходим в директорию, куда сохранили скрипт, и запускаем list_voices.py.

Результат будет примерно таким:

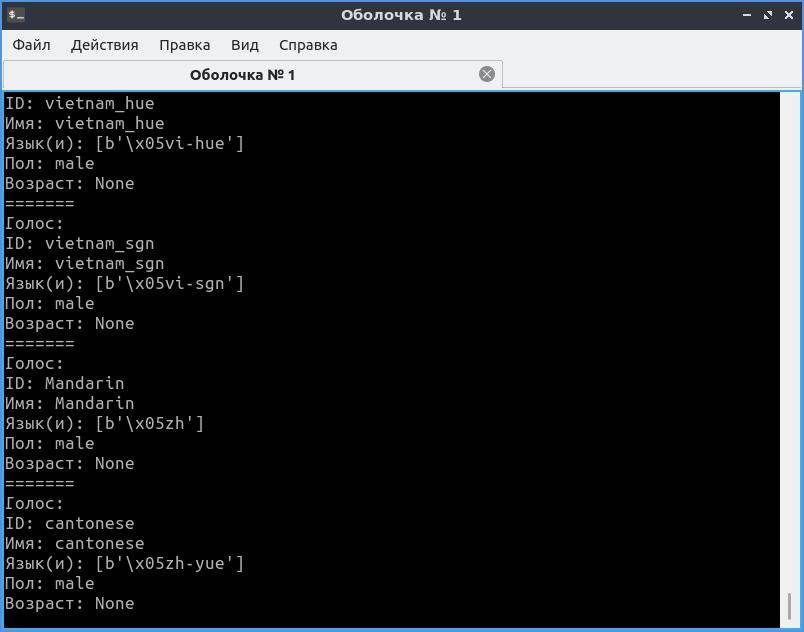

В Linux картина будет похожей, но с другими идентификаторами.

Как видите, в Windows для большинства установленных голосов MS SAPI заполнены только «Имя» и ID. Однако этого хватит, чтобы решить следующую нашу задачу: написать код, который выберет русский голос и что-то им произнесет.

Например, у голоса RHVoice Aleksandr есть преимущество — его имя уникально, потому что записано транслитом и в таком виде не встречается у других известных производителей голосов. Но через pyttsx3 этот голос будет работать только в Windows. Для воспроизведения в Linux ему нужен Speech Dispatcher (подробнее чуть позже), с которым библиотека взаимодействовать не умеет. Как общаться с «диспетчером» еще обсудим, а пока разберемся с доступными голосами.

Как выбрать голос по имени

В Windows голос удобно выбирать как по ID, так и по имени. В Linux проще работать с именем или языком голоса. Создадим новый файл set_voice_and_say.py:

import pyttsx3

tts = pyttsx3.init()

voices = tts.getProperty(‘voices’)

# Задать голос по умолчанию

tts.setProperty(‘voice’, ‘ru’)

# Попробовать установить предпочтительный голос

for voice in voices:

if voice.name == ‘Aleksandr’:

tts.setProperty(‘voice’, voice.id)

tts.say(‘Командный голос вырабатываю, товарищ генерал-полковник!’)

tts.runAndWait()

В Windows вы услышите голос Aleksandr, а в Linux — стандартный русский eSpeak. Если бы мы вовсе не указали голос, после запуска нас ждала бы тишина, так как по умолчанию синтезатор говорит по-английски.

Обратите внимание: tts.say() не выводит реплики мгновенно, а собирает их в очередь, которую затем нужно запустить на воспроизведение командой tts.runAndWait().

Выбор голоса по ID

Часто бывает, что в системе установлены голоса с одинаковыми именами, поэтому надежнее искать необходимый голос по ID.

Заменим часть написанного выше кода:

for voice in voices:

ru = voice.id.find(‘RHVoiceAnna’) # Найти Анну от RHVoice

if ru > -1: # Eсли нашли, выбираем этот голос

tts.setProperty(‘voice’, voice.id)

Теперь в Windows мы точно не перепутаем голоса Anna от Microsoft и RHVoice. Благодаря поиску в подстроке нам даже не пришлось вводить полный ID голоса.

Но когда мы пишем под конкретную машину, для экономии ресурсов можно прописать голос константой. Выше мы запускали скрипт list_voices.py — он показал параметры каждого голоса в ОС. Тогда-то вы и могли обратить внимание, что в Windows идентификатором служит адрес записи в системном реестре:

import pyttsx3

tts = pyttsx3.init()

EN_VOICE_ID = «HKEY_LOCAL_MACHINESOFTWAREMicrosoftSpeechVoicesTokensMS-Anna-1033-20DSK»

RU_VOICE_ID = «HKEY_LOCAL_MACHINESOFTWAREMicrosoftSpeechVoicesTokenEnumsRHVoiceAnna»

# Использовать английский голос

tts.setProperty(‘voice’, EN_VOICE_ID)

tts.say(«Can you hear me say it’s a lovely day?»)

# Теперь — русский

tts.setProperty(‘voice’, RU_VOICE_ID)

tts.say(«А напоследок я скажу»)

tts.runAndWait()

Как озвучить системное время в Windows и Linux

Это крошечное приложение каждую минуту проговаривает текущее время по системным часам. Точнее, оно сообщает время при каждой смене минуты. Например, если вы запустите скрипт в 14:59:59, программа заговорит через секунду.

Создадим новый файл с именем time_tts.py. Всего, что мы разобрали выше, должно хватить, чтобы вы без проблем прочли и поняли следующий код:

# «Говорящие часы» — программа озвучивает системное время

from datetime import datetime, date, time

import pyttsx3, time

tts = pyttsx3.init()

tts.setProperty(‘voice’, ‘ru’) # Наш голос по умолчанию

tts.setProperty(‘rate’, 150) # Скорость в % (может быть > 100)

tts.setProperty(‘volume’, 0.8) # Громкость (значение от 0 до 1)

def set_voice(): # Найти и выбрать нужный голос по имени

voices = tts.getProperty(‘voices’)

for voice in voices:

if voice.name == ‘Aleksandr’:

tts.setProperty(‘voice’, voice.id)

else:

pass

def say_time(msg): # Функция, которая будет называть время в заданном формате

set_voice() # Настроить голос

tts.say(msg)

tts.runAndWait() # Воспроизвести очередь реплик и дождаться окончания речи

while True:

time_checker = datetime.now() # Получаем текущее время с помощью datetime

if time_checker.second == 0:

say_time(‘{h} {m}’.format(h=time_checker.hour, m=time_checker.minute))

time.sleep(55)

else:

pass

Программа будет отслеживать и называть время, пока вы не остановите ее сочетанием клавиш Ctrl+Break или Ctrl+C (в Windows и Linux соответственно).

Посмотрите на алгоритм: чтобы уловить смену минуты, следим за значением секунд и ждем, когда оно будет равно нулю. После этого объявляем время и, чтобы поберечь оперативную память, отправляем программу спать на 55 секунд. После этого она снова начнет проверять текущее время и ждать нулевой секунды.

Для дальнейшего изучения библиотеки pyttsx3 вы можете заглянуть в англоязычную документацию, в том числе справку по классу и примеры. А пока посмотрим на другие инструменты.

Обертка для eSpeak NG

Модуль называется py-espeak-ng. Это альтернатива pyttsx3 для случаев, когда вам нужен или доступен только один синтезатор — eSpeak NG. Не дай бог, конечно. Впрочем, для быстрых экспериментов с голосом очень даже подходит. Принцип использования покажется вам знакомым:

from espeakng import ESpeakNG

engine = ESpeakNG()

engine.speed = 150

engine.say(«I’d like to be under the sea. In an octopus’s garden, in the shade!», sync=True)

engine.speed = 95

engine.pitch = 32

engine.voice = ‘russian’

engine.say(‘А теперь Горбатый!’, sync=True)

Обратите внимание на параметр синхронизации реплик sync=True. Без него синтезатор начнет читать все фразы одновременно — вперемешку. В отличие от pyttsx3, обертка espeakng не использует команду runAndWait(), и пропуск параметра sync сбивает очередь чтения.

Озвучиваем текст из файла

Не будем довольствоваться текстами в коде программы — пора научиться брать их извне. Тем более, это очень просто. В папке, где хранится только что рассмотренный нами скрипт, создайте файл test.txt с текстом на русском языке и в кодировке UTF-8. Теперь добавьте в конец кода такой блок:

text_file = open(«test.txt», «r»)

data = text_file.read()

tts.say(data, sync=True)

text_file.close()

Открываем файл на чтение, передаем содержимое в переменную data, затем воспроизводим голосом все, что в ней оказалось, и закрываем файл.

Управляем речью через Speech Dispatcher в Linux

До сих пор по результатам работы нашего кода в Linux выводился один суровый eSpeak. Пришло время позаботиться о друзьях Tux’а и порадовать их сравнительно реалистичными голосами RHVoice. Для этого нам понадобится Speech Dispatcher — аналог MS SAPI. Он позволяет управлять всеми установленными в системе голосовыми движками и вызывать любой из них по необходимости.

Скорее всего Speech Dispatcher есть у вас в системе по умолчанию. Чтобы обращаться к нему из кода Python, надо установить модуль speechd:

sudo apt install python3-speechd

Пробуем выбрать синтезатор RHVoice с помощью «диспетчера» и прочесть текст:

import speechd

tts_d = speechd.SSIPClient(‘test’)

tts_d.set_output_module(‘rhvoice’)

tts_d.set_language(‘ru’)

tts_d.set_rate(50)

tts_d.set_punctuation(speechd.PunctuationMode.SOME)

tts_d.speak(‘И нежный вкус родимой речи так чисто губы холодит’)

tts_d.close()

Ура! Наконец-то наше Linux-приложение говорит голосом, похожим на человеческий. Обратите внимание на метод .set_output_module() — он позволяет выбрать любой установленный движок, будь то espeak, rhvoice или festival. После этого синтезатор прочтет текст голосом, предписанным для данного движка по умолчанию. Если задан только язык — голосом по умолчанию для данного языка.

Получается, чтобы сделать кроссплатформенное приложение с поддержкой синтезатора RHVoice, нужно совместить pyttsx3 и speechd: проверить, в какой системе работает наш код, и выбрать SAPI или Speech Dispatcher. А в любой непонятной ситуации — откатиться на неказистый, но вездеходный eSpeak.

Однако для этого программа должна знать, где работает. Определить текущую ОС и ее разрядность очень легко! Лично я предпочитаю использовать для этого стандартный модуль platform, который не нужно устанавливать:

import platform

system = platform.system() # Вернет тип системы.

bit = platform.architecture() # Вернет кортеж, где разрядность — нулевой элемент

print(system)

print(bit[0])

Пример результата:

Windows

64bit

Кстати, не обязательно решать все за пользователя. На базе pyttsx3 вы при желании создадите меню выбора голоса с возможностью управлять такими параметрами, как высота голоса, громкость и скорость речи.

Модуль Google TTS — голоса из интернета

Google предлагает онлайн-озвучку текста с записью результата в mp3-файл. Это не для каждой задачи:

- постоянно нужен быстрый интернет;

- нельзя воспроизвести аудио средствами самого gtts;

- скорость обработки текста ниже, чем у офлайн-синтезаторов.

Что касается голосов, английский и французский звучат очень реалистично. Русский голос Гугла — девушка, которая немного картавит и вдобавок произносит «ц» как «ч». По этой причине ей лучше не доверять чтение аудиокниг, имен и топонимов.

Еще один нюанс. Когда будете экспериментировать с кодом, не называйте файл «gtts.py» — он не будет работать! Выберите любое другое имя, например use_gtts.py.

Простейший код, который сохраняет текст на русском в аудиофайл:

from gtts import gTTS

tts = gTTS(‘Иван Федорович Крузенштерн. Человек и пароход!’, lang=’ru’)

tts.save(‘tts_output.mp3’)

После запуска этого кода в директории, где лежит скрипт, появится запись. Чтобы воспроизвести файл «не отходя от кассы», придется использовать еще какой-то модуль или фреймворк. Годится pygame или pyglet.

Вот листинг приложения, которое построчно читает txt-файлы с помощью связки gtts и PyGame. Я заметила, что для нормальной работы этого скрипта текст из text.txt должен быть в кодировке Windows-1251 (ANSI).

Выводим текст через NVDA

Мы научились озвучивать приложение с помощью установленных в системе синтезаторов. Но что если большинству пользователей эта фишка не нужна, и мы хотим добавить речь исключительно как опцию для слабовидящих? В таком случае не обязательно писать код озвучивания: достаточно передать текст интерфейса другому приложению — экранному диктору.

Одна из самых популярных программ экранного доступа в Windows — бесплатная и открытая NVDA. Для связи с ней к нашему приложению нужно привязать библиотеку nvdaControllerClient (есть варианты для 32- и 64-разрядных систем). Узнавать разрядность системы вы уже умеете.

Еще для работы с экранным диктором нам понадобятся модули ctypes и time. Создадим файл nvda.py, где напишем модуль связи с NVDA:

import time, ctypes, platform

# Загружаем библиотеку клиента NVDA

bit = platform.architecture()

if bit[0] == ’32bit’:

clientLib = ctypes.windll.LoadLibrary(‘nvdaControllerClient32.dll’)

elif bit[0] == ’64bit’:

clientLib = ctypes.windll.LoadLibrary(‘nvdaControllerClient64.dll’)

else:

errorMessage=str(ctypes.WinError(res))

ctypes.windll.user32.MessageBoxW(0,u»Ошибка! Не удалось определить разрядность системы!»,0)

# Проверяем, запущен ли NVDA

res = clientLib.nvdaController_testIfRunning()

if res != 0:

errorMessage=str(ctypes.WinError(res))

ctypes.windll.user32.MessageBoxW(0,u»Ошибка: %s»%errorMessage,u»нет доступа к NVDA»,0)

def say(msg):

clientLib.nvdaController_speakText(msg)

time.sleep(1.0)

def close_speech():

clientLib.nvdaController_cancelSpeech()

Теперь эту заготовку можно применить в коде основной программы:

import nvda

nvda.say(‘Начать игру’)

# … другие реплики или сон

nvda.close_speech()

Если NVDA неактивна, после запуска кода мы увидим окошко с сообщением об ошибке, а если работает — услышим от нее заданный текст.

Плюс подхода в том, что незрячий пользователь будет слышать тот голос, который сам выбрал и настроил в NVDA.

Заключение

Ваша программа уже глаголет устами хотя бы одного из установленных синтезаторов? Поздравляю! Как видите, это не слишком сложно и «в выигрыше даже начинающий». Еще больше радуют перспективы использования TTS в ваших проектах. Все, что можно вывести как текст, можно и озвучить.

Представьте утилиту, которая при внезапной проблеме с экраном телефона или монитора сориентирует пользователя по речевым подсказкам, поможет спокойно сохранить данные и штатно завершить работу. Или как насчет прослушивания входящей почты, когда вы не за монитором? Напишите, когда, на ваш взгляд, TTS полезна, а когда только раздражает. Говорящая программа с какими функциями пригодилась бы вам?

История о том, как разработать технологию для синтеза речи с бюджетом 3 миллиона рублей (с примерами и этапами).

Всем привет. Мы уже писали здесь статью об использовании голосового бота в колл-центре транспортной компании и сейчас мы пошли дальше. Мы решили создать собственный синтез речи, способный конкурировать с такими гигантами как Google, Yandex, Amazon и относительно новыми игроками на этом рынке как Тинькофф, АБК и Vera Voice.

Пару слов о нас

Мы команда из 35 человек децентрализованно работающих по разным городам и странам. В 2016 году мы начали работать под брендом Twin. Тогда мы начинали с простых голосовых ботов. Сейчас это уже более сложные модели со сложными сценариями, машинным обучением и гибкой маршрутизацией в телефонии. Не буду подробно останавливаться на этом, гораздо подробнее и интереснее это описано на нашем сайте.

Сейчас я немного опишу вводную информацию по синтезу речи в 2020 году: что есть на рынке, как это используется, для чего, сколько стоит и какие проблемы возникают. Кому эта информация не интересна, примеры синтеза начинаются после заголовка “Первые результаты”. Приятного прочтения!

Почему синтез, а не записанный голос?

Сейчас синтез речи используется в основном в различных умных колонках, голосовых помощниках и в меньшей степени для уведомлений и общения с клиентом. Мы подробнее остановимся именно на синтезе для телефонии.

Почему в звонках используется синтез речи? При общении с голосовым ботом или при уведомлении от голосового бота часто озвучиваются различные переменные, масштаб вариаций которых может достигать несколько миллионов значений. Например, уведомление о доставке груза, где используются ФИО, даты, город, улица, числа. Одних только имён может быть около 60 тысяч и озвучить всё диктором будет трудоемкой задачей и помимо этого добавит зависимости от одного диктора. Таким образом, для гибкости и оперативности при разработке голосовых ботов синтез подходит наилучшим образом нежели предзаписанная речь.

Плюсы и минусы синтеза речи и записи диктора

Синтез

Плюсы: позволяет синтезировать речь на основе любого текста в реальном времени.

Минусы: при большом объёме синтезированной речи очень сложно придать ей необходимую и естественную эмоциональную окраску.

Запись

Плюсы: мы можем придать любой эмоциональный окрас, скорость и тембр речи, объяснив диктору, что мы в итоге хотим услышать.

Минусы: очень сложно и трудозатрано предзаписать большой объём переменной информации и учесть все возможные доработки сценариев бота.

При совмещении плюсов и минусов предзаписи и индивидуального синтеза речи мы получим идеальное сочетание.

Вот пример стороннего синтеза при звонке

Кто предоставляет данную технологию сейчас

К 2020 году на рынке сформировались несколько глобальных игроков и несколько локальных со своими плюсами и минусами.

Глобальные: Google, Amazon

Локальные: Yandex, Tinkoff, АБК, Vera Voice

В конце 2019 года мы задумались о реализации собственного синтеза. Да, в краткосрочной перспективе это получается невыгодно, но в перспективе от 2-х лет эта история очень интересна для нас. Дополнительным толчком также стали запросы от клиентов с потребностью синтеза речи определенного диктора. То есть у клиентов возникла потребность создать гибридный вариант голоса при звонках, когда часть диалога происходит с использованием предзаписанных реплик, а переменные синтезируются на основе голоса их диктора.

Сколько стоит разработка собственного синтеза речи?

Итак, на первый взгляд эта идея кажется обязательной для компании, работающей в сфере голосовых ботов, но цена реализации неизвестна. В процессе исследования мы поняли, что реализовать синтез мы можем, но его качество в большей степени зависит от собранных данных исходного голоса и его доработок, потому что основные и ключевые технологии создания синтеза открыты и доступны.

Для сравнения, в 2019 Tinkoff только на свой суперкомпьютер «Колмогоров» потратили около 1 млн. долларов без расходов на разработку программного обеспечения. О стоимости разработки ПО можно только гадать, информацию в открытых источниках мне не удалось найти.

Что мы хотели получить в результате?

Нам нужен был качественный синтез со стоимостью разработки не более 3 млн. рублей и возможностью активно масштабировать эту модель в течении 1 года, а дальше пополнять уже новый бюджет за счет новых клиентов. Ключевыми критериями были:

- Стоимость разработки и сопровождения ПО

-

Приемлемое качество для использования в телефонии

-

Возможность создавать синтез на основе 1 часа речи диктора

Решение

Практически любой синтез речи на базе нейронных сетей состоит из 3 основных модулей:

- Нормализация текста.

- Синтез спектрограммы из текста.

- Синтез аудиоданных из спектрограммы (вокодер).

Для своей реализации синтеза речи мы решили дорабатывать Tacotron 2 и WaveGlow под свои нужды.

Вот что из этого вышло

Первые результаты.

Во время первых попыток обучения Tacotron 2 мы разбирались с архитектурой нейронной сети: как с ней работать, как её обучать и использовать. Первые результаты нас не устроили, но потом удалось добиться устойчивого синтеза с минимальными проблемами. За исключением того, что спектрограмма переводилась в аудиоданные с помощью алгоритма Гриффин-Лима, который даёт крайне сильный «металлический отблеск» в полученной синтезированной речи.

Для наглядности я прикреплю к каждому из этапов примеры синтеза и оригинальной записи диктора.

Синтез

Оригинал

Второй этап

Звучание синтеза было явно на уровне крайне сырого прототипа и вряд ли бы устроило какого-либо клиента. На начальном этапе мы сомневались в привлекательности будущего результата, поэтому решили пойти дальше и разбираться с более качественными подходами для перевода спектрограммы в аудиоданные. Теперь синтез речи стал полностью нейросетевым и звучит намного приятнее, естественнее. Так же были вручную проверены и очищены данные для обучения, что немного упростило и ускорило процесс обучения.

Синтез

Оригинал

Третий этап

Добавили небольшие изменения в архитектуре нейронной сети, пересмотрели подходы к обучению моделей, подготовили аудиозаписи для обучения, добавили перевод слов в набор фонем. Благодаря этому получилось обучить модель всего на 3-х часах аудиозаписей, вместо 10-20 часов ранее.

Синтез

Оригинал

Четвертый этап

Русский язык

На этом этапе мы провели более масштабную работу. Добавили ещё несколько изменений в архитектуре нейронной сети, оптимизировали процесс подготовки аудиозаписей и обучения, добавили расстановку ударений и обработку ударных и безударных фонем. Существенно доработали процесс обучения моделей, благодаря которым получилось обучить модель всего на 1-м часе аудиозаписей без особой потери в качестве и стабильности синтеза.

Английский язык

Параллельно мы записали 1 час с англоговорящим диктором и перенесли полученный результата с русского языка на английский. Архитектура нейронной сети и процессы обучения такие же, как на русском языке, но пока что без перевода слов в набор фонем и поддержки ударений. Модель для английского языка обучена так же на 1-ом часе аудиозаписей.

Синтез на английском языке

А теперь текущий вариант синтеза речи на русском языке

Синтез 1

Оригинал 1

Оригинал 2

Оригинал 3

Оригинал 4

Оригинал 5

Заключение

Раньше для озвучивания переменных нам нужно было выбирать максимально похожий синтезированный голос у сторонних сервисов, но это сильно выбивалось из контекста диалога. Теперь для создания синтеза одного диктора требуется не более 1-го часа записи.

Можем ли мы синтезировать голос актеров и публичных личностей для использования в киноиндустрии? Скорее можем, но технология предполагает более масштабное и технологичное применение в голосовых ботах, где объем синтеза гораздо больше.

На текущий момент мы продолжаем двигаться в сторону улучшения качества синтеза, так как есть ещё ряд идей как сделать голос ещё реалистичнее. Запустили несколько пилотных проектов с текущими российскими клиентами и получили несколько запросов от зарубежных компаний.

Спасибо, что дочитали до конца. В комментариях будем рады ответить на вопросы или выслушать предложения и идей.

Синтезатор речи «для роботов» с нуля +17

Программирование, Алгоритмы

Рекомендация: подборка платных и бесплатных курсов таргетированной рекламе — https://katalog-kursov.ru/

Давным-давно посетила меня идея создать синтезатор речи с «голосом робота», как, например, в песне Die Roboter группы Kraftwerk. Поиски информации по «голосу робота» привели к историческому факту, что подобное звучание синтетической речи характерно для вокодеров, которые используются для сжатия речи (2400 — 9600 бит/c). Голос человека, синтезированный вокодером, отдает металлическим звучанием и становится похожим на тот самый «голос робота». Музыкантам понравился данный эффект искажения речи, и они стали активно его использовать в своем творчестве.

Поиски информации по реализации вокодера вывели меня на книгу «Теория и применение цифровой обработки сигналов», где расписано почти все, что необходимо для создания собственного синтезатора речи на основе вокодера.

Небольшое замечание касательно выбора способа реализации синтеза речи

Конечно, можно было бы и не париться с созданием вокодера, а просто сделать базу заранее записанных звуков всех фонем и проигрывать их в соответствии с текстом. Данный способ мне не был интересен, поэтому я решил сделать синтезатор речи именно с синтезом всех звуков, как согласных, так и гласных. Вокодер для этих целей был выбран потому, что его проще обучить, чем формантный синтезатор речи, хотя звучание в обоих случаях было бы именно то, которое мне нужно. К тому же, синтезирование звуков, возможно, позволит реализовать синтезатор речи на базе микроконтроллера stm32 без внешней памяти! Вопрос тут скорее в том, хватит ли скорости работы МК.

Под спойлером представлен результат обработки речи вокодером

Краткая теория работы вокодера

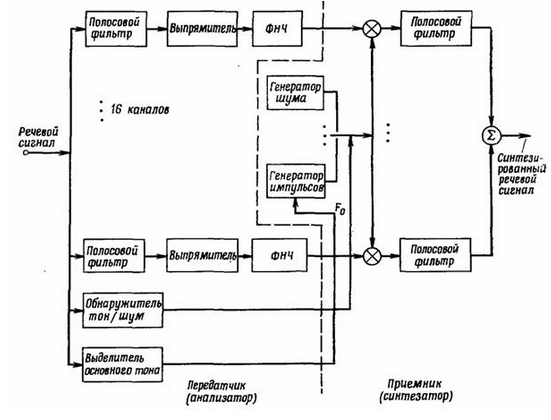

Самая основная часть вокодера — это гребенка полосовых фильтров. Именно она формирует спектр синтетической речи или, наоборот, определяет уровни спектра естественной человеческой речи в приемной части устройства. Как передающая, так и принимающая часть вокодера содержит гребенку полосовых фильтров.

Принимающая человеческую речь часть вокодера также определяет, помимо спектра звука, является ли звук шумовым, или у него есть тон. Для тона определяется его период. Сигналы с выходов полосовых фильтров детектируются, пропускаются через ФНЧ и используются в дальнейшем в качестве коэффициентов для модуляции сигналов на полосовых фильтрах синтезирующей части вокодера.

Синтезирующая часть вокодера содержит генератор шума и тона (читай: генератор случайной числовой последовательности на основе сдвигового регистра и генератора меандра), а также переключатель между этими двумя генераторами. Сигнал от одного из двух генераторов подается на вход гребенки полосовых фильтров. Для каждого фильтра на входе сигнал от генератора тона или шума модулируется соответствующим коэффициентом. И наконец, с выхода всех фильтров суммируем сигнал и получаем синтезированную речь.

Если кто не понял мое описание работы вокодера, вот блок-схема:

Не все так просто

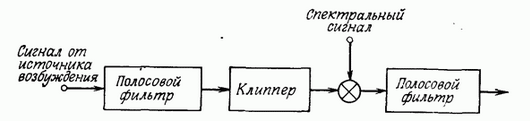

Чтобы вокодер

хоть как-то

понятно звучал, нужно выполнить пару требований к его полосовым фильтрам. Нет времени объяснять, просто поверье, что нужно использовать БИХ фильтры Бесселя (пруфы на 749 странице). Также, нужно распределить спектр речи неравномерно по фильтрам, особенно если у нас их немного (в моей реализации вокодера их всего 16 штук). Есть еще одна прелюбопытнейшая вещь, с которой вы можете ознакомиться все в той же книжке. А именно, представим, что сначала мы пропускаем сигнал от генератора тона или шума через гребенку фильтров, затем с выхода каждого фильтра ограничиваем сигнал двумя уровнями -1 и +1 и затем модулируем сигналы и снова пропускаем каждый сигнал через такой же фильтр, как ранее. По идее, такая схема не должна давать ощутимой разницы в синтезируемой речи. Тем не менее, такой прием выравнивания спектра существенно улучшает синтетическую речь вокодера. Почему так, лучше прочесть в книжке. Ну а тем, кому лень читать, скажу кратко: это из-за флуктуаций речи человека. На картинке снизу представлена блок-схема «улучшения» вокодера.

Что же касательно того, как распределить частоты между фильтрами… Основные частоты человеческой речи находятся в диапазоне примерно до 4-5 кГц (очень примерно). Я взял предел в 4 кГц и, используя психофизическую единицу измерения высоты звука «мел», распределил равномерно, правда не по герцам, а по мелам.

Что дает такой способ синтеза речи?

Если коэффициенты модуляции полосовых фильтров «смещать» по номеру фильтра, можно получить из женского голоса мужской. И это несмотря на то, что диапазоны фильтров (в моей реализации вокодера) в частотной области распределены не равномерно.

Также можно менять интонацию речи, можно вообще все менять. Единственный минус остается

отстойное

низкое качество речи.

Прослушать то, как меняется женская речь в мужскую, можно тут:

женский голос без изменений (монотонный)

мужской голос из женского (монотонный)

А если мужской голос сделать еще более мужским?

очень мужской голос (монотонный)

Немного кода

Весь код я пока выкладывать не буду (так как еще не дописал синтезатор речи — будет вторая статья). Ниже представлен код для определения высоты основного тона (также можно определить, тон или шум). Для этого измеряется энтропия сигнала, энтропия сигнала после ФНЧ на 600 Гц (в частотной области тона), а также число правильных совпадений в определителе периода тона.

Код определения высоты основного тона.

#include <math.h>

#include <stdio.h>

/*

speesy_Entropy_f - возвращает энтропию сигнала (функция не моя)

speesy_GetBasicTone - получить высоту основного тона

speesy_GetAllCoincidence - число совпадений в функции определения высоты основного тона

speesy_GetBasicToneEntropy - энтропия сигнала в области высоты основного тона

speesy_SetFreqMeander - установить частоту меандра

speesy_Meander - возвращает сигнал меандра

*/

#define SPEESY_SAMPLE_FREQ8 8000

#define SPEESY_SAMPLE_FREQ16 16000

#define SPEESY_SAMPLE_FREQ SPEESY_SAMPLE_FREQ16

#define SPEESY_MEANDER_MAX 100

#define FOR_FLOAT_EPSILON 1.19209e-007

static float speesy_all_coincidence = 0; //число правильных совпадений в определителе периода основного тона

static float speesy_fliter600_Entropy = 1.0;

static float speesy_meander_period = 0.01;//для генератора меандра

float speesy_Entropy_f(const float* source, unsigned long int start, unsigned long int finish, unsigned char binsCount, float minRaw, float maxRaw) {

float entropy = 0;

float binSize = fabs(maxRaw - minRaw) / (float)binsCount;

//FOR_FLOAT_EPSILON == numeric_limits<float>::epsilon()

if (fabs(binSize) < FOR_FLOAT_EPSILON) {

return 0;

}

//float* p = new float[binsCount];

float p[256];

for (unsigned char i = 0; i < binsCount; i++) {

p[i] = 0.0;

}

// Calculate probabilities

unsigned char index;

float value;

for (unsigned long int i = start; i <= finish; i++) {

value = source[i]; //for 8-bit data

index = floor((value - minRaw) / binSize);

if (index >= binsCount) {

index = binsCount - 1;

}

p[index] += 1.0;

}

unsigned char Normalize_size = finish - start + 1;

for (unsigned char i = 0; i < binsCount; i++) {

p[i] /= Normalize_size;

}

for (unsigned char i = 0; i < binsCount; i++) {

if (p[i] > FOR_FLOAT_EPSILON) {

entropy += p[i] * log2(p[i]);

}

}

entropy = -entropy;

return entropy;

}

float speesy_GetBasicTone(float source) {

static float matrix[6][6] ={0,0,0,0,0,0,

0,0,0,0,0,0,

0,0,0,0,0,0,

0,0,0,0,0,0,

0,0,0,0,0,0,

0,0,0,0,0,0};

const float max_detector_p = 0.0255;

const float min_detector_p = 0.0016;

static float detector_p[6] = {min_detector_p};

static float detector_old_p[6] = {min_detector_p};

static float detector_t[6] = {0};

static float detector_tay[6] = {0.016};

static float detector_t_end = 0;

//static float detector_beta[6] = {0};

static float detector_value[6] = {0};

float f_data = 0;

//char detector_p_t0_f = 0;

static float sig_old = 0;

static char sig_p = 0;

static char sig_m = 0;

static unsigned short tim160 = 0;

float detector_m1;

float detector_m2;

float detector_m3;

float detector_m4;

float detector_m5;

float detector_m6;

int detector_data = 0;

static float detector_old_m1;

static float detector_old_m4 = 0;

static char speesy_tone_i = 0;

static char speesy_tone_x = 0;

static char speesy_tone_y = 0;

static char speesy_tone_inter = 0;

//char n_coincidence[4] ={0};

char n_coincidence_matrix[6][4] ={0};

static float out_t;

#if SPEESY_SAMPLE_FREQ == SPEESY_SAMPLE_FREQ8

static float source_data[16] = {0};

const int max_source_data = 16;

const float p_conts = 0.000125;

#endif // SPEESY_SAMPLE_FREQ

#if SPEESY_SAMPLE_FREQ == SPEESY_SAMPLE_FREQ16

static float source_data[32] = {0};

const int max_source_data = 32;

const float p_conts = 0.0000625;

#endif // SPEESY_SAMPLE_FREQ

/*************Filter 600 Hz**********************/

#if SPEESY_SAMPLE_FREQ == SPEESY_SAMPLE_FREQ8

const float filter600_ACoef1[5] = {

0.00161978575856732190,

0.00647914303426928760,

0.00971871455140393280,

0.00647914303426928760,

0.00161978575856732190

};

const float filter600_BCoef1[4] = {

-2.63228606617055720000,

2.68865140959361830000,

-1.25580694576241330000,

0.22536111137571077000

};

#endif // SPEESY_SAMPLE_FREQ

#if SPEESY_SAMPLE_FREQ == SPEESY_SAMPLE_FREQ16

const float filter600_ACoef1[5] = {

0.00013538805748957640,

0.00054155222995830559,

0.00081232834493745844,

0.00054155222995830559,

0.00013538805748957640

};

const float filter600_BCoef1[4] = {

-3.29078386336302660000,

4.09122986596582550000,

-2.27618508727807440000,

0.47792443748067198000

};

#endif // SPEESY_SAMPLE_FREQ

static float filter600_y[5] = {0}; //output samples

static float filter600_x[5] = {0}; //input samples

static float out_filter600[240] = {0};

short out_i = 0;

filter600_x[4] = filter600_x[3];

filter600_y[4] = filter600_y[3];

filter600_x[3] = filter600_x[2];

filter600_y[3] = filter600_y[2];

filter600_x[2] = filter600_x[1];

filter600_y[2] = filter600_y[1];

filter600_x[1] = filter600_x[0];

filter600_y[1] = filter600_y[0];

filter600_x[0] = source;

filter600_y[0] = filter600_ACoef1[0] * filter600_x[0];

filter600_y[0] += filter600_ACoef1[1] * filter600_x[1] - filter600_BCoef1[0] * filter600_y[1];

filter600_y[0] += filter600_ACoef1[2] * filter600_x[2] - filter600_BCoef1[1] * filter600_y[2];

filter600_y[0] += filter600_ACoef1[3] * filter600_x[3] - filter600_BCoef1[2] * filter600_y[3];

filter600_y[0] += filter600_ACoef1[4] * filter600_x[4] - filter600_BCoef1[3] * filter600_y[4];

/***************End Filter 600 Hz*********************/

for (out_i = 239;out_i>0; out_i--) {

out_filter600[out_i] = out_filter600[out_i - 1];

}

out_filter600[0] = filter600_y[0];

if (tim160 < 160) {tim160 = tim160 + 1;}

else {

tim160 = 0;

speesy_fliter600_Entropy = speesy_Entropy_f(out_filter600,0,159,255,-32768,32768);

speesy_fliter600_Entropy = speesy_Entropy_f(out_filter600,160,239,255,-32768,32768);

}

detector_m1 = 0;

detector_m2 = 0;

detector_m3 = 0;

detector_m4 = 0;

detector_m5 = 0;

detector_m6 = 0;

//printf("nSpeesy max_source_data = %dn",max_source_data);

if (filter600_y[0] >= 0) {

if (filter600_y[0] > sig_old) {sig_p = 1;}

else {

if (sig_p == 1) {

sig_p = 0;

detector_m1 = filter600_y[0];

if (detector_m1 > detector_old_m1) {

detector_m3 = detector_m1 - detector_old_m1;

} else detector_m3 = 0;

detector_m2 = detector_m1 + detector_old_m4;

detector_old_m1 = detector_m1;

}

}

sig_old = filter600_y[0];

} else {

if ((-filter600_y[0]) > sig_old) {sig_m = 1;}

else {

if (sig_m == 1) {

sig_m = 0;

detector_m4 = -filter600_y[0];

if (detector_m4 > detector_old_m4) {

detector_m6 = detector_m4 - detector_old_m4;

} else detector_m6 = 0;

detector_m5 = detector_m4 + detector_old_m1;

detector_old_m4 = detector_m4;

}

}

sig_old = -filter600_y[0];

}

/*****************************************************/

//ИОН6

if (detector_t[5] > detector_tay[5]) { //если время больше tay

f_data = detector_value[5]*(exp(-(detector_t[5] - detector_tay[5])/(detector_p[5]/0.695))); //экспоненциальный разряд

if (detector_m6 > f_data) { //больше уровня

detector_value[5] = detector_m6; //обновляем уровень

detector_p[5] = (detector_t[5] + detector_p[5])/2; //среднее значение периода

if (detector_p[5] > max_detector_p) detector_p[5] = max_detector_p;

if (detector_p[5] < min_detector_p) detector_p[5] = min_detector_p;

detector_tay[5] = 0.4*detector_p[5]; //новое тау

detector_t[5] = 0;

//detector_p_t0_f = 1;

matrix[5][2] = matrix[5][1];

matrix[5][1] = matrix[5][0];

matrix[5][0] = detector_p[5];

} else {

detector_t[5] = detector_t[5] + p_conts; //инкремент времени

}

} else {

detector_t[5] = detector_t[5] + p_conts;

}

//ИОН5

if (detector_t[4] > detector_tay[4]) { //если время больше tay

f_data = detector_value[4]*(exp(-(detector_t[4] - detector_tay[4])/(detector_p[4]/0.695))); //экспоненциальный разряд

if (detector_m5 > f_data) { //больше уровня

detector_value[4] = detector_m5; //обновляем уровень

detector_p[4] = (detector_t[4] + detector_p[4])/2; //среднее значение периода

if (detector_p[4] > max_detector_p) detector_p[4] = max_detector_p;

if (detector_p[4] < min_detector_p) detector_p[4] = min_detector_p;

detector_tay[4] = 0.4*detector_p[4]; //новое тау

detector_t[4] = 0;

//detector_p_t0_f = 1;

matrix[4][2] = matrix[4][1];

matrix[4][1] = matrix[4][0];

matrix[4][0] = detector_p[4];

} else {

detector_t[4] = detector_t[4] + p_conts; //инкремент времени

}

} else {

detector_t[4] = detector_t[4] + p_conts;

}

//ИОН4

if (detector_t[3] > detector_tay[3]) { //если время больше tay

f_data = detector_value[3]*(exp(-(detector_t[3] - detector_tay[3])/(detector_p[3]/0.695))); //экспоненциальный разряд

if (detector_m4 > f_data) { //больше уровня

detector_value[3] = detector_m4; //обновляем уровень

detector_p[3] = (detector_t[3] + detector_p[3])/2; //среднее значение периода

if (detector_p[3] > max_detector_p) detector_p[3] = max_detector_p;

if (detector_p[3] < min_detector_p) detector_p[3] = min_detector_p;

detector_tay[3] = 0.4*detector_p[3]; //новое тау

detector_t[3] = 0;

//detector_p_t0_f = 1;

matrix[3][2] = matrix[3][1];

matrix[3][1] = matrix[3][0];

matrix[3][0] = detector_p[3];

} else {

detector_t[3] = detector_t[3] + p_conts; //инкремент времени

}

} else {

detector_t[3] = detector_t[3] + p_conts;

}

//ИОН3

if (detector_t[2] > detector_tay[2]) { //если время больше tay

f_data = detector_value[2]*(exp(-(detector_t[2] - detector_tay[2])/(detector_p[2]/0.695))); //экспоненциальный разряд

if (detector_m3 > f_data) { //больше уровня

detector_value[2] = detector_m3; //обновляем уровень

detector_p[2] = (detector_t[2] + detector_p[2])/2; //среднее значение периода

if (detector_p[2] > max_detector_p) detector_p[2] = max_detector_p;

if (detector_p[2] < min_detector_p) detector_p[2] = min_detector_p;

detector_tay[2] = 0.4*detector_p[2]; //новое тау

detector_t[2] = 0;

//detector_p_t0_f = 1;

matrix[2][2] = matrix[2][1];

matrix[2][1] = matrix[2][0];

matrix[2][0] = detector_p[2];

} else {

detector_t[2] = detector_t[2] + p_conts; //инкремент времени

}

} else {

detector_t[2] = detector_t[2] + p_conts;

}

//ИОН2

if (detector_t[1] > detector_tay[1]) { //если время больше tay

f_data = detector_value[1]*(exp(-(detector_t[1] - detector_tay[1])/(detector_p[1]/0.695))); //экспоненциальный разряд

if (detector_m2 > f_data) { //больше уровня

detector_value[1] = detector_m2; //обновляем уровень

detector_p[1] = (detector_t[1] + detector_p[1])/2; //среднее значение периода

if (detector_p[1] > max_detector_p) detector_p[1] = max_detector_p;

if (detector_p[1] < min_detector_p) detector_p[1] = min_detector_p;

detector_tay[1] = 0.4*detector_p[1]; //новое тау

detector_t[1] = 0;

//detector_p_t0_f = 1;

matrix[1][2] = matrix[1][1];

matrix[1][1] = matrix[1][0];

matrix[1][0] = detector_p[1];

} else {

detector_t[1] = detector_t[1] + p_conts; //инкремент времени

}

} else {

detector_t[1] = detector_t[1] + p_conts;

}

//ИОН1

if (detector_t[0] > detector_tay[0]) { //если время больше tay

f_data = detector_value[0]*(exp(-(detector_t[0] - detector_tay[0])/(detector_p[0]/0.695))); //экспоненциальный разряд

if (detector_m1 > f_data) { //больше уровня

detector_value[0] = detector_m1; //обновляем уровень

detector_p[0] = (detector_t[0] + detector_p[0])/2; //среднее значение периода

if (detector_p[0] > max_detector_p) detector_p[0] = max_detector_p;

if (detector_p[0] < min_detector_p) detector_p[0] = min_detector_p;

detector_tay[0] = 0.4*detector_p[0]; //новое тау

detector_t[0] = 0;

//detector_p_t0_f = 1;

matrix[0][2] = matrix[0][1];

matrix[0][1] = matrix[0][0];

matrix[0][0] = detector_p[0];

} else {

detector_t[0] = detector_t[0] + p_conts; //инкремент времени

}

} else {

detector_t[0] = detector_t[0] + p_conts;

}

/************************************************************************/

if (detector_t_end == 0) {

for (speesy_tone_x = 0;speesy_tone_x<6;speesy_tone_x++) {

matrix[speesy_tone_x][3] = matrix[speesy_tone_x][0] + matrix[speesy_tone_x][1];

matrix[speesy_tone_x][4] = matrix[speesy_tone_x][1] + matrix[speesy_tone_x][2];

matrix[speesy_tone_x][5] = matrix[speesy_tone_x][1] + matrix[speesy_tone_x][2] + matrix[speesy_tone_x][0];

}

for (speesy_tone_inter = 0; speesy_tone_inter<4;speesy_tone_inter++) {

n_coincidence_matrix[0][speesy_tone_inter] = 0;

n_coincidence_matrix[1][speesy_tone_inter] = 0;

n_coincidence_matrix[2][speesy_tone_inter] = 0;

n_coincidence_matrix[3][speesy_tone_inter] = 0;

n_coincidence_matrix[4][speesy_tone_inter] = 0;

n_coincidence_matrix[5][speesy_tone_inter] = 0;

for (speesy_tone_x = 0;speesy_tone_x<6;speesy_tone_x++) {

for (speesy_tone_y = 0;speesy_tone_y<6;speesy_tone_y++) {

//printf("nValue_matrix %f",matrix[speesy_tone_x][speesy_tone_y]);

//printf("nmatrix %f",(float)matrix[speesy_tone_x][speesy_tone_y]);

for (speesy_tone_i = 0;speesy_tone_i<6;speesy_tone_i++) {

//printf("nmatrix %f",(float)matrix[speesy_tone_x][speesy_tone_y]);

//printf("nspeesy_tone_i %d",speesy_tone_i);

//printf("nsr matrix %f",(float)matrix[speesy_tone_i][0]);

if (((speesy_tone_y != 0)&(speesy_tone_x!=speesy_tone_i))|(speesy_tone_y > 0))

if ((matrix[speesy_tone_i][0] >= 0.0016)&(matrix[speesy_tone_i][0] <= 0.0031)) {

f_data = 0.0001*((float)speesy_tone_inter + 1.0);

if ((((float)matrix[speesy_tone_i][0] + (float)f_data) >= (float)matrix[speesy_tone_x][speesy_tone_y])&

(((float)matrix[speesy_tone_i][0] - (float)f_data) <= (float)matrix[speesy_tone_x][speesy_tone_y])) {

n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] = n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] + 1;

//printf("ncoincidence 0.0016 - 0.0031");

}

} else

if ((matrix[speesy_tone_i][0] > 0.0031)&(matrix[speesy_tone_i][0] <= 0.0063)) {

f_data = 0.0002*((float)speesy_tone_inter + 1.0);

if ((((float)matrix[speesy_tone_i][0] + (float)f_data) >= (float)matrix[speesy_tone_x][speesy_tone_y])&

(((float)matrix[speesy_tone_i][0] - (float)f_data) <= (float)matrix[speesy_tone_x][speesy_tone_y])) {

n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] = n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] + 1;

//printf("ncoincidence 0.0031 - 0.0063");

}

} else

if ((matrix[speesy_tone_i][0] > 0.0063)&(matrix[speesy_tone_i][0] <= 0.0127)) {

f_data = 0.0004*((float)speesy_tone_inter + 1.0);

if ((((float)matrix[speesy_tone_i][0] + (float)f_data) >= (float)matrix[speesy_tone_x][speesy_tone_y])&

(((float)matrix[speesy_tone_i][0] - (float)f_data) <= (float)matrix[speesy_tone_x][speesy_tone_y])) {

n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] = n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] + 1;

//printf("ncoincidence 0.0063 - 0.0127");

}

} else

if ((matrix[speesy_tone_i][0] > 0.0127)&(matrix[speesy_tone_i][0] <= 0.0255)) {

f_data = 0.0008*((float)speesy_tone_inter + 1.0);

if (((matrix[speesy_tone_i][0] + f_data) >= matrix[speesy_tone_x][speesy_tone_y])&

((matrix[speesy_tone_i][0] - f_data) <= matrix[speesy_tone_x][speesy_tone_y])) {

n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] = n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] + 1;

//printf("ncoincidence 0.0127 - 0.0255");

}

} else {

//printf("nNO coincidence");

}

//printf("ncoincidence %d",n_coincidence_matrix[speesy_tone_i][speesy_tone_inter]);

} //end for

} //end for

for (speesy_tone_inter = 0; speesy_tone_inter<4;speesy_tone_inter++) {

for (speesy_tone_i = 0;speesy_tone_i<6;speesy_tone_i++) {

//printf("nDo mat_ton %d",(int)n_coincidence_matrix[speesy_tone_i][speesy_tone_inter]);

}

}

if (speesy_tone_inter == 0) {

for (speesy_tone_i = 0;speesy_tone_i<6;speesy_tone_i++) {

if (n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] >= 1) {

n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] -= 1;

} else {

n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] = 0;

}

}

} else

if (speesy_tone_inter == 1) {

for (speesy_tone_i = 0;speesy_tone_i<6;speesy_tone_i++) {

if (n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] >= 2) {

n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] -= 2;

} else {

n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] = 0;

}

}

} else

if (speesy_tone_inter == 2) {

for (speesy_tone_i = 0;speesy_tone_i<6;speesy_tone_i++) {

if (n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] >= 5) {

n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] -= 5;

} else {

n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] = 0;

}

}

} else

if (speesy_tone_inter == 3) {

for (speesy_tone_i = 0;speesy_tone_i<6;speesy_tone_i++) {

if (n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] >= 7) {

n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] -= 7;

} else {

n_coincidence_matrix[speesy_tone_i][speesy_tone_inter] = 0;

}

}

}

} //end for

} //end for () for inter

out_t = 0;

speesy_tone_x = 0;

for (speesy_tone_inter = 0; speesy_tone_inter<4;speesy_tone_inter++) {

for (speesy_tone_i = 0;speesy_tone_i<6;speesy_tone_i++) {

//printf("n mat_ton %d",(int)n_coincidence_matrix[speesy_tone_i][speesy_tone_inter]);

if (speesy_tone_x < n_coincidence_matrix[speesy_tone_i][speesy_tone_inter]) {

speesy_tone_x = n_coincidence_matrix[speesy_tone_i][speesy_tone_inter];

out_t = matrix[speesy_tone_i][0];

}

}

}

speesy_all_coincidence = speesy_tone_x;

} // end if

detector_t_end = detector_t_end + p_conts;

if (detector_t_end > 0.01) detector_t_end = 0;

return out_t;

}

float speesy_GetAllCoincidence(void) {

return speesy_all_coincidence;

}

float speesy_GetBasicToneEntropy(void) {

return speesy_fliter600_Entropy;

}

void speesy_SetFreqMeander(float freq) {

if (freq > 0) {

speesy_meander_period = (1.0/freq)/2;

}

}

signed char speesy_Meander(void) {

static float tim = 0;

static signed char out = SPEESY_MEANDER_MAX;

if (tim < speesy_meander_period) {

tim = tim + 0.0000625;

} else {

tim = 0;

out = -out;

}

return out;

}

А так же код гребенки полосовых фильтров.

#define SPEESY_NCOEF 4

#define SPEESY_MAXCAN 16

#define SPEESY_SAMPLE_FREQ8 8000

#define SPEESY_SAMPLE_FREQ16 16000

#define SPEESY_SAMPLE_FREQ SPEESY_SAMPLE_FREQ16

#if SPEESY_SAMPLE_FREQ == SPEESY_SAMPLE_FREQ16

//const float speesy_gain_correction_factor[16] = {1};

//for 0-88 Hz

const float ACoef1[SPEESY_NCOEF+1] = {

0.00000010368236408362,

0.00000041472945633450,

0.00000062209418450175,

0.00000041472945633450,

0.00000010368236408362

};

const float BCoef1[SPEESY_NCOEF] = {

-3.89262720221970990000,

5.68304206565440850000,

-3.68807460061232460000,

0.89766108913372833000

};

//for 88-188 Hz ---

const float ACoef2[SPEESY_NCOEF+1] = {

0.00046664702180067459,

0.00000000000000000000,

-0.00093329404360134919,

0.00000000000000000000,

0.00046664702180067459

};

const float BCoef2[SPEESY_NCOEF] = {

-3.92772838537582160000,

5.78986681239677910000,

-3.79636811635581890000,

0.93423598091247251000

};

//for 188-300 Hz

const float ACoef3[SPEESY_NCOEF+1] = {

0.00068858979234044106,

0.00000000000000000000,

-0.00137717958468088210,

0.00000000000000000000,

0.00068858979234044106

};

const float BCoef3[SPEESY_NCOEF] = {

-3.90771680345434060000,

5.74278248379999570000,

-3.76163133600848760000,

0.92663841158343707000

};

//for 300-426 Hz

const float ACoef4[SPEESY_NCOEF+1] = {

0.00088886359477686550,

0.00000000000000000000,

-0.00177772718955373100,

0.00000000000000000000,

0.00088886359477686550

};

const float BCoef4[SPEESY_NCOEF] = {

-3.87697578244056950000,

5.67379106513293690000,

-3.71429576416733910000,

0.91785164973031175000

};

//for 426-569 Hz

const float ACoef5[SPEESY_NCOEF+1] = {

0.00089752885269638212,

0.00000000000000000000,

-0.00179505770539276420,

0.00000000000000000000,

0.00089752885269638212

};

const float BCoef5[SPEESY_NCOEF] = {

-3.83152224876138180000,

5.57511629406004070000,

-3.64956251837243120000,

0.90729235654450602000

};

//for 569-729 Hz

const float ACoef6[SPEESY_NCOEF+1] = {

0.00117165116363920890,

0.00000000000000000000,

-0.00234330232727841770,

0.00000000000000000000,

0.00117165116363920890

};

const float BCoef6[SPEESY_NCOEF] = {

-3.76921491262598970000,

5.44568593950509160000,

-3.56948525439078870000,

0.89685259841470821000

};

//for 729-910 Hz

const float ACoef7[SPEESY_NCOEF+1] = {

0.00148423763165421900,

0.00000000000000000000,

-0.00296847526330843790,

0.00000000000000000000,

0.00148423763165421900

};

const float BCoef7[SPEESY_NCOEF] = {

-3.68252961240084180000,

5.27062615397503010000,

-3.46252708324253880000,

0.88411914122102575000

};

//for 910-1113 Hz

const float ACoef8[SPEESY_NCOEF+1] = {

0.00200280660037213200,

0.00000000000000000000,

-0.00400561320074426400,

0.00000000000000000000,

0.00200280660037213200

};

const float BCoef8[SPEESY_NCOEF] = {

-3.56693687706466770000,

5.04696879760847760000,

-3.32877844509510410000,

0.87096927786413736000

};

//for 1113-1343 Hz

const float ACoef9[SPEESY_NCOEF+1] = {

0.00211587349387137120,

0.00000000000000000000,

-0.00423174698774274240,

0.00000000000000000000,

0.00211587349387137120

};

const float BCoef9[SPEESY_NCOEF] = {

-3.41224013209053600000,

4.75975212198515950000,